1. 應用K-means演算法進行圖片壓縮 讀取一張圖片 觀察圖片文件大小,占記憶體大小,圖片數據結構,線性化 用kmeans對圖片像素顏色進行聚類 獲取每個像素的顏色類別,每個類別的顏色 壓縮圖片生成:以聚類中收替代原像素顏色,還原為二維 觀察壓縮圖片的文件大小,占記憶體大小 from sklearn. ...

1. 應用K-means演算法進行圖片壓縮

讀取一張圖片

觀察圖片文件大小,占記憶體大小,圖片數據結構,線性化

用kmeans對圖片像素顏色進行聚類

獲取每個像素的顏色類別,每個類別的顏色

壓縮圖片生成:以聚類中收替代原像素顏色,還原為二維

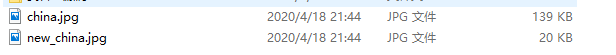

觀察壓縮圖片的文件大小,占記憶體大小

from sklearn.datasets import load_sample_image

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

import numpy as np

import matplotlib.image as img

import sys

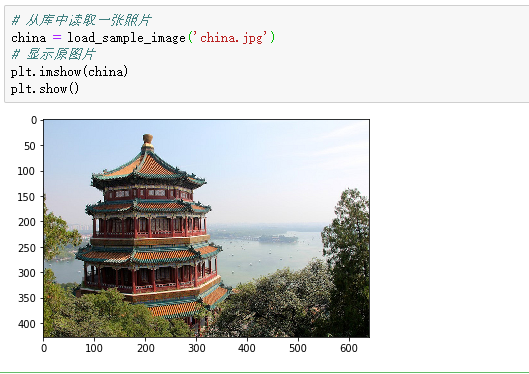

# 從庫中讀取一張照片

china = load_sample_image('china.jpg')

# 顯示原圖片

plt.imshow(china)

plt.show()

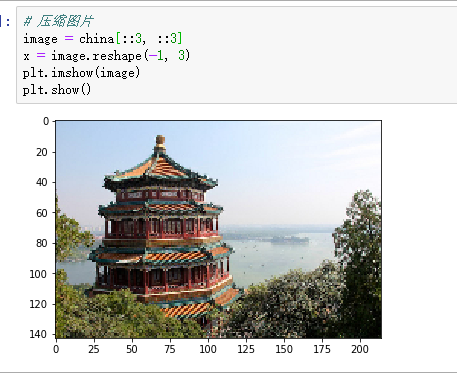

# 壓縮圖片

image = china[::3, ::3]

x = image.reshape(-1, 3)

plt.imshow(image)

plt.show()

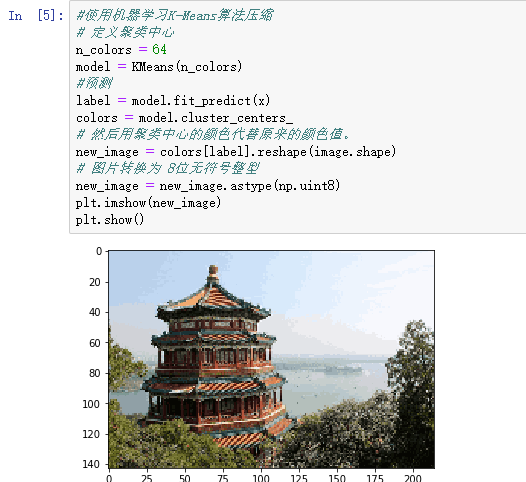

#使用機器學習K-Means演算法壓縮

# 定義聚類中心

n_colors = 64

model = KMeans(n_colors)

#預測

label = model.fit_predict(x)

colors = model.cluster_centers_

# 然後用聚類中心的顏色代替原來的顏色值。

new_image = colors[label].reshape(image.shape)

# 圖片轉換為 8位無符號整型

new_image = new_image.astype(np.uint8)

plt.imshow(new_image)

plt.show()

第一張原圖

第二張壓縮圖

第三張使用KMeans演算法壓縮圖片

保存圖片

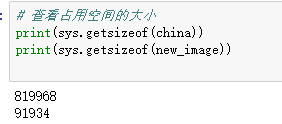

查看原圖和壓縮圖所占記憶體大小

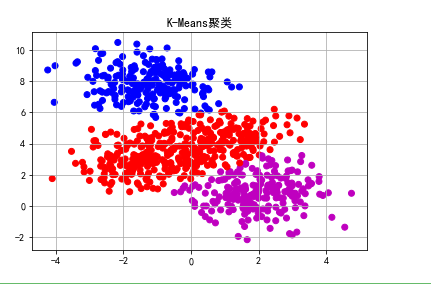

2. 觀察學習與生活中可以用K均值解決的問題。

從數據-模型訓練-測試-預測完整地完成一個應用案例。

import matplotlib.pyplot as plt

import sklearn.datasets as ds

import matplotlib.colors

#造數據

N=800

centers=4

# 生成2000個(預設)2維樣本點集合,中心點5個

data,y=ds.make_blobs(N,centers=centers,random_state=0)

#原始數據分佈

#pylot使用rc配置文件來自定義圖形的各種預設屬性,包括窗體大小、每英寸的點數、線條寬度、顏色、樣式、坐標軸、坐標和網路屬性、文本、字體等。

matplotlib.rcParams['font.sans-serif'] = [u'SimHei']

matplotlib.rcParams['axes.unicode_minus'] = False

cm = matplotlib.colors.ListedColormap(list('rgbm'))

plt.scatter(data[:,0],data[:,1],c=y,cmap=cm)

plt.title(u'原始數據分佈')

plt.grid()

plt.show()

#使用K-Means演算法

from sklearn.cluster import KMeans

# n_clusters=k

model=KMeans(n_clusters=3,init='k-means++')

#聚類預測

y_pre=model.fit_predict(data)

plt.scatter(data[:,0],data[:,1],c=y_pre,cmap=cm)

plt.title(u'K-Means聚類')

plt.grid()

plt.show()

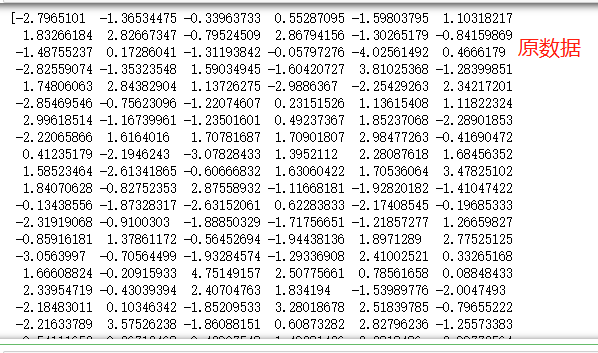

#查看原數據 print(data[:,0],data[:,1]) # 查看預測後數據 print(y_pre)

文本聚類

# -*- coding: utf-8 -*-

import os

import re

from os import listdir

import jieba

from sklearn import feature_extraction

from sklearn.feature_extraction.text import TfidfTransformer

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.cluster import KMeans

all_file=listdir('E:/201706120017賴志豪.txt') #獲取文件夾中所有文件名#數據集地址

outputDir="E:/output.txt" #結果輸出地址

labels=[] #用以存儲名稱

corpus=[] #空語料庫

size=200#測試集容量

def buildSW():

'''停用詞的過濾'''

typetxt=open('word.txt') #停用詞文檔地址

texts=['\u3000','\n',' '] #爬取的文本中未處理的特殊字元

'''停用詞庫的建立'''

for word in typetxt:

word=word.strip()

texts.append(word)

return texts

def buildWB(texts):

'''語料庫的建立'''

for i in range(0,len(all_file)):

filename=all_file[i]

filelabel=filename.split('.')[0]

labels.append(filelabel) #名稱列表

file_add='***'+ filename #數據集地址

doc=open(file_add,encoding='utf-8').read()

data=jieba.cut(doc) #文本分詞

data_adj=''

delete_word=[]

for item in data:

if item not in texts: #停用詞過濾

# value=re.compile(r'^[0-9]+$')#去除數字

value = re.compile(r'^[\u4e00-\u9fa5]{2,}$')#只匹配中文2字詞以上

if value.match(item):

data_adj+=item+' '

else:

delete_word.append(item)

corpus.append(data_adj) #語料庫建立完成

# print(corpus)

return corpus

def countIdf(corpus):

vectorizer=CountVectorizer()#該類會將文本中的詞語轉換為詞頻矩陣,矩陣元素a[i][j] 表示j詞在i類文本下的詞頻

transformer=TfidfTransformer()#該類會統計每個詞語的tf-idf權值

tfidf=transformer.fit_transform(vectorizer.fit_transform(corpus))#第一個fit_transform是計算tf-idf,第二個fit_transform是將文本轉為詞頻矩陣

weight=tfidf.toarray()#將tf-idf矩陣抽取出來,元素a[i][j]表示j詞在i類文本中的tf-idf權重

return weight

def Kmeans(weight,clusters,correct):

mykms=KMeans(n_clusters=clusters)

y=mykms.fit_predict(weight)

result=[]

for i in range(0,clusters):

label_i=[]

gp=0

jy=0

xz=0

ty=0

for j in range(0,len(y)):

if y[j]==i:

label_i.append(labels[j])

type=labels[j][0:2]

if(type=='gp'):

gp+=1

elif(type=='jy'):

jy+=1

elif(type=='xz'):

xz+=1

elif(type=='ty'):

ty+=1

max=jy

type='教育'

if(gp>jy):

max=gp

type='股票'

if(max<xz):

max=xz

type='星座'

if(max<ty):

max=ty

type='體育'

correct[0]+=max

result.append('類別'+'('+type+')'+':'+str(label_i))

return result

def output(result,outputDir,clusters):

outputFile='out'

type='.txt'

count=0

while(os.path.exists(outputDir+outputFile+type)):

count+=1

outputFile='out'+str(count)

doc = open(outputDir+outputFile+type, 'w')

for i in range(0,clusters):

print(result[i], file=doc)

print('本次分類總樣本數目為:'+str(size)+' 其中正確分類數目為:'+str(correct[0])+' 正確率為:'+str(correct[0]/size), file=doc)

doc.close()

texts=buildSW()

corpus=buildWB(texts)

weight=countIdf(corpus)

clusters=4

correct=[0]#正確量

result=Kmeans(weight,clusters,correct)

output(result,outputDir,clusters)

print('finish')

詞頻統計結果