不同於單一架構應用(Monolith), 分散式環境下, 進行事務操作將變得困難, 因為分散式環境通常會有多個數據源, 只用本地資料庫事務難以保證多個數據源數據的一致性. 這種情況下, 可以使用兩階段或者三階段提交協議來完成分散式事務.但是使用這種方式一般來說性能較差, 因為事務管理器需要在多個數據 ...

不同於單一架構應用(Monolith), 分散式環境下, 進行事務操作將變得困難, 因為分散式環境通常會有多個數據源, 只用本地資料庫事務難以保證多個數據源數據的一致性. 這種情況下, 可以使用兩階段或者三階段提交協議來完成分散式事務.但是使用這種方式一般來說性能較差, 因為事務管理器需要在多個數據源之間進行多次等待. 有一種方法同樣可以解決分散式事務問題, 並且性能較好, 這就是我這篇文章要介紹的使用事件,本地事務以及消息隊列來實現分散式事務.

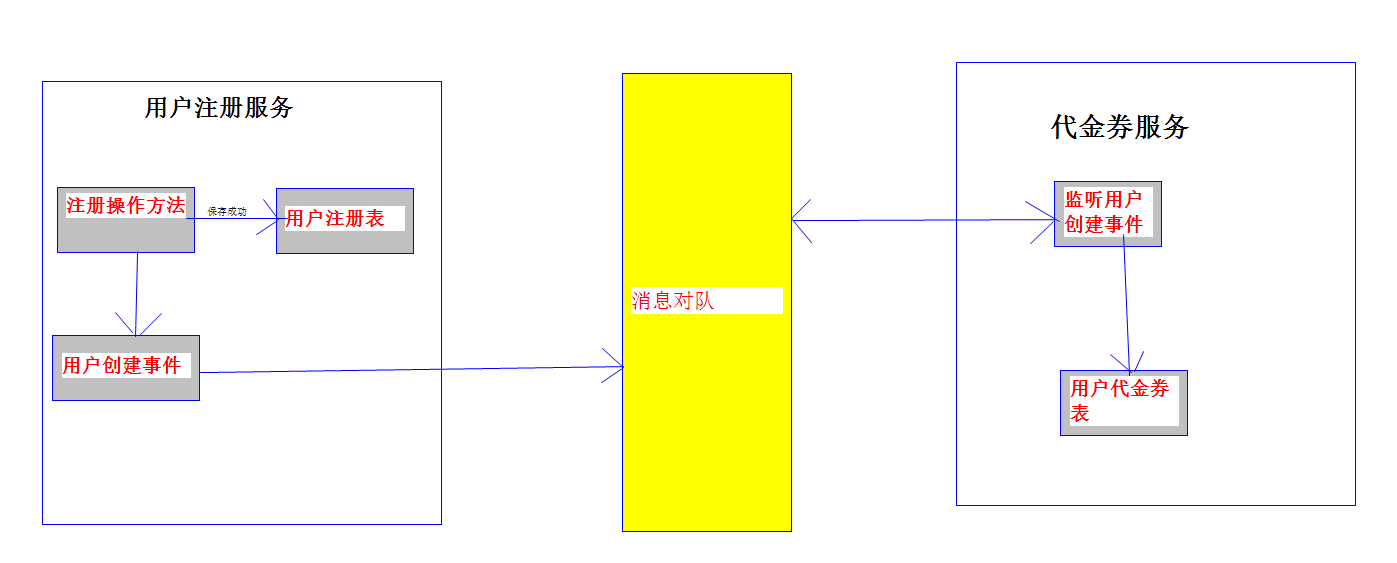

我們從一個簡單的實例入手. 基本所有互聯網應用都會有用戶註冊的功能. 在這個例子中, 我們對於用戶註冊有兩步操作:

1. 註冊成功, 保存用戶信息.

2. 需要給用戶發放一張代金券, 目的是鼓勵用戶進行消費.

如果是一個單一架構應用, 實現這個功能非常簡單: 在一個本地事務里, 往用戶表插一條記錄, 並且在代金券表裡插一條記錄, 提交事務就完成了. 但是如果我們的應用是用微服務實現的, 可能用戶和代金券是兩個獨立的服務, 他們有各自的應用和資料庫, 那麼就沒有辦法簡單的使用本地事務來保證操作的原子性了. 現在來看看如何使用事件機制和消息隊列來實現這個需求.(我在這裡使用的消息隊列是kafka, 原理同樣適用於ActiveMQ/RabbitMQ等其他隊列)

我們會為用戶註冊這個操作創建一個事件, 該事件就叫做用戶創建事件(USER_CREATED). 用戶服務成功保存用戶記錄後, 會發送用戶創建事件到消息隊列, 代金券服務會監聽用戶創建事件, 一旦接收到該事件, 代金券服務就會在自己的資料庫中為該用戶創建一張代金券. 好了, 這些步驟看起來都相當的簡單直觀, 但是怎麼保證事務的原子性呢?

考慮下麵這兩個場景:

1. 用戶服務在保存用戶記錄, 還沒來得及向消息隊列發送消息之前就宕機了. 怎麼保證用戶創建事件一定發送到消息隊列了?

2. 代金券服務接收到用戶創建事件, 還沒來得及處理事件就宕機了. 重新啟動之後如何消費之前的用戶創建事件?

這兩個問題的本質是: 如何讓操作資料庫和操作消息隊列這兩個操作成為一個原子操作. 不考慮2PC, 這裡我們可以通過事件表來解決這個問題. 下麵是類圖.

EventPublish是記錄待發佈事件的表. 其中:

id: 每個事件在創建的時候都會生成一個全局唯一ID, 例如UUID.

status: 事件狀態, 枚舉類型. 現在只有兩個狀態: 待發佈(NEW), 已發佈(PUBLISHED).

payload: 事件內容. 這裡我們會將事件內容轉成json存到這個欄位里.

eventType: 事件類型, 枚舉類型. 每個事件都會有一個類型, 比如我們之前提到的創建用戶USER_CREATED就是一個事件類型.

EventProcess是用來記錄待處理的事件. 欄位與EventPublish基本相同.

我們首先看看事件的發佈過程. 下麵是用戶服務發佈用戶創建事件的順序圖.

1. 用戶服務在接收到用戶請求後開啟事務, 在用戶表創建一條用戶記錄, 並且在EventPublish表創建一條status為NEW的記錄, payload記錄的是事件內容, 提交事務.

2. 用戶服務中的定時器首先開啟事務, 然後查詢EventPublish是否有status為NEW的記錄, 查詢到記錄之後, 拿到payload信息, 將消息發佈到kafka中對應的topic.

發送成功之後, 修改資料庫中EventPublish的status為PUBLISHED, 提交事務.

下麵是代金券服務處理用戶創建事件的順序圖

.

1. 代金券服務接收到kafka傳來的用戶創建事件(實際上是代金券服務主動拉取的消息, 先忽略消息隊列的實現), 在EventProcess表創建一條status為NEW的記錄, payload記錄的是事件內容, 如果保存成功, 向kafka返回接收成功的消息.

2. 代金券服務中的定時器首先開啟事務, 然後查詢EventProcess是否有status為NEW的記錄, 查詢到記錄之後, 拿到payload信息, 交給事件回調處理器處理, 這裡是直接創建代金券記錄. 處理成功之後修改資料庫中EventProcess的status為PROCESSED, 最後提交事務.

回過頭來看我們之前提出的兩個問題:

1. 用戶服務在保存用戶記錄, 還沒來得及向消息隊列發送消息之前就宕機了. 怎麼保證用戶創建事件一定發送到消息隊列了?

根據事件發佈的順序圖, 我們把創建事件和發佈事件分成了兩步操作. 如果事件創建成功, 但是在發佈的時候宕機了. 啟動之後定時器會重新對之前沒有發佈成功的事件進行發佈. 如果事件在創建的時候就宕機了, 因為事件創建和業務操作在一個資料庫事務里, 所以對應的業務操作也失敗了, 資料庫狀態的一致性得到了保證.

2. 代金券服務接收到用戶創建事件, 還沒來得及處理事件就宕機了. 重新啟動之後如何消費之前的用戶創建事件?

根據事件處理的順序圖, 我們把接收事件和處理事件分成了兩步操作. 如果事件接收成功, 但是在處理的時候宕機了. 啟動之後定時器會重新對之前沒有處理成功的事件進行處理. 如果事件在接收的時候就宕機了, kafka會重新將事件發送給對應服務.

通過這種方式, 我們不用2PC, 也保證了多個數據源之間狀態的最終一致性.

和2PC/3PC這種同步事務處理的方式相比, 這種非同步事務處理方式具有非同步系統通常都有的優點:

1. 事務吞吐量大. 因為不需要等待其他數據源響應.

2. 容錯性好. A服務在發佈事件的時候, B服務甚至可以不線上.

缺點:

1. 編程與調試較複雜.

2. 容易出現較多的中間狀態. 比如上面的例子, 在用戶服務已經保存了用戶併發布了事件, 但是代金券服務還沒來得及處理之前, 用戶如果登錄系統, 會發現自己是沒有代金券的. 這種情況可能在有些業務中是能夠容忍的, 但是有些業務卻不行. 所以開發之前要考慮好.

另外, 上面的流程在實現的過程中還有一些可以改進的地方:

1. 定時器在更新EventPublish狀態為PUBLISHED的時候, 可以一次批量更新多個EventProcess的狀態.

2. 定時器查詢EventProcess並交給事件回調處理器處理的時候, 可以使用線程池非同步處理, 加快EventProcess處理周期.

3. 在保存EventPublish和EventProcess的時候同時保存到Redis, 之後的操作可以對Redis中的數據進行, 但是要小心處理緩存和資料庫可能狀態不一致問題.

4. 針對Kafka, 因為Kafka的特點是可能重發消息, 所以在接收事件並且保存到EventProcess的時候可能報主鍵衝突的錯誤(因為重覆消息id是相同的), 這個時候可以直接丟棄該消息.