一、ssh免密登錄 1.命令ssh-keygen、 overwrite輸入y一路回車 2.將生成的密鑰發送到本機 ssh-copy-id localhost中間會詢問是否繼續輸入“yes” 3.測試免密登錄是否成功 ssh localhost 二、Java配置 新建一個文件夾存放java和hadoo ...

一、ssh免密登錄

1.命令ssh-keygen、

overwrite輸入y一路回車

2.將生成的密鑰發送到本機

ssh-copy-id localhost中間會詢問是否繼續輸入“yes”

3.測試免密登錄是否成功

ssh localhost

二、Java配置

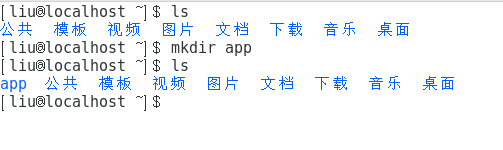

新建一個文件夾存放java和hadoop這裡我在~目錄下新建了一個app文件夾下麵。

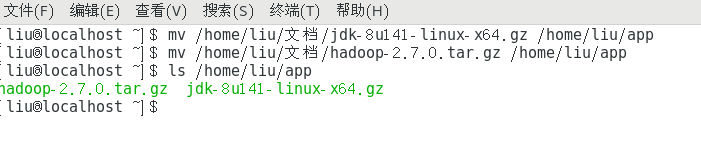

命令行移動文件到新建的app文件夾下。

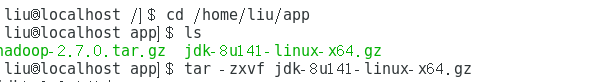

解壓jdk壓縮包。

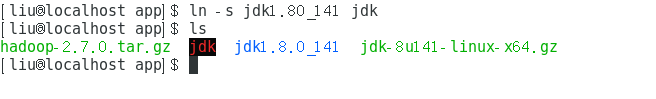

創建軟連接或重命名已解壓文件夾。

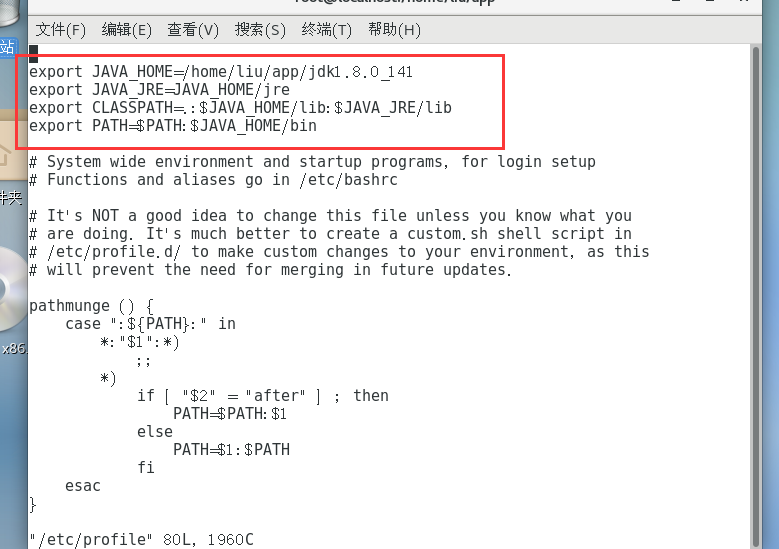

配置jdk環境變數。切換到root用戶(輸入su命令 切換root用戶接著輸入root用戶密碼),然後通過

vi /etc/profile

編輯、etc/profile文件配置環境變數。

編輯好後Esc鍵接著“:”在輸入wq保存並且退出編輯。

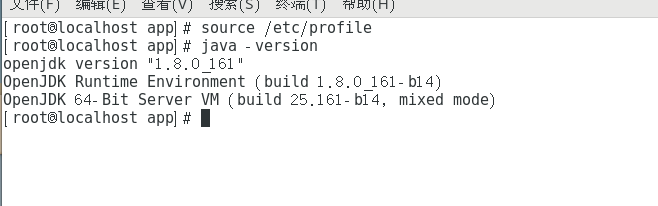

使/etc/profile生效,並檢測是否配置成功。

配置成功。

三、Hadoop配置

由root用戶切換為普通用戶,我這裡用戶名是liu所以使用命令 su liu。

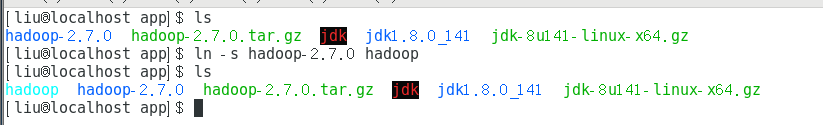

解壓Hadoop然後創建軟連接或者重命名。

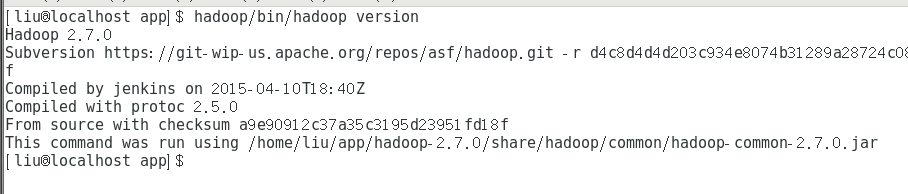

驗證單擊模式Hadoop是否安裝成功,hadoop/bin/hadoop version

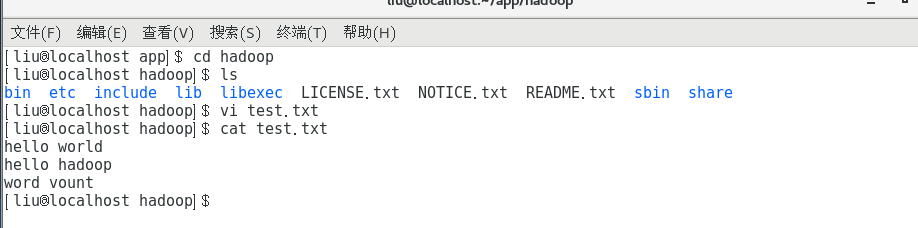

此時可以看到Hadoop版本2.7.0,安裝成功。可以在hadoop目錄下新建一個test.txt輸入一下內容。

測試運行Hadoop自帶的WordCount程式,統計單詞個數。

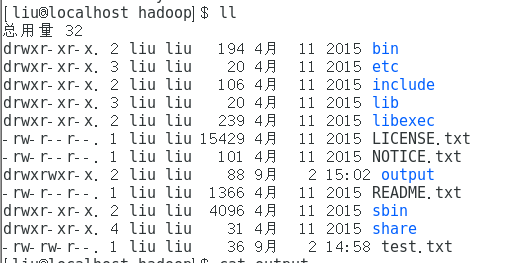

查看結果文件夾output

查看內容

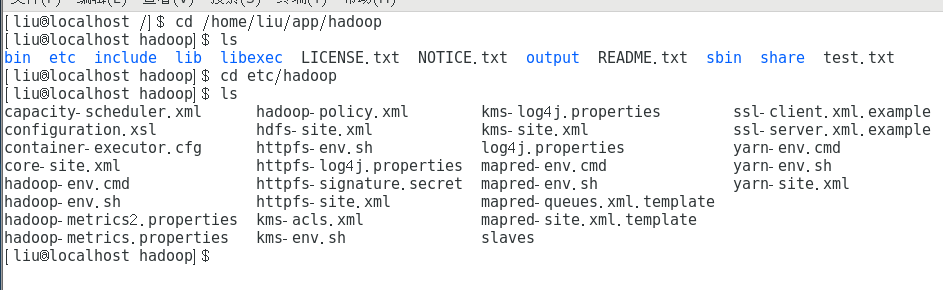

四、Hadoop偽分散式配置

進入hadoop目錄下的/etc/hadoop文件

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>file:/data/tmp</value> </property> <property> <name>hadoop.proxyuser.hadoop.hosts</name> <value>*</value> </property> <property> <name>hadoop.proxyuser.hadoop.groups</name> <value>*</value> </property> </configuration>修改core-site.xml文件

<configuration> <property> <name>dfs.namenode.name.dir</name> <value>/data/dfs/name</value> <final>true</final> </property> <property> <name>dfs.datanode.data.dir</name> <value>/data/dfs/data</value> <final>true</final> </property> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.permissions</name> <value>false</value> </property> </configuration>修改hdfs-site.xml文件

export JAVA_HOME=/home/liu/app/jdk1.8.0_141修改hadoop-env.sh

<configuration> <property> <name>mapreduce.frameword.name</name> <value>yarn</value> </property> </configuration>修改mapred-site.xml.template

<configuration> <!-- Site specific YARN configuration properties --> <property> <name>yarn.nodemanager.aux-servies</name> <value>mapreduce_shuffle</value> </property> </configuration>修改yarn-site.xml

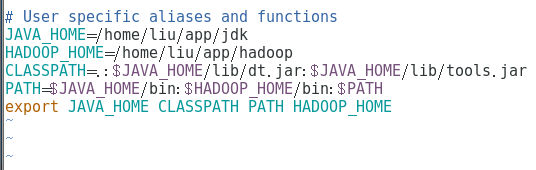

配置hadoop環境在 ~/.bashrc文件下

保存退出後記得source ~/.bashrc是修改生效。

然後在~下創建配置文件中的目錄,

mkdir -p data/p

mkdir -p /data/dfs/name

mkdir -p /data/dfs/data

第一次需要格式化namenode,進入hadoop目錄下。

cd /home/liu/app/hadoop

格式化。

bin/hdfs namenode -format

啟動hadoop

sbin/start-all.sh

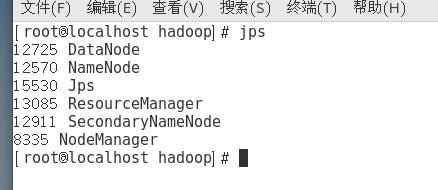

啟動完畢後輸入jps查看。

最重要的是NameNode和DataNode。這樣就配置並且啟動成功了。

需要註意的是如果jps後並沒有則說明配置錯誤,請檢查配置文件,若配置完環境變數後檢測是否成功,提示失敗並給出路徑,很有可能是環境變數配置路徑錯誤。

若第一次啟動hadoop失敗,後邊重新啟動的時候,請刪除~下新建的data文件重新格式化NameNode。