1.首先安裝scala(找到合適版本的具體地址下載) 在/usr/local/目錄下 wget https://www.scala-lang.org/download/**** 2.安裝spark (由於我的Hadoop是2.7.6版本的,因此我所用的spark是在官網上的適用hadoop-2以上版 ...

1.首先安裝scala(找到合適版本的具體地址下載)

在/usr/local/目錄下wget https://www.scala-lang.org/download/****

2.安裝spark

(由於我的Hadoop是2.7.6版本的,因此我所用的spark是在官網上的適用hadoop-2以上版本的)wget http://mirrors.tuna.tsinghua.edu.cn/apache/spark/spark-2.4.3/spark-2.4.3-bin-hadoop2.7.tgz tar -zxvf spark-2.4.3-bin-hadoop2.7.tgz rm spark-2.4.3-bin-hadoop2.7.tgz

3.配置環境變數

vim /etc/profile

4.刷新環境變數

source /etc/profile

5.複製配置文件

cp slaves.template slaves cp spark-env.sh.template spark-env.sh

6.接著進行以下配置

vim /etc/profile(查看其它配置文件直接複製即可) vim ./spark-2.4.3-bin-hadoop2.7/conf vim spark-env.sh

7.啟動spark環境

1)先啟動Hadoop環境

/usr/local/hadoop-2.7.6/sbin/start-all.sh

2) 啟動Spark環境

/usr/local/spark-2.4.3-bin-hadoop2.7/sbin/start-all.sh

8.查看spark的web控制界面

我的是:http://192.168.87.140:8080 顯示埠為7077

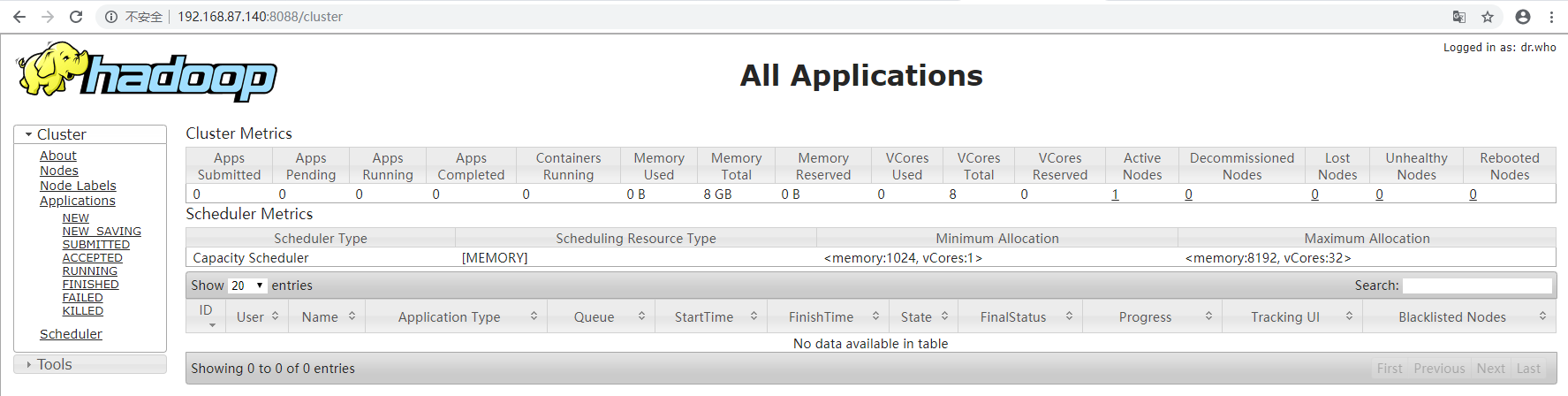

9.查看Hadoop的web端界面

我的是:http://192.168.87.140:8088

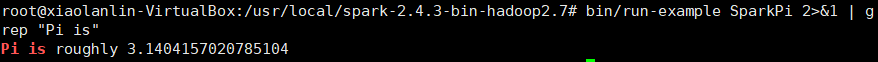

10.驗證Spark是否安裝成功

bin/run-example SparkPi註意:命令執行後出現一大堆東西,只需要從中找到下麵這個圖中的東西,就說明安裝成功。

bin/run-example SparkPi 2>&1 | grep "Pi is"

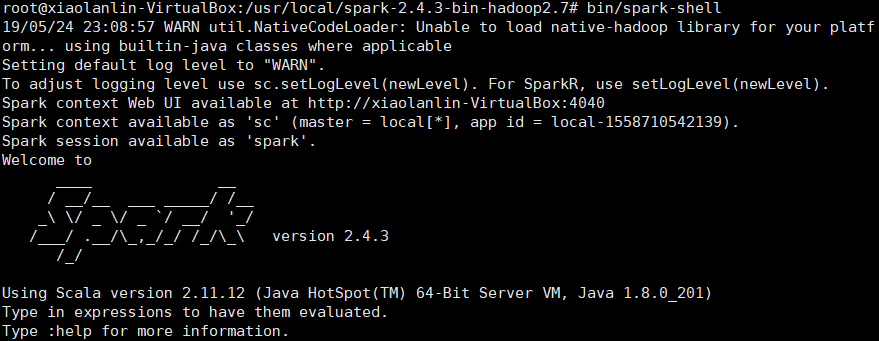

11.使用Spark Shell編寫代碼

1)啟動Spark Shell

bin/spark-shell

2)載入text文件

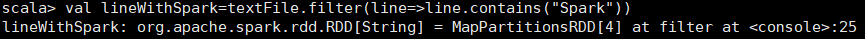

spark創建sc,可以載入本地文件和HDFS文件創建RDD。這裡用Spark自帶的本地文件README.md文件測試。 scala>val textFile=sc.textFile("file:///usr/local/spark-2.4.3-bin-hadoop2.7/README.md") 載入HDFS文件和本地文件都是使用textFile,區別是添加首碼(hdfs://和file://)進行標識。3)簡單RDD操作

scala> textFile.first() // 獲取RDD文件textFile的第一行內容 scala> textFile.count() // 獲取RDD文件textFile的所有項的計數

scala> val lineWithSpark=textFile.filter(line=>line.contains("Spark"))// 抽取含有“Spark”的行,返回一個新的RDD

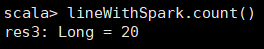

scala> lineWithSpark.count() //統計新的RDD的行數

4)可以通過組合RDD操作進行組合,可以實現簡易MapReduce操作

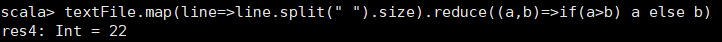

scala> textFile.map(line=>line.split(" ").size).reduce((a,b)=>if(a>b) a else b) //找出文本中每行的最多單詞數

5)退出Spark shell

:quit