實現流程 這裡我將這個功能抽象成一個面具載入服務,請跟隨我的代碼一窺究竟吧。 1.導入對應的工具包 from time import sleep import cv2 import numpy as np from PIL import Image from imutils import face_ ...

實現流程

從攝像頭獲取視頻流,並轉換為一幀一幀的圖像,然後將圖像信息傳遞給opencv這個工具庫處理,返回灰度圖像(就像你使用本地靜態圖片一樣)

程式啟動後,根據監聽器信息,使用一個while迴圈,不斷的載入視頻圖像,然後返回給opencv工具呈現圖像信息。

創建一個鍵盤事件監聽,按下"d"鍵,則開始執行面部匹配,併進行面具載入(這個過程是動態的,你可以隨時移動)。

面部匹配使用Dlib中的人臉檢測演算法來查看是否有人臉存在。如果有,它將為每個人臉創建一個結束位置,眼鏡和煙捲會移動到那裡結束。

然後我們需要縮放和旋轉我們的眼鏡以適合每個人的臉。我們將使用從Dlib的68點模型返回的點集來找到眼睛和嘴巴的中心,併為它們之間的空間旋轉。

在我們實時獲取眼鏡和煙捲的最終位置後,眼鏡和煙捲從屏幕頂部進入,開始匹配你的眼鏡和嘴巴。

假如沒有人臉,程式會直接返回你的視頻信息,不會有面具移動的效果。

預設一個周期是4秒鐘。然後你可以通過"d"鍵再次檢測。

程式退出使用"q"鍵。

這裡我將這個功能抽象成一個面具載入服務,請跟隨我的代碼一窺究竟吧。

- 1.導入對應的工具包

from time import sleep

import cv2

import numpy as np

from PIL import Image

from imutils import face_utils, resize

try:

from dlib import get_frontal_face_detector, shape_predictor

except ImportError:

raise

- 創建面具載入服務類

DynamicStreamMaskService及其對應的初始化屬性:

class DynamicStreamMaskService(object):

"""

動態黏貼面具服務

"""

def __init__(self, saved=False):

self.saved = saved # 是否保存圖片

self.listener = True # 啟動參數

self.video_capture = cv2.VideoCapture(0) # 調用本地攝像頭

self.doing = False # 是否進行面部面具

self.speed = 0.1 # 面具移動速度

self.detector = get_frontal_face_detector() # 面部識別器

self.predictor = shape_predictor("shape_predictor_68_face_landmarks.dat") # 面部分析器

self.fps = 4 # 面具存在時間基礎時間

self.animation_time = 0 # 動畫周期初始值

self.duration = self.fps * 4 # 動畫周期最大值

self.fixed_time = 4 # 畫圖之後,停留時間

self.max_width = 500 # 圖像大小

self.deal, self.text, self.cigarette = None, None, None # 面具對象

- 按照上面介紹,我們先實現讀取視頻流轉換圖片的函數:

def read_data(self):

"""

從攝像頭獲取視頻流,並轉換為一幀一幀的圖像

:return: 返回一幀一幀的圖像信息

"""

_, data = self.video_capture.read()

return data

- 接下來我們實現人臉定位函數,及眼鏡和煙捲的定位:

def get_glasses_info(self, face_shape, face_width):

"""

獲取當前面部的眼鏡信息

:param face_shape:

:param face_width:

:return:

"""

left_eye = face_shape[36:42]

right_eye = face_shape[42:48]

left_eye_center = left_eye.mean(axis=0).astype("int")

right_eye_center = right_eye.mean(axis=0).astype("int")

y = left_eye_center[1] - right_eye_center[1]

x = left_eye_center[0] - right_eye_center[0]

eye_angle = np.rad2deg(np.arctan2(y, x))

deal = self.deal.resize(

(face_width, int(face_width * self.deal.size[1] / self.deal.size[0])),

resample=Image.LANCZOS)

deal = deal.rotate(eye_angle, expand=True)

deal = deal.transpose(Image.FLIP_TOP_BOTTOM)

left_eye_x = left_eye[0, 0] - face_width // 4

left_eye_y = left_eye[0, 1] - face_width // 6

return {"image": deal, "pos": (left_eye_x, left_eye_y)}

def get_cigarette_info(self, face_shape, face_width):

"""

獲取當前面部的煙捲信息

:param face_shape:

:param face_width:

:return:

"""

mouth = face_shape[49:68]

mouth_center = mouth.mean(axis=0).astype("int")

cigarette = self.cigarette.resize(

(face_width, int(face_width * self.cigarette.size[1] / self.cigarette.size[0])),

resample=Image.LANCZOS)

x = mouth[0, 0] - face_width + int(16 * face_width / self.cigarette.size[0])

y = mouth_center[1]

return {"image": cigarette, "pos": (x, y)}

def orientation(self, rects, img_gray):

"""

人臉定位

:return:

"""

faces = []

for rect in rects:

face = {}

face_shades_width = rect.right() - rect.left()

predictor_shape = self.predictor(img_gray, rect)

face_shape = face_utils.shape_to_np(predictor_shape)

face['cigarette'] = self.get_cigarette_info(face_shape, face_shades_width)

face['glasses'] = self.get_glasses_info(face_shape, face_shades_width)

faces.append(face)

return faces

- 剛纔我們提到了鍵盤監聽事件,這裡我們實現一下這個函數:

def listener_keys(self):

"""

設置鍵盤監聽事件

:return:

"""

key = cv2.waitKey(1) & 0xFF

if key == ord("q"):

self.listener = False

self.console("程式退出")

sleep(1)

self.exit()

if key == ord("d"):

self.doing = not self.doing

- 接下來我們來實現載入面具信息的函數:

def init_mask(self):

"""

載入面具

:return:

"""

self.console("載入面具...")

self.deal, self.text, self.cigarette = (

Image.open(x) for x in ["images/deals.png", "images/text.png", "images/cigarette.png"]

)

- 上面基本的功能都實現了,我們該實現畫圖函數了,這個函數原理和之前我寫的那篇用AI人臉識別技術實現抖音特效實現是一樣的,這裡我就不贅述了,可以去github或Python中文社區微信公眾號查看。

def drawing(self, draw_img, faces):

"""

畫圖

:param draw_img:

:param faces:

:return:

"""

for face in faces:

if self.animation_time < self.duration - self.fixed_time:

current_x = int(face["glasses"]["pos"][0])

current_y = int(face["glasses"]["pos"][1] * self.animation_time / (self.duration - self.fixed_time))

draw_img.paste(face["glasses"]["image"], (current_x, current_y), face["glasses"]["image"])

cigarette_x = int(face["cigarette"]["pos"][0])

cigarette_y = int(face["cigarette"]["pos"][1] * self.animation_time / (self.duration - self.fixed_time))

draw_img.paste(face["cigarette"]["image"], (cigarette_x, cigarette_y),

face["cigarette"]["image"])

else:

draw_img.paste(face["glasses"]["image"], face["glasses"]["pos"], face["glasses"]["image"])

draw_img.paste(face["cigarette"]["image"], face["cigarette"]["pos"], face["cigarette"]["image"])

draw_img.paste(self.text, (75, draw_img.height // 2 + 128), self.text)

- 既然是一個服務類,那該有啟動與退出函數吧,最後我們來寫一下吧。

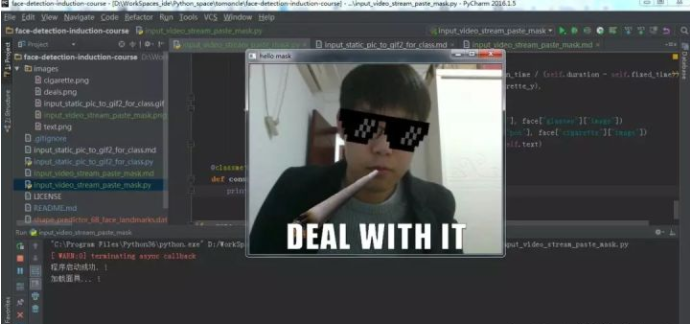

簡單介紹一下這個start()函數, 啟動後根據初始化監聽信息,不斷監聽視頻流,並將流信息通過opencv轉換成圖像展示出來。

並且調用按鍵監聽函數,不斷的監聽你是否按下"d"鍵進行面具載入,如果監聽成功,則進行圖像人臉檢測,並移動面具,

並持續一個周期的時間結束,面具此時會根據你的面部移動而移動。最終呈現文章頂部圖片的效果.

def start(self):

"""

啟動程式

:return:

"""

self.console("程式啟動成功.")

self.init_mask()

while self.listener:

frame = self.read_data()

frame = resize(frame, width=self.max_width)

img_gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

rects = self.detector(img_gray, 0)

faces = self.orientation(rects, img_gray)

draw_img = Image.fromarray(cv2.cvtColor(frame, cv2.COLOR_BGR2RGB))

if self.doing:

self.drawing(draw_img, faces)

self.animation_time += self.speed

self.save_data(draw_img)

if self.animation_time > self.duration:

self.doing = False

self.animation_time = 0

else:

frame = cv2.cvtColor(np.asarray(draw_img), cv2.COLOR_RGB2BGR)

cv2.imshow("hello mask", frame)

self.listener_keys()

def exit(self):

"""

程式退出

:return:

"""

self.video_capture.release()

cv2.destroyAllWindows()

- 最後,讓我們試試:

if __name__ == '__main__':

ms = DynamicStreamMaskService()

ms.start()

- 寫到這裡,這個小功能就已經實現了,大家不妨事來使用一下。