配置前先把功能變數名稱映射配好哈 詳情參考我的其他隨筆 下載好hdfs.tar.gz 後 在/home/ldy下 mkdir apps/ tar -xzvf hdfs.tar.gz -C /home/ldy/apps/ #專門用來安裝hdfs 和jdk的 修改環境變數:vim /etc/profile 在最 ...

配置前先把功能變數名稱映射配好哈 詳情參考我的其他隨筆(哪裡不通可以在下方評論)

下載好hdfs.tar.gz 後

在/home/ldy下

mkdir apps/

tar -xzvf hdfs.tar.gz -C /home/ldy/apps/ #專門用來安裝hdfs 和jdk的

修改環境變數:vim /etc/profile

在最後的fi上面添加

export HDP_HOME=/home/ldy/apps/hadoop-2.8.5/etc/hadoop #路徑因人而定

export PATH=$PATH:$HDP_HOME/sbin : $HDP_HOME/bin

hadoop-daemon.sh 等命令在sbin目錄下(舊版的在bin下) 最好兩個都配。jdk的配置也是一樣的道理

當出現命令not found 時:source /etc/profile 即可

配置文件:

在/home/ldy/apps/hadoop-2.8.5/etc/hadoop下

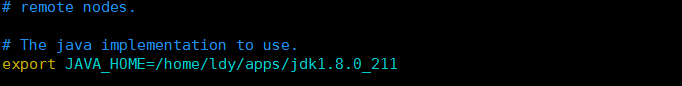

vim hadoop-env.sh #告訴它java_home即可

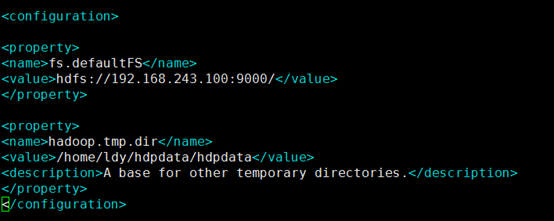

Vim core-site.xml

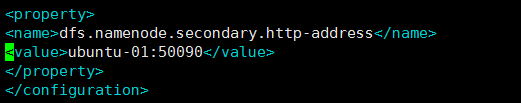

Vim hdfs-site.xml

註:core-site.xml配置錯誤會導致 incorrect namenode addr

name標簽的值不可以修改

功能變數名稱映射後value值可以寫主機名,且所有伺服器的core-site.xml的地址必須一致,確保使用同一個文件系統

配置一下secondary namenodes:(這個是優化設置,配了會好些)

建議大家先配好一個伺服器然後直接複製粘貼文件到其他伺服器,省得麻煩

複製本地文件到其他伺服器需要遠程連接,開啟ssh服務以及使用scp遠程連接命令

註:需要連接的主機也要開通ssh以及安裝scp

開啟ssh:

運行 ps -e | grep ssh,查看是否有sshd進程

如果沒有,說明server沒啟動,通過 /etc/init.d/ssh -start 啟動server進程,如果提示ssh不存在 那麼就是沒安裝server

安裝server

1.sudo apt-get update

2.sudo apt-get install openssh-server

apt-get過程中可能出現:

E: Could not get lock /var/lib/dpkg/lock-frontend - open (11: Resource temporarly unavailable)

E: Unable to acquire the dpkg frontend lock (/var/lib/dpkg/lock-frontend), is an other process using it?

當出現這個報錯時直接:

sudo rm /var/lib/dpkg/lock-frontend

sudo rm /var/lib/dpkg/lock

接下來有可能還會報下麵的錯:

E: Could not get lock /var/lib/apt/lists/lock - open (11: Resource temporarily unavailable)

Unable to lock directory /var/lib/apt/lists

sudo rm /var/lib/apt/lists/lock

apt-get update 即可

Scp :

scp -r /home/ldy/apps/hadoop-2.8.5 ubuntu-01:/home/ldy/apps/

#將本地的hadoop文件複製到ubuntu-01主機的apps目錄下

報錯: ssh連接The authenticity of host can't be established

修改/etc/ssh/ssh_config文件的配置

修改:(沒有就在最後面添加)

StrictHostKeyChecking no

註:一般是禁止root用戶登錄的,切換到普通用戶可正常使用

當出現這個錯誤時:

Permisson denied ,please try again

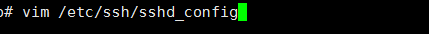

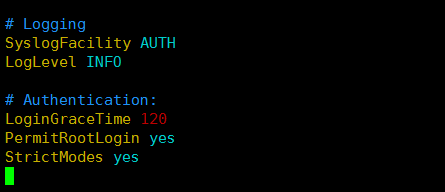

出現這個錯誤是因為請求被拒絕,是ssh的許可權問題,需要修改ssh許可權,切換root, 直接vim /etc/ssh/sshd_config

將PermitRootLogin no 改為 PermitRootLogin yes

記得重啟ssh:sudo service ssh restart

hadoop namenode -format (一次就夠了)

start-dfs.sh (開啟namenode和datanode服務)

使用這個命令每次都要輸密碼,這裡可以設一個免密登錄,在namenode伺服器上設比較好

免密登錄:

ssh-keygen;(一直回車就行)

ssh-copy-id 主機名;(有多少個主機執行多少次這個命令)

vim etc/hadoop/slaves (加上所有需要免密的主機名)

註意:虛擬機重啟後得重新執行 start-dfs.sh,namenode和datanode才啟動(其本質是軟體)

若有不對敬請指正........