搭建zk集群,起碼保證3台虛擬機的配置,本人使用的虛擬機環境為wm14+centos7+jdk1.8 下載地址 下載地址 zk的tar包下載地址:http://mirror.bit.edu.cn/apache/zookeeper/ 安裝方式 安裝方式 下載好tar包後上傳到自己的虛擬機文件夾中,這裡 ...

搭建zk集群,起碼保證3台虛擬機的配置,本人使用的虛擬機環境為wm14+centos7+jdk1.8

-

下載地址

zk的tar包下載地址:http://mirror.bit.edu.cn/apache/zookeeper/

-

安裝方式

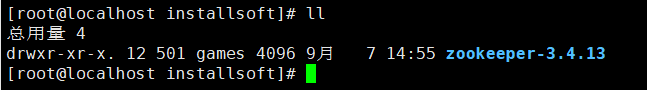

下載好tar包後上傳到自己的虛擬機文件夾中,這裡我自己創建了一個專門存放tar包的目錄soft

使用命令:tar -zxvf zookeeper-3.4.13.tar.gz -C /usr/local/installsoft

將tar包解壓到另一個目錄installsoft中。

為了方便後續直接使用腳本啟動不必進入bin目錄啟動,我們配置一下環境變數。

使用命令:vim /etc/profile

環境變數中增加:

export ZK_HOME=/usr/local/installsoft/zookeeper-3.4-13

export PATH=$ZK_HOME/bin:$PATH

-

集群配置

進入zk目錄

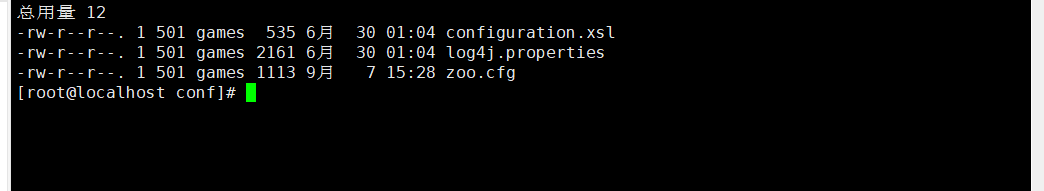

具體每個目錄每個文件什麼含義就不在此多說,有興趣的可以上網找到,我們這裡配置集群主要關註conf文件夾。進入該文件夾。

這裡要提一句,因為本日誌是在整個集群都搭建好之後才過來記錄的,所以這個部分有個小步驟省略掉了,就是修改配置文件的名稱,將原配置文件重命名成了zoo.cfg。

命令:mv 原文件.cfg zoo.cfg

打開配置文件看看內容:命令:vim zoo.cfg

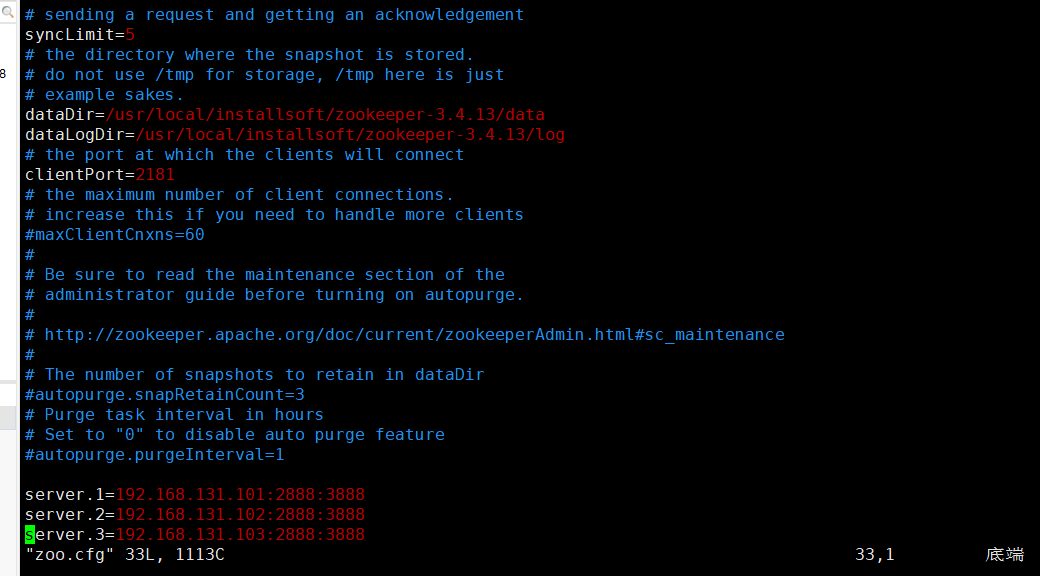

其實裡面的配置內容有很多,但是為了快速的搭建集群,此配置文件只寫了一點點,比如:

dataDir=/usr/local/installsoft/zookeeper-3.4.13/data (數據存儲目錄,一定要記得按照路徑在外面建立文件夾,不然會啟動報錯)

dataLogDir=/usr/local/installsoft/zookeeper-3.4.13/log(日誌存儲目錄,一定要記得按照路徑在外面建立文件夾,不然會啟動報錯)

server.1=ip:2888:3888(集群節點1的配置,包括集群節點的IP,以及zk內部通訊的埠,對外通訊的埠)

server.2=ip:2888:3888(集群節點2的配置,包括集群節點的IP,以及zk內部通訊的埠,對外通訊的埠)

server.3=ip:2888:3888(集群節點3的配置,包括集群節點的IP,以及zk內部通訊的埠,對外通訊的埠)

當然,集群節點可以選擇配置多個,因為機器原因,我虛擬機最多啟動3個就已經卡炸,所以只有3個節點。另外的配置條目具體意思可以自行網上查找,挺多的,這裡不做贅述。

zk目錄下新建兩個文件夾。

另外重點說一下,這裡的data目錄是一定要存在的,但是log文件夾其實可以不用,zk會將日誌自動存儲到預設位置,但是我沒有發現該預設日誌文件的位置,如有知曉的同學,可以告知我一下,萬分感謝。

進入data文件夾。

使用命令:vim myid

linux預設機制,沒有文件創建文件並打開,省略一個創建的步驟。

該文件內容填什麼?其實內容很簡單,就是剛剛配置的集群部分,server.X的X,類似用來表明身份的意思,也就是身份證,表示我這個zk伺服器是集群中的第幾個節點,比如我這台機器IP是192.168.131.101,集群配置為server.1=192.168.131.101:2888:3888,那麼我的myid文件就寫個1即可。

其餘的集群機器可以照著這個路數完全複製過去,僅僅需要註意myid部分的值。

- 啟動zk集群

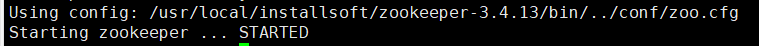

因為我們前面配置了環境變數,所以就不用像啟動別的腳本那樣還要進入到bin目錄下去執行,任意位置,輸入:

zkServer.sh start

等輸出完畢之後,可以看到

代表啟動完畢。

之後輸入:

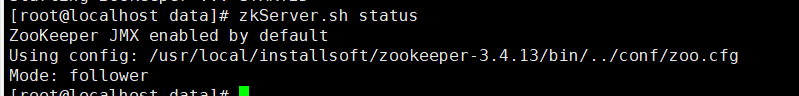

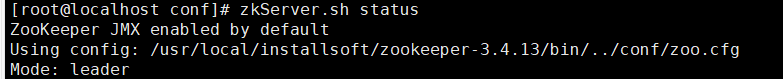

zkServer.sh status

可以查看集群節點狀態。

其餘命令:

zkServer.sh restart(重啟)

zkServer.sh stop (停止)

- 問題

在搭建完成之後,啟動集群,命令zkServer.sh start啟動正常輸出,但是使用zkServer.sh status就在報錯,本想通過日誌查看一下具體報錯問題,但是因為上面也說過,沒找到日誌文件,導致該問題困擾了很久,網上也搜了不少,總結一下:

- 防火牆問題,記得關閉防火牆。

- zoo.cfg文件配置內容,仔細檢查,特別是上面我說的文件夾的創建,一旦忘記或者指定到了zk讀取不到的目錄,就會導致啟動失敗。

- myid內容寫錯或文件位置錯誤。

- 一定要把集群的機器全部啟動之後再來看status,不然就報錯,因為配置了集群,但是其餘的節點沒啟動起來,選舉沒法執行,會導致當前啟動的節點一直觀望,也就獲取不到具體的節點狀態了。(這也是我這次解決問題的使用方法)