這篇筆記咱主要記錄了Hadoop執行Job時可能出現的 /bin/java: No such file or directory 以及 java.lang.reflect.InaccessibleObjectException 問題。 ...

開門見山。

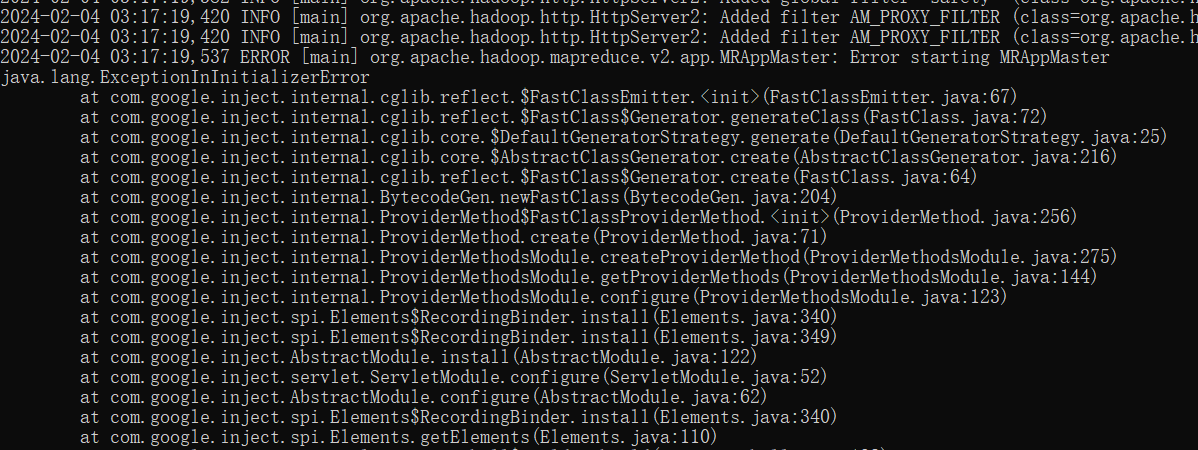

最近在搭建基於 Hadoop 3.3.6 的高可用集群時,遇到了雖然守護進程能正常啟動,但是提交 WordCount 示常式序後作業沒有辦法啟動執行的情況(剛開始就掛了),查看日誌發現主要是以下兩種情況:

-

提示

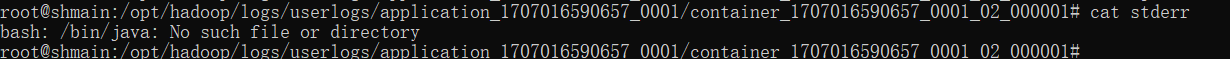

/bin/java文件不存在。bash: /bin/java: No such file or directory -

啟動

MRAppMaster失敗,原因是其拋出了java.lang.reflect.InaccessibleObjectException異常。java.lang.reflect.InaccessibleObjectException: Unable to make ... accessible: module java.base does not "opens java.lang" to unnamed module @...

這裡簡單寫一下二者的解決方法。

1. /bin/java 不存在

字面上看是 Bash 找不到可執行文件 /bin/java ,但細想一下,無論是在 hadoop-env.sh 還是 yarn-env.sh 亦或者 yarn-site.xml 的 yarn.nodemanager.env-whitelist 配置中,我全都加上了 JAVA_HOME 的相關環境變數配置,我在任何地方都沒有寫過 /bin/java 這個路徑,就有點令人匪夷所思了。

但在看了 NodeManager 執行作業時生成的預設容器啟動腳本 launch_container.sh 後就能發現其末尾寫著這樣的語句(這個腳本的位置可以參考下方):

echo "Launching container"

exec /bin/bash -c "$JAVA_HOME/bin/java ... -Xmx1024m org.apache.hadoop.mapreduce.v2.app.MRAppMaster ...

顯而易見,這裡因為 $JAVA_HOME 環境變數沒有傳遞進腳本,導致 bash 實際執行的是 /bin/java。

怎麼解決這個問題?最粗暴的方式是直接給 Java 創建一個軟鏈 /bin/java (網上很多複製粘貼的帖子給出的方法),這樣做雖然能跑,但其實沒觸及根本的問題。

還有一種方法是直接在 Hadoop安裝目錄/libexec/hadoop-config.sh 中導出一個 JAVA_HOME 環境變數。(網上的帖子里還有修改這裡某個條件判斷語句的解決方案,但是在 Hadoop 新版中這部分代碼已經重構了)

我真的好想找出問題的根源哇!(╯▔皿▔)╯ 回去檢查配置文件,我也沒看出什麼問題,該配置的都配置了。

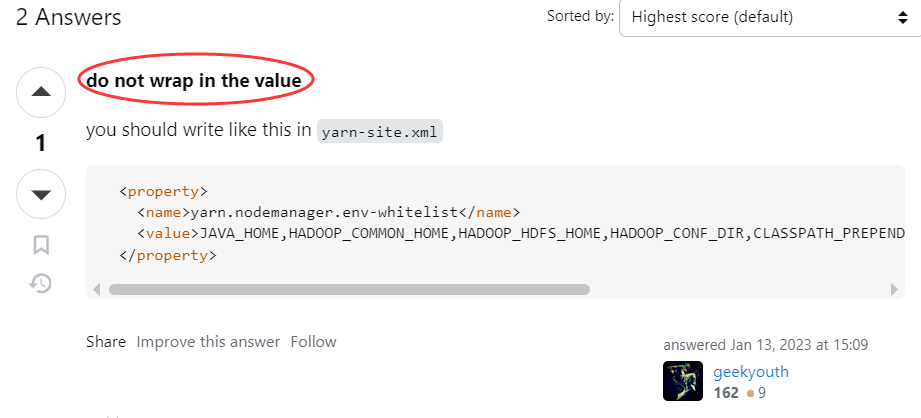

到底還是偶然看到的 StackOverflow 的一位老哥點明瞭我(鏈接):

“不要在屬性值中換行”

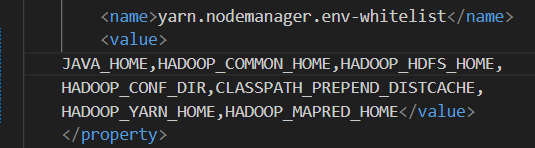

回去檢查了一下我的 yarn-site.xml 配置,發現 VSCode 格式化工具幫我格式化成了這個樣子:

去掉開頭的換行符,改成 <value>JAVA_HOME, ...</value> 就能把這個問題給解決了...原來是值中出現額外字元而導致的,哭笑不得。

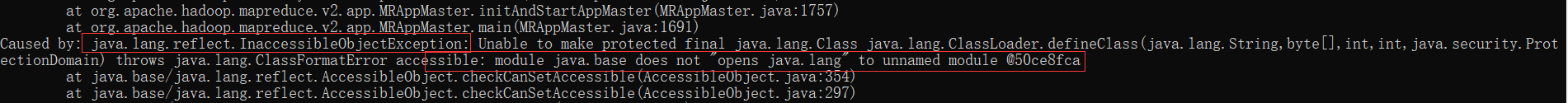

2. java.lang.reflect.InaccessibleObjectException

這個異常貼到網上倒是能找到很多類似的解決方案,即加上 Java 選項 --add-opens java.base/java.lang=ALL-UNNAMED ,但大多是圍繞 ResourceManager, NodeManager 啟動時的情況。

問題就在於這裡 MRAppMaster 的啟動參數位於 launch_container.sh 中,因而我需要找到辦法在腳本的這一句中加入 Java 選項:

exec /bin/bash -c "$JAVA_HOME/bin/java ... -Xmx1024m org.apache.hadoop.mapreduce.v2.app.MRAppMaster ...

在官方文檔里按 java opts 這種關鍵詞查了半天沒找著,轉變思路用 MRAppMaster 搜索,還真就給我找著了。在 mapred-site.xml 配置中有這樣一個屬性(文檔鏈接):

| 屬性名 | 預設值 | 說明 |

|---|---|---|

| yarn.app.mapreduce.am.command-opts | -Xmx1024m | Java opts for the MR App Master processes.... |

正好就是 MRAppMaster 進程啟動時的 Java 選項,在 mapred-site.xml 中加入如下屬性配置即可:

<property>

<name>yarn.app.mapreduce.am.command-opts</name>

<!--保留了 -Xmx1024 -->

<value>--add-opens java.base/java.lang=ALL-UNNAMED -Xmx1024m</value>

<description>MR App Master 進程的 Java 參數</description>

</property>

附: 找到 Job 執行對應容器 (Container) 的執行日誌

首先執行一個作業(Job),然後在集群某台機器中找到其對應的 Application:

# 找到 Job 對應的 Application

yarn application -list -appStates=ALL

返回內容大概是這樣:

Total number of applications (application-types: [], states: [NEW, NEW_SAVING, SUBMITTED, ACCEPTED, RUNNING, FINISHED, FAILED, KILLED] and tags: []):2

Application-Id Application-Name Application-Type User Queue State Final-State Progress Tracking-URL

application_1707118501768_0002 word count MAPREDUCE root default FINISHED SUCCEEDED 100% http://shworker1:19888/jobhistory/job/job_1707118501768_0002

找到 applicationId 後,查詢這個應用在哪台機器上執行:

yarn application -status application_1707118501768_0002

返回內容大概是這樣:

Application Report :

Application-Id : application_1707118501768_0002

Application-Name : word count

Application-Type : MAPREDUCE

User : root

Queue : default

Application Priority : 0

Start-Time : 1707120843501

Finish-Time : 1707120865825

Progress : 100%

State : FINISHED

Final-State : SUCCEEDED

Tracking-URL : http://shworker1:19888/jobhistory/job/job_1707118501768_0002

RPC Port : 42097

AM Host : shworker1

Aggregate Resource Allocation : 52071 MB-seconds, 35 vcore-seconds

Aggregate Resource Preempted : 0 MB-seconds, 0 vcore-seconds

Log Aggregation Status : DISABLED

Diagnostics :

Unmanaged Application : false

Application Node Label Expression : <Not set>

AM container Node Label Expression : <DEFAULT_PARTITION>

TimeoutType : LIFETIME ExpiryTime : UNLIMITED RemainingTime : -1seconds

其中 AM Host 即為應用執行所在主機,這裡是 shworker1。

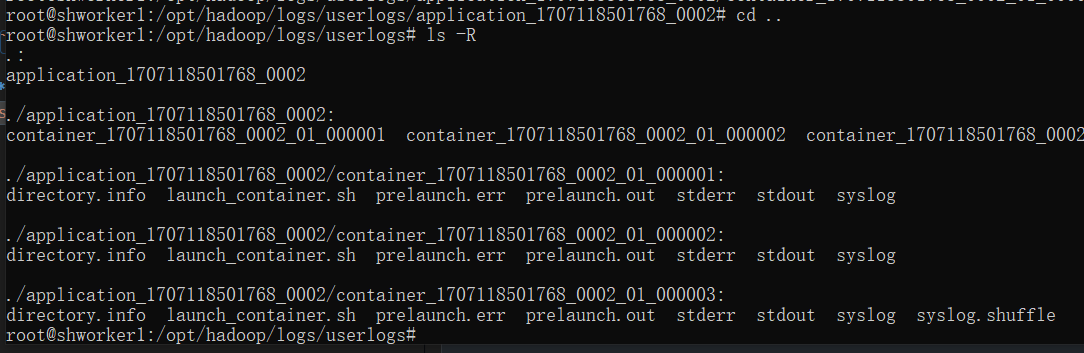

在主機 shworker1 上進入Hadoop的日誌目錄,這個日誌目錄預設是 ${HADOOP_HOME}/logs 。其中會有一個子目錄 userlogs,在這個目錄內你就能找到 application_1707118501768_0002 的 Container 日誌了: