[toc] # 一、爬蟲對象-豆瓣音樂TOP250 今天我們分享一期python爬蟲案例講解。爬取對象是,豆瓣音樂TOP250排行榜數據:https://music.douban.com/top250

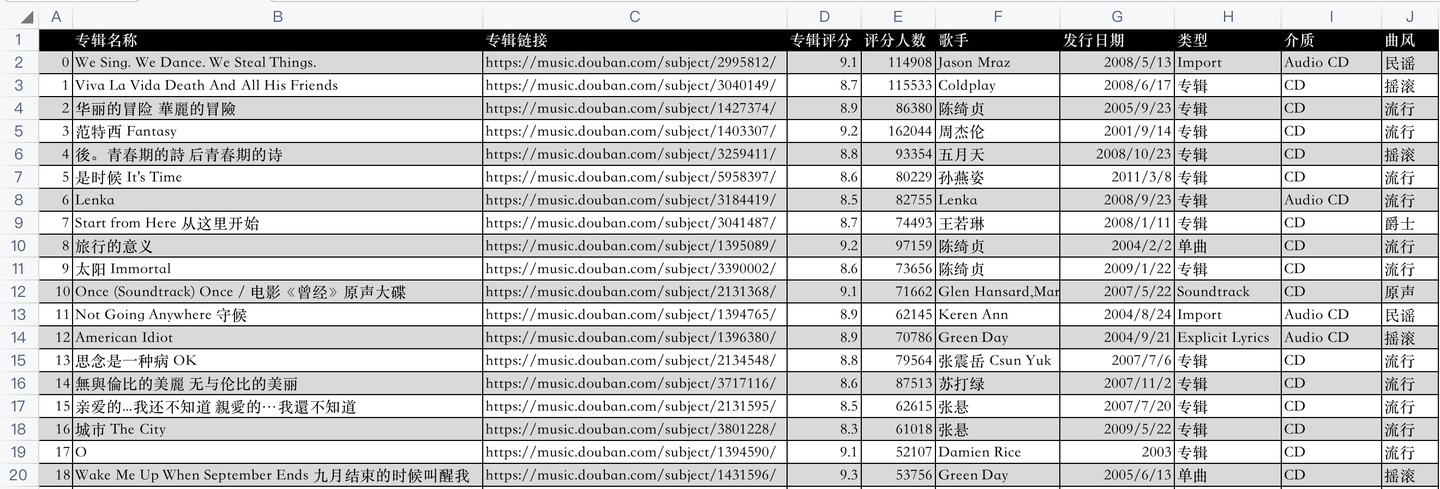

開發好python爬蟲代碼後,爬取成功後的csv數據,如下:

代碼是怎樣實現的爬取呢?下麵逐一講解python實現。

二、python爬蟲代碼講解

首先,導入需要用到的庫:

import requests # 發送請求

from bs4 import BeautifulSoup # 解析網頁

import pandas as pd # 存取csv

from time import sleep # 等待時間

然後,向豆瓣音樂網頁發送請求:

res = requests.get(url, headers=headers)

利用BeautifulSoup庫解析響應頁面:

soup = BeautifulSoup(res.text, 'html.parser')

用BeautifulSoup的select函數,(css解析的方法)編寫代碼邏輯,部分核心代碼:

name = music.select('.pl2 a')[0].text.replace('\n', '').replace(' ', ' ').strip() # 專輯名稱

music_name.append(name)

url = music.select('.pl2 a')[0]['href'] # 專輯鏈接

music_url.append(url)

star = music.select('.rating_nums')[0].text # 音樂評分

music_star.append(star)

star_people = music.select('.pl')[1].text # 評分人數

star_people = star_people.strip().replace(' ', '').replace('人評價', '').replace('(\n', '').replace('\n)',

'') # 數據清洗

music_star_people.append(star_people)

music_infos = music.select('.pl')[0].text.strip() # 歌手、發行日期、類型、介質、曲風

最後,將爬取到的數據保存到csv文件中:

def save_to_csv(csv_name):

"""

數據保存到csv

:return: None

"""

df = pd.DataFrame() # 初始化一個DataFrame對象

df['專輯名稱'] = music_name

df['專輯鏈接'] = music_url

df['專輯評分'] = music_star

df['評分人數'] = music_star_people

df['歌手'] = music_singer

df['發行日期'] = music_pub_date

df['類型'] = music_type

df['介質'] = music_media

df['曲風'] = music_style

df.to_csv(csv_name, encoding='utf_8_sig') # 將數據保存到csv文件

其中,把各個list賦值為DataFrame的各個列,就把list數據轉換為了DataFrame數據,然後直接to_csv保存。

這樣,爬取的數據就持久化保存下來了。

需要說明的是,豆瓣頁面上第4、5、6頁只有24首(不是25首),所以總數量是247,不是250。

不是爬蟲代碼有問題,是豆瓣頁面上就只有247條數據。

三、同步視頻

同步講解視頻:【python爬蟲】利用python爬蟲爬取豆瓣音樂TOP250的數據!

四、獲取完整源碼

附完整源碼:【python爬蟲案例】利用python爬蟲爬取豆瓣音樂TOP250的數據!

我是 @馬哥python說 ,持續分享python源碼乾貨中!