日常生產中 HDFS 上小文件產生是一個很正常的事情,同時小文件也是 Hadoop 集群運維中的常見挑戰,尤其對於大規模運行的集群來說可謂至關重要。 數據地圖是離線開發產品的基本使用單位,包含全部表和項目的相關信息,可以對錶做相關的許可權管理和脫敏管理操作,以及可以展示對應項目占用情況和其表的占用情況 ...

日常生產中 HDFS 上小文件產生是一個很正常的事情,同時小文件也是 Hadoop 集群運維中的常見挑戰,尤其對於大規模運行的集群來說可謂至關重要。

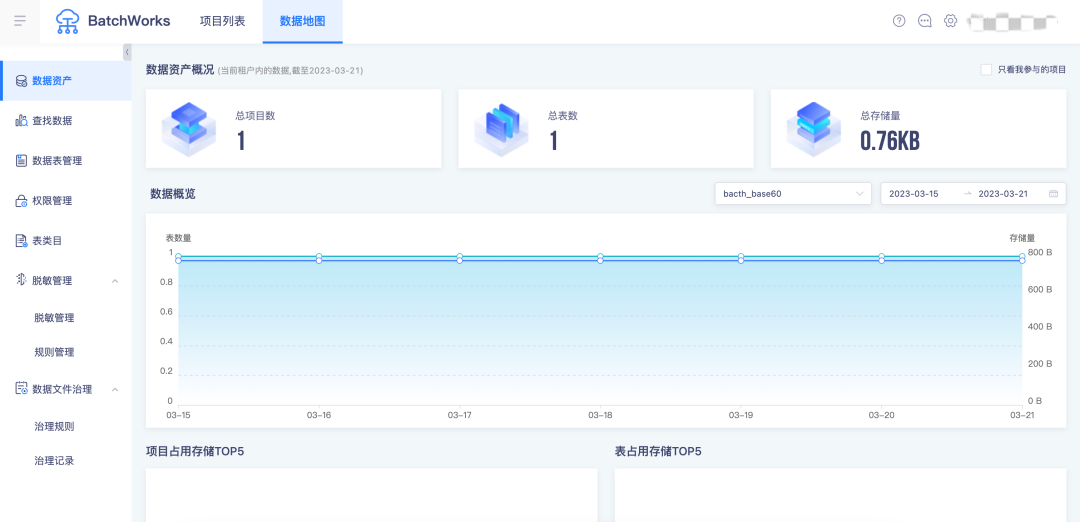

數據地圖是離線開發產品的基本使用單位,包含全部表和項目的相關信息,可以對錶做相關的許可權管理和脫敏管理操作,以及可以展示對應項目占用情況和其表的占用情況。數據地圖可以幫助用戶更好地查找、理解和使用數據。

本文將結合兩者,和大家聊聊數據地圖中的小文件治理應該怎麼做。

小文件的危害

小文件通常指文件大小要比 HDFS 塊大小還要小很多的文件,大量的小文件會給 Hadoop 集群的擴展性和性能帶來嚴重的影響。

NameNode 在記憶體中維護整個文件系統的元數據鏡像、用戶 HDFS 的管理,其中每個 HDFS 文件元信息(位置、大小、分塊等)對象約占150位元組,如果小文件過多,會占用大量記憶體,直接影響 NameNode 的性能。相對地,HDFS 讀寫小文件也會更加耗時,因為每次都需要從 NameNode 獲取元信息,並與對應的 DataNode 建立連接。如果 NameNode 在宕機中恢復,也需要更多的時間從元數據文件中載入。

同時,小文件會給 Spark SQL 等查詢引擎造成查詢性能的損耗,大量的數據分片信息以及對應產生的 Task 元信息也會給 Spark Driver 的記憶體造成壓力,帶來單點問題。此外,入庫操作最後的 commit job 操作,在 Spark Driver 端單點做,很容易出現單點的性能問題。

數據地圖中小文件治理的做法

存儲在 HDFS 中的文件被分成塊,然後將這些塊複製到多個電腦中(DataNode),塊的大小預設為128MB,當文件大小為128時,Hadoop 集群的計算效率最高。因此對非分區表按表進行數據文件合併,使表/分區數據文件的大小接近128M,以此進行小文件的優化。

具體到數據地圖中是怎麼做的呢?

在離線開發平臺中創建出來的表或者底層表都可以通過數據地圖功能維護,我們每天會定時更新這些表的基本信息進行統一維護管理。

在數據地圖中可以根據文件數量和占用存儲創建相應的治理規則,按照每天每周或每月治理。

參數說明

· 規則名稱:新建規則的名稱

· 選擇項目:小文件合併規則生效的項目

· 選擇表:這裡配置的是圈定需要合併的表範圍,判斷條件是 and,例如表的文件數量大於1000並且占用總存儲小於10M時,才會對該表中的文件進行合併操作

· 治理時間:該規則的調度周期,例如每天的凌晨00:00~01:00進行小文件合併,註意如果小文件合併時間到了結束的時間,還沒有合併完成,則會結束當前的合併,等待下次處理

根據治理規則查詢出所有符合信息的表,判斷該表是否為分區表。如果為非分區表則對該表進行文件治理,如果為分區表則按照分區進行治理,最後創建治理記錄。

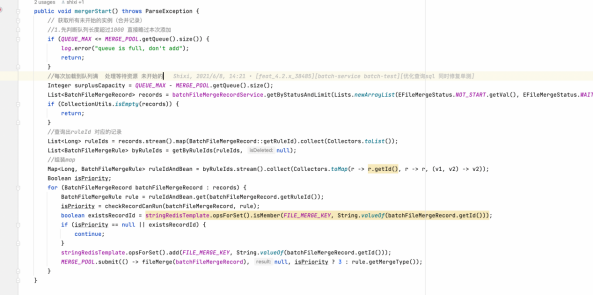

每天定時任務觸發,根據告警記錄查詢記錄中滿足條件的表的基本信息狀態。

● 小文件合併的具體步驟

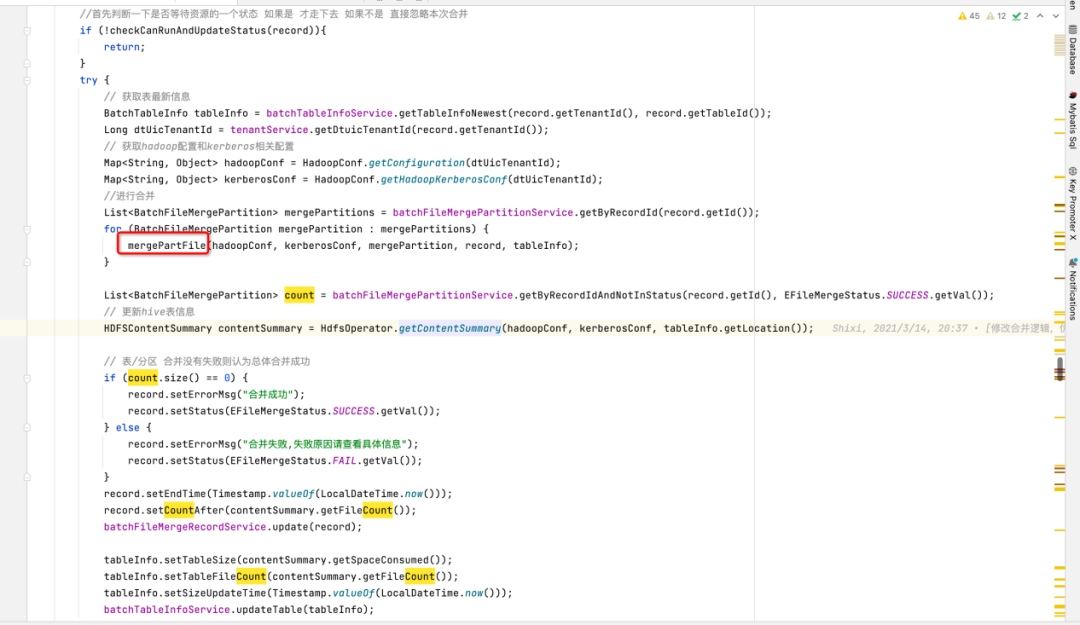

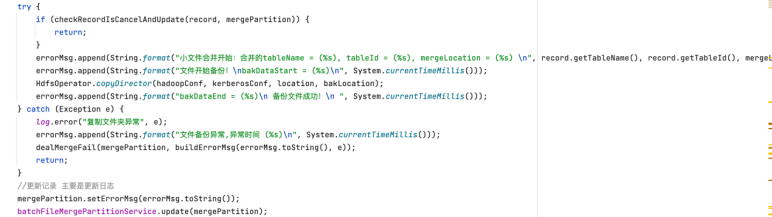

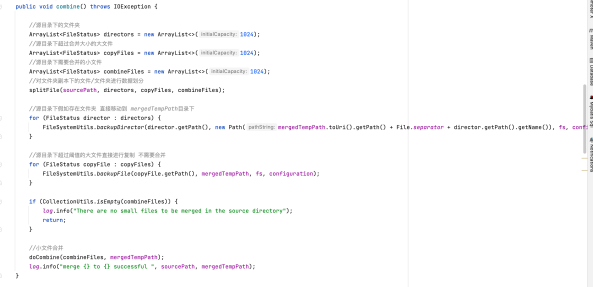

1)備份文件

先創建臨時路徑,把文件複製到臨時路徑中去,再創建要合併的臨時文件

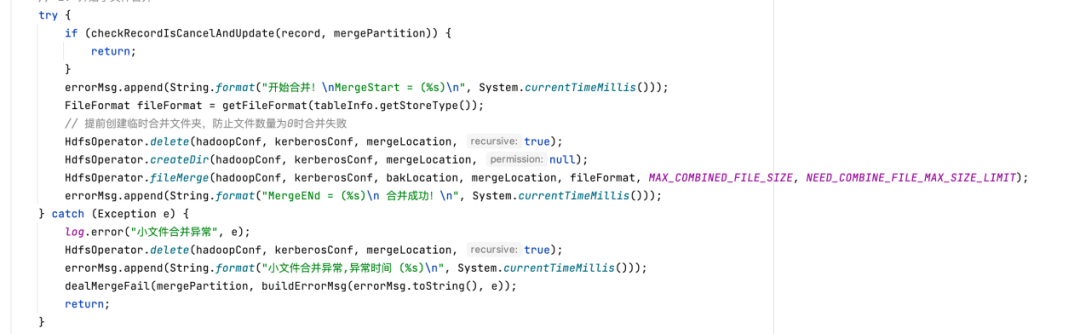

2)小文件合併

執行 HDFS 的 fileMerge 請求合併文件

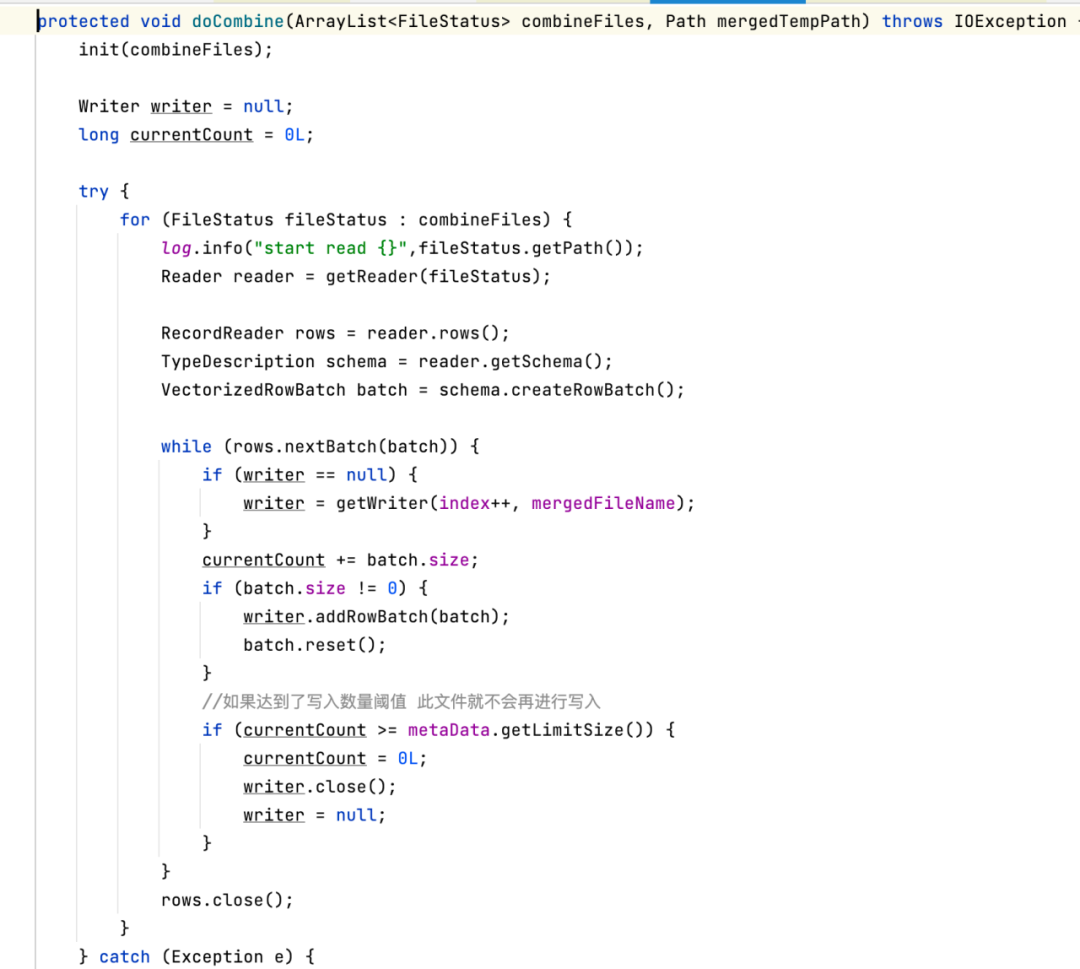

真正調用 hive-exec 方法處理,判斷是否達到閾值合併文件

3)將合併的文件覆蓋到原文件中去

判斷如果合併完成,刪除原路徑下的數據,把臨時路徑修改為原來的真實路徑

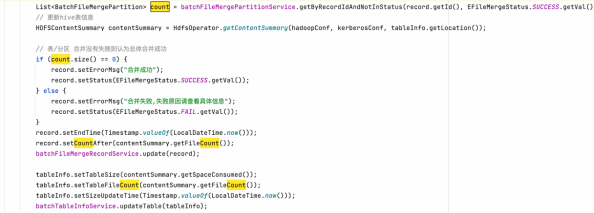

全部處理完成後,查詢 rdos_file_merge_partition 表是否為異常信息列印,若不存在異常信息,更新治理記錄表完成治理,並更新數據地圖中的表信息

治理記錄表把握整體的治理成功失敗狀態,分區信息治理信表維護了整個治理記錄哪些表治理失敗的記錄,最後全量返回對應的是失敗或成功狀態。

· 分區信息治理信表:rdos_file_merge_partition

· 治理記錄表:rdos_file_merge_record

最後把表結構放在下麵,有興趣的小伙伴可以自行查看:

CREATE TABLE `rdos_file_merge_partition` (

`id` int(11) NOT NULL AUTO_INCREMENT,

`project_id` int(11) DEFAULT NULL COMMENT '項目id',

`tenant_id` int(11) DEFAULT NULL COMMENT '租戶id',

`record_id` int(11) DEFAULT NULL COMMENT '合併記錄id',

`status` tinyint(1) DEFAULT NULL COMMENT '合併狀態',

`start_time` datetime DEFAULT NULL COMMENT '開始時間',

`end_time` datetime DEFAULT NULL COMMENT '結束時間',

`error_msg` longtext COMMENT '錯誤信息',

`partition_name` varchar(255) DEFAULT NULL COMMENT '分區名',

`copy_location` varchar(1024) DEFAULT NULL COMMENT '備份路徑',

`storage_before` varchar(255) DEFAULT NULL COMMENT '合併前占用存儲',

`storage_after` varchar(255) DEFAULT NULL COMMENT '合併後占用存儲',

`file_count_before` int(11) DEFAULT NULL COMMENT '合併前文件數量',

`file_count_after` int(11) DEFAULT NULL COMMENT '合併後文件數量',

`gmt_create` datetime DEFAULT NULL COMMENT '創建時間',

`gmt_modified` datetime DEFAULT NULL COMMENT '修改時間',

`is_deleted` tinyint(1) DEFAULT '0' COMMENT '是否刪除 0:未刪除,1 :已刪除',

PRIMARY KEY (`id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8 COMMENT='小文件合併分區信息表';

CREATE TABLE `rdos_file_merge_record` (

`id` int(11) NOT NULL AUTO_INCREMENT,

`project_id` int(11) DEFAULT NULL COMMENT '項目id',

`tenant_id` int(11) DEFAULT NULL COMMENT '租戶id',

`table_id` int(11) DEFAULT NULL COMMENT '合併hive表id',

`table_name` varchar(255) DEFAULT NULL COMMENT '表名',

`rule_id` int(11) DEFAULT NULL COMMENT '小文件合併規則id',

`location` varchar(1024) DEFAULT NULL COMMENT '存儲位置',

`status` tinyint(1) DEFAULT NULL COMMENT '合併狀態',

`error_msg` longtext COMMENT '錯誤信息',

`start_time` datetime DEFAULT NULL COMMENT '合併開始時間',

`end_time` datetime DEFAULT NULL COMMENT '合併結束時間',

`is_partition` tinyint(1) DEFAULT NULL COMMENT '是否是分區表',

`count_before` int(11) DEFAULT NULL COMMENT '合併前文件數量',

`count_after` int(11) DEFAULT NULL COMMENT '合併後文件數量',

`create_user_id` int(11) DEFAULT NULL COMMENT '創建用戶',

`modify_user_id` int(11) DEFAULT NULL COMMENT '修改人id',

`gmt_create` datetime DEFAULT NULL COMMENT '創建時間',

`gmt_modified` datetime DEFAULT NULL COMMENT '修改時間',

`is_deleted` tinyint(1) DEFAULT '0' COMMENT '是否刪除 0:未刪除, 1:已刪除',

`plan_time` datetime NOT NULL COMMENT '計劃時間',

PRIMARY KEY (`id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8 COMMENT='小文件合併記錄表';

《數據治理行業實踐白皮書》下載地址:https://fs80.cn/380a4b

想瞭解或咨詢更多有關袋鼠雲大數據產品、行業解決方案、客戶案例的朋友,瀏覽袋鼠雲官網:https://www.dtstack.com/?src=szbky

同時,歡迎對大數據開源項目有興趣的同學加入「袋鼠雲開源框架釘釘技術qun」,交流最新開源技術信息,qun號碼:30537511,項目地址:https://github.com/DTStack