1、任務介紹 需求分析 爬取豆瓣電影Top250的基本信息,包括電影的名稱,豆瓣評分,評價數,電影概況,電影鏈接等。 https://movie.douban.com/top250 2、基本流程 2.1、準備工作 通過瀏覽器查看分析目標網頁,學習編程基礎規範 與Java的一些區別,Python沒有主 ...

1、任務介紹

需求分析

爬取豆瓣電影Top250的基本信息,包括電影的名稱,豆瓣評分,評價數,電影概況,電影鏈接等。

https://movie.douban.com/top250

2、基本流程

2.1、準備工作

通過瀏覽器查看分析目標網頁,學習編程基礎規範 與Java的一些區別,Python沒有主函數,需要自己去定義並判斷def main():#所有程式從這裡開始執行

print("hello")

if __name__=="__main__": #當 當前程式執行時

#調用函數

main()

2.1.1引入模塊

作用就是使用模塊里封裝好的功能from bs4 import BeautifulSoup#網頁解析

import re #正則表達式,進行文字匹配

import urllib.request,urllib.error #指定URL,獲取網頁數據

import xlwt #進行Excel操作

import sqlite3 # 進行SQLite資料庫操作

#若你的Python升級到2.7.9以後,就會引入一個新特性,

#引入了一個新特性,當使用urllib打開https的鏈接時,會檢驗一次ssl證書

import ssl

#全局取消證書驗證(當項目對安全性問題不太重視時,推薦使用,可以全局取消證書的驗證,簡易方便)

ssl._create_default_https_context = ssl._create_unverified_context

2.1.2構建流程

def main():

baseurl="https://movie.douban.com/top250"#要爬取的網站的路徑

#1.爬取網頁

datalist=getData(baseurl)#將網站爬取的數據存放在datalist中

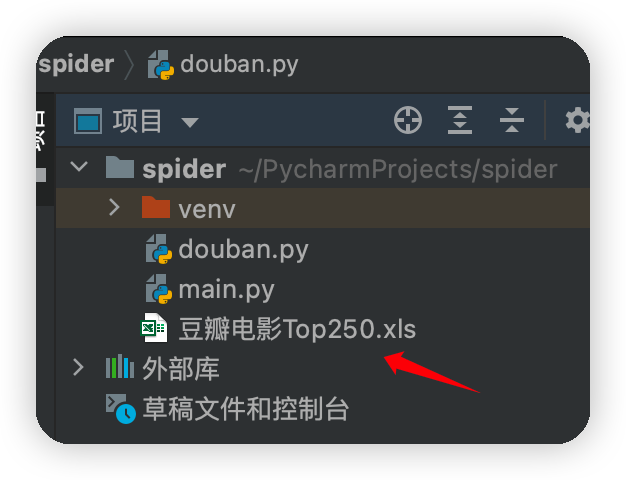

savepath="豆瓣電影Top250.xls"#爬取的數據保存的文件名

#3.保存數據

saveData(datalist,savepath)#將爬取的數據保存在指定的文件內

#爬取網頁

def getData(baseurl):

datalist=[]

return datalist

2.2、獲取數據

通過HTTP庫向目標站點發起請求,請求可以包含額外的header等信息,如果伺服器能正常響應,會得到一個Response,便是所要獲取的頁面內容。 偽裝head得到的方法

#爬取網頁

def getData(baseurl):

datalist=[]

for i in range(0,10):#調用獲取頁面信息的函數,10次

url=baseurl+str(i*25)#baseurl就是參數start後面的值,其實就是個0

html=askURL(url)#保存獲取到的網頁源碼

#得到指定一個URL的網頁內容

def askURL(url):

#用戶代理表示告訴豆瓣服務我們是什麼類型的機器,瀏覽器(本質上是告訴瀏覽器,我們可以接受什麼水平的文件內容)

head={ #模擬瀏覽器頭部信息,向豆瓣伺服器發送消息

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/92.0.4515.159 Safari/537.36" }

request=urllib.request.Request(url,headers=head)#偽裝成是瀏覽器去發出請求,防止被看出是爬蟲

html=""

try:

#將爬取網頁的源碼存放在response中(獲取一個get請求)

response = urllib.request.urlopen(request)

html=response.read().decode("utf-8")#將response中讀取到的源代碼進行解碼

#print(html)

except urllib.error.URLError as e:#訪問可能出現404,或者其它錯誤

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

return html

2.3、解析內容

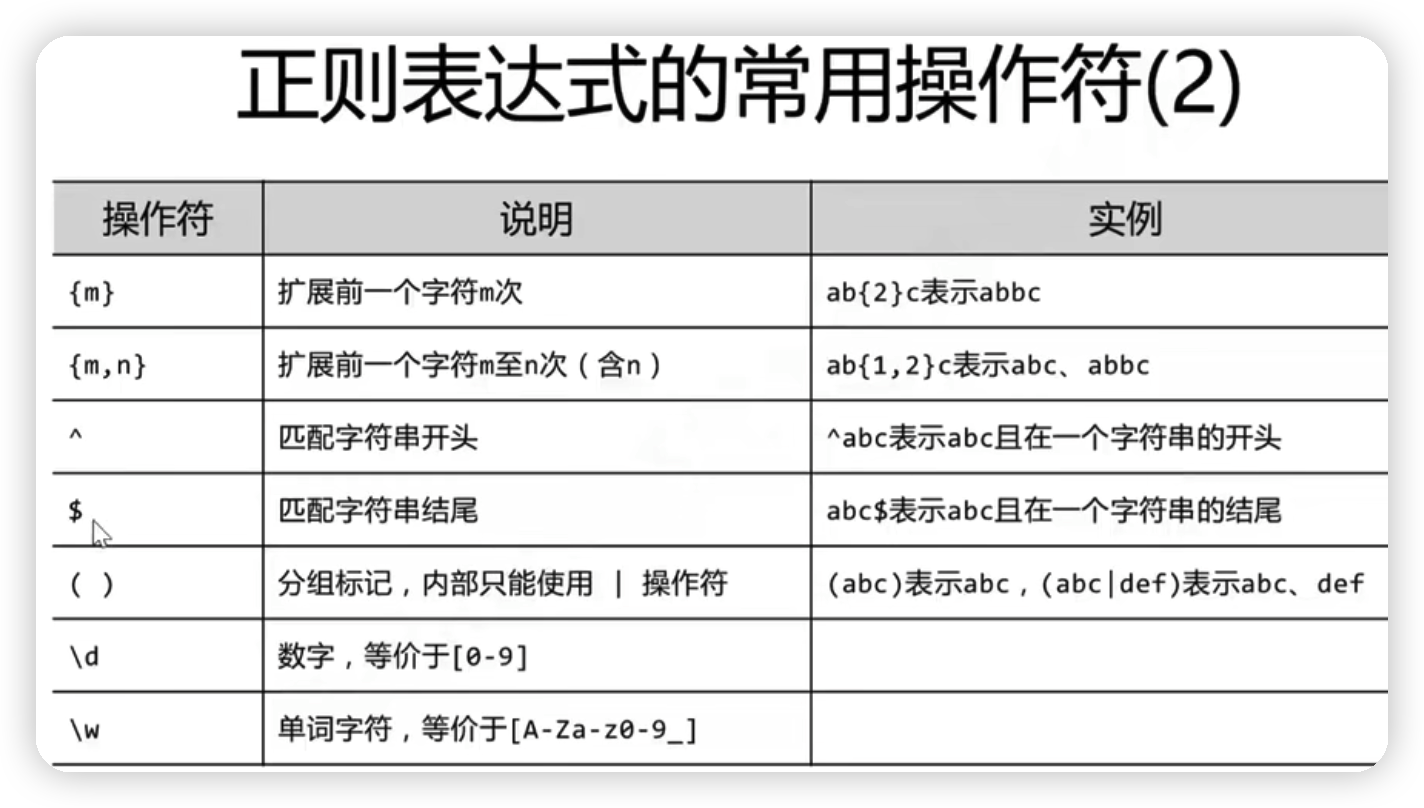

得到的內容可能是HTML、json等格式,可以用二面解析庫,正則表達式等進行解析#影片詳情鏈接的規則

findLink = re.compile(r'<a href="(.*?)">')#創建正則表達式,表示規則(字元竄的模式)

#影片圖片

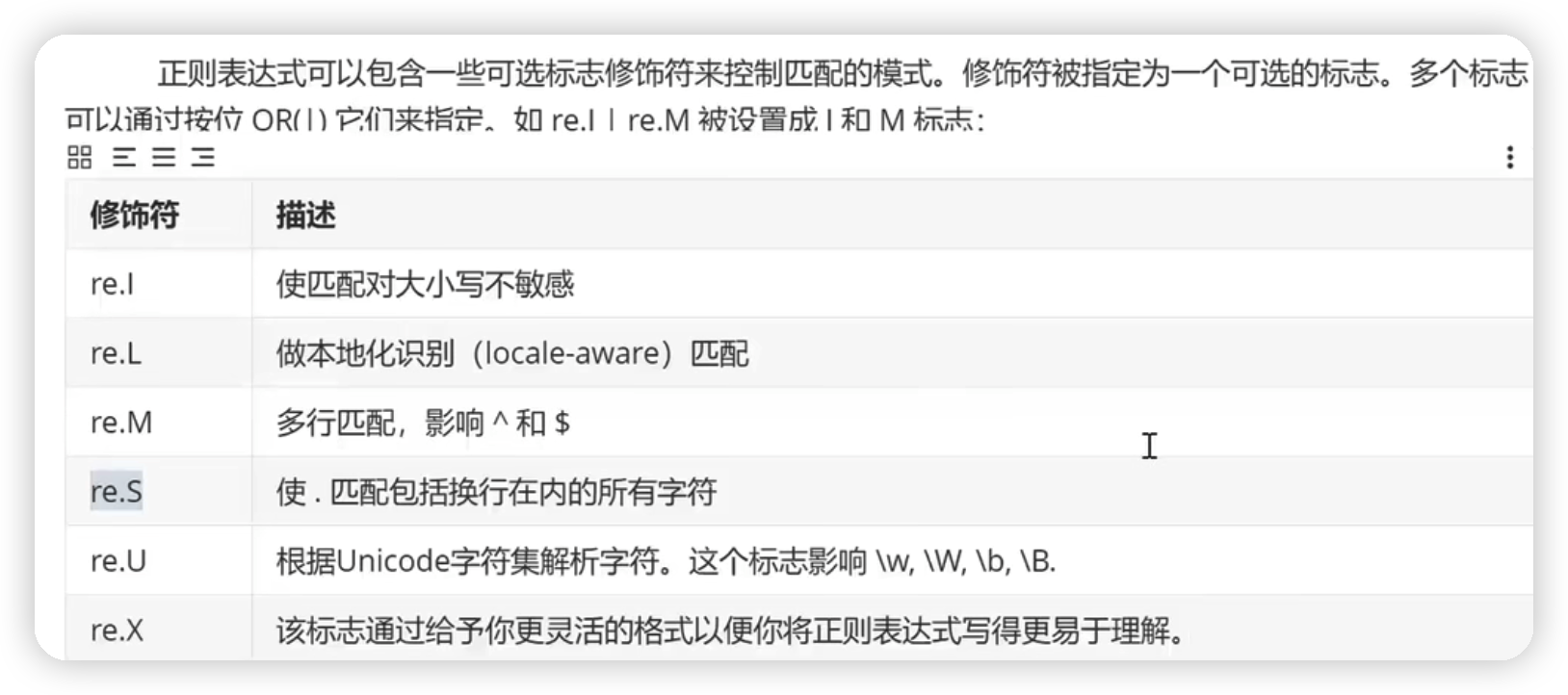

findImgSrc=re.compile(r'<img.*src="(.*?)"',re.S)#re.S讓換行符包含在字元中

#影片片名

findTitle=re.compile(r'<span class="title">(.*)</span>')#re.S讓換行符包含在字元中

#影片評分

findRating=re.compile(r'<span class="rating_num" property="v:average">(.*)</span>')#re.S讓換行符包含在字元中

#找到評價人數

findJudge=re.compile(r'<span>(\d*)人評價</span>')

#找到概況

findInq=re.compile(r'<span class="inq">(.*)</span>')

#找到影片的相關內容

findBd=re.compile(r'<p class="">(.*?)</p>',re.S)

#逐一解析數據

soup= BeautifulSoup(html,"html.parser")#使用html的解析器

for item in soup.find_all('div',class_="item"): #查找符合要求的字元串,形成列表

#print(item)

data=[]

item=str(item)

#影片詳情鏈接

link=re.findall(findLink,item)[0]#re庫用來通過正則表達式查找指定的字元串(標簽里的字元串)

data.append(link)

#圖片

imgSrc=re.findall(findImgSrc,item)[0]

data.append(imgSrc)

#影片片名

titles=re.findall(findTitle,item)#片名可能只有一個中文名,沒有外國名

if(len(titles)==2):#若該電影有兩個名字

ctitle=titles[0]#得到第一個中文名

data.append(ctitle)

otitle=titles[1].replace("/","")#去掉無關的符號,在一個電影名稱中,若有多個名字,每個名字之間會使用/分割開了

data.append(otitle)#添加外國名

else:#若只有一個中文名

data.append(titles[0])#將爬取到的第一個名字存入

data.append(' ')#外國名留空

#評分

rating=re.findall(findRating,item)[0]

data.append(rating)

#評價人數

judgeNum=re.findall(findJudge,item)[0]

data.append(judgeNum)#增加評價人數

#概括

inq=re.findall(findInq,item)

if len(inq) !=0:#如果電影有概述

inq=inq[0].replace("。","")#每個電影概述後面有一個句號

data.append(inq)#添加概述

else:

data.append("")#留空

#相關內容

bd=re.findall(findBd,item)[0]

bd=re.sub('<br(\s+)?/>(\s+)?'," ",bd)#去掉<br/>

bd=re.sub('/'," ",bd)#替換/

data.append(bd.strip())#去掉前後的空格

datalist.append(data)#把處理好的一部電影信息放入datalist

2.4、保存數據

保存形式多樣,可以村委文本,也可以保存到數據,或者保存特定格式的文件#保存數據

def saveData(datalist,savepath):

print("save..")

book=xlwt.Workbook(encoding="utf-8",style_compression=0)#創建workbook對象

sheet=book.add_sheet('豆瓣電影Top250',cell_overwrite_ok=True)#創建工作表

col=("電影詳情鏈接","圖片鏈接","影片中文名","影片外國名","評分","評價數","概況","相關信息")

for i in range(0,8):

sheet.write(0,i,col[i])#列名

for i in range(0,250):

print("第%d條"%(i+1))

data=datalist[i]

for j in range(0,8):

sheet.write(i+1,j,data[j])#數據

book.save(savepath)#保存

最後完整代碼

from bs4 import BeautifulSoup#網頁解析

import re #正則表達式,進行文字匹配

import urllib.request,urllib.error #指定URL,獲取網頁數據

import xlwt #進行Excel操作

import sqlite3 # 進行SQLite資料庫操作

#若你的Python升級到2.7.9以後,就會引入一個新特性,

#引入了一個新特性,當使用urllib打開https的鏈接時,會檢驗一次ssl證書

import ssl

#全局取消證書驗證(當項目對安全性問題不太重視時,推薦使用,可以全局取消證書的驗證,簡易方便)

ssl._create_default_https_context = ssl._create_unverified_context

def main():

baseurl="https://movie.douban.com/top250?start="

#1.爬取網頁

datalist=getData(baseurl)

savepath="豆瓣電影Top250.xls"

#3.保存數據

saveData(datalist,savepath)

#askURL("https://movie.douban.com/top250")

#影片詳情鏈接的規則

findLink = re.compile(r'<a href="(.*?)">')#創建正則表達式,表示規則(字元竄的模式)

#影片圖片

findImgSrc=re.compile(r'<img.*src="(.*?)"',re.S)#re.S讓換行符包含在字元中

#影片片名

findTitle=re.compile(r'<span class="title">(.*)</span>')#re.S讓換行符包含在字元中

#影片評分

findRating=re.compile(r'<span class="rating_num" property="v:average">(.*)</span>')#re.S讓換行符包含在字元中

#找到評價人數

findJudge=re.compile(r'<span>(\d*)人評價</span>')

#找到概況

findInq=re.compile(r'<span class="inq">(.*)</span>')

#找到影片的相關內容

findBd=re.compile(r'<p class="">(.*?)</p>',re.S)

#爬取網頁

def getData(baseurl):

datalist=[]

for i in range(0,10):#調用獲取頁面信息的函數,10次

url=baseurl+str(i*25)#baseurl就是參數start後面的值,其實就是個0

html=askURL(url)#保存獲取到的網頁源碼

#逐一解析數據

soup= BeautifulSoup(html,"html.parser")#使用html的解析器

for item in soup.find_all('div',class_="item"): #查找符合要求的字元串,形成列表

#print(item)

data=[]

item=str(item)

#影片詳情鏈接

link=re.findall(findLink,item)[0]#re庫用來通過正則表達式查找指定的字元串(標簽里的字元串)

data.append(link)

#圖片

imgSrc=re.findall(findImgSrc,item)[0]

data.append(imgSrc)

#影片片名

titles=re.findall(findTitle,item)#片名可能只有一個中文名,沒有外國名

if(len(titles)==2):#若該電影有兩個名字

ctitle=titles[0]#得到第一個中文名

data.append(ctitle)

otitle=titles[1].replace("/","")#去掉無關的符號,在一個電影名稱中,若有多個名字,每個名字之間會使用/分割開了

data.append(otitle)#添加外國名

else:#若只有一個中文名

data.append(titles[0])#將爬取到的第一個名字存入

data.append(' ')#外國名留空

#評分

rating=re.findall(findRating,item)[0]

data.append(rating)

#評價人數

judgeNum=re.findall(findJudge,item)[0]

data.append(judgeNum)#增加評價人數

#概括

inq=re.findall(findInq,item)

if len(inq) !=0:#如果電影有概述

inq=inq[0].replace("。","")#每個電影概述後面有一個句號

data.append(inq)#添加概述

else:

data.append("")#留空

#相關內容

bd=re.findall(findBd,item)[0]

bd=re.sub('<br(\s+)?/>(\s+)?'," ",bd)#去掉<br/>

bd=re.sub('/'," ",bd)#替換/

data.append(bd.strip())#去掉前後的空格

datalist.append(data)#把處理好的一部電影信息放入datalist

#print(datalist)

return datalist

#得到指定一個URL的網頁內容

def askURL(url):

#用戶代理表示告訴豆瓣服務我們是什麼類型的機器,瀏覽器(本質上是告訴瀏覽器,我們可以接受什麼水平的文件內容)

head={ #模擬瀏覽器頭部信息,向豆瓣伺服器發送消息

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/92.0.4515.159 Safari/537.36" }

request=urllib.request.Request(url,headers=head)#偽裝成是瀏覽器去發出請求,防止被看出是爬蟲

html=""

try:

#將爬取網頁的源碼存放在response中(獲取一個get請求)

response = urllib.request.urlopen(request)

html=response.read().decode("utf-8")#將response中讀取到的源代碼進行解碼

#print(html)

except urllib.error.URLError as e:#訪問可能出現404,或者其它錯誤

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

return html

#保存數據

def saveData(datalist,savepath):

print("save..")

book=xlwt.Workbook(encoding="utf-8",style_compression=0)#創建workbook對象

sheet=book.add_sheet('豆瓣電影Top250',cell_overwrite_ok=True)#創建工作表

col=("電影詳情鏈接","圖片鏈接","影片中文名","影片外國名","評分","評價數","概況","相關信息")

for i in range(0,8):

sheet.write(0,i,col[i])#列名

for i in range(0,250):

print("第%d條"%(i+1))

data=datalist[i]

for j in range(0,8):

sheet.write(i+1,j,data[j])#數據

book.save(savepath)#保存

if __name__=="__main__": #當程式執行時

main()

運行結果