告警 正在開會,突然釘釘告警聲響個不停,同時市場人員反饋客戶在投訴系統登不進了,報504錯誤。查看釘釘上的告警信息,幾台業務伺服器節點全部報CPU超過告警閾值,達100%。 趕緊從會上下來,SSH登錄伺服器,使用 top 命令查看,幾個Java進程CPU占用達到180%,190%,這幾個Java進程 ...

告警

正在開會,突然釘釘告警聲響個不停,同時市場人員反饋客戶在投訴系統登不進了,報504錯誤。查看釘釘上的告警信息,幾台業務伺服器節點全部報CPU超過告警閾值,達100%。

趕緊從會上下來,SSH登錄伺服器,使用 top 命令查看,幾個Java進程CPU占用達到180%,190%,這幾個Java進程對應同一個業務服務的幾個Pod(或容器)。

定位

- 使用 docker stats 命令查看本節點容器資源使用情況,對占用CPU很高的容器使用 docker exec -it <容器ID>bash 進入。

- 在容器內部執行 top 命令查看,定位到占用CPU高的進程ID,使用 top -Hp <進程ID> 定位到占用CPU高的線程ID。

- 使用 jstack <進程ID> > jstack.txt 將進程的線程棧列印輸出。

- 退出容器, 使用 docker cp <容器ID>:/usr/local/tomcat/jstack.txt ./ 命令將jstack文件複製到宿主機,便於查看。獲取到jstack信息後,趕緊重啟服務讓服務恢復可用。

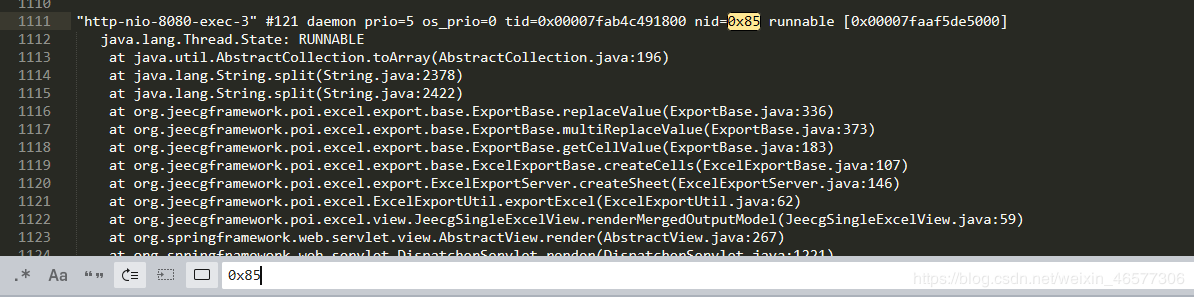

5.將2中占用CPU高的線程ID使用 pringf '%x\n' <線程ID> 命令將線程ID轉換為十六進位形式。假設線程ID為133,則得到十六進位85。在jstack.txt文件中定位到 nid=0x85的位置,該位置即為占用CPU高線程的執行棧信息。如下圖所示,

- 與同事確認,該處為使用一個框架的excel導出功能,並且,導出excel時沒有分頁,沒有限制!!!查看SQL查詢記錄,該導出功能一次導出50w條數據,並且每條數據都需要做轉換計算,更為糟糕的是,操作者因為導出時久久沒有響應,於是連續點擊,幾分鐘內發起了10多次的導出請求。。。於是,CPU被打滿,服務崩潰了,我也崩潰了。。

解決

對於此類耗資源的操作,一定要做好相應的限制。比如可以限制請求量,控制最大分頁大小,同時可以限制訪問頻率,比如同一用戶一分鐘內最多請求多少次。

再發

服務重啟後恢復。到了下午,又一臺伺服器節點CPU告警,依前面步驟定位到占用CPU高的線程,如下

"GC task thread#0 (ParallelGC)" os_prio=0 tid=0x00007fa114020800 nid=0x10 runnable

"GC task thread#1 (ParallelGC)" os_prio=0 tid=0x00007fa114022000 nid=0x11 runnable

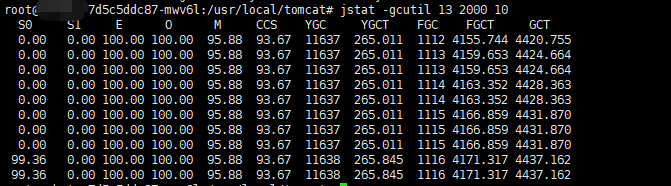

使用命令 jstat -gcutil <進程ID> 2000 10 查看GC情況,如圖

發現Full GC次數達到1000多次,且還在不斷增長,同時Eden區,Old區已經被占滿(也可使用jmap -heap <進程ID>查看堆記憶體各區的占用情況),使用jmap將記憶體使用情況dump出來,

jmap -dump:format=b,file=./jmap.dump 13

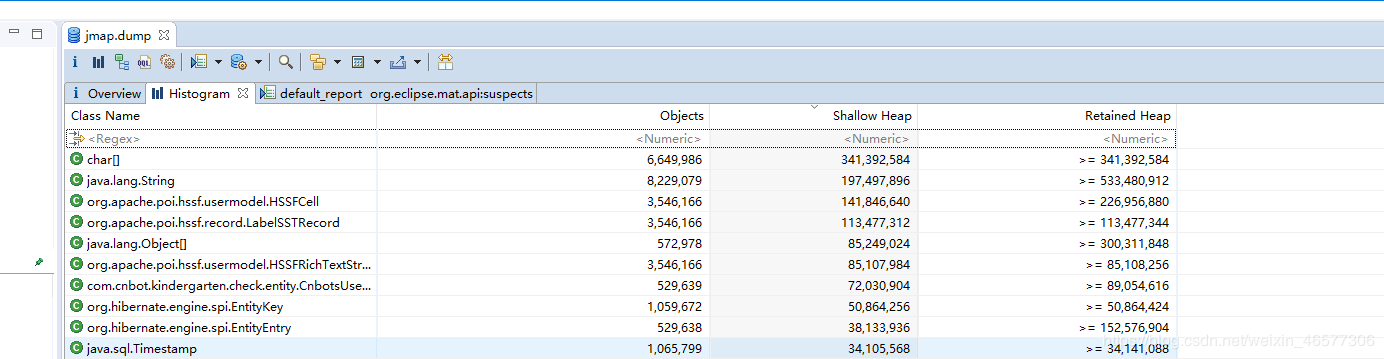

退出容器,使用 docker cp <容器ID>:/usr/local/tomcat/jmap.dump ./ 將dump文件複製到宿主機目錄,下載到本地,使用 MemoryAnalyzer(下載地址:www.eclipse.org/mat/downloa… )打開,如圖

如果dump文件比較大,需要增大MemoryAnalyzer.ini配置文件中的-Xmx值

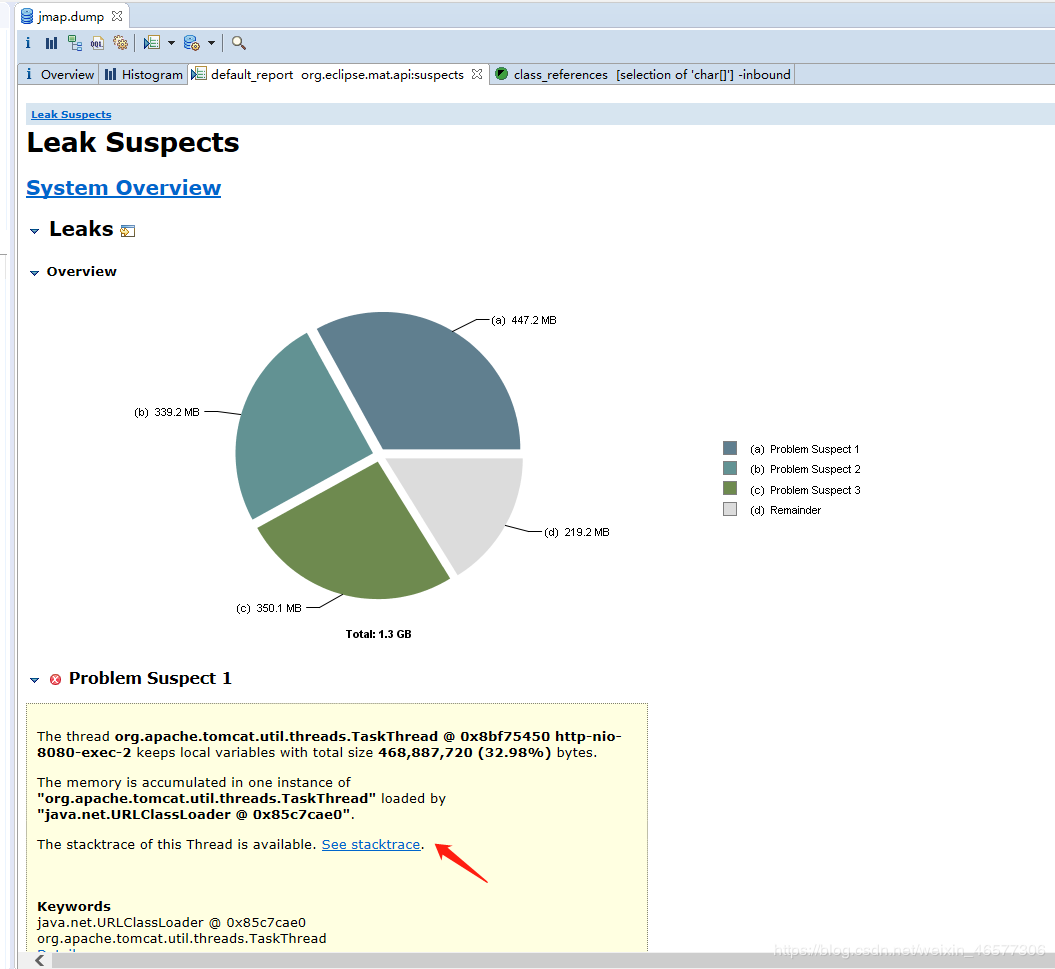

發現占用記憶體最多的是char[], String對象,通過右鍵可以查看引用對象,但點開貌似也看不出所以然來,進入記憶體泄露報告頁面,如圖

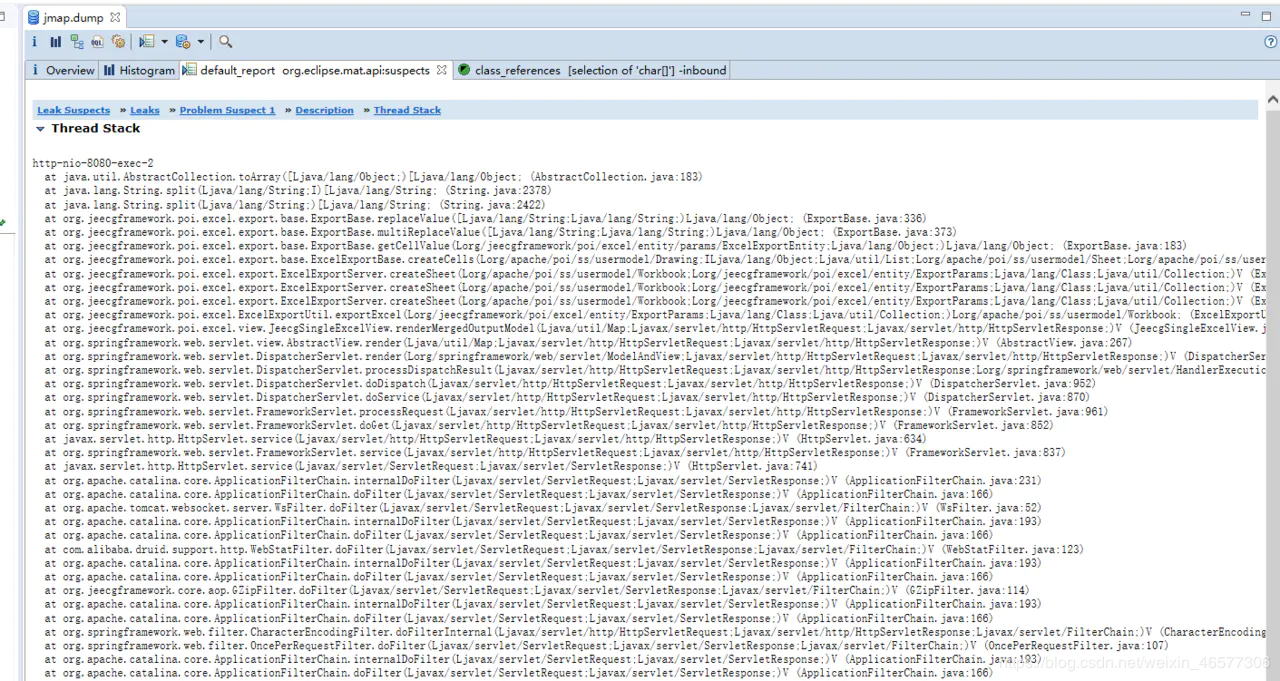

該頁面統計了堆記憶體的占用情況,並且給出疑似泄露點,在上圖中點開“see stacktrace”鏈接,進入線程棧頁面,

似曾熟悉的畫面,還是跟excel導出有關,數據太多,導致記憶體溢出。。。於是GC頻繁,於是CPU爆了。根源還是同一個。

總結

本文以處理一次線上服務CPU 100%的實戰過程示例了在遇到Java服務造成伺服器CPU消耗過高或記憶體溢出的一般處理方法,希望對大家定位線上類似問題提供參考。同時,開發實現功能時需要考慮的更深遠一些,不能停留在解決當前的場景,需要考慮數據量不斷增大時,你的實現是否還能適用。俗話說,初級程式員解決當前問題,中級程式員解決兩年後的問題,高級程式員解決五年後的問題,_。

作者:雨歌