遷移概述 系統的遷移是指把源主機上的 操作系統 和 應用程式 移動到目的主機,並且能夠在目的主機上正常 運行 在沒有虛擬機的時代,物理機之間的遷移依靠的是系統備份和恢復技術。在源主機上實時備份操作系統和應用程式的狀態,然後把存儲介質連接到目標主機上,最後在目標主機上恢復系統。隨著虛擬機技術的發展,系 ...

遷移概述

系統的遷移是指把源主機上的操作系統和應用程式移動到目的主機,並且能夠在目的主機上正常運行

在沒有虛擬機的時代,物理機之間的遷移依靠的是系統備份和恢復技術。在源主機上實時備份操作系統和應用程式的狀態,然後把存儲介質連接到目標主機上,最後在目標主機上恢復系統。隨著虛擬機技術的發展,系統的遷移更加靈活和多樣化。

遷移的目的:

- 簡化系統維護管理

- 提高系統負載均衡

- 增強系統錯誤容忍度

- 優化系統電源管理

熱遷移--Live Migration

熱遷移(又叫動態遷移、實時遷移),即虛擬機保存(save)/恢復(restore):將整個虛擬機的運行狀態完整保存下來,同時可以快速的恢復到原有硬體平臺甚至是不同硬體平臺上。恢復以後,虛擬機仍舊平滑運行,用戶不會察覺到任何差異。

| 遷移的種類 | 解釋 |

|---|---|

| P2P | 物理機之間的遷移 |

| V2P | 虛擬機遷到物理機 |

| P2V | 物理機遷到虛擬機 |

| V2V | 虛擬機遷到虛擬機 |

熱遷移的應用

(1)雙機容錯或者負載均衡

當宿主機出現軟硬體故障導致服務異常時,虛擬機可漂移到另外主機上,或者在集群中依據工作負載量的大小,選擇更換宿主機與否來保證自身良好的服務提供性

(2)系統硬體維護

硬體需要定期維護,使用虛擬機的動態遷移技術,實現了服務不受硬體維護干擾的7*24小時運行

(3)資料庫備份

將資料庫運行在虛擬機中,如需備份就保存虛擬機,如果資料庫崩潰,可以通過恢復虛擬機來恢復整個資料庫

(4)環境重現

進行性能測試或程式調試時,需要重現當時複雜龐大且完全一致的網路環境 ,需要一定的運行時間,將各服務安裝到獨立的各個虛擬機,利用各個獨立虛擬機部署所需的工作環境,可以大大縮短環境重現時間

(5)電腦共用

在一些公共場合共用電腦,由於不同的系統配置和軟體需要大量的時間,使用虛擬機的保存/恢復可以縮短配置和恢復時間;也可以在物理機上運行多個邏輯虛擬機分配給每一個需要者一個獨立、安全、穩定的環境,當因為宿主機出現問題影響虛擬機使用時,我們可以讓該虛擬機漂移到其他宿主機以此來保持正常工作

熱遷移的優勢

1.首先是可伸縮性比較強,IT管理者可以在合理時間段讓運行某些關鍵業務的伺服器適當減少工作量,以便進行更新操作系統,給應用程式打補丁等。而到了服務高峰期,又可以彈性地進行大負載量的運算。虛擬機遷移過程完全透明,幾乎不影響使用。

2.其次,現在的數據中心都追求環保節能,工作量負載大的應用程式必然會令伺服器能耗增加,有了虛擬機熱遷移技術,當一臺物理伺服器負載過大時,系統管理員可以將其上面的虛擬機遷移到其他伺服器,可有效減低數據中心伺服器的總體能耗,再通過冷卻系統將數據中心的溫度保持在正常水平。

熱遷移的局限

進行虛擬機的熱遷移也有不少的限制。例如,VMotion在進行遷移之前,管理軟體會檢測目標伺服器的X86架構是否與原伺服器相容,包括存儲設備以及處理器,虛擬機必須放到共用的存儲里,CPU 的類型也要一樣,不僅不能一個是英特爾, 一個是AMD,甚至相同廠商不同產品線的CPU也不行,比如英特爾至強和奔騰

衡量虛擬機遷移的效率

(1)整體遷移時間

從源主機中遷移操作開始到目的主機上客戶機服務處於不可用狀態的時間,此時源主機上客戶機已經暫停服務,目的主機上的客戶機還未恢復服務。

(2)伺服器停機時間

在遷移過程中,源主機和目的主機上的客戶機都處於不可用狀態的時間,此時源主機上客戶機已暫停,目的目的主機上客戶還未恢復服務。

(3)對服務的性能影響

不僅包括遷移後的客戶機中應用程式的性能與遷移前相對比是否有所降低,還包括遷移後對目的主機上的其他服務的性能影響。

Kvm動態遷移註意事項:

1.源宿主機和目的宿主機直接儘量用網路共用的存儲系統來保存客戶機磁碟鏡像,例如NFS,ISCSI,Glusterfs等。

2.為了提高動態遷移的成功率,儘量在同類型cpu的主機上面進行動態遷移,從安全、穩定角度考慮不建議跨平臺遷移。

3.64位的客戶機只能運行在64宿主機之間的遷移,而32位客戶機可以在32宿主機和64位宿主機

之間遷移。

4.在進行動態遷移時,被遷移客戶機的名稱是唯一的,在目的宿主機上不能有與源宿主機被遷移客戶機同名的客戶機存在。

5.目的宿主機和源宿主機的軟體儘可能的相同,也就是同為Vmware,KVM,Xen等。

熱遷移實例

KVM動態遷移目前有兩種,一種是基於共用存儲的動態遷移,一種是基於數據塊的動態遷移,需要qemu-kvm-0.12.2以上版本支持,OEL6.3版本是qemu-kvm-0.12.1.2,其它發行版可能有支持

虛擬化平臺架構

NFS伺服器配置

[root@python ~]# cat /etc/exports

/nfs-storage 192.168.213.0/24(rw,sync,no_root_squash)

[root@kvm ~]# showmount -e 192.168.213.163

Export list for 192.168.213.163:

/nfs-storage 192.168.213.0/24

宿主主機配置準備

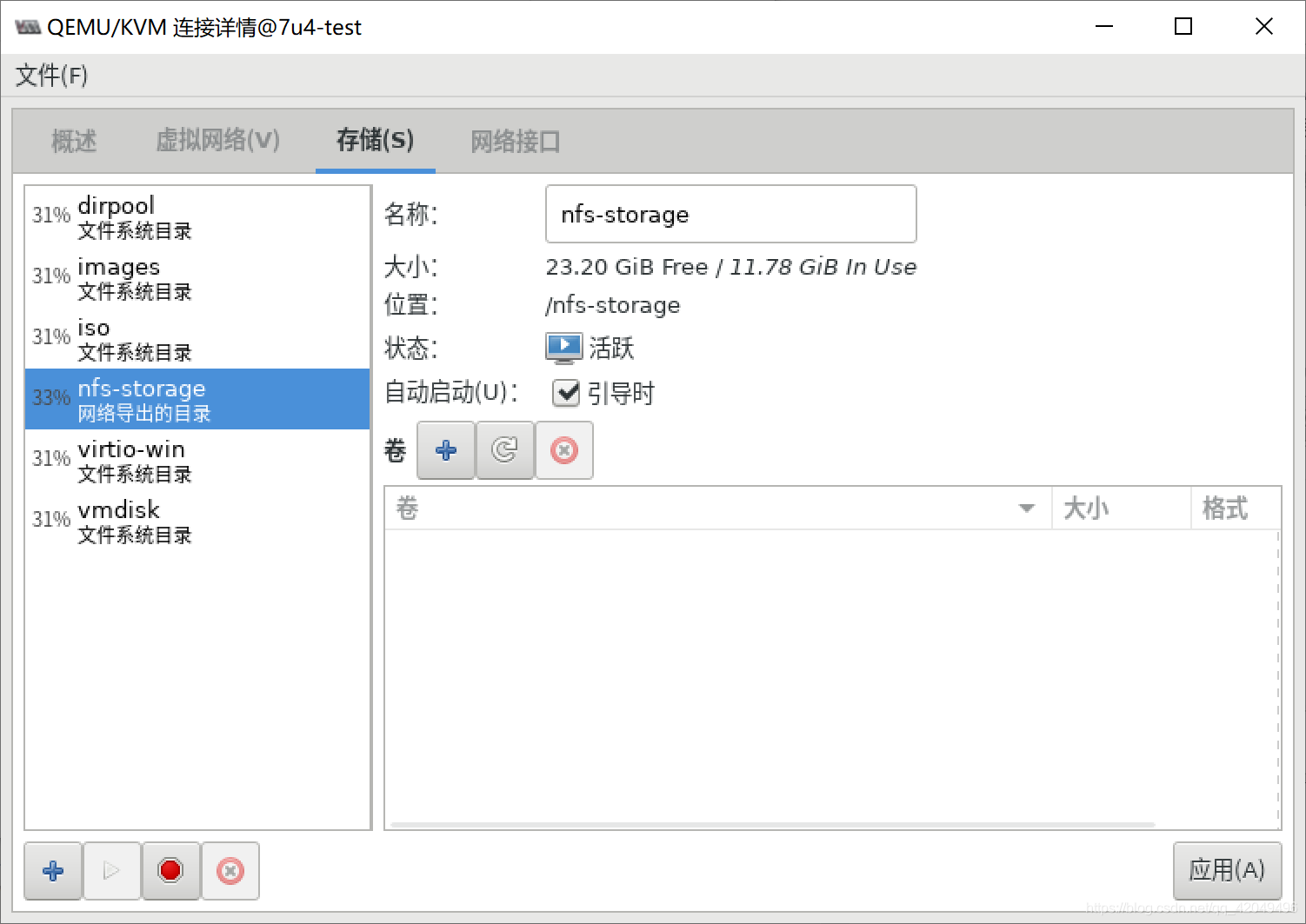

(1)節點1掛載nfs目錄(存儲池)

[root@7u4-test ~]# virsh pool-define-as nfs-storage --source-format nfs --type netfs --source-host 192.168.213.163 --source-path /nfs-storage --target /nfs-storage

[root@7u4-test ~]# virsh pool-start nfs-storage

池 nfs-storage 已啟動

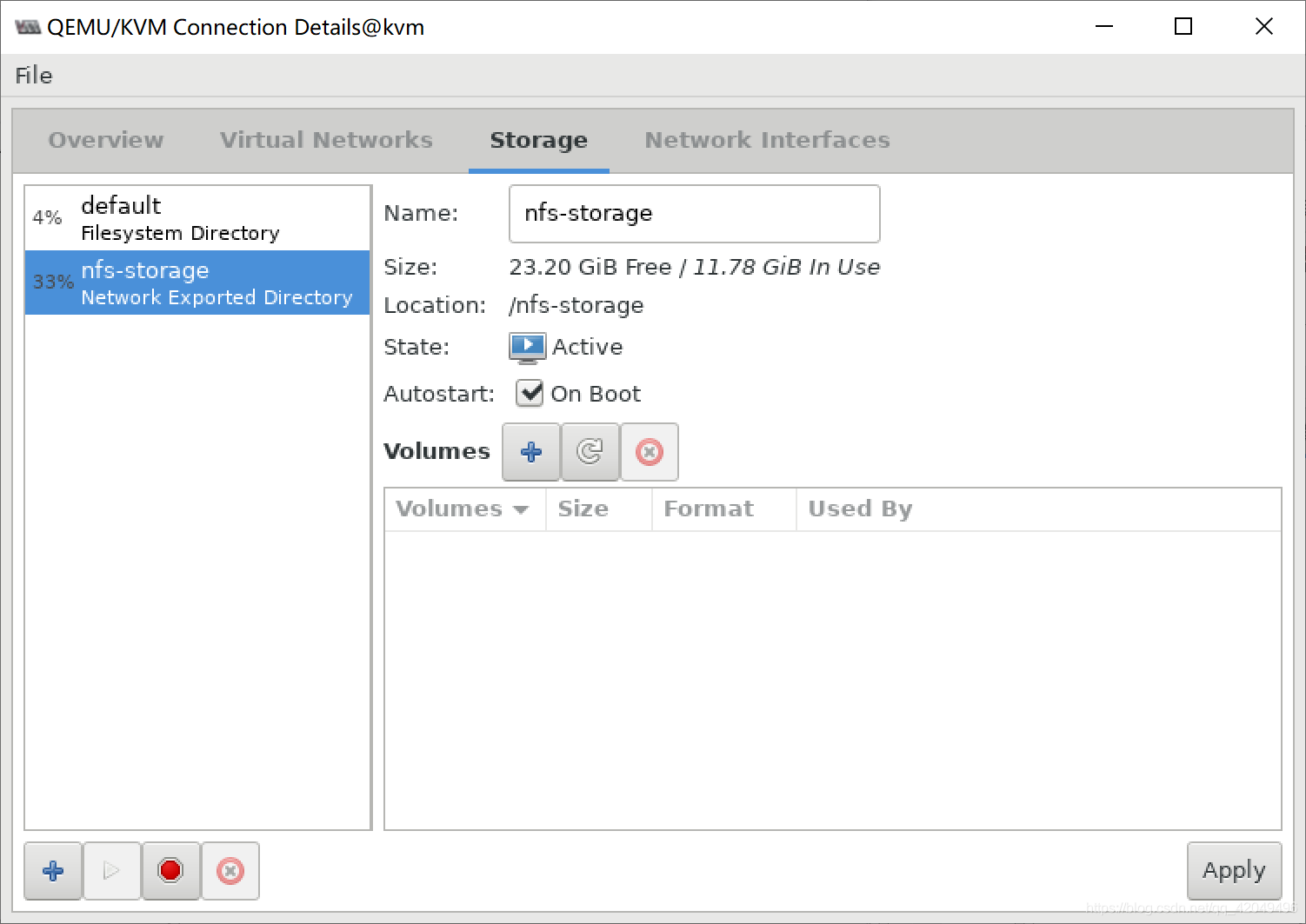

(2)節點2掛載nfs目錄(存儲池)

[root@kvm ~]# virsh pool-define-as nfs-storage --source-format nfs --type netfs --source-host 192.168.213.163 --source-path /nfs-storage --target /nfs-storage

Pool nfs-storage defined

[root@kvm ~]# virsh pool-start nfs-storage

Pool nfs-storage started

確保兩節點都有相同的虛擬機磁碟文件存儲目錄

KVM虛擬機配置

(1)上傳鏡像

#centos7u4是製作好的後備鏡像

[root@7u4-test vmdisk]# scp centos7u4.qcow2 192.168.213.163:/nfs-storage

(2)在node1上創建虛擬機

基於後備鏡像創建磁碟文件

[root@7u4-test ~]# qemu-img create -f qcow2 -b /nfs-storage/centos7u4.qcow2 /nfs-storage/node-7u4.img

Formatting '/nfs-storage/node-7u4.img', fmt=qcow2 size=10737418240 backing_file='/nfs-storage/centos7u4.qcow2' encryption=off cluster_size=65536 lazy_refcounts=off

創建虛擬機配置文件

[root@7u4-test ~]# vim /etc/libvirt/qemu/node-7u4.xml

(3)define虛擬機&&啟動虛擬機

[root@7u4-test qemu]# virsh define node-7u4.xml

定義域 node-7u4(從 node-7u4.xml)

[root@7u4-test qemu]# virsh list --all

Id 名稱 狀態

----------------------------------------------------

10 node-7u4 running

- centos7-1 關閉

- centos7u4 關閉

- windows7 關閉

虛擬機遷移

(1)將虛擬機配置文件備份並傳遞到node2

#備份配置文件

[root@7u4-test ~]# virsh dumpxml node-7u4 >node-7u4.xml

#將備份文件上傳到node2上並添加到域

[root@7u4-test ~]# scp node-7u4.xml [email protected]:/root

[root@kvm ~]# virsh define node-7u4.xml

Domain node-7u4 defined from node-7u4.xml

(2)遷移

因為測試我們忽略錯誤和安全隱患,此外需要配置主機名的host解析

[root@7u4-test ~]# cat /etc/hosts

192.168.213.171 7u4-test

192.168.213.128 kvm

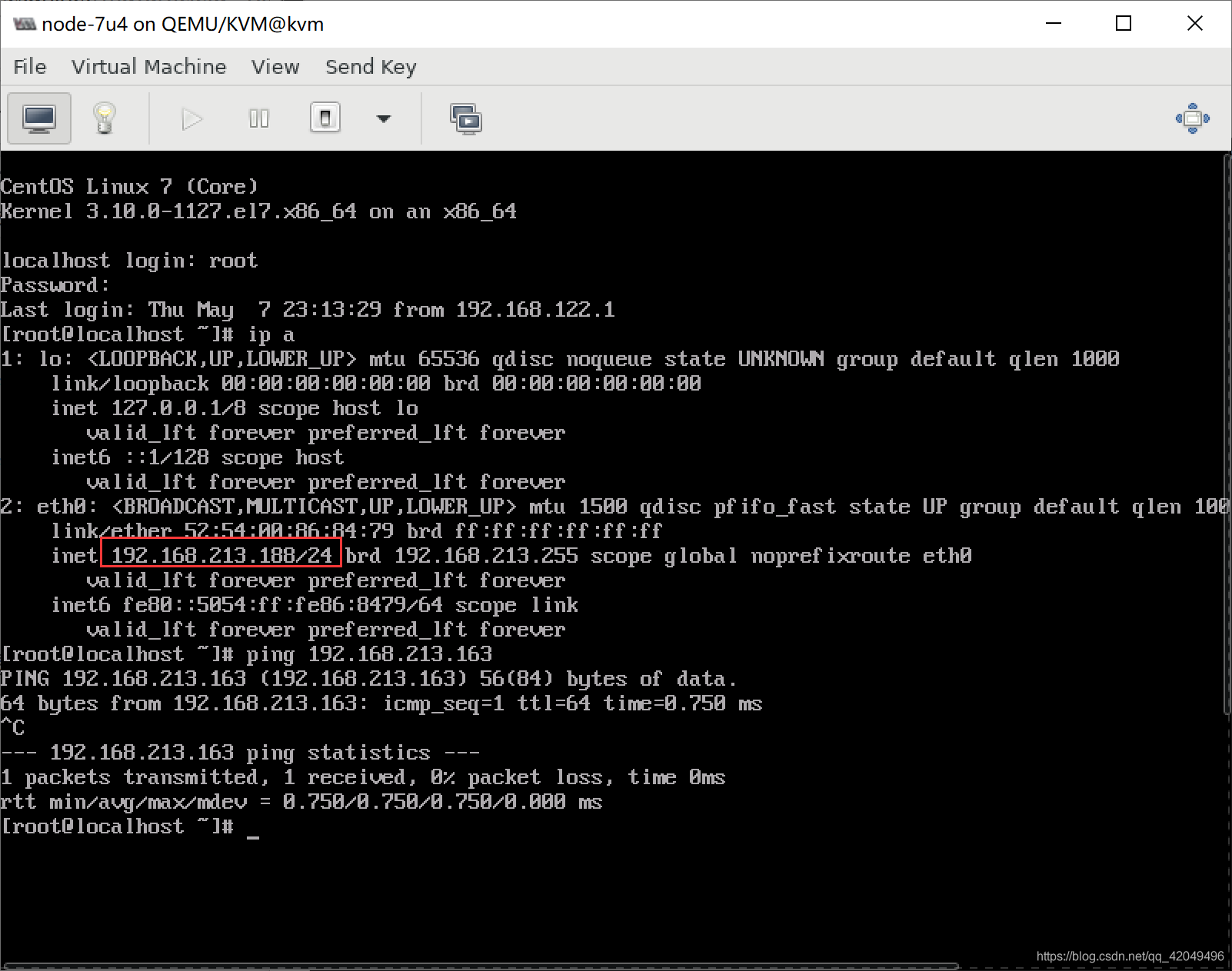

同時給虛擬機配置好網路,並常ping

[ root@bogon nfs-storage ]# ping 192.168.122.100

| PING 192.168. 122.100 (192.168.122.100) 56(84) bytes of data.

54 bytes from 192.168.122.100: icmp seq=1 ttL=64 time=1.32 ms

在node1上虛擬機運行狀態

[root@7u4-test ~]# virsh list --all

Id 名稱 狀態

----------------------------------------------------

10 node-7u4 running

在node2上虛擬機是停運狀態

[root@kvm ~]# virsh list --all

Id Name State

----------------------------------------------------

- node-7u4 shut off

配置免密互信,執行遷移命令

[root@7u4-test ~]# virsh migrate --live --verbose --abort-on-error --unsafe node-7u4 qemu+ssh://192.168.213.128/system

[email protected]'s password:

遷移: [100 %]

遷移完成後

[root@7u4-test ~]# virsh list --all

Id 名稱 狀態

----------------------------------------------------

- centos7-1 關閉

[root@kvm ~]# virsh list --all

Id Name State

----------------------------------------------------

1 node-7u4 running

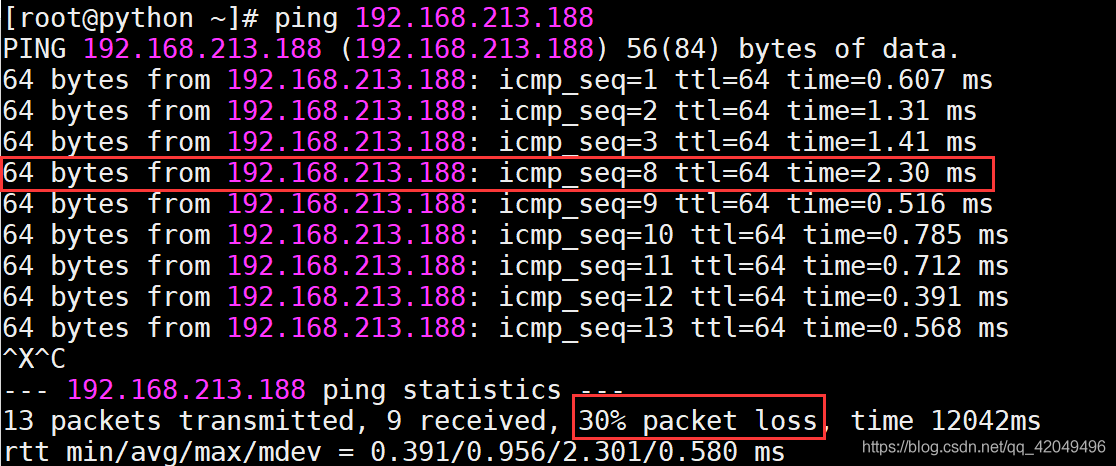

在ping的節點上查看,業務幾乎沒有中斷(丟包可忽略,沒有影響ping測試)

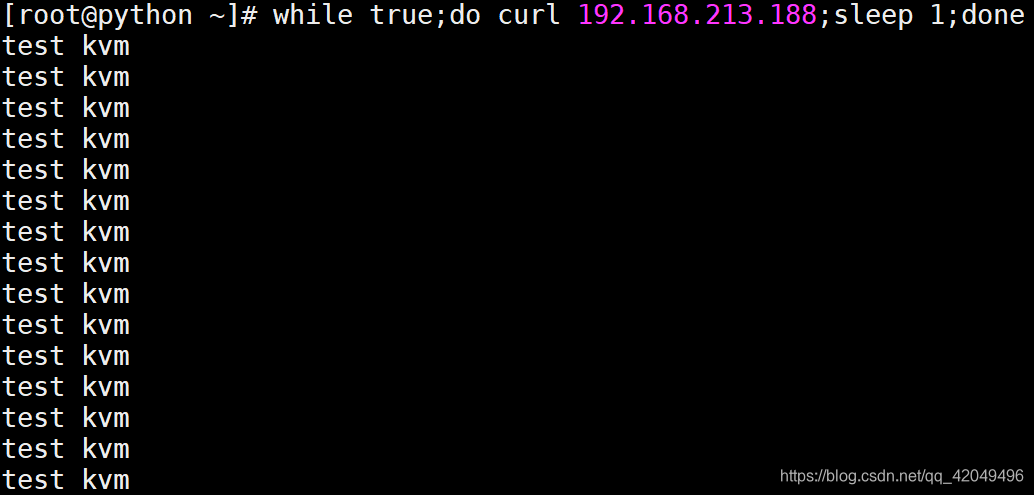

[root@python ~]# while true;do curl 192.168.213.188;sleep 1;done

問題與解決

1.在進行熱遷移時,出現錯誤:Unable to find security driver for model selinux

原因: 兩個節點selinux狀態不同,一個是selinux disabled,另一個是selinux permission

2.啟動NFS中的虛擬機失敗:Could not open '/nfs-storage/node-7u4.img': Permission denied

[root@7u4-test qemu]# virsh start node-7u4

錯誤:開始域 node-7u4 失敗

錯誤:內部錯誤:process exited while connecting to monitor: 2020-05-07T13:59:15.032691Z qemu-kvm: -drive file=/nfs-storage/node-7u4.img,format=qcow2,if=none,id=drive-virtio-disk0: could not open disk image /nfs-storage/node-7u4.img: Could not open '/nfs-storage/node-7u4.img': Permission denied

解決方法: 關閉selinux

3.虛擬機與宿主機不在同一網段

在節點上新增NAT網卡,設置為bridge模式,使虛擬機成為網路中具有獨立IP的主機

4.在進行熱遷移時,出現錯誤:error: unable to connect to server at '7u4-test:49152': No route to host

4.在進行熱遷移時,出現錯誤:error: unable to connect to server at '7u4-test:49152': No route to host

原因: 免密登錄沒有成功,重新做免密登錄;也有可能是firewalld導致遷移時免密失敗