昨天大致把思路理清楚了,用one hot的方式把關鍵詞按字拆開編碼,今天嘗試可行性。 目前主流的文本向量化方式主要包括one hot、tf (term frequency)和tf idf (term frequency–inverse document frequency)這三種,越往後準確度應該越 ...

昨天大致把思路理清楚了,用one-hot的方式把關鍵詞按字拆開編碼,今天嘗試可行性。

目前主流的文本向量化方式主要包括one-hot、tf (term-frequency)和tf-idf (term frequency–inverse document frequency)這三種,越往後準確度應該越高。

我的需求比較簡單,只有一百多個相對較短的關鍵詞,所以先用one-hot方式向量化,把整個流程跑通,再回來測試準確度的區別。

分詞的話可以用python的jieba包,因為詞語比較短,所以也先不分詞了,按字拆分。

一百多個詞拆下來一共200多個關鍵字,感覺也還ok。

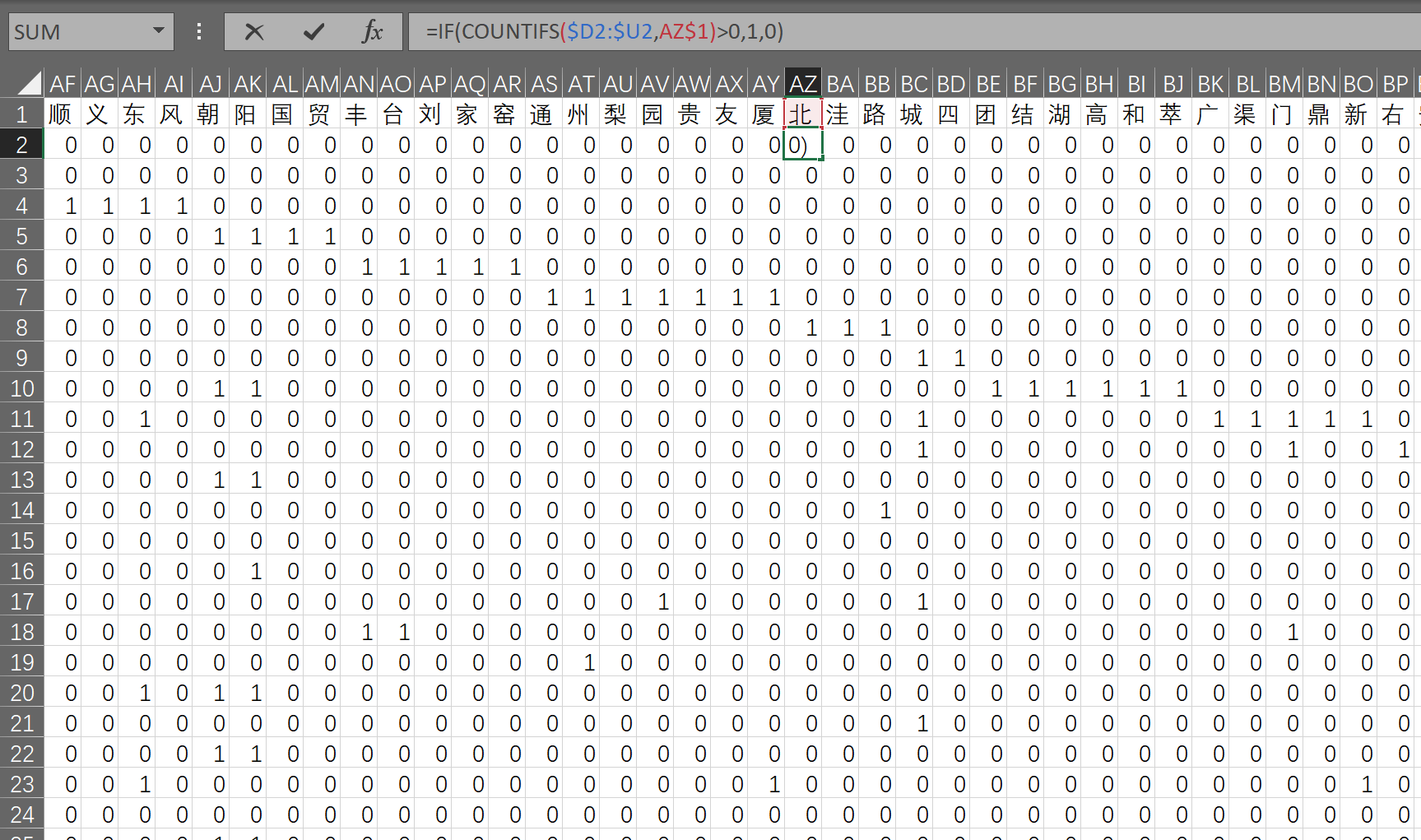

思路的驗證是在Excel中做的,畢竟數據量小,看起來也方便。

流程是:先用vba把詞拆成字(用Excel公式也可以完成);用vba的字典功能把字去重放到首行;然後用countif公式得出one-hot編碼。

後面遇到新詞之後計算新詞的編碼,對比兩個向量就可以計算相似度了。

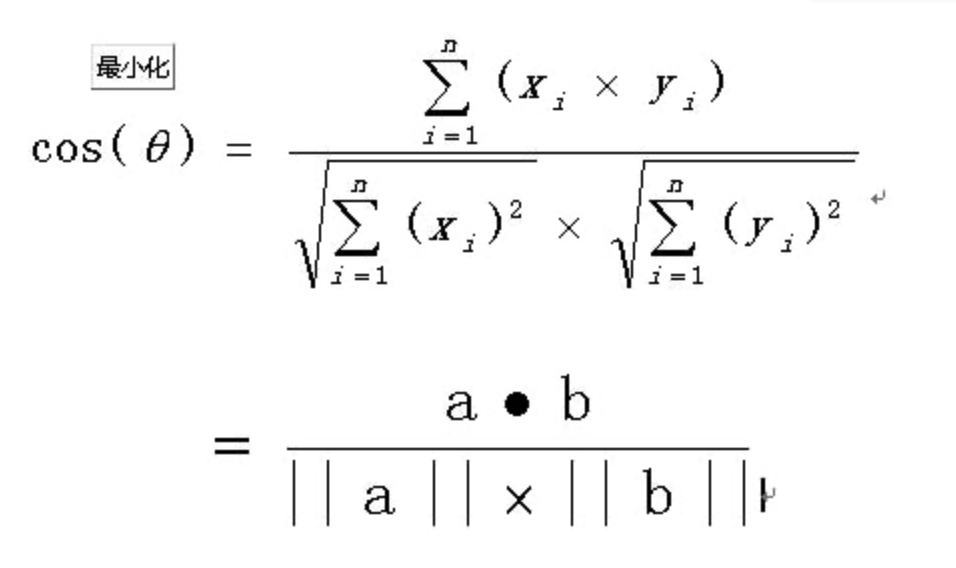

向量的相似度用 餘弦相似度 方法,不贅述,具體解釋可以百度,公式如下。

找了一段用numpy計算餘弦相似度的代碼,進行測試。

import numpy as np

def cos_sim(vector_a, vector_b):

"""

計算兩個向量之間的餘弦相似度

:param vector_a: 向量 a

:param vector_b: 向量 b

:return: sim

"""

vector_a = np.mat(vector_a)

vector_b = np.mat(vector_b)

num = float(vector_a * vector_b.T)

denom = np.linalg.norm(vector_a) * np.linalg.norm(vector_b)

sim = num / denom

return sim

print( cos_sim(np.array([[1, 1, 1,1,1,1,1,1]]),np.array([[1, 2, 1,1,1,1,1,1]])) )

成功計算出這兩個測試向量的相似度

目前整個計算流程基本算是跑通了,接下來就是用C#實現以上功能。