本文介紹使用ELK(elasticsearch、logstash、kibana) + kafka來搭建一個日誌系統。主要演示使用spring aop進行日誌收集,然後通過kafka將日誌發送給logstash,logstash再將日誌寫入elasticsearch,這樣elasticsearch就有... ...

概述

本文介紹使用ELK(elasticsearch、logstash、kibana) + kafka來搭建一個日誌系統。主要演示使用spring aop進行日誌收集,然後通過kafka將日誌發送給logstash,logstash再將日誌寫入elasticsearch,這樣elasticsearch就有了日誌數據了,最後,則使用kibana將存放在elasticsearch中的日誌數據顯示出來,並且可以做實時的數據圖表分析等等。詳細

代碼下載:http://www.demodashi.com/demo/10181.html

本文介紹使用ELK(elasticsearch、logstash、kibana) + kafka來搭建一個日誌系統。主要演示使用spring aop進行日誌收集,然後通過kafka將日誌發送給logstash,logstash再將日誌寫入elasticsearch,這樣elasticsearch就有了日誌數據了,最後,則使用kibana將存放在elasticsearch中的日誌數據顯示出來,並且可以做實時的數據圖表分析等等。

為什麼用ELK

以前不用ELK的做法

最開始我些項目的時候,都習慣用log4j來把日誌寫到log文件中,後來項目有了高可用的要求,我們就進行了分散式部署web,這樣我們還是用log4j這樣的方式來記錄log的話,那麼就有N台機子的N個log目錄,這個時候查找log起來非常麻煩,不知道問題用戶出錯log是寫在哪一臺伺服器上的,後來,想到一個辦法,乾脆把log直接寫到資料庫中去,這樣做,雖然解決了查找異常信息便利性的問題了,但存在兩個缺陷:

1,log記錄好多,表不夠用啊,又得分庫分表了,

2,連接db,如果是資料庫異常,那邊log就丟失了,那麼為瞭解決log丟失的問題,那麼還得先將log寫在本地,然後等db連通了後,再將log同步到db,這樣的處理辦法,感覺是越搞越複雜。

現在ELK的做法

好在現在有了ELK這樣的方案,可以解決以上存在的煩惱,首先是,使用elasticsearch來存儲日誌信息,對一般系統來說可以理解為可以存儲無限條數據,因為elasticsearch有良好的擴展性,然後是有一個logstash,可以把理解為數據介面,為elasticsearch對接外面過來的log數據,它對接的渠道,有kafka,有log文件,有redis等等,足夠相容N多log形式,最後還有一個部分就是kibana,它主要用來做數據展現,log那麼多數據都存放在elasticsearch中,我們得看看log是什麼樣子的吧,這個kibana就是為了讓我們看log數據的,但還有一個更重要的功能是,可以編輯N種圖表形式,什麼柱狀圖,折線圖等等,來對log數據進行直觀的展現。

ELK職能分工

-

logstash做日誌對接,接受應用系統的log,然後將其寫入到elasticsearch中,logstash可以支持N種log渠道,kafka渠道寫進來的、和log目錄對接的方式、也可以對reids中的log數據進行監控讀取,等等。

-

elasticsearch存儲日誌數據,方便的擴展特效,可以存儲足夠多的日誌數據。

-

kibana則是對存放在elasticsearch中的log數據進行:數據展現、報表展現,並且是實時的。

怎樣用ELK

首先說明一點,使用ELK是不需要開發的,只需要搭建環境使用即可。搭建環境,可以理解為,下載XX軟體,然後配置下XX埠啊,XX地址啊,XX日誌轉發規則啊等等,當配置完畢後,然後點擊XX bat文件,然後啟動。

Logstash配置

可以配置接入N多種log渠道,現狀我配置的只是接入kafka渠道。

配置文件在\logstash-2.3.4\config目錄下

要配置的是如下兩個參數體:

-

input:數據來源。

-

output:數據存儲到哪裡。

input {

kafka {

zk_connect => "127.0.0.1:2181"

topic_id => "mylog_topic"

}

}

filter {

#Only matched data are send to output.

}

output {

#stdout{}

# For detail config for elasticsearch as output,

# See: https://www.elastic.co/guide/en/logstash/current/plugins-outputs-elasticsearch.html

elasticsearch {

action => "index" #The operation on ES

hosts => "127.0.0.1:9200" #ElasticSearch host, can be array.

index => "my_logs" #The index to write data to.

}

}

Elasticsearch配置

配置文件在\elasticsearch-2.3.3\config目錄下的elasticsearch.yml,可以配置允許訪問的IP地址,埠等,但我這裡是採取預設配置。

Kibana配置

配置文件在\kibana-4.5.4-windows\config目錄下的kibana.yml,可以配置允許訪問的IP地址,埠等,但我這裡是採取預設配置。

這裡有一個需要註意的配置,就是指定訪問elasticsearch的地址。我這裡是同一臺機子做測試,所以也是採取預設值了。

# The Elasticsearch instance to use for all your queries. # elasticsearch.url: "http://localhost:9200"

關於ELK的配置大致上,就這樣就可以了,當然其實還有N多配置項可供配置的,具體可以google。這裡就不展開說了。

具體的配置請下載運行環境,裡面有具體的配置。

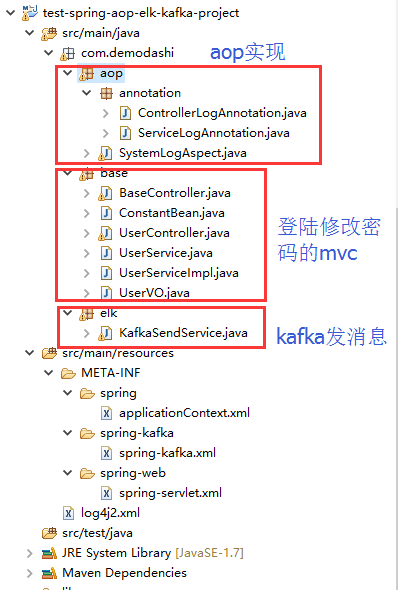

和spring aop日誌對接

elk環境搭建完畢後,需要在應用系統做日誌的aop實現。

部分spring配置

<aop:aspectj-autoproxy /> <aop:aspectj-autoproxy proxy-target-class="true" /> <!-- 掃描web包,應用Spring的註解 --> <context:component-scan base-package="com.demodashi"> <context:include-filter type="annotation" expression="org.springframework.stereotype.Controller" /> <context:exclude-filter type="annotation" expression="javax.inject.Named" /> <context:exclude-filter type="annotation" expression="javax.inject.Inject" /> </context:component-scan>

部分java代碼

package com.demodashi.aop.annotation;

import java.lang.annotation.*;

/**

*自定義註解 攔截service

*/

@Target({ElementType.PARAMETER, ElementType.METHOD})

@Retention(RetentionPolicy.RUNTIME)

@Documented

public @interface ServiceLogAnnotation {

String description() default "";

}

package com.demodashi.aop.annotation;

import java.lang.annotation.*;

/**

*自定義註解 攔截Controller

*/

@Target({ElementType.PARAMETER, ElementType.METHOD})

@Retention(RetentionPolicy.RUNTIME)

@Documented

public @interface ControllerLogAnnotation {

String description() default "";

}

代碼截圖

日誌和kafka、和logstash、elasticsearch、kibana直接的關係

ELK,kafka、aop之間的關係

1、aop對日誌進行收集,然後通過kafka發送出去,發送的時候,指定了topic(在spring配置文件中配置為 topic="mylog_topic")

2、logstash指定接手topic為 mylog_topic的kafka消息(在config目錄下的配置文件中,有一個input的配置)

3、然後logstash還定義了將接收到的kafka消息,寫入到索引為my_logs的庫中(output中有定義)

4、再在kibana配置中,指定要連接那個elasticsearch(kibana.yml中有配置,預設為本機)

5、最後是訪問kibana,在kibana的控制臺中,設置要訪問elasticsearch中的哪個index。

部署ELK + kafka環境

我本機的環境是jdk8.0,我記得測試的過程中,elasticsearch對jdk有特別的要求,必須是jdk7或者以上。

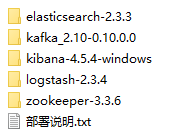

下載運行環境附件,並解壓後,看到如下:

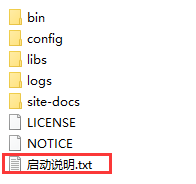

這些運行環境,在每個軟體裡面,都有具體的啟動說明,如kafka的目錄下,這樣:

按照啟動說明的命令來執行,即可啟動。

這裡需要說明一點,最先啟動,應該是zookeeper,然後才是其他的,其他幾個沒有嚴格區分啟動順序。

直接在window下麵,同一臺機子啟動即可。除了kibana-4.5.4-windows外,其他幾個也是可以在linux下運行的。

運行效果

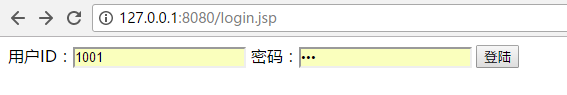

項目導入到eclipse後,啟動,然後訪問如下地址:

用戶名為 1001 密碼為 123

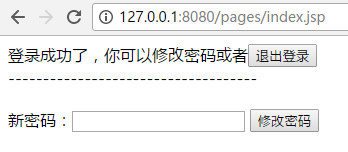

登陸後能看到如下:

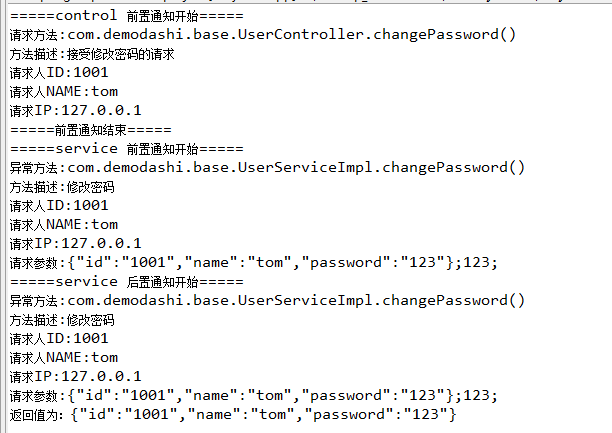

本例子是對修改密碼做了日誌攔截。所以修改密碼的動作,能看到列印如下信息:

然後是觀察一下aop日誌攔截,是否被kafka發送給logstash了,是否被寫入了elasticsearch了。

訪問elasticsearch,http://127.0.0.1:9200/_plugin/head/ 如下:

註意觀察我們定義的my_logs這個索引庫是否增加記錄了。

訪問kibana:

http://127.0.0.1:5601/app/kibana

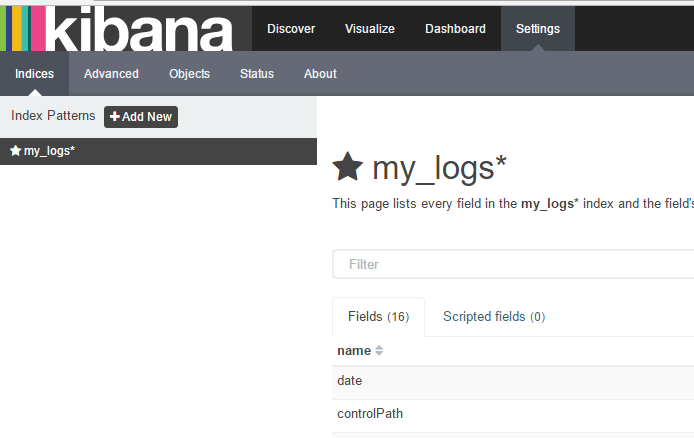

在輸入索引名稱後,再點擊 create按鈕,即可得到如下界面:

然後再點擊Discover,界面如下:

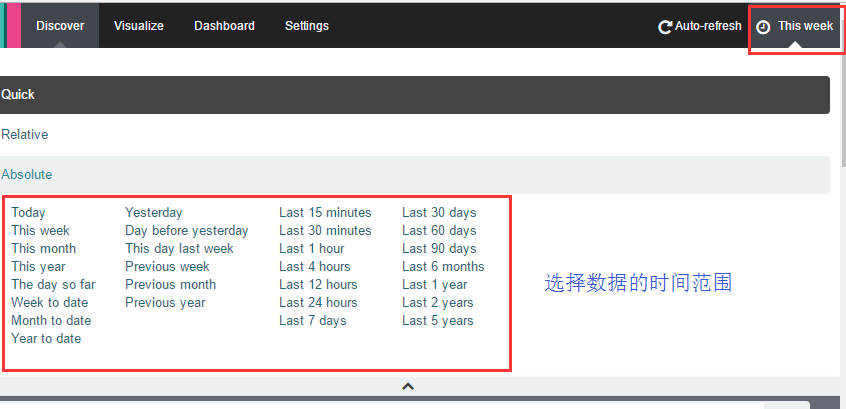

如果你看不到數據,記得點擊右上角的按鈕來選擇數據的時間範圍:

到這裡就完成了,日誌的AOP收集,日誌的流轉,並寫入到elasticsearch,並用kibana看數據。

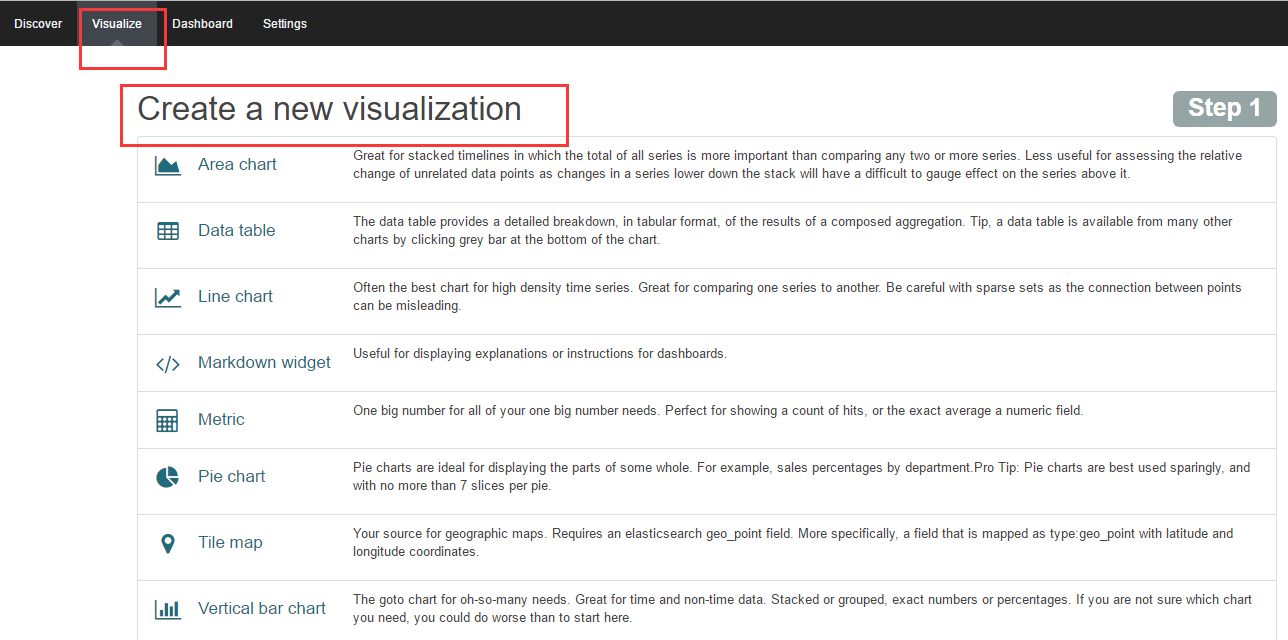

當然kibana還有很重要的一個功能是數據分析圖表的配置,主要是通過嚮導來完成。

高可用實現

現在實現的是一個最基本的日誌收集,日誌傳輸,日誌存儲以及日誌展示的一條鏈路的功能,如果系統上線,還需要做一定的集群,如kafka集群,zookeeper集群,還有elasticsearch集群