大數據技術開篇之Hadoop入門【hdfs】 學習都是從瞭解到熟悉的過程,而學習一項新的技術的時候都是從這個技術是什麼?可以乾什麼?怎麼用?如何優化?這幾點開始。今天這篇文章分為兩個部分。一、hadoop概述 二、hadoop核心技術之一的hdfs的講解。 【hadoop概述】 一、hadoop是什 ...

大數據技術開篇之Hadoop入門【hdfs】

學習都是從瞭解到熟悉的過程,而學習一項新的技術的時候都是從這個技術是什麼?可以乾什麼?怎麼用?如何優化?這幾點開始。今天這篇文章分為兩個部分。一、hadoop概述 二、hadoop核心技術之一的hdfs的講解。

【hadoop概述】

一、hadoop是什麼?

Hadoop是一個由Apache基金會所開發的分散式系統基礎架構。用戶可以在不瞭解分散式底層細節的情況下,開發分散式程式。充分利用集群的威力進行高速運算和存儲。Hadoop實現了一個分散式文件系統(Hadoop Distributed File System),簡稱HDFS。HDFS有高容錯性的特點,並且設計用來部署在低廉的(low-cost)硬體上;而且它提供高吞吐量(high throughput)來訪問應用程式的數據,適合那些有著超大數據集(large data set)的應用程式。HDFS放寬了(relax)POSIX的要求,可以以流的形式訪問(streaming access)文件系統中的數據。Hadoop的框架最核心的設計就是:HDFS和MapReduce。HDFS為海量的數據提供了存儲,而MapReduce則為海量的數據提供了計算。

簡單概況就是hadoop是一個分散式系統的基礎架構,通過分散式來進行高速運算和存儲。

二、用來乾什麼?

主要用來解決海量數據存儲和海量數據運算的問題

三、當前版本

Apach 版本:主要用於自己學習研究方面,免費開源版本

Cloudera:收費版本,企業版本。目前公司商用化最多的版本。

Hortonworks:商業版本,這個版本的優勢在於參考文檔相對詳盡,學習起來比較方便

四、hadoop組成

commons:輔助工具

hdfs:一個分散式高吞吐量,高可靠的分散式文件系統

mapreduce 一個分散式離線計算框架

yarn:作業調度和資源管理的框架。

五、集群模式

單節點模式,偽集群,完整集群。三個模式

HDFS 學習

一、hdfs是什麼?

hdfs一個分散式高吞吐量,高可靠的分散式文件系統。

二、hdfs優缺點:

優點:

【1】高容錯性,數據自動保存多個副本,一個副本丟失後可以自動恢復

【2】適合大數據的處理

數據可以達到gb,Tb,pb級別,文件處理可以達到百萬以上的規模

【3】可以構建在廉價的機器上面,通過多副本來實現可靠性

缺點:

【1】不適合低延時數據訪問,比如毫秒級別做不到

【2】無法高效對大量小文件進行存儲

【3】不支持文件的隨機修改,僅支持文件的追加

三、hdfs的組成:

Client:客戶端

【1】文件切分。文件上傳時將文件切成一個個block塊

【2】與NameNode交互,獲取文件的位置信息

【3】與DataNode交互,讀取或寫入數據

【4】client提供一些命令來管理Hdfs,比如啟動或者關閉

【5】client可以通過命令來訪問Hdfs

NameNode就是Master,它是一個主管、管理者

【1】管理數據塊的原信息

【2】配置副本策略

【3】處理客戶端請求

DateNode

【1】存儲實際的數據塊

【2】執行數據塊的讀寫操作

econdaryNameNode:並非NameNode的熱備。當NameNode掛掉的時候,它並不能馬上替換NameNode並提供服務

【1】輔助NameNode,分擔其工作量

【2】定期合併Fsimage和Edits,並推送給NameNode;

【3】在緊急情況下,可輔助恢復NameNode。

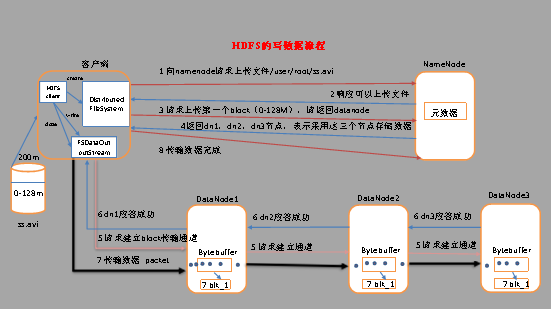

四、hdfs文件寫入流程

(1) 客戶端通過Distributed FileSystem模塊向NameNode請求上傳文件,NameNode檢查目標文件是否已存在,父目錄是否存在。

(2) NameNode返回是否可以上傳。

(3) 客戶端請求第一個 block上傳到哪幾個datanode伺服器上。

(4) NameNode返回3個datanode節點,分別為dn1、dn2、dn3。

(5) 客戶端通過FSDataOutputStream模塊請求dn1上傳數據,dn1收到請求會繼續調用dn2,然後dn2調用dn3,將這個通信管道建立完成。

(6) dn1、dn2、dn3逐級應答客戶端。

(7) 客戶端開始往dn1上傳第一個block(先從磁碟讀取數據放到一個本地記憶體緩存),以packet為單位,dn1收到一個packet就會傳給dn2,dn2傳給dn3;

(8) 當一個block傳輸完成之後,客戶端再次請求NameNode上傳第二個block的伺服器。(重覆執行3-7步)。

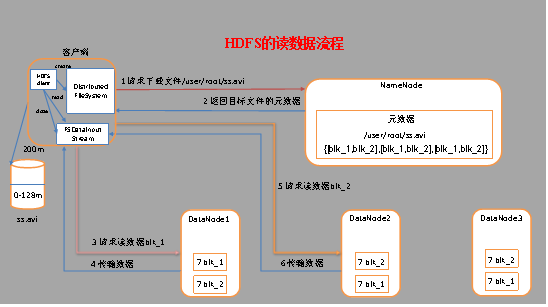

五、hdfs 讀文件流程

(1) 客戶端通過Distributed FileSystem向NameNode請求下載文件,NameNode通過查詢元數據,找到文件塊所在的DataNode地址。

(2) 挑選一臺DataNode(就近原則,然後隨機)伺服器,請求讀取數據。

(3) DataNode開始傳輸數據給客戶端(從磁碟裡面讀取數據輸入流,以packet為單位來做校驗)。

(4) 客戶端以packet為單位接收,先在本地緩存,然後寫入目標文件。

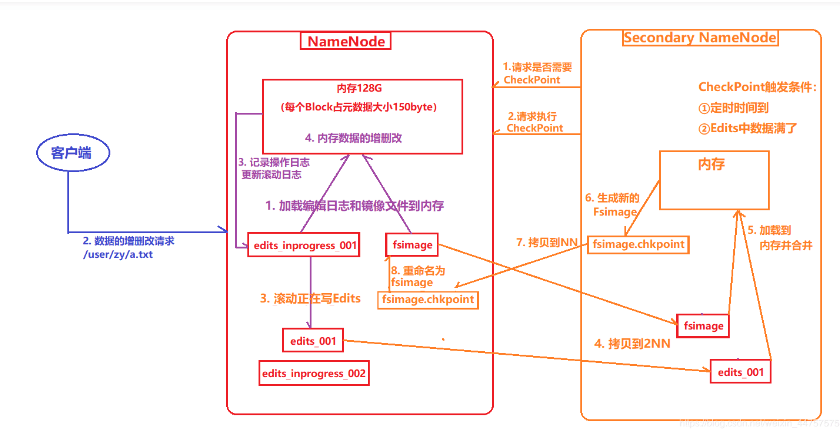

六、NN與2NN的工作機制

(1) 第一階段:NameNode啟動

a) 第一次啟動NameNode格式化後,創建fsimage和edits文件。如果不是第一次啟動,直接載入編輯日誌和鏡像文件到記憶體。

b) 客戶端對元數據進行增刪改的請求。

c) NameNode記錄操作日誌,更新滾動日誌。

d) NameNode在記憶體中對數據進行增刪改查。

(2) 第二階段:Secondary NameNode工作

a) Secondary NameNode詢問NameNode是否需要checkpoint。直接帶回NameNode是否檢查結果。

b) Secondary NameNode請求執行checkpoint。

c) NameNode滾動正在寫的edits日誌。

d) 將滾動前的編輯日誌和鏡像文件拷貝到Secondary NameNode。

e) Secondary NameNode載入編輯日誌和鏡像文件到記憶體,併合並。

f) 生成新的鏡像文件fsimage.chkpoint。

g) 拷貝fsimage.chkpoint到NameNode。

h) NameNode將fsimage.chkpoint重新命名成fsimage。

NN和2NN工作機制詳解:

fsimage:namenode記憶體中元數據序列化後形成的文件。

edits:記錄客戶端更新元數據信息的每一步操作(可通過Edits運算出元數據)。

namenode啟動時,先滾動edits並生成一個空的edits.inprogress,然後載入edits(歸檔後的)和fsimage(最新的)到記憶體中,此時namenode記憶體就持有最新的元數據信息。client開始對namenode發送元數據的增刪改查的請求,這些請求的操作首先會被記錄在edits.inprogress中(查詢元數據的操作不會被記錄在edits中,因為查詢操作不會更改元數據信息),如果此時namenode掛掉,重啟後會從edits中讀取元數據的信息。然後,namenode會在記憶體中執行元數據的增刪改查的操作。

由於edits中記錄的操作會越來越多,edits文件會越來越大,導致namenode在啟動載入edits時會很慢,所以需要對edits和fsimage進行合併(所謂合併,就是將edits和fsimage載入到記憶體中,照著edits中的操作一步步執行,最終形成新的fsimage)。Secondarynamenode:幫助namenode進行edits和fsimage的合併工作。

secondarynamenode首先會詢問namenode是否需要checkpoint(觸發checkpoint需要滿足兩個條件中的任意一個,定時時間到和edits中數據寫滿了)。直接帶回namenode是否檢查結果。secondarynamenode執行checkpoint操作,首先會讓namenode滾動edits並生成一個空的edits.inprogress,滾動edits的目的是給edits打個標記,以後所有新的操作都寫入edits.inprogress,其他未合併的edits和fsimage會拷貝到secondarynamenode的本地,然後將拷貝的edits和fsimage載入到記憶體中進行合併,生成fsimage.chkpoint,然後將fsimage.chkpoint拷貝給namenode,重命名為fsimage後替換掉原來的fsimage。namenode在啟動時就只需要載入之前未合併的edits和fsimage即可,因為合併過的edits中的元數據信息已經被記錄在fsimage中。

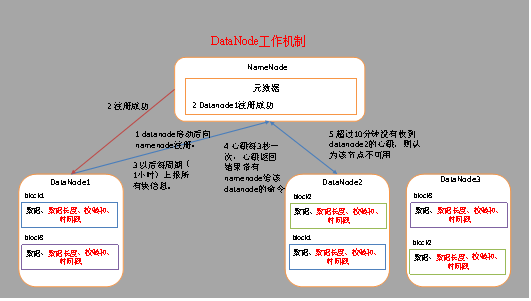

六、DataName工作機制

(1) 一個數據塊在DataNode上以文件形式存儲在磁碟上,包括兩個文件,一個是數據本身,一個是元數據包括數據塊的長度,塊數據的校驗和,以及時間戳。

(2) DataNode啟動後向NameNode註冊,通過後,周期性(1小時)的向NameNode上報所有的塊信息。

(3) 心跳是每3秒一次,心跳返回結果帶有NameNode給該DataNode的命令如複製塊數據到另一臺機器,或刪除某個數據塊。如果超過10分鐘沒有收到某個DataNode的心跳,則認為該節點不可用。

今天的hdfs的分享就到這裡了,下次會分享MapReduce和Yarn的知識。每天進步一點點,大家一起加油。