一些介紹 Hadoop 2和Hadoop 3的埠區別 Hadoop 3 HDFS集群架構 我的集群規劃 | name | ip | role | | | | | | 61 | 192.168.3.61 | namenode,datanode | | 62 | 192.168.3.62 | data ...

一些介紹

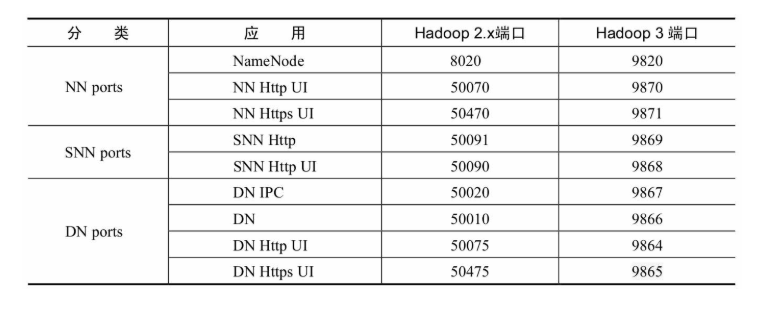

Hadoop 2和Hadoop 3的埠區別

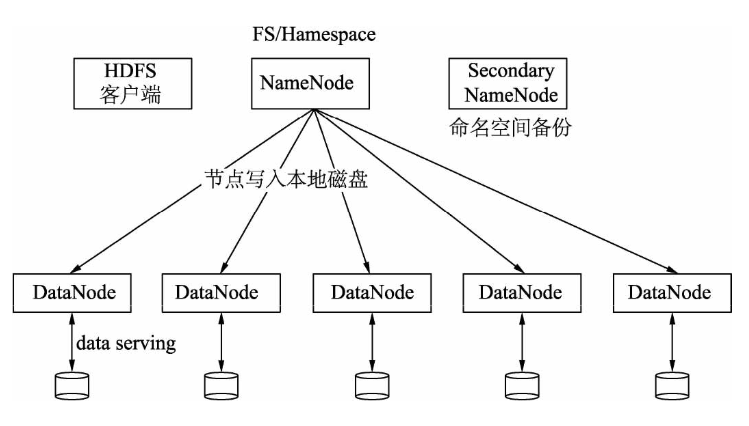

Hadoop 3 HDFS集群架構

我的集群規劃

| name | ip | role |

|---|---|---|

| 61 | 192.168.3.61 | namenode, datanode |

| 62 | 192.168.3.62 | datanode |

| 63 | 192.168.3.63 | secondnamenode |

| 64 | 192.168.3.64 | datanode |

1.安裝JDK

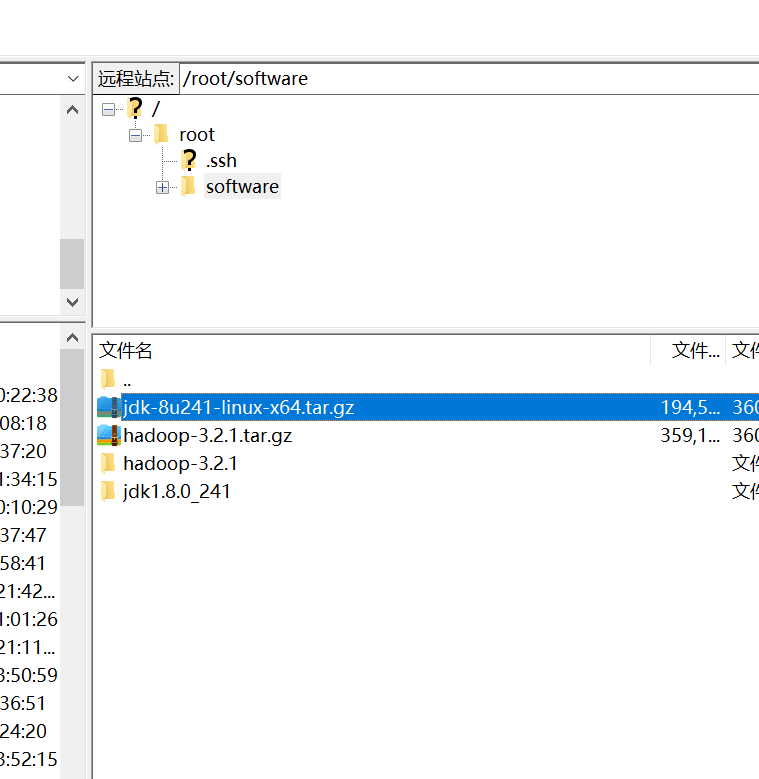

利用FileZilla sftp功能進行上傳到指定文件夾下/root/software,下圖是配置sftp.

解壓使用命令tar -xvzf jdk-8u241-linux-x64.tar.gz 解壓到當前文件夾下。

配置環境變數,輸入命令vim /etc/profile,添加

JAVA_HOME=/root/software/jdk1.8.0_241

PATH=$JAVA_HOME/bin:$PATH最後退出vi,輸入source /etc/profile

測試輸入命令java -version,如果展示

root@localhost ~]# java -version

java version "1.8.0_241"

Java(TM) SE Runtime Environment (build 1.8.0_241-b07)

Java HotSpot(TM) 64-Bit Server VM (build 25.241-b07, mixed mode)

[root@localhost ~]# 安裝成功!

ssh免密配置請查看

2.配置Hadoop

sftp://[email protected]/root/software/hadoop-3.2.1.tar.gz

解壓。

2.1部署及配置

Hadoop的配置涉及以下幾個文件,分別是:hadoop-env.sh、core-site.xml、hdfs-site.xml和workers。其中,hadoop-env.sh是Hadoop運行環境變數配置;core-site.xml是Hadoop公共屬性的配置;hdfs-site.xml是關於HDFS的屬性配置;workers是DataNode分佈配置。下麵我們分別配置這幾個文件。

以61為中心配置,最後複製到其他伺服器

- hadoop-env.sh文件

在/etc/hadoop/hadoop-env.sh中配置運行環境變數,在預設情況下,這個文件是沒有任何配置的。我們需要配置JAVA_HOME、HDFS_NAMENODE_USER和HDFS_DATANODE_USER等,HDFS_SECONDARYNAMENODE_USER配置代碼如下:

在尾部加入

export JAVA_HOME=/root/software/jdk1.8.0_241

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root其中,JAVA_HOME=/root/software/jdk1.8.0_241是指定JDK的位置,HDFS_NAMENODE_USER=root是指定操作NameNode進程的用戶是root。同理,HDFS_DATANODE_USER和HDFS_SECONDARYNAMENODE_USER分別指定了操作DataNode和Secondary NameNode的用戶,在這裡我們設置為root用戶,具體應用時,讀者根據情況進行設置即可。在這裡需要註意的是,HDFS_NAMENODE_USER、HDFS_DATANODE_USER和HDFS_SECONDARYNAMENODE_USER是Hadoop 3.x為了提升安全性而引入的。

- core-site.xml文件

core-site.xml中主要配置Hadoop的公共屬性,配置代碼如下:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.3.61:9820</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoopdata</value>

</property>

</configuration>其中,fs.defaultFS是指定NameNode所在的節點,在這裡配置為node1;9820是預設埠;hdfs:是協議;hadoop.tmp.dir是配置元數據所存放的配置,這裡配置為/opt/hadoopdata,後續如果需要查看fsiamge和edits文件,可以到這個目錄下查找。

- hdfs-site.xml文件

hdfs-site.xml文件中主要是HDFS屬性配置,配置代碼如下:

<configuration>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>192.168.3.63:9868</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.namenode.datanode.registration.ip-hostname-check</name>

<value>false</value>

</property>其中,dfs.namenode.secondary.http-address屬性是配置Secondary NameNode的節點,在這裡配置為node2。埠為9868。

關於這些配置,讀者可以從官網上查找,網址為https://hadoop.apache.org/docs/stable/index.html,其中的左下角有個Configuration項,其中包括core-default.xml等配置文件。

- workers文件

在workers中配DataNode節點,在其中寫入:

192.168.3.61

192.168.3.62

192.168.3.642.2 將配置複製到其他伺服器

進入 /root/software/hadoop-3.2.1/etc 目錄

輸入命令

scp -r ./hadoop 192.168.3.62:/root/software/hadoop-3.2.1/etc/

scp -r ./hadoop 192.168.3.63:/root/software/hadoop-3.2.1/etc/

scp -r ./hadoop 192.168.3.64:/root/software/hadoop-3.2.1/etc/2.3配置下hadoop的環境變數,方便輸入命令

export JAVA_HOME=/root/software/jdk1.8.0_241

export HADOOP_HOME=/root/software/hadoop-3.2.1

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin2.4格式化

第一次安裝Hadoop需要進行格式化,以後就不需要了。格式化命令在hadoop/bin下麵,執行如下命令:

hdfs namenode -formate格式化後會創建一個空白的fsimage文件,可以在opt/hadoopdata/dfs/name/current中找到fsimage文件,註意此時沒有edits文件。

3.啟動

進入hadoop/sbin下麵運行start-dfs.sh,啟動HDFS集群,啟動命令如下:

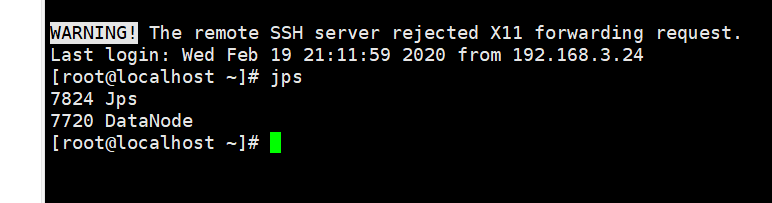

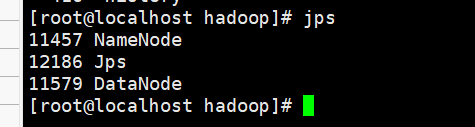

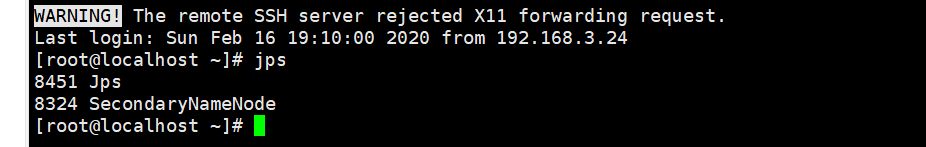

./start-dfs.sh這時,可以在不同節點中通過jps命令查看不同的進程。

61

62

63

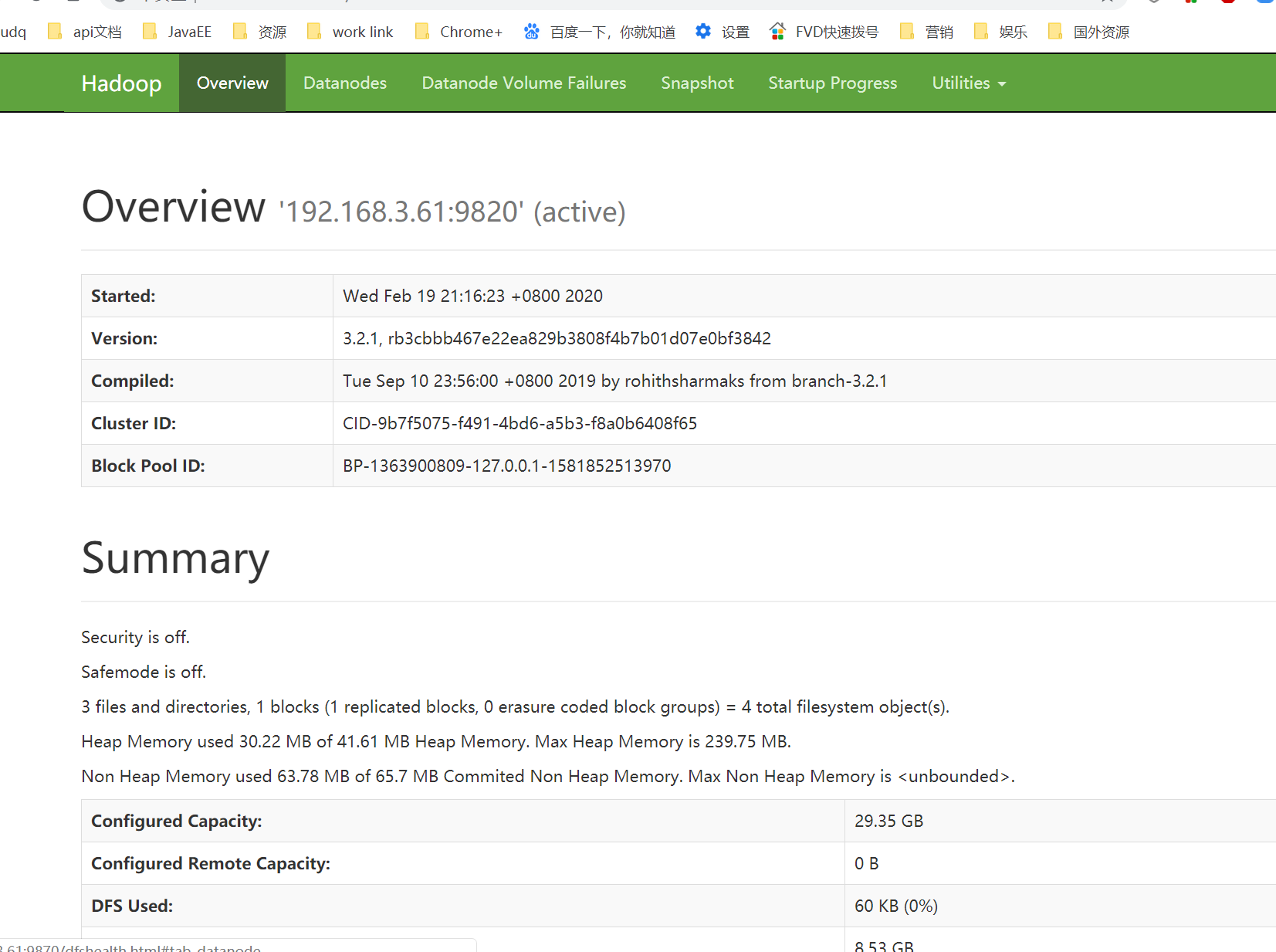

4.打開瀏覽器查看HDFS監聽頁面

在瀏覽器中輸入http://ip:9870,比如這裡輸入http://192.168.30.61:9870/,出現以下界面則表示Hadoop完全分散式搭建成功

選擇Datanodes選項,可以看到DataNode的利用率和DataNode的節點狀態

這裡只顯示了一個比較奇怪,以後再研究。

更多精彩請關註公眾號【lovepythoncn】