前兩篇介紹了Spark的yarn client和yarn cluster模式,本篇繼續介紹Spark的STANDALONE模式和Local模式。 下麵具體還是用計算PI的程式來說明,examples中該程式有三個版本,分別採用Scala、Python和Java語言編寫。本次用Java程式JavaSp ...

前兩篇介紹了Spark的yarn client和yarn cluster模式,本篇繼續介紹Spark的STANDALONE模式和Local模式。

下麵具體還是用計算PI的程式來說明,examples中該程式有三個版本,分別採用Scala、Python和Java語言編寫。本次用Java程式JavaSparkPi做說明。

1 package org.apache.spark.examples; 2 3 import org.apache.spark.api.java.JavaRDD; 4 import org.apache.spark.api.java.JavaSparkContext; 5 import org.apache.spark.sql.SparkSession; 6 7 import java.util.ArrayList; 8 import java.util.List; 9 10 /** 11 * Computes an approximation to pi 12 * Usage: JavaSparkPi [partitions] 13 */ 14 public final class JavaSparkPi { 15 16 public static void main(String[] args) throws Exception { 17 SparkSession spark = SparkSession 18 .builder() 19 .appName("JavaSparkPi") 20 .getOrCreate(); 21 22 JavaSparkContext jsc = new JavaSparkContext(spark.sparkContext()); 23 24 int slices = (args.length == 1) ? Integer.parseInt(args[0]) : 2; 25 int n = 100000 * slices; 26 List<Integer> l = new ArrayList<>(n); 27 for (int i = 0; i < n; i++) { 28 l.add(i); 29 } 30 31 JavaRDD<Integer> dataSet = jsc.parallelize(l, slices); 32 33 int count = dataSet.map(integer -> { 34 double x = Math.random() * 2 - 1; 35 double y = Math.random() * 2 - 1; 36 return (x * x + y * y <= 1) ? 1 : 0; 37 }).reduce((integer, integer2) -> integer + integer2); 38 39 System.out.println("Pi is roughly " + 4.0 * count / n); 40 41 spark.stop(); 42 } 43 }

程式邏輯與之前的Scala和Python程式一樣,就不再多做說明瞭。對比Scala、Python和Java程式,同樣計算PI的邏輯,程式分別是26行、30行和43行,可以看出編寫Spark程式,使用Scala或者Python比Java來得更加簡潔,因此推薦使用Scala或者Python編寫Spark程式。

下麵來以STANDALONE方式來執行這個程式,執行前需要啟動Spark自帶的集群服務(在master上執行$SPARK_HOME/sbin/start-all.sh),最好同時啟動spark的history server,這樣即使在程式運行完以後也可以從Web UI中查看到程式運行情況。啟動Spark的集群服務後,會在master主機和slave主機上分別出現Master守護進程和Worker守護進程。而在Yarn模式下,就不需要啟動Spark的集群服務,只需要在客戶端部署Spark即可,而STANDALONE模式需要在集群每台機器都部署Spark。

輸入以下命令:

[root@BruceCentOS4 jars]# $SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master spark://BruceCentOS.Hadoop:7077 $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

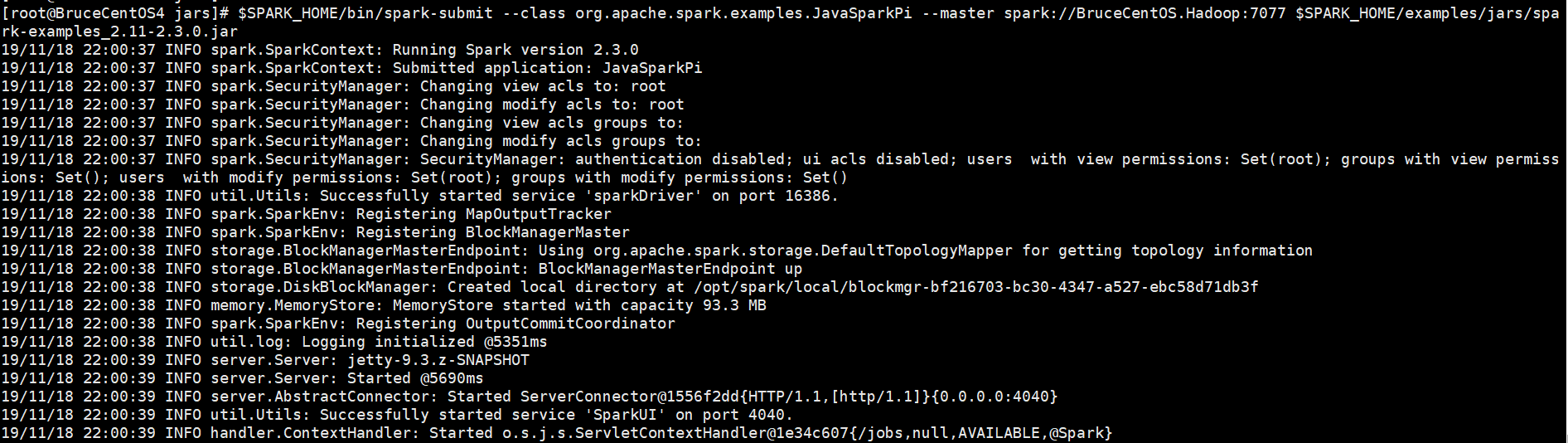

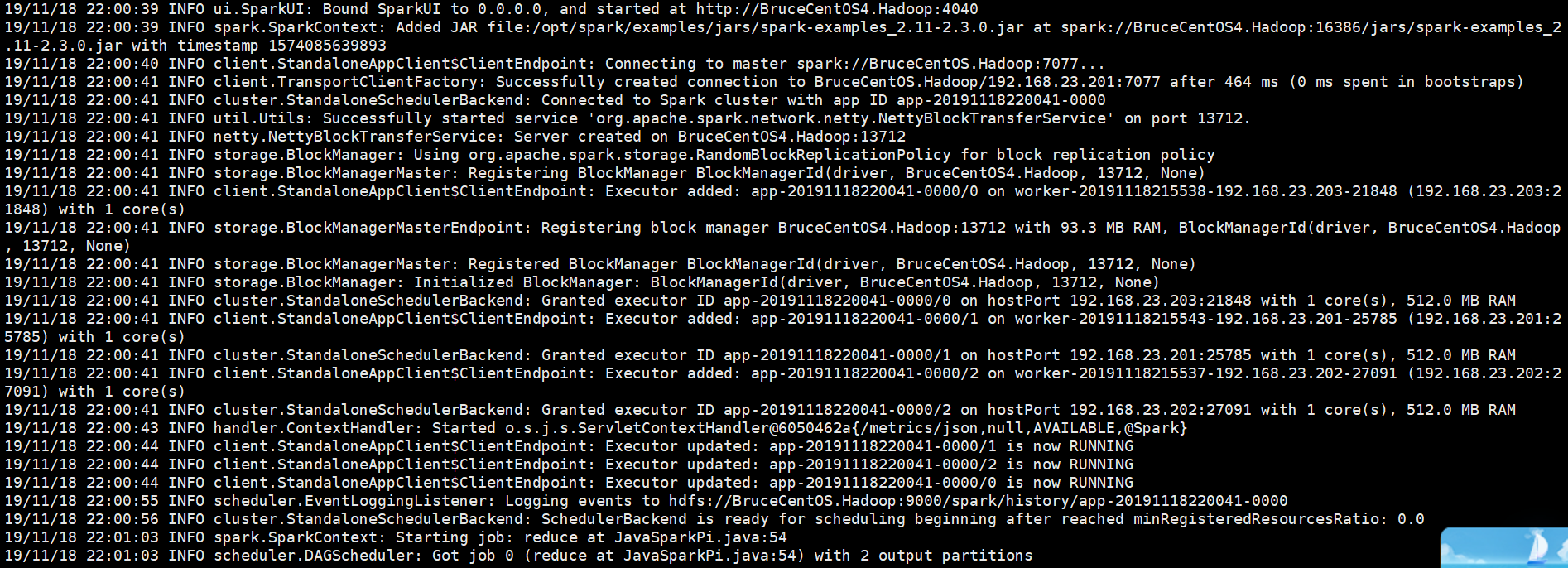

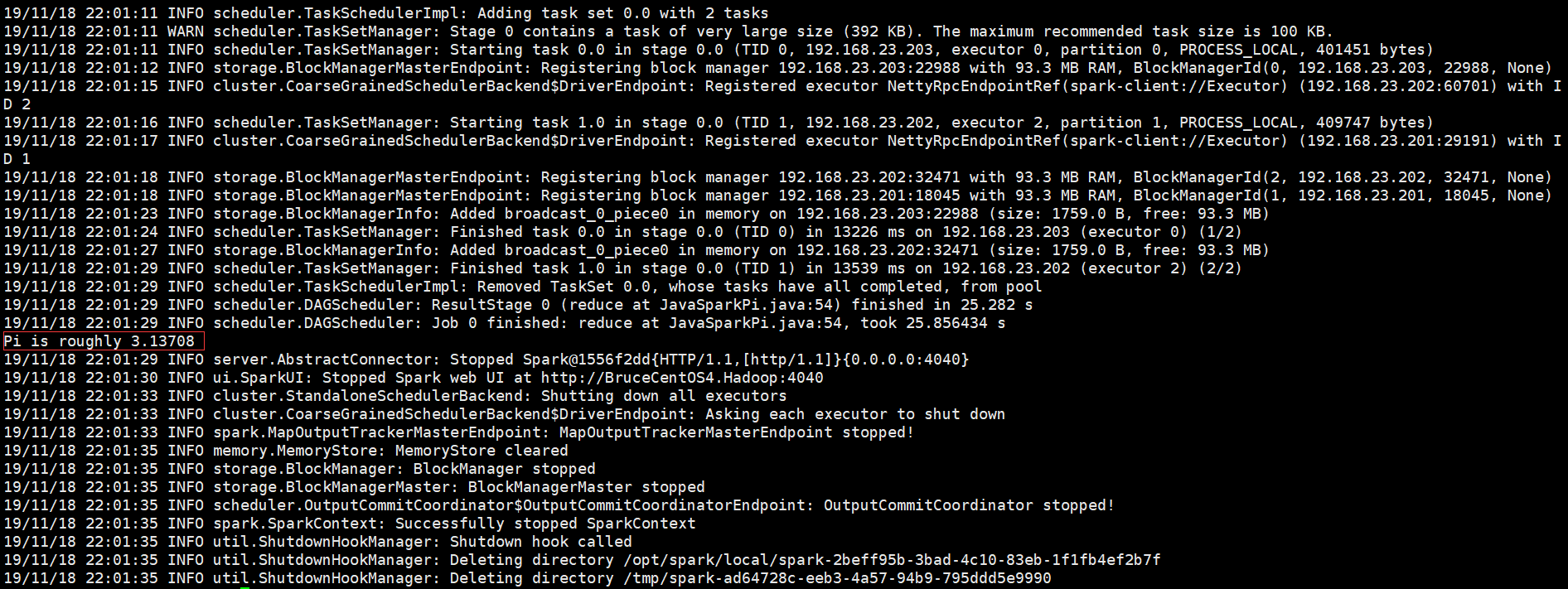

以下是程式運行輸出信息部分截圖,

開始部分:

中間部分:

結束部分:

從上面的程式輸出信息科看出,Spark Driver是運行在客戶端BruceCentOS4上的SparkSubmit進程當中的,集群是Spark自帶的集群。

SparkUI上的Executor信息:

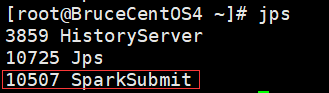

BruceCentOS4上的客戶端進程(包含Spark Driver):

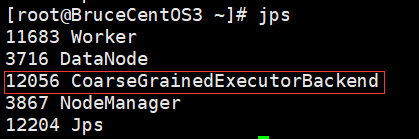

BruceCentOS3上的Executor進程:

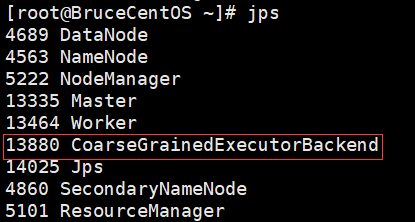

BruceCentOS上的Executor進程:

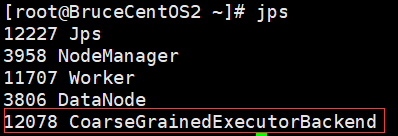

BruceCentOS2上的Executor進程:

下麵具體描述下Spark程式在standalone模式下運行的具體流程。

這裡是一個流程圖:

- SparkContext連接到Master,向Master註冊並申請資源(CPU Core 和Memory)。

- Master根據SparkContext的資源申請要求和Worker心跳周期內報告的信息決定在哪個Worker上分配資源,然後在該Worker上獲取資源,然後啟動CoarseGrainedExecutorBackend。

- CoarseGrainedExecutorBackend向SparkContext註冊。

- SparkContext將Applicaiton代碼發送給CoarseGrainedExecutorBackend;並且SparkContext解析Applicaiton代碼,構建DAG圖,並提交給DAG Scheduler分解成Stage(當碰到Action操作時,就會催生Job;每個Job中含有1個或多個Stage,Stage一般在獲取外部數據和shuffle之前產生),然後以Stage(或者稱為TaskSet)提交給Task Scheduler,Task Scheduler負責將Task分配到相應的Worker,最後提交給CoarseGrainedExecutorBackend執行。

- CoarseGrainedExecutorBackend會建立Executor線程池,開始執行Task,並向SparkContext報告,直至Task完成。

- 所有Task完成後,SparkContext向Master註銷,釋放資源。

最後來看Local運行模式,該模式就是在單機本地環境執行,主要用於程式測試。程式的所有部分,包括Client、Driver和Executor全部運行在客戶端的SparkSubmit進程當中。Local模式有三種啟動方式。

#啟動1個Executor運行任務(1個線程)

[root@BruceCentOS4 ~]#$SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master local $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

#啟動N個Executor運行任務(N個線程),這裡N=2

[root@BruceCentOS4 ~]#$SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master local[2] $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

#啟動*個Executor運行任務(*個線程),這裡*指代本地機器上的CPU核的個數。

[root@BruceCentOS4 ~]#$SPARK_HOME/bin/spark-submit --class org.apache.spark.examples.JavaSparkPi --master local[*] $SPARK_HOME/examples/jars/spark-examples_2.11-2.3.0.jar

以上就是個人對Spark運行模式(STANDALONE和Local)的一點理解,其中參考了“求知若渴 虛心若愚”博主的“Spark(一): 基本架構及原理”的部分內容(其中基於Spark2.3.0對某些細節進行了修正),在此表示感謝。