一 kubeadm介紹1.1 概述Kubeadm 是一個工具,它提供了 kubeadm init 以及 kubeadm join 這兩個命令作為快速創建 kubernetes 集群的最佳實踐。kubeadm 通過執行必要的操作來啟動和運行一個最小可用的集群。kubeadm 只關心啟動集群,而不關心其... ...

一 kubeadm介紹

1.1 概述

Kubeadm 是一個工具,它提供了 kubeadm init 以及 kubeadm join 這兩個命令作為快速創建 kubernetes 集群的最佳實踐。 kubeadm 通過執行必要的操作來啟動和運行一個最小可用的集群。kubeadm 只關心啟動集群,而不關心其他工作,如部署前的節點準備工作、安裝各種Kubernetes Dashboard、監控解決方案以及特定雲提供商的插件,這些都不屬於 kubeadm 關註範圍。1.2 kubeadm功能

- kubeadm init 啟動一個 Kubernetes 主節點;

- kubeadm join 啟動一個 Kubernetes 工作節點並且將其加入到集群;

- kubeadm upgrade 更新一個 Kubernetes 集群到新版本;

- kubeadm config 如果使用 v1.7.x 或者更低版本的 kubeadm 初始化集群,您需要對集群做一些配置以便使用 kubeadm upgrade 命令;

- kubeadm token 管理 kubeadm join 使用的令牌;

- kubeadm reset 還原 kubeadm init 或者 kubeadm join 對主機所做的任何更改;

- kubeadm version 列印 kubeadm 版本;

- kubeadm alpha 預覽一組可用的新功能以便從社區搜集反饋。

二 kubeadm安裝

2.1 前置條件

相應的充足資源的Linux伺服器; 建議關閉SELinux及防火牆:sed -i "s/SELINUX=enforcing/SELINUX=disabled/g" /etc/selinux/config && systemctl stop firewalld Mac及UUID唯一; 若未關閉防火牆則建議放通相應埠,如下: Master節點——2.2 節點規劃

提示:本實驗使用單master部署,生產中可部署奇數個master以做高可用。

2.3 手動添加解析

1 [root@master ~]# cat <<EOF >> /etc/hosts 2 172.24.8.71 master 3 172.24.8.72 node1 4 172.24.8.73 node2 5 EOF

提示:所有節點均建議如上操作。

2.4 修正iptables

1 [root@k8s_master ~]# cat <<EOF >> /etc/sysctl.d/k8s.conf 2 net.bridge.bridge-nf-call-ip6tables = 1 3 net.bridge.bridge-nf-call-iptables = 1 4 net.ipv4.ip_forward = 1 5 EOF 6 [root@master ~]# modprobe br_netfilter 7 [root@master ~]# sysctl -p /etc/sysctl.d/k8s.conf

提示:所有節點均建議如上操作。

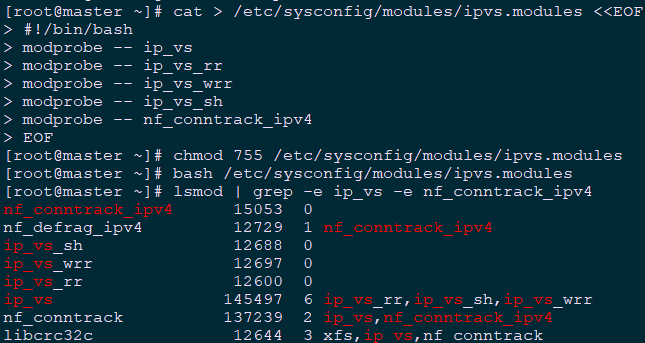

2.5 載入IPVS

pod的負載均衡是用kube-proxy來實現的,實現方式有兩種,一種是預設的iptables,一種是ipvs,相對iptables,ipvs有更好的性能。且當前ipvs已經加入到了內核的主幹。 為kube-proxy開啟ipvs的前提需要載入以下的內核模塊: ip_vs ip_vs_rr ip_vs_wrr ip_vs_sh nf_conntrack_ipv41 [root@master ~]# cat > /etc/sysconfig/modules/ipvs.modules <<EOF 2 #!/bin/bash 3 modprobe -- ip_vs 4 modprobe -- ip_vs_rr 5 modprobe -- ip_vs_wrr 6 modprobe -- ip_vs_sh 7 modprobe -- nf_conntrack_ipv4 8 EOF 9 [root@master ~]# chmod 755 /etc/sysconfig/modules/ipvs.modules 10 [root@master ~]# bash /etc/sysconfig/modules/ipvs.modules 11 [root@master ~]# lsmod | grep -e ip_vs -e nf_conntrack_ipv4 12 [root@master ~]# yum -y install ipvsadm

提示:所有節點均建議如上操作。

為了更好的管理和查看ipvs,可安裝相應的管理工具《002.LVS管理工具的安裝與使用》。

提示:所有節點均建議如上操作。

為了更好的管理和查看ipvs,可安裝相應的管理工具《002.LVS管理工具的安裝與使用》。

2.6 安裝Docker

1 [root@master ~]# yum -y update 2 [root@master ~]# yum -y install yum-utils device-mapper-persistent-data lvm2 3 [root@master ~]# yum-config-manager \ 4 --add-repo \ 5 http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo 6 [root@master ~]# yum list docker-ce --showduplicates | sort -r #查看可用版本 7 [root@master ~]# yum -y install docker-ce-18.09.0-3.el7 #kubeadm當前不支持18.09以上版本 8 [root@master ~]# mkdir /etc/docker 9 [root@master ~]# cat > /etc/docker/daemon.json <<EOF 10 { 11 "exec-opts": ["native.cgroupdriver=systemd"], 12 "log-driver": "json-file", 13 "log-opts": { 14 "max-size": "100m" 15 }, 16 "storage-driver": "overlay2", 17 "storage-opts": [ 18 "overlay2.override_kernel_check=true" 19 ] 20 } 21 EOF #配置system管理cgroup 22 [root@master ~]# vi /usr/lib/systemd/system/docker.service #更改docker鏡像路徑 23 ExecStart=/usr/bin/dockerd-current --data-root=/data/docker #修改為獨立的單獨路徑 24 [root@master ~]# systemctl daemon-reload 25 [root@master ~]# systemctl restart docker 26 [root@master ~]# systemctl enable docker 27 [root@master ~]# iptables -nvL #確認iptables filter表中FOWARD鏈的預設策略(pllicy)為ACCEPT。

提示:所有節點均建議如上操作。

提示:所有節點均建議如上操作。

Kubernetes 1.13版本相容docker版本等可參考:https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.13.md。

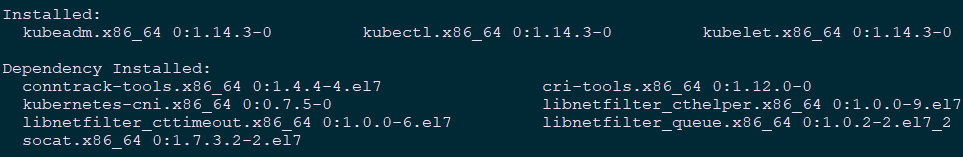

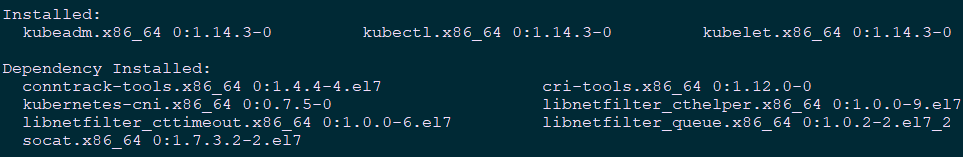

2.7 相關組件包

需要在每台機器上都安裝以下的軟體包: kubeadm: 用來初始化集群的指令; kubelet: 在集群中的每個節點上用來啟動 pod 和 container 等; kubectl: 用來與集群通信的命令行工具。 kubeadm 不能 幫您安裝或管理 kubelet 或 kubectl ,所以得保證他們滿足通過 kubeadm 安裝的 Kubernetes 控制層對版本的要求。如果版本沒有滿足要求,可能導致一些意外錯誤或問題。 具體相關組件安裝見《附001.kubectl介紹及使用》。2.8 正式安裝

1 [root@master ~]# cat <<EOF > /etc/yum.repos.d/kubernetes.repo 2 [kubernetes] 3 name=Kubernetes 4 baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/ 5 enabled=1 6 gpgcheck=1 7 repo_gpgcheck=1 8 gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg 9 EOF 10 #配置yum源 11 [root@master ~]# yum install -y kubelet kubeadm kubectl --disableexcludes=kubernetes

說明:同時安裝了cri-tools, kubernetes-cni, socat三個依賴:

socat:kubelet的依賴;

cri-tools:即CRI(Container Runtime Interface)容器運行時介面的命令行工具。

說明:同時安裝了cri-tools, kubernetes-cni, socat三個依賴:

socat:kubelet的依賴;

cri-tools:即CRI(Container Runtime Interface)容器運行時介面的命令行工具。

1 [root@master ~]# systemctl enable kubelet

提示:所有節點均建議如上操作。此時不需要啟動kubelet,初始化的過程中會自動啟動的,如果此時啟動了會出現報錯,忽略即可。

2.9 其他調整

Kubernetes 從1.8版本開始要求關閉系統的Swap,如果不關閉,預設配置下kubelet將無法啟動。1 [root@master ~]# echo "vm.swappiness=0" >> /etc/sysctl.d/k8s.conf 2 [root@master ~]# sysctl -p /etc/sysctl.d/k8s.conf提示:同時需要註意fstba等系統掛載的swap。

三 初始化最簡集群-Mater

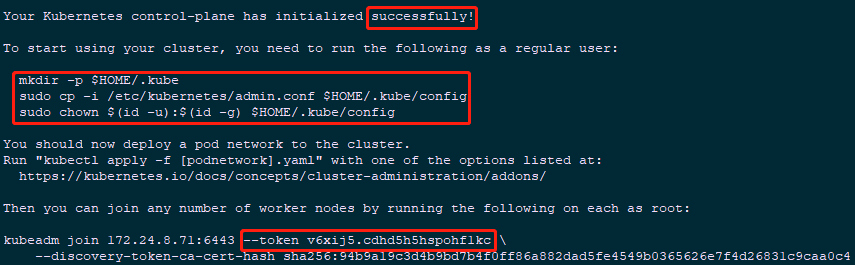

3.1 Master上初始化

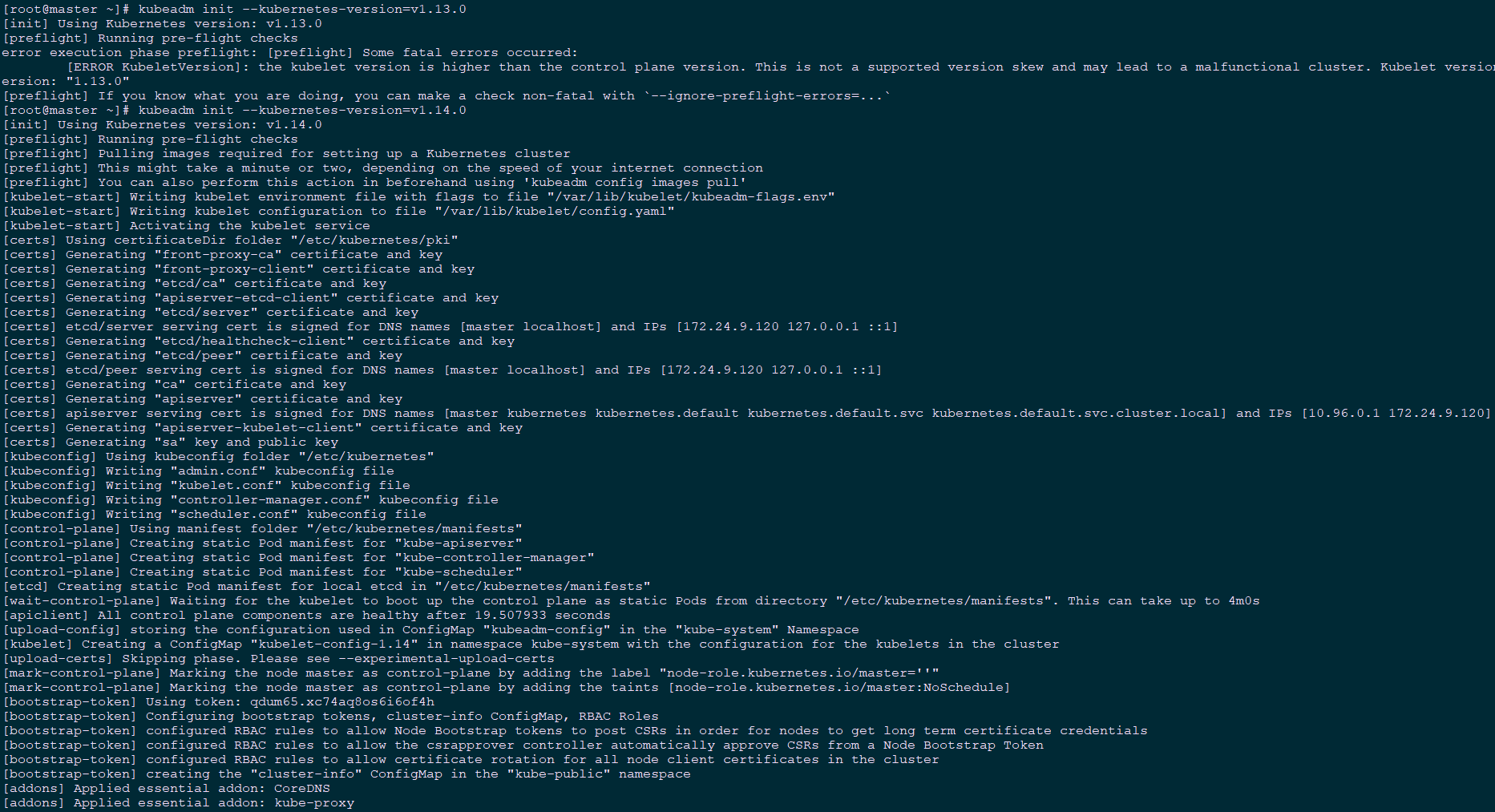

1 [root@master ~]# kubeadm init --kubernetes-version=v1.14.0 --pod-network-cidr=10.244.0.0/16

1 [root@master ~]# mkdir -p $HOME/.kube 2 [root@master ~]# sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config 3 [root@master ~]# sudo chown $(id -u):$(id -g) $HOME/.kube/config提示:選擇flannel作為Pod網路插件,所以上面的命令指定–pod-network-cidr=10.244.0.0/16。 預設使用k8s.gcr.io拉取鏡像,國內用戶可通過以下命令使用阿裡源: kubeadm init --kubernetes-version=v1.14.0 --image-repository=registry.aliyuncs.com/google_containers --pod-network-cidr=10.244.0.0/16

1 [root@master ~]# export KUBECONFIG=$HOME/.kube/config #聲明配置文件

附加:初始化過程粗略解析:

初始化Kubernetes大致步驟如下:

初始化Kubernetes大致步驟如下:

- [kubelet-start] 生成kubelet的配置文件”/var/lib/kubelet/config.yaml”

- [certificates]生成相關的各種證書

- [kubeconfig]生成相關的kubeconfig文件

- [bootstraptoken]生成token記錄下來,後邊使用kubeadm join往集群中添加節點時會用到

3.2 查看集群狀態

1 [root@master ~]# kubectl get cs 2 NAME STATUS MESSAGE ERROR 3 controller-manager Healthy ok 4 scheduler Healthy ok 5 etcd-0 Healthy {"health":"true"}

四 安裝flannel插件

4.1 NIC插件介紹

Calico 是一個安全的 L3 網路和網路策略提供者。 Canal 結合 Flannel 和 Calico, 提供網路和網路策略。 Cilium 是一個 L3 網路和網路策略插件, 能夠透明的實施 HTTP/API/L7 策略。 同時支持路由(routing)和疊加/封裝( overlay/encapsulation)模式。 Contiv 為多種用例提供可配置網路(使用 BGP 的原生 L3,使用 vxlan 的 overlay,經典 L2 和 Cisco-SDN/ACI)和豐富的策略框架。Contiv 項目完全開源。安裝工具同時提供基於和不基於 kubeadm 的安裝選項。 Flannel 是一個可以用於 Kubernetes 的 overlay 網路提供者。 Romana 是一個 pod 網路的層 3 解決方案,並且支持 NetworkPolicy API。Kubeadm add-on 安裝細節可以在這裡找到。 Weave Net 提供了在網路分組兩端參與工作的網路和網路策略,並且不需要額外的資料庫。 CNI-Genie 使 Kubernetes 無縫連接到一種 CNI 插件,例如:Flannel、Calico、Canal、Romana 或者 Weave。 提示:本實驗使用flannel插件,附加演示了另一種插件Weave的安裝。4.2 下載flannel配置

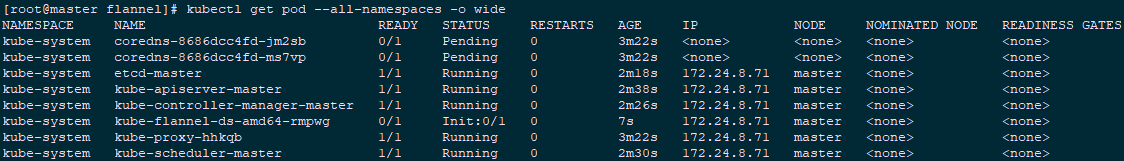

1 [root@master ~]# mkdir flannel 2 [root@master ~]# cd flannel/ 3 [root@master flannel]# wget https://raw.githubusercontent.com/coreos/flannel/62e44c867a2846fefb68bd5f178daf4da3095ccb/Documentation/kube-flannel.yml 4 [root@master flannel]# kubectl apply -f kube-flannel.yml 5 [root@master ~]# kubectl get pod --all-namespaces -o wide #查看相關pod

延伸:

使用kubeadm初始化的集群,出於安全考慮Pod不會被調度到Master Node上,其策略是因為當前的master節點node1被打上了node-role.kubernetes.io/master:NoSchedule的污點:

延伸:

使用kubeadm初始化的集群,出於安全考慮Pod不會被調度到Master Node上,其策略是因為當前的master節點node1被打上了node-role.kubernetes.io/master:NoSchedule的污點:

1 [root@master ~]# kubectl describe node master | grep Taint 2 Taints: node-role.kubernetes.io/master:NoSchedule

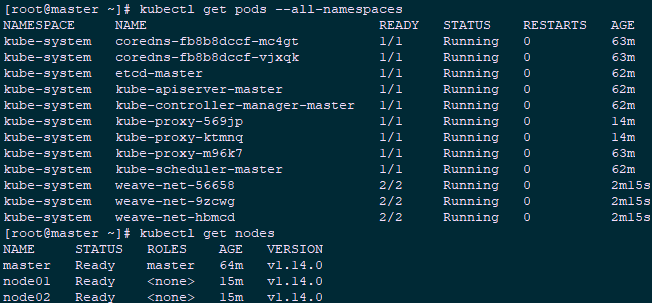

附加:安裝weave插件

1 [root@master ~]# kubectl apply -f "https://cloud.weave.works/k8s/net?k8s-version=$(kubectl version | base64 | tr -d '\n')"

提示:kubeadm 只支持基於容器網路介面(CNI)的網路而且不支持 kubenet。

1 [root@master ~]# kubectl get pods --all-namespaces #查看驗證 2 [root@master ~]# kubectl get nodes

提示:更多Kubetcl使用參考:https://kubernetes.io/docs/reference/kubectl/kubectl/

https://kubernetes.io/docs/reference/kubectl/overview/

更多kubeadm使用參考:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

提示:更多Kubetcl使用參考:https://kubernetes.io/docs/reference/kubectl/kubectl/

https://kubernetes.io/docs/reference/kubectl/overview/

更多kubeadm使用參考:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

五 Node節點安裝

5.1 node節點準備

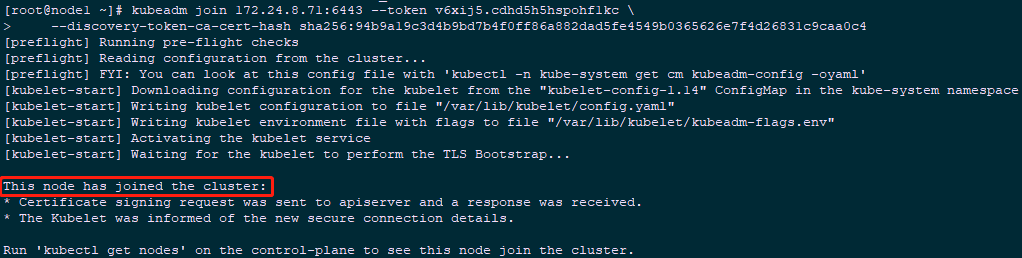

執行完所有2.2——2.9步驟。5.2 加入集群

1 [root@node1 ~]# echo "1" >/proc/sys/net/ipv4/ip_forward 2 [root@node1 ~]# kubeadm join 172.24.8.71:6443 --token v6xij5.cdhd5h5hspohf1kc \ 3 --discovery-token-ca-cert-hash sha256:94b9a19c3d4b9bd7b4f0ff86a882dad5fe4549b0365626e7f4d26831c9caa0c4 4 [root@node2 ~]# echo "1" >/proc/sys/net/ipv4/ip_forward 5 [root@node2 ~]# kubeadm join 172.24.8.71:6443 --token v6xij5.cdhd5h5hspohf1kc \ 6 --discovery-token-ca-cert-hash sha256:94b9a19c3d4b9bd7b4f0ff86a882dad5fe4549b0365626e7f4d26831c9caa0c4

註意:預設為0,修改為1,則開啟IP轉發功能,修改後立刻生效,但重啟後失效。

註意:預設為0,修改為1,則開啟IP轉發功能,修改後立刻生效,但重啟後失效。

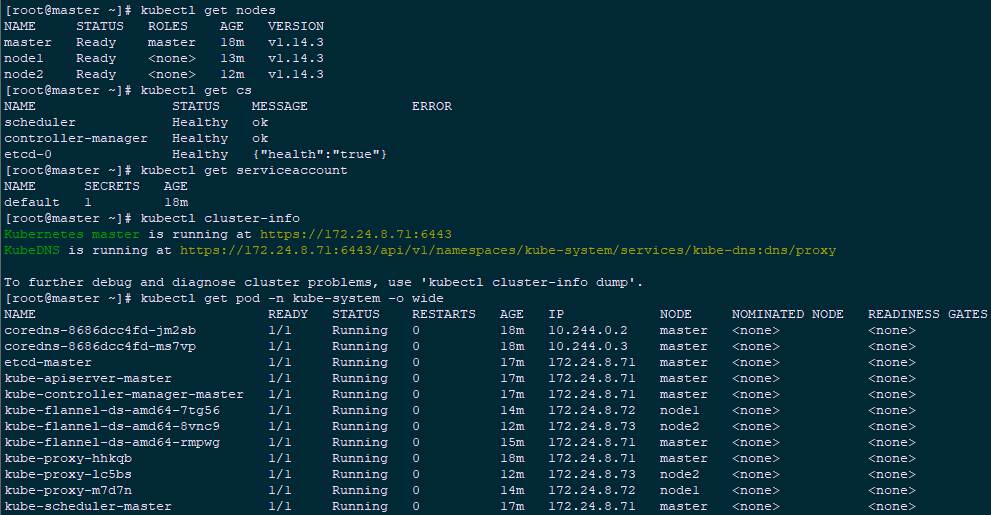

5.3 確認驗證

1 [root@master ~]# kubectl get nodes #節點狀態 2 [root@master ~]# kubectl get cs #組件狀態 3 [root@master ~]# kubectl get serviceaccount #服務賬戶 4 [root@master ~]# kubectl cluster-info #集群信息 5 [root@master ~]# kubectl get pod -n kube-system -o wide #所有服務狀態

提示:更多Kubetcl使用參考:https://kubernetes.io/docs/reference/kubectl/kubectl/

https://kubernetes.io/docs/reference/kubectl/overview/

更多kubeadm使用參考:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

提示:更多Kubetcl使用參考:https://kubernetes.io/docs/reference/kubectl/kubectl/

https://kubernetes.io/docs/reference/kubectl/overview/

更多kubeadm使用參考:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

六 開啟IPVS

6.1 修改ConfigMap

1 [root@master ~]# kubectl edit cm kube-proxy -n kube-system #模式改為ipvs 2 …… 3 mode: "ipvs" 4 …… 5 [root@master ~]# kubectl get pod -n kube-system | grep kube-proxy | awk '{system("kubectl delete pod "$1" -n kube-system")}' 6 [root@master ~]# kubectl get pod -n kube-system | grep kube-proxy #查看proxy的pod 7 [root@master ~]# kubectl logs kube-proxy-mgqfs -n kube-system #查看任意一個proxy pod的日誌