在百萬級和千萬級數據級別進行插入,pymongo的insert_many()方法有著很強的優勢。本文做了對原生pymongo和Django框架中經常使用的mongoengine進行測試,以進行對比。 ...

在百萬級和千萬級數據級別進行插入,pymongo的insert_many()方法有著很強的優勢。原因是每次使用insert_one()方法進行插入數據,都是要對資料庫伺服器進行一次訪問,而這樣的訪問是基於TCP連接的,每次在發送請求的時候伺服器端都需要對TCP報文進行解析。而使用insert_many(),可以一次給伺服器發送大量的數據,只需要一次的TCP報文解析,既可以插入大量數據,避免了大量的報文解析工作。這樣一來,數據插入的效率就會大大提升。所以,為了提升效率,筆者建議在十萬數據級別以上使用insert_many()方法。

下麵是我通過使用pymongo原生方法和框架中的經常使用的Mongoengine進行的性能測試。

一、使用Mongoengine

Mongoengine是基於面向對象的,在構建集合的時候非常方便,就直接寫一個類。而pymongo是繼承於MongoDB的文檔類型的,所以在框架中使用會相對沒有那麼方便。但是Mongoengine目前來講還有許多還沒有完善的地方。個人覺得,還是根據實際的需求來選擇不同的引擎。

插入數據方面,Mongoengine在0.15版本之前只有save()方法,在0.15版本之後添加了insert_one()和inset_many()方法,具體可以看官方文檔:。

但是由於Django官方沒有將MongoDB列為建議使用的資料庫,所以不支持0.9之後的版本。

代碼:

插入一千條數據

插入方法:使用save()保存數據

耗時:大概2秒鐘

插入10萬條數據

插入方法:使用save()

耗時:兩分多鐘

二、使用pymongo

(1)測試1:插入一百萬數據

插入方法:insert_many()

耗時:28秒

代碼:

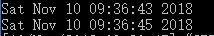

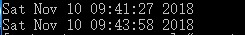

耗時時間:

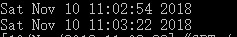

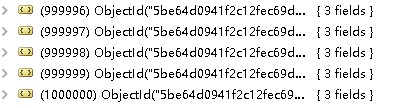

插入結果:

(2)測試2:在一百萬條數據基礎上增加十萬數據

插入方法:insert_one()

耗時:1分鐘29秒

代碼:

耗時時間:

插入結果:

通過上面的測試,很明顯的看到,無論是使用Mongoengine的save()方法,還是使用pymongo的insert_one()方法,在大數據量的插入時都會耗費大量的時間,在百萬級別的數據就已經需要花費5-6個小時的時間了,顯然,這樣的效率是很低的。更別說千萬級別的數據了。

而使用pymongo的insert_many()方法,在插入百萬條數據只是花費了28秒,速度好像快得有點難以想象是吧?按照這樣的推算,千萬級別數據的數據也大概花費不到5分鐘就可以完成了。

那麼為什麼pymongo的原生方法insert_many()有這麼高的效率呢?如何能更進一步提高效率呢?通過閱讀源碼和分析參數,來瞭解一下。

insert_many() 定義源碼:

def insert_many(self, documents, ordered=True, bypass_document_validation=False, session=None):

官方對參數的解析:

參數:

documents就是我們需要插入的數據文檔,也就是上文的articles

下麵重點講ordered和bypass_document_validaion

1. ordered

預設情況下是True,即按順序來插入多條數據,如果發生錯誤,就會終止後面的插入。如果設置為False,文檔將以任意的順序將數據插入到伺服器中,並且是並行進行的,客戶端會儘力將所有的數據都插入到伺服器中。所以,設置為False會在數據的插入效率有很大的提升,但也要付出一點數據安全性的代價。

2. bypass_document_validation

預設情況為False。如果為True,那麼允許在寫入發生錯誤的時候推出文檔級別的驗證,不影響後面的數據插入。

設置合適的參數值,可以更好地為海量數據的插入提供更好的插入環境。

筆者:

歡迎評論!希望本人的文章對閱讀者有幫助,也希望讀者在發現錯誤的地方及時向我提出,我會儘快修改自己的技術疏漏。作為一個即將畢業的在校生,本人知道自己技術上還有很大的進步空間,我會努力提升自己,也會定時寫一些自己學習中的收穫和項目中的經驗。希望前行的路上,有更多樂於分享的人一起作伴。