每個人都在說大數據,但是大數據到底是什麼?很多人都沒有搞清楚。所以大數據學習要學什麼知識自然就不是非常清楚了。 什麼是大數據?其實從字面意義上講,我們就可以進行簡單的瞭解,大數據就是大的數據,也可以稱之為海量數據或巨量數據。大數據相對的就是小數據或者普通數據,大數據與小數據或平臺數據的區別在哪裡呢? ...

每個人都在說大數據,但是大數據到底是什麼?很多人都沒有搞清楚。所以大數據學習要學什麼知識自然就不是非常清楚了。

什麼是大數據?

其實從字面意義上講,我們就可以進行簡單的瞭解,大數據就是大的數據,也可以稱之為海量數據或巨量數據。大數據相對的就是小數據或者普通數據,大數據與小數據或平臺數據的區別在哪裡呢?小數據或平臺數據是可以通過人或者普通的工具就可以進行收集、提取、處理等等操作。而大數據是涉及的有價值的數據資料量,規模巨大到無法通過人腦甚至主流軟體工具,在合理時間內達到擷取、管理、處理、並整理成為幫助企業經營決策更積極目的的資訊。

那麼大數據的處理就需要新型的技術和工具進行處理,而當前社會的高速發展,每天在不同的互聯網平臺甚至傳統行業都會產生巨大的數據。所以大數據人才的需求量就不斷增加。

大數據主要就業方向是什麼?

我們瞭解完大數據的基本概念後,再讓我們看看每天談論的大數據到底做什麼工作

1.大數據研發

2.大數據分析與挖掘

3.深度學習

4.人工智慧

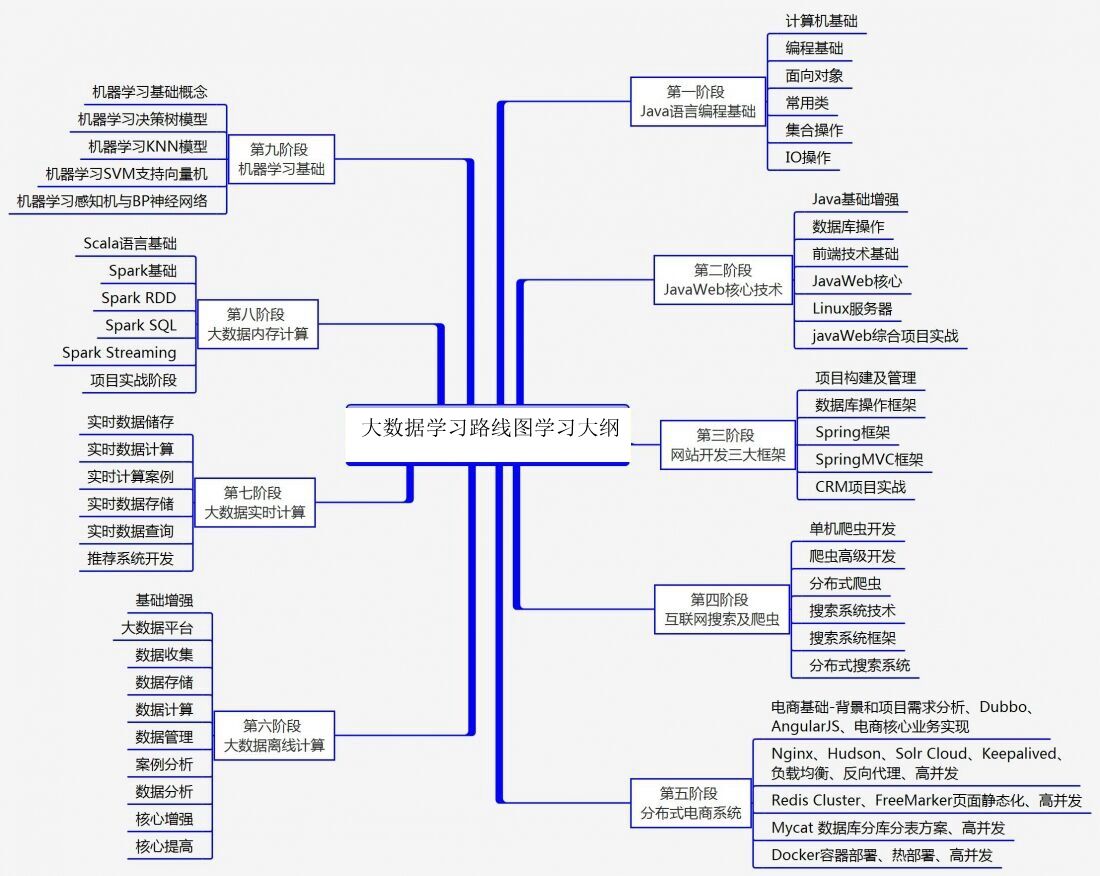

大數據需要學習哪些知識?

學習大數據到底是學習編程、還是工具使用,還是數學理論?

大數據的方向很廣需要掌握的知識也不大相同。今天我們就主要的就業方向進行知識結構解剖。

java:大家都知道Java的方向有JavaSE、JavaEE、JavaME,學習大數據要學習那個方向呢?只需要學習Java的標準版JavaSE就可以了,像Servlet、JSP、Tomcat、Struts、Spring、Hibernate,Mybatis都是JavaEE方向的技術在大數據技術里用到的並不多,只需要瞭解就可以了,當然Java怎麼連接資料庫還是要知道的,像JDBC一定要掌握一下,有同學說Hibernate或Mybites也能連接資料庫啊,為什麼不學習一下,我這裡不是說學這些不好,而是說學這些可能會用你很多時間,到最後工作中也不常用,我還沒看到誰做大數據處理用到這兩個東西的,當然你的精力很充足的話,可以學學Hibernate或Mybites的原理,不要只學API,這樣可以增加你對Java操作資料庫的理解,因為這兩個技術的核心就是Java的反射加上JDBC的各種使用。

linux:因為大數據相關軟體都是在Linux上運行的,所以Linux要學習的扎實一些,學好Linux對你快速掌握大數據相關技術會有很大的幫助,能讓你更好的理解hadoop、hive、hbase、spark等大數據軟體的運行環境和網路環境配置,能少踩很多坑,學會shell就能看懂腳本這樣能更容易理解和配置大數據集群。還能讓你對以後新出的大數據技術學習起來更快。

hadoop:這是現在流行的大數據處理平臺幾乎已經成為大數據的代名詞,所以這個是必學的。Hadoop裡面包括幾個組件HDFS、MapReduce和YARN,HDFS是存儲數據的地方就像我們電腦的硬碟一樣文件都存儲在這個上面,MapReduce是對數據進行處理計算的,它有個特點就是不管多大的數據只要給它時間它就能把數據跑完,但是時間可能不是很快所以它叫數據的批處理。YARN是體現Hadoop平臺概念的重要組件有了它大數據生態體系的其它軟體就能在hadoop上運行了,這樣就能更好的利用HDFS大存儲的優勢和節省更多的資源比如我們就不用再單獨建一個spark的集群了,讓它直接跑在現有的hadoop yarn上面就可以了。其實把Hadoop的這些組件學明白你就能做大數據的處理了,只不過你現在還可能對"大數據"到底有多大還沒有個太清楚的概念,聽我的別糾結這個。等以後你工作了就會有很多場景遇到幾十T/幾百T大規模的數據,到時候你就不會覺得數據大真好,越大越有你頭疼的。當然別怕處理這麼大規模的數據,因為這是你的價值所在,讓那些個搞Javaee的php的html5的和DBA的羡慕去吧。

Zookeeper:這是個萬金油,安裝Hadoop的HA的時候就會用到它,以後的Hbase也會用到它。它一般用來存放一些相互協作的信息,這些信息比較小一般不會超過1M,都是使用它的軟體對它有依賴,對於我們個人來講只需要把它安裝正確,讓它正常的run起來就可以了。

mysql:我們學習完大數據的處理了,接下來學習學習小數據的處理工具mysql資料庫,因為一會裝hive的時候要用到,mysql需要掌握到什麼層度那?你能在Linux上把它安裝好,運行起來,會配置簡單的許可權,修改root的密碼,創建資料庫。這裡主要的是學習SQL的語法,因為hive的語法和這個非常相似。

Sqoop:這個是用於把Mysql里的數據導入到Hadoop里的。當然你也可以不用這個,直接把Mysql數據表導出成文件再放到HDFS上也是一樣的,當然生產環境中使用要註意Mysql的壓力。

Hive:這個東西對於會SQL語法的來說就是神器,它能讓你處理大數據變的很簡單,不會再費勁的編寫MapReduce程式。有的人說Pig那?它和Pig差不多掌握一個就可以了。

Oozie:既然學會Hive了,我相信你一定需要這個東西,它可以幫你管理你的Hive或者MapReduce、Spark腳本,還能檢查你的程式是否執行正確,出錯了給你發報警並能幫你重試程式,最重要的是還能幫你配置任務的依賴關係。我相信你一定會喜歡上它的,不然你看著那一大堆腳本,和密密麻麻的crond是不是有種想屎的感覺。

Hbase:這是Hadoop生態體系中的NOSQL資料庫,他的數據是按照key和value的形式存儲的並且key是唯一的,所以它能用來做數據的排重,它與MYSQL相比能存儲的數據量大很多。所以他常被用於大數據處理完成之後的存儲目的地。

Kafka:這是個比較好用的隊列工具,隊列是幹嗎的?排隊買票你知道不?數據多了同樣也需要排隊處理,這樣與你協作的其它同學不會叫起來,你幹嗎給我這麼多的數據(比如好幾百G的文件)我怎麼處理得過來,你別怪他因為他不是搞大數據的,你可以跟他講我把數據放在隊列里你使用的時候一個個拿,這樣他就不在抱怨了馬上灰流流的去優化他的程式去了,因為處理不過來就是他的事情。而不是你給的問題。當然我們也可以利用這個工具來做線上實時數據的入庫或入HDFS,這時你可以與一個叫Flume的工具配合使用,它是專門用來提供對數據進行簡單處理,並寫到各種數據接受方(比如Kafka)的。大數據學習群142973723

Spark:它是用來彌補基於MapReduce處理數據速度上的缺點,它的特點是把數據裝載到記憶體中計算而不是去讀慢的要死進化還特別慢的硬碟。特別適合做迭代運算,所以演算法流們特別稀飯它。它是用scala編寫的。Java語言或者Scala都可以操作它,因為它們都是用JVM的。