Sqoop將mysql數據導入hbase的血與淚(整整搞了大半天) 版權聲明:本文為yunshuxueyuan原創文章。如需轉載請標明出處: https://my.oschina.net/yunshuxueyuan/blogQQ技術交流群:299142667 一、 問題如何產生 龐老師只講解了mys ...

Sqoop將mysql數據導入hbase的血與淚(整整搞了大半天)

版權聲明:本文為yunshuxueyuan原創文章。

如需轉載請標明出處: https://my.oschina.net/yunshuxueyuan/blog

QQ技術交流群:299142667

一、 問題如何產生

龐老師只講解了mysql和hdfs,mysq與hive的數據互導,因此決定研究一下將mysql數據直接導入hbase,這時出現了一系列問題。

心酸史:

二、 開始具體解決問題

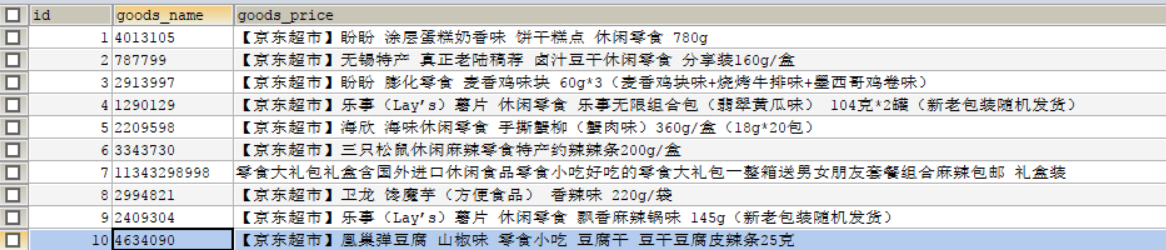

需求:(將以下這張表數據導入mysql)

由此,編寫如下sqoop導入命令

sqoop import -D sqoop.hbase.add.row.key=true --connect jdbc:mysql://192.168.1.9/spider --username root --password root --table test_goods --hbase-create-table --hbase-table t_goods --column-family cf --hbase-row-key id -m 1

一切看著都很正常,接下來開始執行命令,報如下錯誤:

1、

Error during import: No primary key could be found for table *

報錯原因就是指定的mysql表名不是大寫,所以mysql表名必須大寫

2、

Could not insert row with null value for row-key column

報錯原因是沒有指定mysql的列名,所以必須指定列名,並且hbase-row-key id 中的id,必須在–columns中顯示。 --columns ID,GOODS_NAME, GOODS_PRICE

3、

Error parsing arguments for import Unrecognized argument

報錯原因是在指定mysql的列名時,用逗號隔開的時候我多加了空格,所以在Columns後顯示的列名只能用逗號隔開,不要帶空格。

將以上三個問題排除後:我的最新導入命令變為如下:

sqoop import -D sqoop.hbase.add.row.key=true --connect jdbc:mysql://192.168.1.9:3306/spider --username root --password root --table TEST_GOODS --columns id,goods_name,goods_price --hbase-create-table --hbase-table t_goods --column-family cf --hbase-row-key id --where "id >= 5" -m 1

註意:這裡有個小問題:記得將id>=5引起來

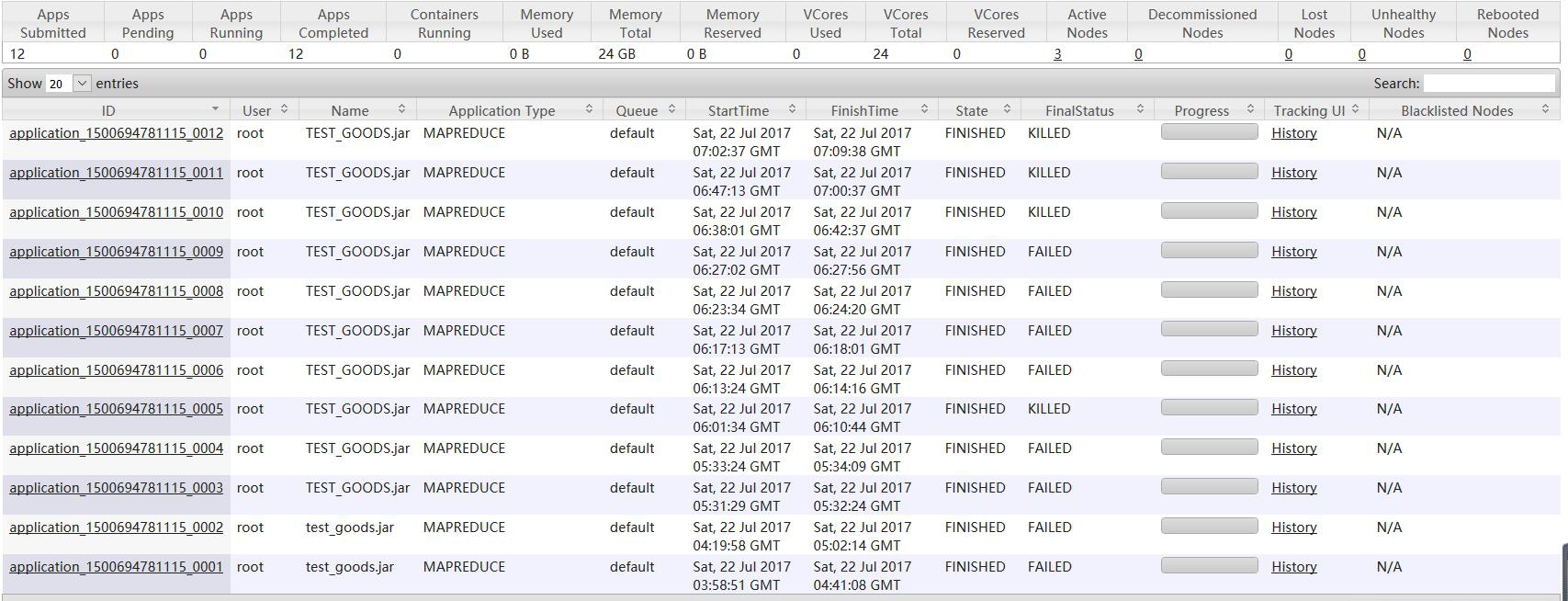

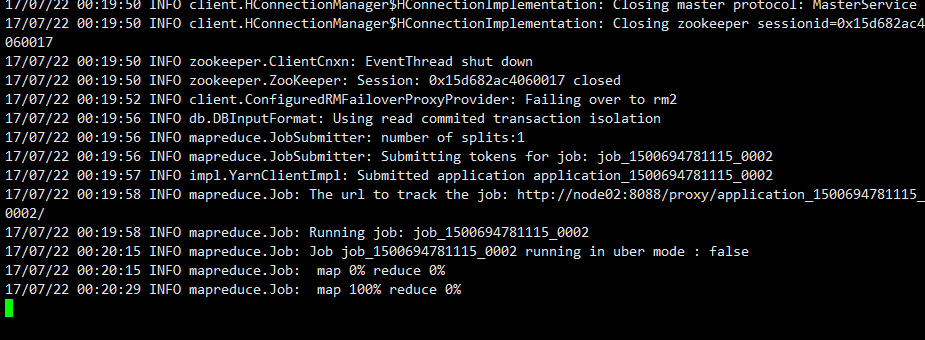

再次執行導入命令:出現如下情況(卡了好長時間)

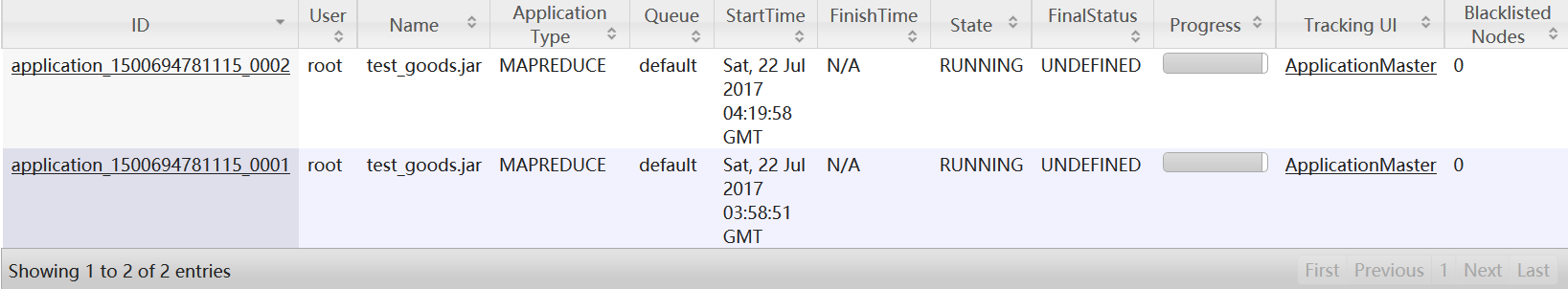

發下map執行完成了,但是也就只卡在這裡不動了,mapreduce任務一直在後臺起著,一段時間後死掉,在這期間不停的執行導入命令和殺掉mapreduce的job

hadoop job -list 查看mapreduce 的job列表

hadoop job -kill job_id 殺死某個Job

經過長時間的測試,突然意識到當前用的是Hbase偽分散式,一下子恍然大悟:

原因:因為當前環境為hbase的偽分散式,所以hbase的數據是存在本地磁碟上的,

並且由自帶的zookeeper進行管理。而將mysql數據導入hbase的原理其實就是將數據導入hdfs,所以要想導入成功,存放hbase的數據地址應該在hdfs上才可以。所以如何解決這個問題,我想大家知道了,那就是開啟hbase完全分散式。

經過一頓折騰將虛擬機回覆到hbase完全分散式的快照,安裝好sqoop,進行最終的測試!

最終執行的導入命令如下:(完整的導入命令)

sqoop import -D sqoop.hbase.add.row.key=true --connect jdbc:mysql://192.168.1.9:3306/spider --username root --password root --table TEST_GOODS --columns ID,GOODS_NAME,GOODS_PRICE --hbase-create-table --hbase-table t_goods --column-family cf --hbase-row-key ID --where "ID >= 5" -m 1

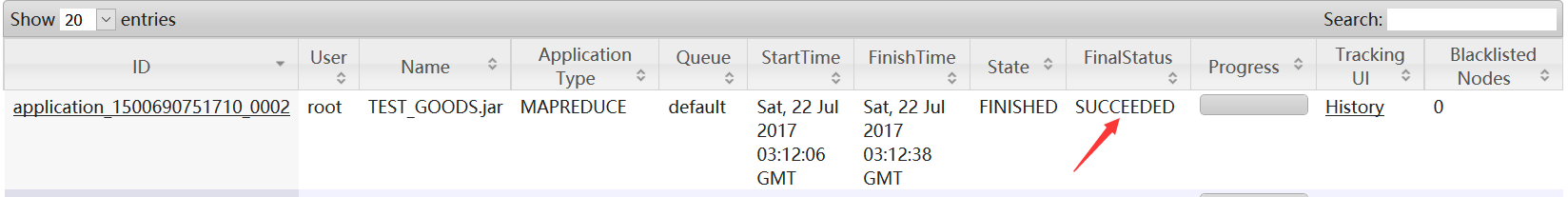

終於見到久違的頁面:

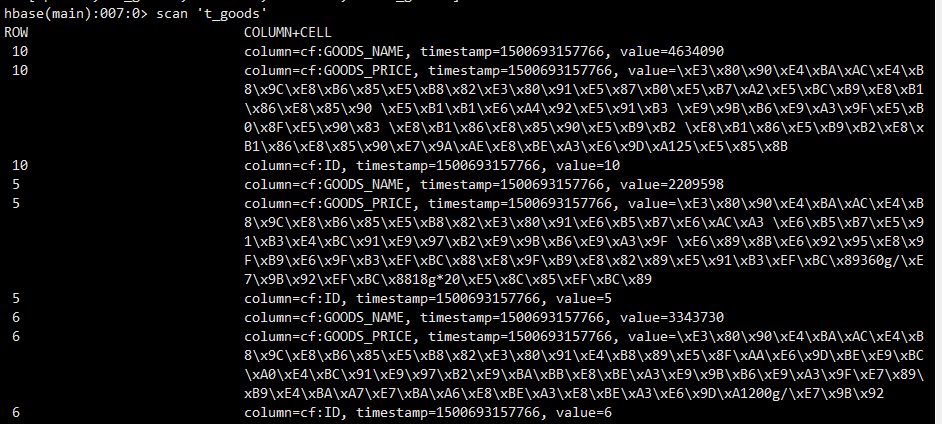

查看hbase,數據已經成功導入

最後我將命令寫入一個xxx文件,通過sqoop –options-file xxx 執行導入命令

錯誤寫法如下:

import -D sqoop.hbase.add.row.key=true --connect jdbc:mysql://192.168.1.9:3306/spider --username root --password root --table TEST_GOODS --columns ID,GOODS_NAME,GOODS_PRICE --hbase-create-table --hbase-table test_goods --column-family cf --hbase-row-key ID --where "ID >= 5" -m 1

錯誤原因:參數的名稱和參數的值沒有進行回車換行

正確寫法:

import -D sqoop.hbase.add.row.key=true --connect jdbc:mysql://192.168.1.9:3306/spider --username root --password root --table TEST_GOODS --columns ID,GOODS_NAME,GOODS_PRICE --hbase-create-table --hbase-table tt_goods --column-family cf --hbase-row-key ID --where ID>=5 -m 1

註:參數含義解釋

-D sqoop.hbase.add.row.key=true 是否將rowkey相關欄位寫入列族中,預設為false,預設情況下你將在列族中看不到任何row key中的欄位。註意,該參數必須放在import之後。

--connect 資料庫連接字元串

--username –password mysql資料庫的用戶名密碼

--table Test_Goods表名,註意大寫

--hbase-create-table 如果hbase中該表不存在則創建

--hbase-table 對應的hbase表名

--hbase-row-key hbase表中的rowkey,註意格式

--column-family hbase表的列族

--where 導入是mysql表的where條件,寫法和sql中一樣

--split-by CREATE_TIME 預設情況下sqoop使用4個併發執行任務,需要制訂split的列,如果不想使用併發,可以用參數 --m 1

到此,bug解決完成!!!

三、知識拓展,定時增量導入

1、Sqoop增量導入

sqoop import -D sqoop.hbase.add.row.key=true --connect jdbc:mysql://192.168.1.9:3306/spider --username root --password root --table TEST_GOODS --columns ID,GOODS_NAME,GOODS_PRICE --hbase-create-table --hbase-table t_goods --column-family cf --hbase-row-key ID --incremental lastmodified --check-column U_DATE --last-value '2017-06-27' --split-by U_DATE

--incremental lastmodified 增量導入支持兩種模式 append 遞增的列;lastmodified時間戳。

--check-column 增量導入時參考的列

--last-value 最小值,這個例子中表示導入2017-06-27到今天的值

2、Sqoop job:

sqoop job --create testjob01 --import --connect jdbc:mysql://192.168.1.9:3306/spider --username root --password root --table TEST_GOODS --columns ID,GOODS_NAME,GOODS_PRICE --hbase-create-table --hbase-table t_goods --column-family cf --hbase-row-key ID -m 1

設置定時執行以上sqoop job

使用linux定時器:crontab -e

例如每天執行

0 0 * * * /opt/local/sqoop-1.4.6/bin/sqoop job ….

--exec testjob01

版權聲明:本文為yunshuxueyuan原創文章。

如需轉載請標明出處: https://my.oschina.net/yunshuxueyuan/blog

QQ技術交流群:299142667