本文分享自天翼雲開發者社區《一種Mysql和Mongodb數據同步到Elasticsearch的實現辦法和系統》,作者:l****n 核心流程如下: 核心邏輯說明: MySQL Binlog解析: 首先,從MySQL的二進位日誌(Binlog)中解析出表名。這一步驟非常關鍵,因為我們只關註特定表的數 ...

本文分享自天翼雲開發者社區《一種Mysql和Mongodb數據同步到Elasticsearch的實現辦法和系統》,作者:l****n

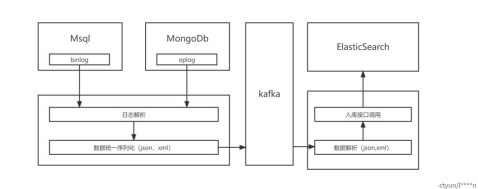

核心流程如下:

核心邏輯說明:

MySQL Binlog解析:

首先,從MySQL的二進位日誌(Binlog)中解析出表名。這一步驟非常關鍵,因為我們只關註特定表的數據變更。

進一步,我們檢查Binlog中的操作類型,如INSERT、UPDATE和DELETE,以確定是否是表數據的變動操作。這是因為我們只需要捕獲數據的變更,而不關心查詢操作。

如果操作是INSERT或DELETE,我們只需要關註受影響的數據行。對於UPDATE操作,我們需要記錄新舊值的變化。

記憶體中數據組裝:

從解析過的Binlog數據中,我們構建一個記憶體數據結構,通常是一個數據對象,其中包括表名、欄位名、新舊值等信息。這允許我們在記憶體中輕鬆管理和處理數據。

數據序列化:

接下來,我們將記憶體中的數據對象序列化為特定的格式,通常為JSON或XML。這是為了將數據轉化為一種可傳輸的結構,其中包含了表名、欄位名和相應的新舊值。序列化的過程使數據適合通過網路傳輸。

數據傳輸到消息隊列:

完成序列化後,數據通過TCP協議發送到消息隊列,通常是Apache Kafka。消息隊列用於持久性存儲和傳遞數據,以確保數據不會丟失。

數據在消息隊列中等待被消費者處理,這可以是其他系統、應用程式或服務,根據需要對數據進行進一步的分析或存儲。

MongoDB Oplog解析:

MongoDB的日誌解析過程類似於MySQL,但我們使用的是MongoDB的操作日誌(Oplog)來捕獲數據變更。

同樣,我們從Oplog中解析出表名,確定操作類型(INSERT、UPDATE、DELETE),並提取新舊值。

數據消費和存儲:

消費者通過TCP協議從Kafka隊列中拉取數據。消費者可以是各種類型的應用程式或服務,例如數據倉庫、實時監控系統等。

數據可以通過HTTP協議將其寫入Elasticsearch,以進行搜索、分析和可視化。Elasticsearch是一個強大的搜索引擎和分析工具,適用於處理大量數據。

以上流程描述瞭如何從MySQL和MongoDB中的日誌解析數據,將其序列化為可傳輸的格式,並通過消息隊列傳遞到其他系統或存儲庫中,以便進行後續處理、分析和查詢。這種數據管道允許實時捕獲和利用資料庫中的變更,以滿足各種用例和需求。