不知道各位網購的時候,是否會去留意商品評價,有些小伙伴是很在意評價的,看到差評就不想買了,而有些小伙伴則是會對差評進行理性分析,而還有一類人不在乎這個。 當然這都是題外話,咱們今天主要的目的是使用Python來爬取某東商品的評價,並保存到CSV表格。 1、數據採集邏輯 在進行數據採集之前,明確哪些數 ...

不知道各位網購的時候,是否會去留意商品評價,有些小伙伴是很在意評價的,看到差評就不想買了,而有些小伙伴則是會對差評進行理性分析,而還有一類人不在乎這個。

當然這都是題外話,咱們今天主要的目的是使用Python來爬取某東商品的評價,並保存到CSV表格。

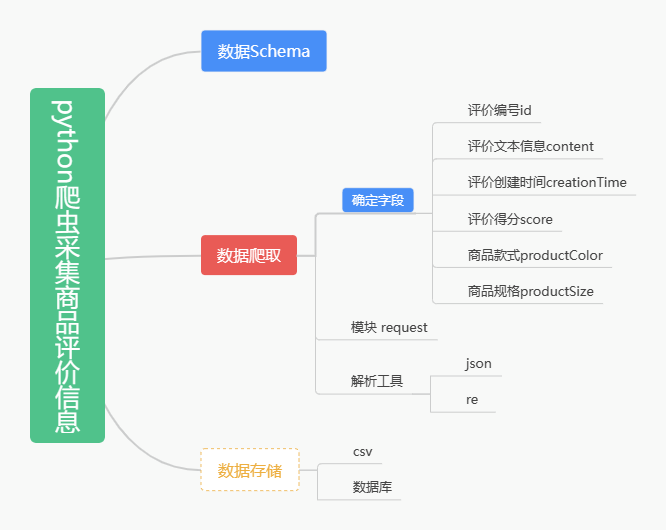

1、數據採集邏輯

在進行數據採集之前,明確哪些數據為所需,制定數據Schema為爬取工作做出要求,並根據數據Schema制定出有針對性的爬取方案和採集邏輯。

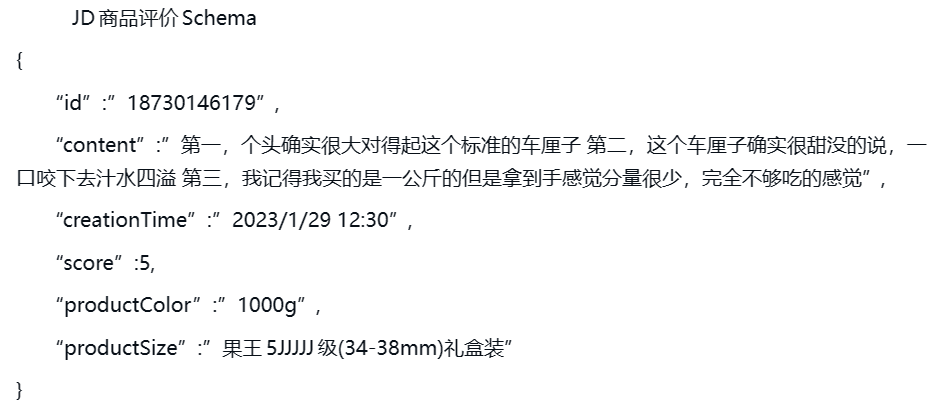

2、數據Schema

3、數據爬取

抓取平臺任一商品的評論信息,此案例抓取的商品是某一店鋪的車釐子評價信息。

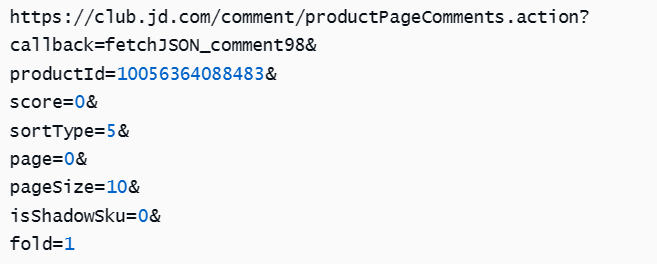

評論信息是由JS動態載入的,所以直接抓取商品詳情頁的URL並不能獲得商品評論信息。因此我們需要先找到存放商品評價信息的文件,通過使用瀏覽器的開發者工具進行查找。

目標URL地址:

通過發現可知,productId為當前商品的商品Id,page為頁碼(從0開始),爬取該商品的所有評價信息只需要改變page參數即可。(商品評價頁只顯示前100頁,所以page最大值為99)

導入庫

import random import requests import json import re import csv import time import pymysql

對爬蟲程式進行偽裝

header = { 'refer': 'https: // item.jd.com /', 'cookie': '', 'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/110.0.0.0 Safari/537.36 Edg/110.0.1587.50' }

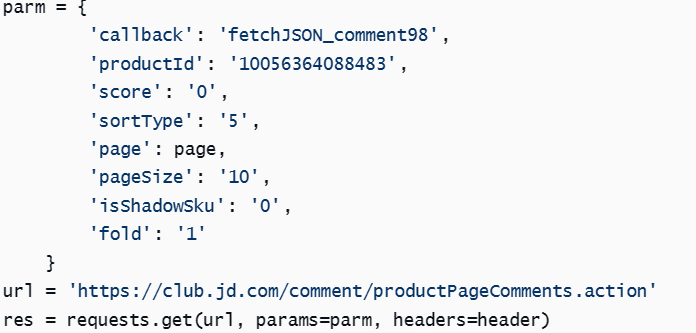

抓取商品評論信息

將python程式偽裝成瀏覽器後,就可以對評論信息進行爬取,在前面的分析中,productId和page為重要參數,在本案例中爬取的商品為車釐子,productId已確定,只需要對page進行更改即可達到需要。通過parms提交參數,使代碼更有邏輯感並方便更改兩個重要參數。

防止反爬,每爬取一頁數據後,設置程式休眠環節。

# 程式休眠 time.sleep(random.randint(40, 80) * 0.1) print('第%d頁正在爬取' % (page + 1)) ''' 爬取完成後,需要對頁面進行編碼,不影響後期的數據提取和數據清洗工作。 使用正則對數據進行提取,返回字元串。 字元串轉換為json格式數據。 ''' res.encoding = 'gb18030' html = res.text data = re.findall('fetchJSON_comment98\((.*?)\);', html) data = json.loads(data[0]) # 將處理的數據進行解析 comments = data['comments'] print(data['comments'])

4、數據存儲

存儲到csv

# 寫入csv文件 f = open("evalution_data.csv", "a", newline='', encoding='gb18030') header = ["id", "content", "creationTime", "score", "productColor", "productSize"] # 創建一個DictWriter對象,第二個參數就是上面創建的表頭 writer = csv.DictWriter(f, header) writer.writeheader() for i in comments: id = i['id'] content = i['content'] creationTime = i['creationTime'] score = i['score'] productColor = i['productColor'] productSize = i['productSize'] writer.writerow( {"id": id, "content": content, "creationTime": creationTime, "score": score, "productColor": productColor, "productSize": productSize}) f.close()

存儲到資料庫

# 寫入資料庫 conn = pymysql.connect(host='', user='', password='', port=, db='') cursor = conn.cursor() for i in comments: id = i['id'] content = i['content'] creationTime = i['creationTime'] score = i['score'] productColor = i['productColor'] productSize = i['productSize'] sql = "insert into evalution_data(id,content,creationTime,score,productColor,productSize) values('%d','%s','%s','%d','%s','%s')" cursor.execute(sql) conn.commit() # 我還專門錄製了視頻講解,以及進行可視化分析,完整代碼和視頻講解都在這個扣裙了:708525271 cursor.close() conn.close()

好了,今天的分享就到這裡結束了,咱們下次見!