有時候會想,如果chatGPT是人,它會是一個怎樣的人呢?下麵是我的推測過程。 首先,她應該是女人 會推測而不會計算 你問它: 3457 * 43216 = ,它回答 149261912 (這是錯的。正確結果是 149397712)。 之所以結果的 2 是對的,僅僅因為它讀了太多的文字資料以後,隱約 ...

有時候會想,如果chatGPT是人,它會是一個怎樣的人呢?下麵是我的推測過程。

首先,她應該是女人

會推測而不會計算

你問它: 3457 * 43216 = ,它回答 149261912 (這是錯的。正確結果是 149397712)。

之所以結果的 2 是對的,僅僅因為它讀了太多的文字資料以後,隱約感覺到 7 結尾的文字,乘號,6 結尾的文字,和 2 結尾的文字比較「押韻」從語感上比較像一首詩。

所以它就學會了這樣的文字,而不是學會了計算。

感性而不理性

有沒有覺得,當自己跟老婆吵架時,你講什麼正確的道理都是徒勞,她不在乎對錯而在於你有沒有顧及她的感受。這印證《男人來自火星,女人來自金星》中說到的一個觀點:男人和女人在思維理解上有本質的不同,男人註重理性,女人註重感性。

沒錯,chatGPT不擅長理性計算,在背誦了一堆堆文字資料後,她覺得”順口”就認為是對的答案,就是這麼任性就是這麼感性。

所以,ChatGPT肯定是記憶力超強,天生對數字邏輯一竅不通的女人。

其次,她有工作經驗且善解人意

預訓練:增加工作經驗

舉個慄子:家裡請阿姨,來你家之前阿姨會接受家政公司的崗前培訓,怎麼拖地,怎麼弄飯,包括怎麼帶小孩,這樣保證了阿姨到雇主家可直接幹活。

ChatGPT一開始就知道客觀既定的自然規律,比如蘋果是水果而不是石頭。原因是在被使用之前它經過了崗前培訓,也就是GPT中的P(Pre-trained 預訓練和微調),保證它可以直接上手就乾,而不是磨磨唧唧等你教完它所有之後才會幹活。

預訓練是給ChatGPT提供基礎技能,讓其有工作經驗,直接上手就乾,節約使用者成本。

微調:讓她善解人意

舉個慄子:還是上面那個阿姨。

上崗後,阿姨的技能和習慣可能跟雇主的不一樣,比如雇主要減肥,做飯就不做三菜一湯了,全部變青菜,不要白米飯要西藍花,OK , 三菜一湯是預訓練的標配結果,全部青菜是根據雇主習慣進行的微調。微調讓chatGPT更加符合自己口味了。

再比如:如果你要問chatGPT 你公司年假多少?他肯定回答不出來。

但是如果給他錄入你公司考勤制度信息之後,它就知道你公司年假多少了。這個過程就是微調。

微調是給模型提供使用者個性化信息,讓其與使用者更加同頻,給使用者感覺是,它知我,知己也!

再次,她是語言學家

當你用不同語言時,她知道用對應語言你。

當你覺得文字太長,她可以幫你變短。

當你想要她翻譯成別的語言,她可以翻譯成外語。

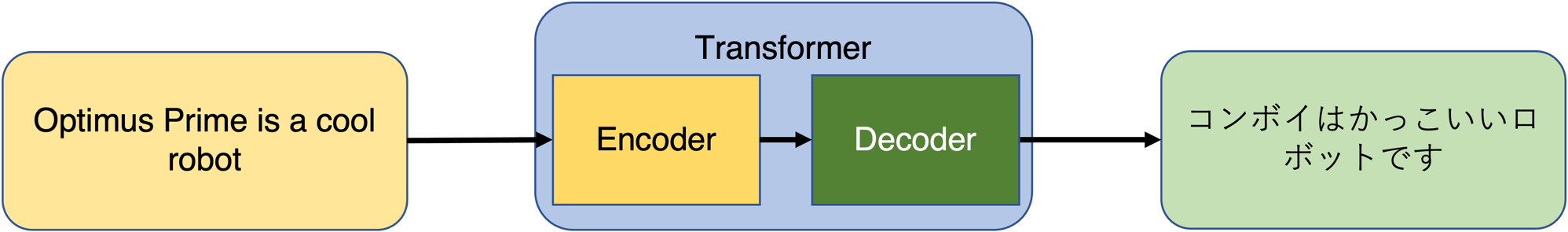

這其中歸功於GPT中的T:Transformer轉換器。該模塊作用類似電源轉換器: 220v進12v出

轉換器模塊工作流程:轉換器依據預訓練中的經驗,將輸入轉換成向量表示,該向量中包含了上下文,輸入含義等信息(類似二維碼)。向量可以看做GPT可識別的數據結構,當使用者提出不同需求時,轉換器根據該向量變換生成新的輸出。

如圖中,輸入經過Encoder編碼成向量,向量根據用戶需求Decoder成不同長度,語言的輸出。

轉換器實現將固定輸入轉換成各種不同輸出的功能。

最後

本文結合生活中的例子推測 ChatGPT 是怎樣的人。ChatGPT 中實際過程比這個複雜得多,其過程可能不嚴謹,但旨在對 ChatGPT 中 G P T 含義進行通俗化解釋,希望各位大佬喜歡。

彩蛋

參考鏈接

Transformers Models in Machine Learning: Self-Attention to the Rescue