一、初識爬蟲,requests使用 requests介紹: Request支持HTTP連接保持和連接池,支持使用cookie保持會話,支持文件上傳,支持自動響應內容的編碼,支持國際化的URL和POST數據自動編碼。requests會自動實現持久連接keep-alive # 導入模塊 import r ...

一、初識爬蟲,requests使用

requests介紹:

Request支持HTTP連接保持和連接池,支持使用cookie保持會話,支持文件上傳,支持自動響應內容的編碼,支持國際化的URL和POST數據自動編碼。requests會自動實現持久連接keep-alive

# 導入模塊

import requests

# 目標URL

url = 'https://www.sogou.com/'

response = requests.get(url=url) # 發起請求,並接受

# 接受的頁面進行解析

page_text = response.text

# 列印出來

print(page_text)

# 保存到本地

with open('sogou.html', 'w', encoding='utf-8') as fp:

fp.write(page_text)

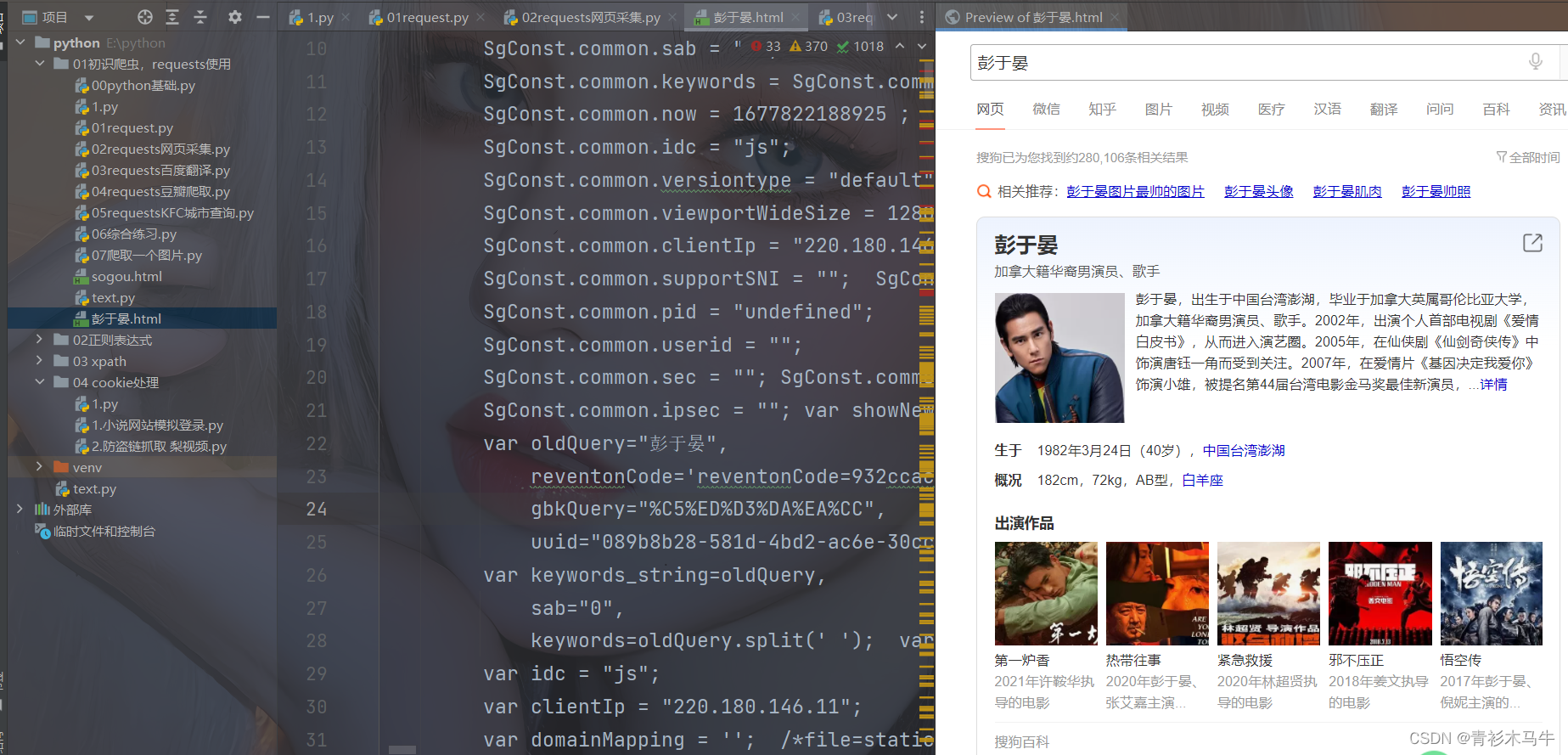

print("結束")二、網頁採集案列:搜狗爬取人物信息

# 導入模塊,輸入url

import requests

url = 'https://www.sogou.com/web?'

# 模擬瀏覽器UA,防止被髮現是個爬蟲

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/106.0.0.0 Safari/537.36)'

}

# 輸入提示框(要搜索的東西)

name = input("輸入一個人名:")

# 構造payload,模擬真實數據包

param = {

'type': 'getpinyin',

'query': name

}

# 發起請求並接受請求到的內容

response = requests.get(url, params=param, headers=headers)

# 文本方式讀取

page_txt = response.text

# 保存網頁

filename = name + '.html'

with open(filename, 'w', encoding='utf-8') as fp:

fp.write(page_txt)

print("succeed")