在數倉項目中,我們常常會選擇Apache Atlas進行數據的治理。本文結合筆者在生產環境中遇到的常見問題及解決方法,整合出完整的Atlas編譯、部署及使用過程。 ...

1、編譯階段

組件信息:

| 組件名稱 | 版本 |

|---|---|

| Atals | 2.2.0 |

| HBase | 2.2.6 |

| Hive | 3.1.2 |

| Hadoop | 3.1.1 |

| Kafka | 2.11_2.4.1 |

| Zookeeper | 3.6.2 |

| ElasticSearch | 7.12.1 |

架構: x86 (已知arm編譯時會報node-sass缺少的問題,git上沒有對應arm架構的包)

操作系統:CentOS 7.6

說明:

1、編譯不包括其內嵌的HBase和Solr,只編譯Atlas本身

2、下麵的步驟中有些並非編譯過程報錯,而是具體使用中或導入hive元數據時報的錯,提前修改

步驟:

step1:官網下載Atlas-2.2.0源碼,解壓

step2:配個國內源。可以在maven的conf目錄下settings.xml里配置,也可以在項目的pom.xml里配置,這裡貼阿裡源做參考

step3:提前從Here下一個nodejs的包放到maven倉庫下,目錄參考

$MAVEN_REPOSITORY/com/github/eirslett/node/12.16.0/node-12.16.0-linux-x64.tar.gz

註意下下來的包名字叫node-v12.16.0-linux-x64.tar.gz,放在maven倉庫里的時候要把裡面的v去掉。如果不提前下,編譯時候自己下載的速度很慢

step4:主pom.xml里添加下麵兩個依賴

<dependency>

<groupId>org.restlet.jee</groupId>

<artifactId>org.restlet</artifactId>

<version>2.4.0</version>

</dependency>

<dependency>

<groupId>org.restlet.jee</groupId>

<artifactId>org.restlet.ext.servlet</artifactId>

<version>2.4.0</version>

</dependency>

step5:修改./intg/src/main/java/org/apache/atlas/ApplicationProperties.java

註釋掉line 365 LOG.info("Setting " + SOLR_WAIT_SEARCHER_CONF + " = " + getBoolean(SOLR_WAIT_SEARCHER_CONF));

這步是因為我們採用es作為查詢引擎,solr的相關配置都會註釋掉,而這行調用會在導入hive元數據的時候報錯

step6:把項目里的jsr311-api改成javax.ws.rs-api (6處,可以直接在項目目錄下grep -rn搜), 並修改主pom.xml中jsr.version為2.0.1

這步主要影響六個支持的組件的數據導入及後續,包括

hbase、hive、sqoop、impala、falcon、storm

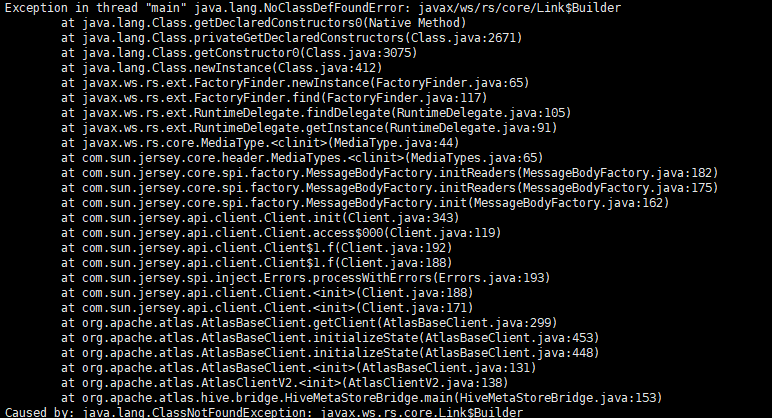

主要原因:jsr311-api包中javax.ws.rs.core包中沒有Link類,而Atlas以HBase作為元數據存儲,HBase本身使用的為javax.ws.rs-api包中的core包,其中有Link類,所以調用腳本導入數據時會報以下錯誤

step7:執行編譯命令mvn clean package -DskipTests -Drat.skip=true -Pdist

編譯後的包在./distro/target目下,server包即為Atlas部署包,bin包為集成了常用hook(如hbase-hook)的部署包

2、部署階段

前置條件:

集群內有正常運行且可用的hadoop、hive、hbase、kafka、zk、es,且atlas所在節點必須有hbase及hive的配置文件目錄

步驟:

step1:解壓atlas-bin包(這裡以/data/apps為例,順便改個名

tar -zxvf apache-atlas-2.2.0-bin.tar.gz -C /data/apps

mv apache-atlas-2.2.0 atlas-2.2.0

step2:解壓hook包(這裡以hive-hook為例),並拷貝內容到atlas安裝目錄下

tar -zxvf apache-atlas-2.2.0-hive-hook.tar.gz -C /data/apps/

/usr/bin/cp /data/apps/apache-atlas-hive-hook-2.2.0/* /data/apps/atlas-2.2.0/

step3:修改atlas配置文件(有的配置是已有的,修改即可;有的配置沒有,需要加)

atlas-application.properties:

#atlas server config

atlas.rest.address=http://atlas-ip:21000

atlas.server.run.setup.on.start=false

#hbase config

atlas.audit.hbase.tablename=apache_atlas_entiry_audit

atuls.audit.zookeeper.session.timeout.ms=1000

atlas.audit.hbase.zookeeper.quorum=zk地址

atlas.graph.storage.hostname=zk地址

#solr config

#註釋掉所有和solr相關的配置項

#es config

atlas.graph.index.search.backend=elasticsearch

atlas.graph.index.search.hostname=es-ip:9200

atlas.graph.index.search.elasticsearch.client-only=true

atlas.graph.index.search.elasticsearch.http.auth.type=basic

atlas.graph.index.search.elasticsearch.http.auth.basic.username=elastic

atlas.graph.index.search.elasticsearch.http.auth.basic.password=Cestc!666

#kafka config

atlas.nofification.embedded=false

atlas.kafka.data=/data/log/kafka

atlas.kafka.zookeeper.connect=zk地址/kafkaCluster

atlas.kafka.bootstrap.servers=kafka地址

#hive config

atlas.hook.hive.numRetries=3

atlas.hook.hive.queueSize=10000

atlas.cluster.name=primary

atlas-env.sh:

export HBASE_CONF_DIR=/data/apps/hbase-2.2.6/conf

atlas-log4j.xml:

#去掉org.apache.log4j.DailyRollingFileAppender一塊的註釋來暴露性能指標

step4:將atlas-application.properties分發到所有hive所在節點的hive/conf目錄下

step5:分發hive-hook目錄到hive節點下,並修改hive配置文件

ssh hive-node "mkdir -p /data/apps/atlas-2.2.0/hook"

scp -r /data/apps/atlas-2.2.0/hook/hive hive-node:$PWD

hive-site.xml

<property>

<name>hive.exec.post.hooks</name>

<value>org.apache.atlas.hive.hook.HiveHook</value>

</property>

hive-env.sh

export HIVE_AUX_JARS_PATH=/data/apps/atlas-2.2.0/hook/hive

step6:重啟Hive

step7:調用atlas啟動腳本啟動服務

$ATLAS_HONE/bin/atlas_start.py

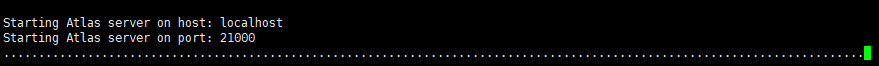

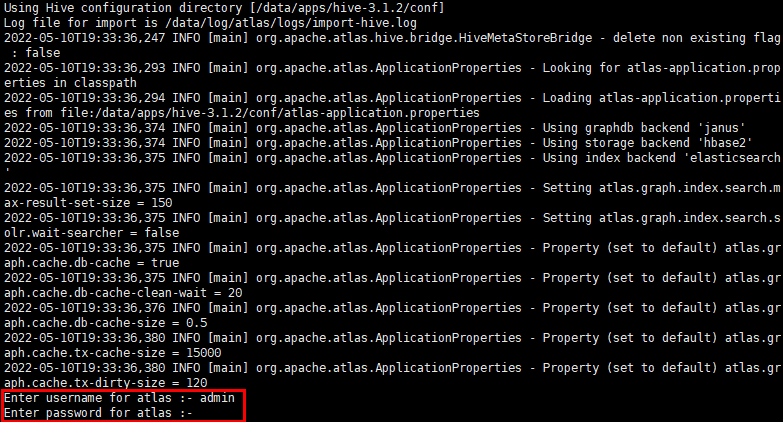

啟動過程如下圖所示

該過程會耗時較久,包含index創建、數據的初始化等操作

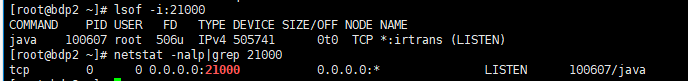

此時可以跟一下atlas的啟動日誌,直到日誌不再刷新,再lsof或netstat查一下21000是否已經監聽了,如已存在,則打開瀏覽器輸入ip:21000登錄atlas頁面

千萬不要相信他提示的Apache Atlas Server started!!!和jps顯示的Atlas進程,因為啟動腳本超過一定時間後一定會報成功,但此時21000埠還未被監聽,服務是不可用的,真正可用還是以21000被成功監聽,可以進到Atlas登錄頁面為準

3、使用階段

說明:

此處我們以Hive的元數據導入及使用為例,其它數據源使用類似

步驟:

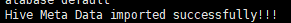

step1:進入atlas安裝目錄下,執行hook-bin中的import-hive.sh腳本

$ATLAS_HOME/hook-bin/import-hive.sh

執行後如下圖

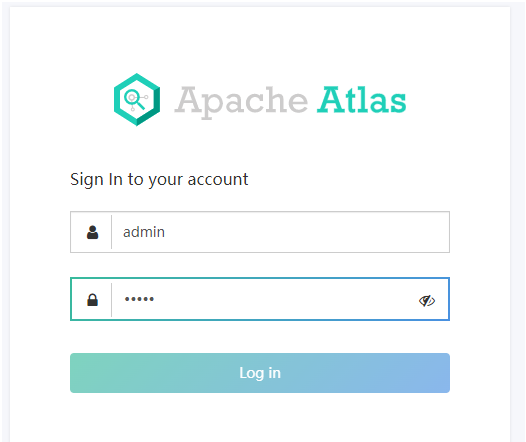

過程中會提示輸入atlas用戶名和密碼,都輸入admin即可

成功後會提示

該過程時間視hive現有數據量大小而定

step2:登錄Atlas Web頁面

打開瀏覽器輸入ip:21000登錄atlas頁面

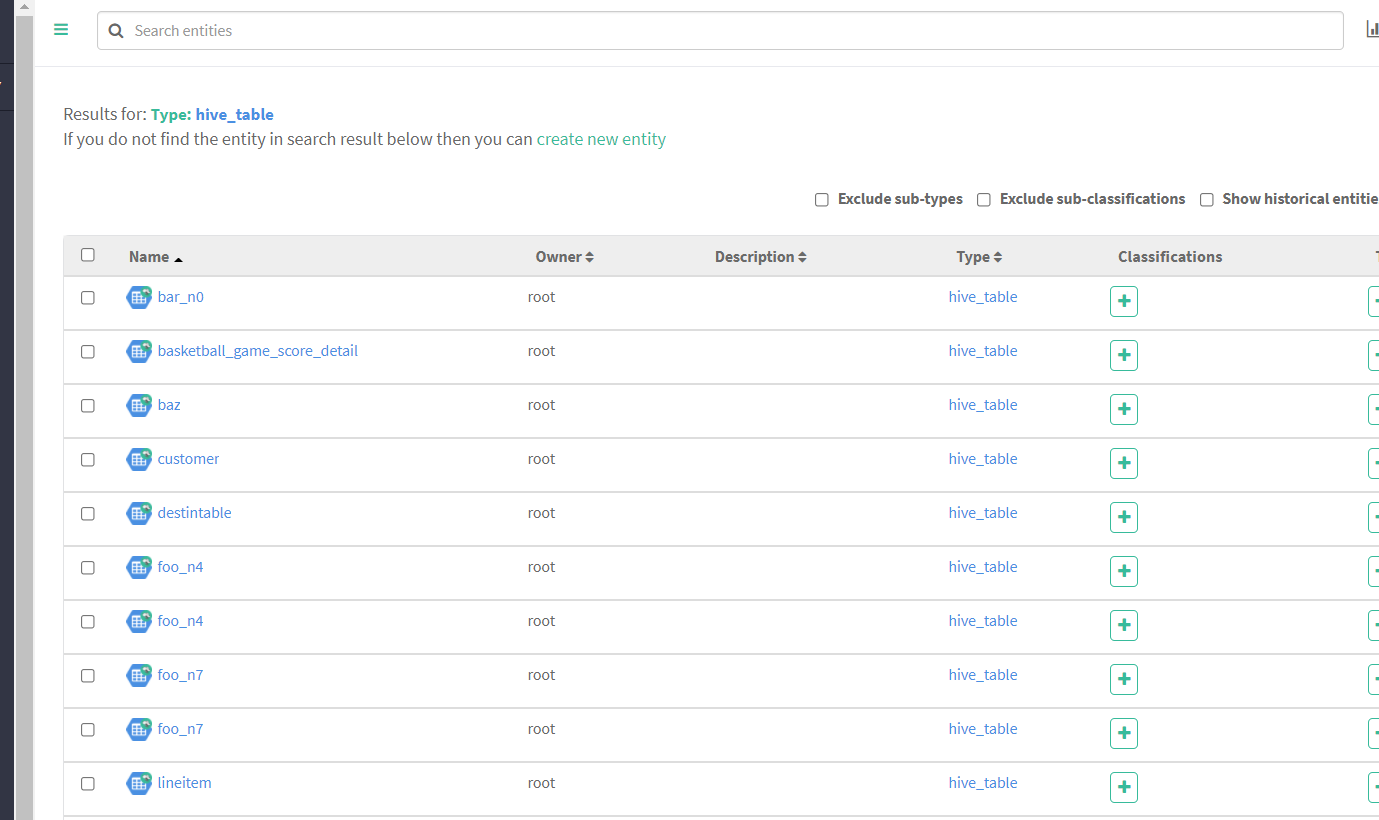

登錄後如下圖

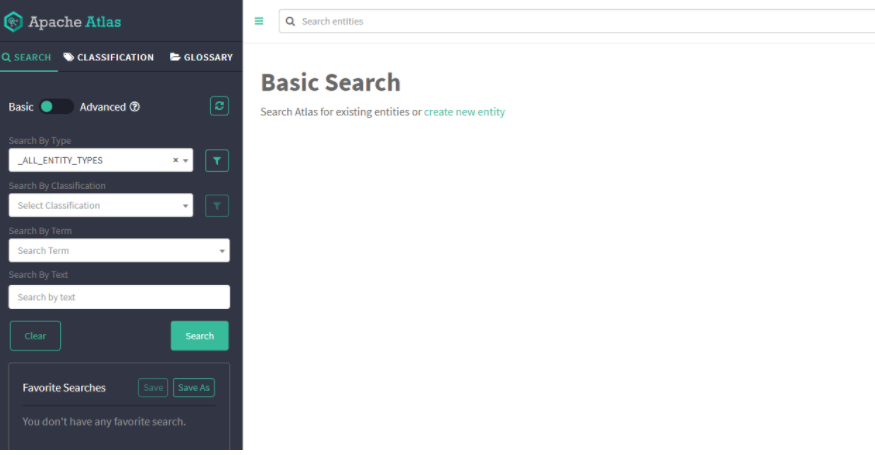

此時可以點擊右上角小圖標

查看總體數據情況

查看所有hive表

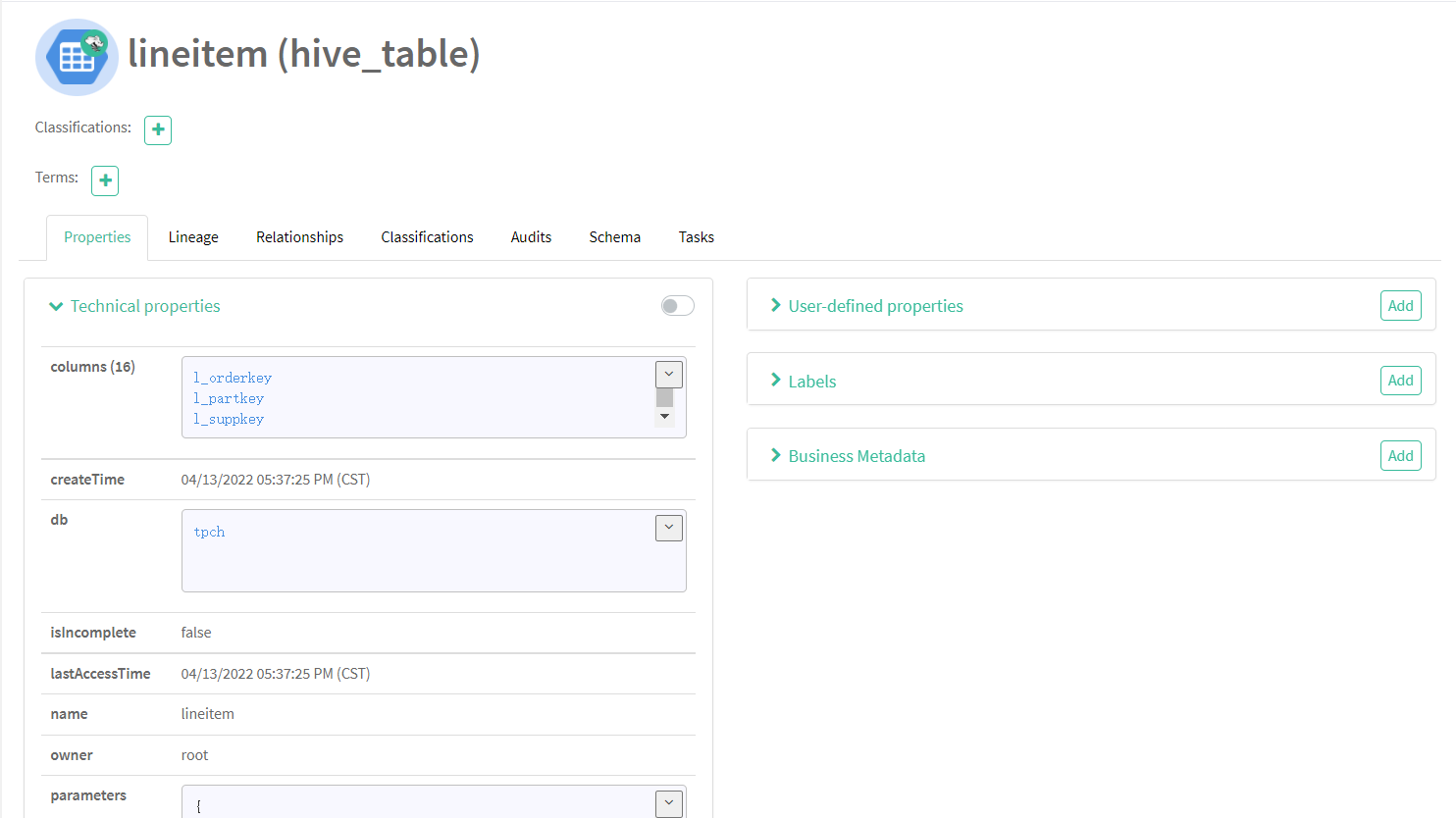

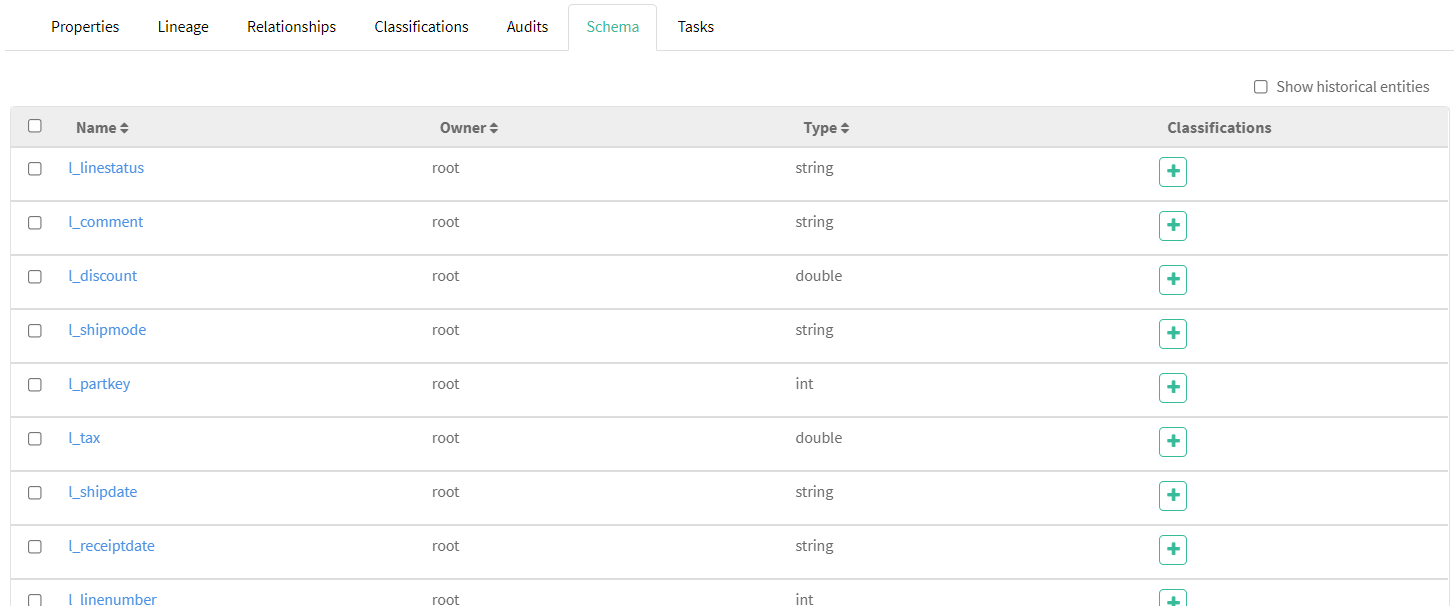

隨便點擊一個表查看詳情

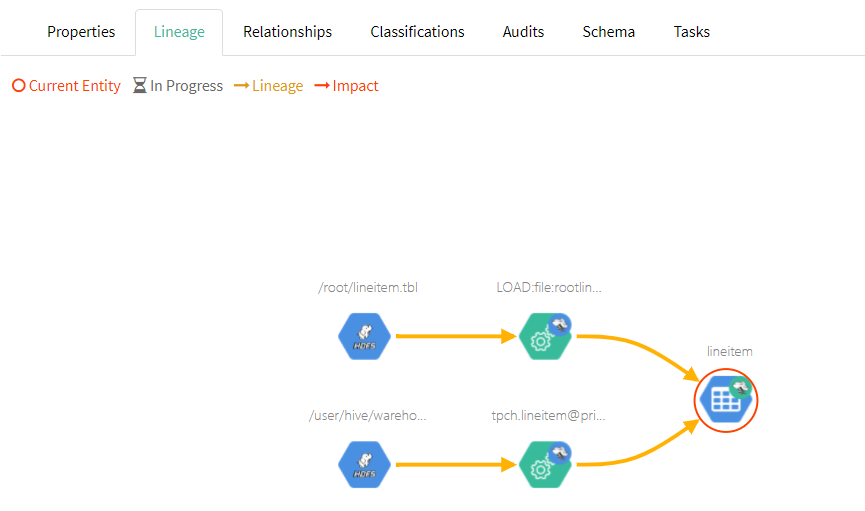

可以清楚地看到這個表的各項信息、欄位及血緣圖等

我們也可以通過左側搜索欄檢索過濾想要查找的項

以上就是我在生產環境中部署Atlas-2.2.0並集成es、hive的過程,使用時可以點擊頁面操作,也可通過調用Rest API集成到自己系統里用

本文首發於博客園,作者榆天紫夏,希望對大家有所幫助。原文地址https://www.cnblogs.com/yutianzixia/p/16257916.html。如有遺漏或問題歡迎補充指正

本文來自博客園,作者:榆天紫夏,轉載請註明原文鏈接:https://www.cnblogs.com/yutianzixia/p/16257916.html