一:創建maven項目 導入maven <dependencies> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-hdfs</artifactId> <version>2.7.6</version> </d ...

一:創建maven項目

導入maven

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.6</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.zookeeper/zookeeper -->

<!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-common -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.6</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-client -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.6</version>

</dependency>

<!-- https://mvnrepository.com/artifact/junit/junit -->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

</dependency>

</dependencies>

junit是測試塊的包

其他三個是hdfs連接需要的包

二:winuti處理(如果有就不需要處理)

1.解壓hadoop-2.6.1到D盤 2.配置環境變數 配置變數的(https://jingyan.baidu.com/article/47a29f24610740c0142399ea.html)二:相關操作

1:目錄操作

相關操作:1:mkdirs 創建目錄。

2:delete 刪除文件或目錄。

3:listStatus 列出目錄的內容。

4:getFileStatus 顯示文件系統的目錄和文件的元數據信息。

5:getFileBlockLocations 顯示文件存儲位置

(1:創建一個目錄

import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; import org.junit.Before; import org.junit.Test; import java.io.IOException; import java.net.URI; import java.net.URISyntaxException; public class Test1 { FileSystem fs; @Before public void conn() throws URISyntaxException, IOException { //hadoop配置文件,自動獲取hadoop的hdfs配置文件 Configuration conf = new Configuration(); conf.set("dfs.replication", "1");//設置副本數為一 //創建url 9000是埠號配置文件中有,master是主機名,如果沒有配置映射可以是ip地址 URI uri = new URI("hdfs://master:9000"); //等同於客戶端 fs = FileSystem.get(uri, conf); } @Test public void mkdir() throws IOException { //創建一個Path對象傳入想要創建hdfs的路徑 Path path = new Path("/data1"); //判斷是否存在要是存在就刪除,以免報錯 if(fs.exists(path)){ fs.delete(path); } //創建目錄 fs.mkdirs(path); } }

可以通過web界面查看有沒有創建成功(master:50070)

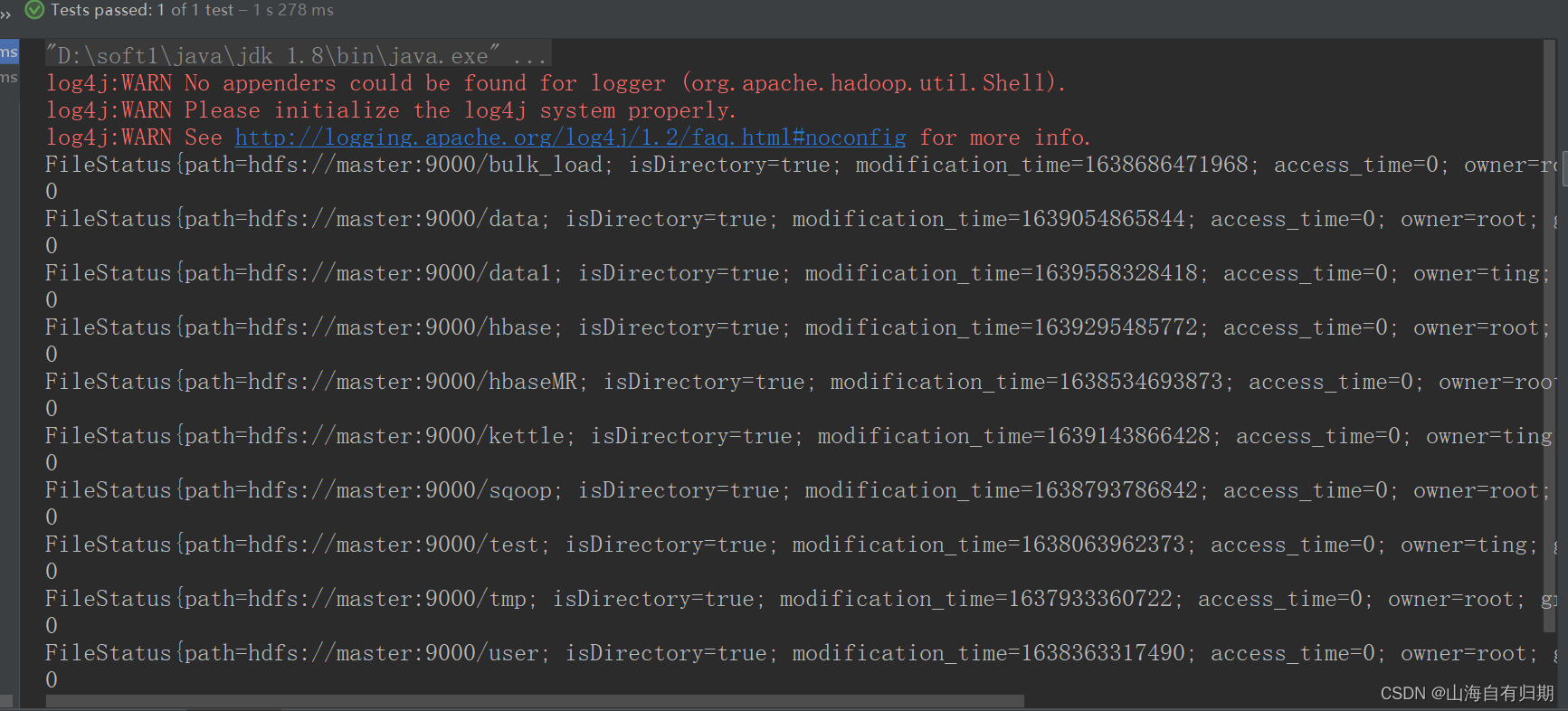

(2:獲取獲取文件列表

@Test public void filestatus() throws IOException { //獲取根目錄下的文件列表 FileStatus[] fileStatuses = fs.listStatus(new Path("/")); //遍歷 fileStatuses for (FileStatus fileStatus : fileStatuses) { System.out.println(fileStatus); }

三:關於測試包

我用的junit測試,可以不用main方法需要運行哪個就運行哪個,每個@Test前面都有一個運行的一個@Test對應一個方法(函數),還有@Before,@After等。@Before是運行每個@Test之前都會運行,常用來做連接。@After相反是運行每個@Test之後都會運行常用在關閉連接的方法前面。

(原文鏈接:https://blog.csdn.net/weixin_50691399/article/details/121955946)

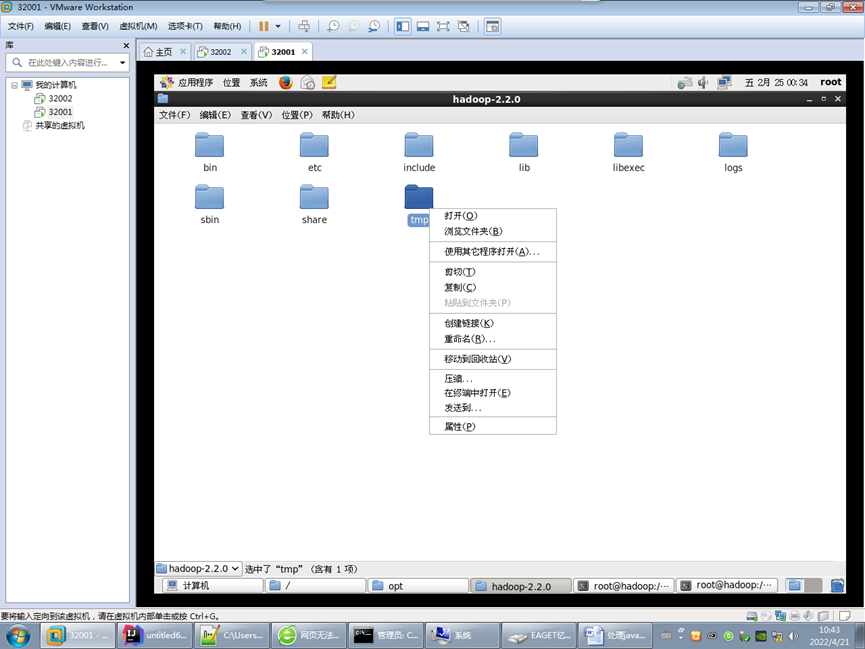

四:連接不上的問題

1.刪除tmp

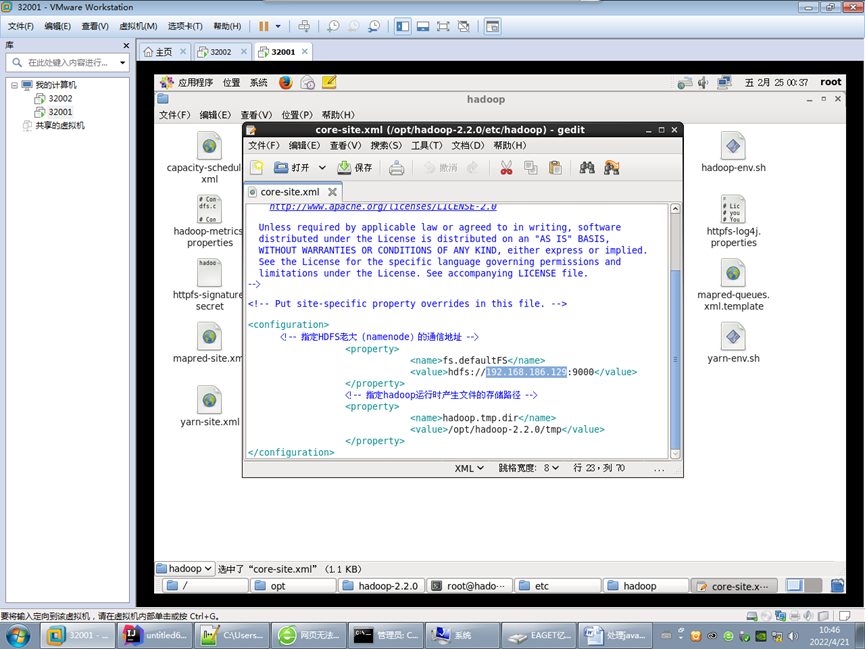

2.修改配置

修改namenode的地址為具體IP (之前寫的localhost)

修改slaves文件,為具體IP

3. 格式化hdfs

hadoop namenode –format

4.啟動HDFS

start-dfs.sh