簡要記錄下本次實驗作業的內容和總結。 實驗1 1. 題目描述 實驗1. 利用自定義函數求所有水仙花數,並用逗號隔開輸出。 所謂水仙花數是一個三位數,其每位上的數字的立方和等於其本身, 如153=13+53+3^3 故153是水仙花數。 2.代碼實現: def flowerNumer(n): n1 = ...

整個數據獲取的信息是通過房源平臺獲取的,通過下載網頁元素併進行數據提取分析完成整個過程。

導入相關的網頁下載、數據解析、數據處理庫

from fake_useragent import UserAgent # 身份信息生成庫

from bs4 import BeautifulSoup # 網頁元素解析庫

import numpy as np # 科學計算庫

import requests # 網頁下載庫

from requests.exceptions import RequestException # 網路請求異常庫

import pandas as pd # 數據處理庫

然後,在開始之前初始化一個身份信息生成的對象,用於後面隨機生成網頁下載時的身份信息。

user_agent = UserAgent()

編寫一個網頁下載函數get_html_txt,從相應的url地址下載網頁的html文本。

def get_html_txt(url, page_index):

'''

獲取網頁html文本信息

:param url: 爬取地址

:param page_index:當前頁數

:return:

'''

try:

headers = {

'user-agent': user_agent.random

}

response = requests.request("GET", url, headers=headers, timeout=10)

html_txt = response.text

return html_txt

except RequestException as e:

print('獲取第{0}頁網頁元素失敗!'.format(page_index))

return ''

編寫網頁元素處理函數catch_html_data,用於解析網頁元素,並將解析後的數據元素保存到csv文件中。

def catch_html_data(url, page_index):

'''

處理網頁元素數據

:param url: 爬蟲地址

:param page_index:

:return:

'''

# 下載網頁元素

html_txt = str(get_html_txt(url, page_index))

if html_txt.strip() != '':

# 初始化網頁元素對象

beautifulSoup = BeautifulSoup(html_txt, 'lxml')

# 解析房源列表

h_list = beautifulSoup.select('.resblock-list-wrapper li')

# 遍歷當前房源的詳細信息

for n in range(len(h_list)):

h_detail = h_list[n]

# 提取房源名稱

h_detail_name = h_detail.select('.resblock-name a.name')

h_detail_name = [m.get_text() for m in h_detail_name]

h_detail_name = ' '.join(map(str, h_detail_name))

# 提取房源類型

h_detail_type = h_detail.select('.resblock-name span.resblock-type')

h_detail_type = [m.get_text() for m in h_detail_type]

h_detail_type = ' '.join(map(str, h_detail_type))

# 提取房源銷售狀態

h_detail_status = h_detail.select('.resblock-name span.sale-status')

h_detail_status = [m.get_text() for m in h_detail_status]

h_detail_status = ' '.join(map(str, h_detail_status))

# 提取房源單價信息

h_detail_price = h_detail.select('.resblock-price .main-price .number')

h_detail_price = [m.get_text() for m in h_detail_price]

h_detail_price = ' '.join(map(str, h_detail_price))

# 提取房源總價信息

h_detail_total_price = h_detail.select('.resblock-price .second')

h_detail_total_price = [m.get_text() for m in h_detail_total_price]

h_detail_total_price = ' '.join(map(str, h_detail_total_price))

h_info = [h_detail_name, h_detail_type, h_detail_status, h_detail_price, h_detail_total_price]

h_info = np.array(h_info)

h_info = h_info.reshape(-1, 5)

h_info = pd.DataFrame(h_info, columns=['房源名稱', '房源類型', '房源狀態', '房源均價', '房源總價'])

h_info.to_csv('北京房源信息.csv', mode='a+', index=False, header=False)

print('第{0}頁房源信息數據存儲成功!'.format(page_index))

else:

print('網頁元素解析失敗!')

編寫多線程處理函數,初始化網路網頁下載地址,並使用多線程啟動調用業務處理函數catch_html_data,啟動線程完成整個業務流程。

import threading # 導入線程處理模塊

def thread_catch():

'''

線程處理函數

:return:

'''

for num in range(1, 50, 3):

url_pre = "https://bj.fang.lianjia.com/loupan/pg{0}/".format(str(num))

url_cur = "https://bj.fang.lianjia.com/loupan/pg{0}/".format(str(num + 1))

url_aft = "https://bj.fang.lianjia.com/loupan/pg{0}/".format(str(num + 2))

thread_pre = threading.Thread(target=catch_html_data, args=(url_pre, num))

thread_cur = threading.Thread(target=catch_html_data, args=(url_cur, num + 1))

thread_aft = threading.Thread(target=catch_html_data, args=(url_aft, num + 2))

thread_pre.start()

thread_cur.start()

thread_aft.start()

thread_catch()

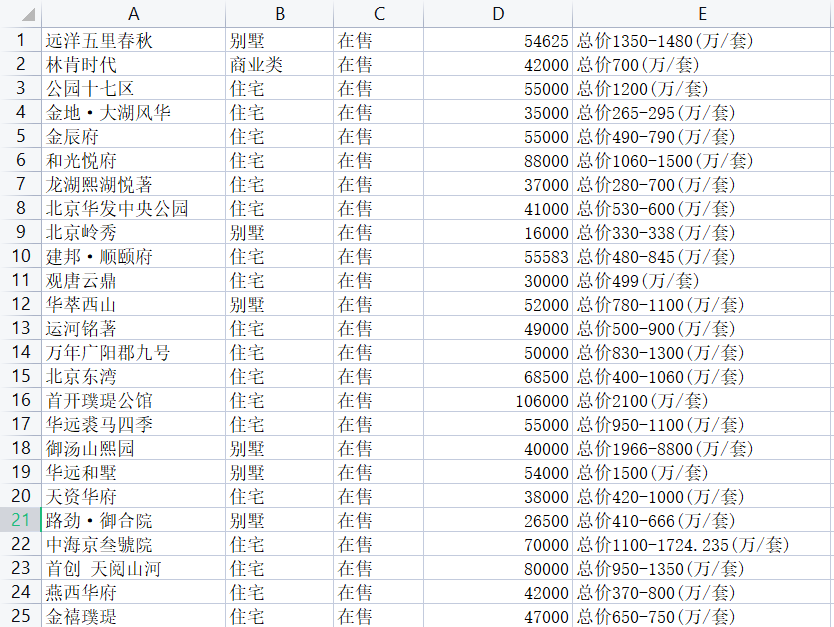

數據存儲結果展示效果

【往期精彩】

辦公自動化:Image圖片轉換成PDF文檔存儲...

python做一個微型美顏圖片處理器,十行代碼即可完成...

用python做一個文本翻譯器,自動將中文翻譯成英文,超方便的!

小王,給這2000個客戶發一下節日祝福的郵件...

python 一行命令開啟網路間的文件共用...

PyQt5 批量刪除 Excel 重覆數據,多個文件、自定義重覆項一鍵刪除...

再見XShell,這款國人開源的終端命令行工具更nice!

python 表情包下載器,輕鬆下載上萬個表情包、鬥圖不用愁...

Python 自動清理電腦垃圾文件,一鍵啟動即可...

有了jmespath,處理python中的json數據就變成了一種享受...

解鎖一個新技能,如何在Python代碼中使用表情包...

萬能的list列表,python中的堆棧、隊列實現全靠它!

歡迎關註作者公眾號【Python 集中營】,專註於後端編程,每天更新技術乾貨,不定時分享各類資料!