一 統一日誌管理 1.1 日誌管理 在Kubernetes集群環境中,一個完整的應用或服務都會涉及為數眾多的組件運行,各組件所在的Node及實例數量都是可變的。日誌子系統如果不做集中化管理,則會給系統的運維支撐造成很大的困難,因此建議在集群層面對日誌進行統一收集和檢索等工作。 在容器中輸出到控制台的 ...

一 統一日誌管理

1.1 日誌管理

在Kubernetes集群環境中,一個完整的應用或服務都會涉及為數眾多的組件運行,各組件所在的Node及實例數量都是可變的。日誌子系統如果不做集中化管理,則會給系統的運維支撐造成很大的困難,因此建議在集群層面對日誌進行統一收集和檢索等工作。 在容器中輸出到控制台的日誌,都會以*-json.log的命名方式保存在/var/lib/docker/containers/目錄下。 Kubernetes推薦採用Fluentd+Elasticsearch+Kibana完成對系統和容器日誌的採集、查詢和展現工作。 部署統一的日誌管理系統,需要以下兩個前提條件。- API Server正確配置了CA證書。

- DNS服務啟動、運行。

1.2 EFK簡介

Kubernetes 開發了一個 Elasticsearch 附加組件來實現集群的日誌管理。這是一個 Elasticsearch、Fluentd 和 Kibana 的組合。- Elasticsearch 是一個搜索引擎,負責存儲日誌並提供查詢介面;

- Fluentd 負責從 Kubernetes 搜集日誌,每個node節點上面的fluentd監控並收集該節點上面的系統日誌,並將處理過後的日誌信息發送給Elasticsearch;

- Kibana 提供了一個 Web GUI,用戶可以瀏覽和搜索存儲在 Elasticsearch 中的日誌。

在各Node上都運行了一個Fluentd容器,採集本節點/var/log和/var/lib/docker/containers兩個目錄下的日誌進程,將其彙總到Elasticsearch集群,最終通過Kibana完成和用戶的交互工作。因此Fluentd必須在每個Node上運行。為了滿足這一需求,可通過以下幾種方式部署Fluentd。

在各Node上都運行了一個Fluentd容器,採集本節點/var/log和/var/lib/docker/containers兩個目錄下的日誌進程,將其彙總到Elasticsearch集群,最終通過Kibana完成和用戶的交互工作。因此Fluentd必須在每個Node上運行。為了滿足這一需求,可通過以下幾種方式部署Fluentd。

- 直接在Node主機上部署Fluentd。

- 利用kubelet的--config參數, 為每個Node都載入Fluentd Pod。

- 利用DaemonSet讓Fluentd Pod在每個Node上運行。

二 EFK部署

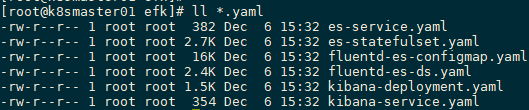

2.1 獲取EFK yaml

lasticsearch 附加組件本身會作為 Kubernetes 的應用在集群里運行,其 YAML 配置文件可從kubernetes官方github倉庫獲取: https://github.com/kubernetes/kubernetes/tree/master/cluster/addons/fluentd-elasticsearch [root@k8smaster01 ~]# mkdir efk [root@k8smaster01 ~]# cd efk [root@k8smaster01 efk]# ll *.yaml

2.2 修改鏡像

對於部分鏡像,建議通過修改鏡像從國內源進行下載,國內相關源參考: [root@k8smaster01 efk]# sed -i "s/quay.io/quay.azk8s.cn/g" `grep quay.io -rl ./*` 提示:國內相關源參考:https://blog.csdn.net/networken/article/details/84571373。 2.3 部署Elasticsearch [root@k8smaster01 efk]# vi es-statefulset.yaml1 …… 2 resources: 3 # need more cpu upon initialization, therefore burstable class 4 limits: 5 cpu: 1000m 6 memory: 600Mi #建議將記憶體調小,避免Node節點資源不夠 7 requests: 8 cpu: 100m 9 memory: 600Mi #建議將記憶體調小,避免Node節點資源不夠 10 ……[root@k8smaster01 efk]# kubectl create -f es-statefulset.yaml

2.4 部署Elasticsearch SVC

[root@k8smaster01 efk]# kubectl create -f es-service.yaml2.5 部署fluentd

[root@k8smaster01 efk]# kubectl create -f fluentd-es-configmap.yaml #創建fluentd ConfigMap [root@k8smaster01 efk]# kubectl create -f fluentd-es-ds.yaml #部署fluentd2.6 部署Kibana

[root@k8smaster01 efk]# vi kibana-deployment.yaml1 …… 2 env: 3 - name: ELASTICSEARCH_HOSTS 4 value: http://elasticsearch-logging:9200 5 # - name: SERVER_NAME 6 # value: kibana-logging 7 # - name: SERVER_BASEPATH 8 # value: /api/v1/namespaces/kube-system/services/kibana-logging/proxy 9 # - name: SERVER_REWRITEBASEPATH 10 # value: "false" 11 ……提示:kibana使用Nodeport之後,若直接使用Nodeport連接,會報404 status 錯誤,因為啟動參數中添加了server.basePath,那麼一般是需要在前端做一個反向代理來重定向。因此在kibana的yaml文件中刪除SERVER_BASEPATH該環境變數後,才可以正常訪問。 [root@k8smaster01 efk]# kubectl create -f kibana-deployment.yaml

2.7 部署Kibana SVC

[root@k8smaster01 efk]# vi kibana-service.yaml1 apiVersion: v1 2 kind: Service 3 metadata: 4 name: kibana-logging 5 namespace: kube-system 6 labels: 7 k8s-app: kibana-logging 8 kubernetes.io/cluster-service: "true" 9 addonmanager.kubernetes.io/mode: Reconcile 10 kubernetes.io/name: "Kibana" 11 spec: 12 type: NodePort #模式為NodePort 13 ports: 14 - port: 5601 15 protocol: TCP 16 targetPort: ui 17 selector: 18 k8s-app: kibana-logging[root@k8smaster01 efk]# kubectl create -f kibana-service.yaml

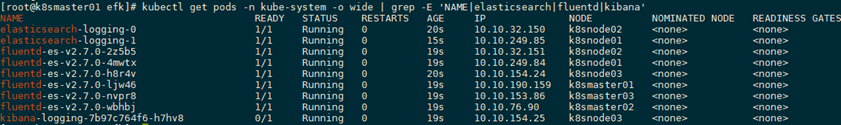

2.8 查看資源

[root@k8smaster01 efk]# kubectl get pods -n kube-system -o wide | grep -E 'NAME|elasticsearch|fluentd|kibana' [root@k8smaster01 efk]# kubectl get svc -n kube-system -o wide | grep -E 'NAME|kibana' #查看保留的SVC

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

kibana-logging NodePort 10.105.239.129 <none> 5601:30008/TCP 2m59s k8s-app=kibana-logging

[root@k8smaster01 efk]# kubectl get svc -n kube-system -o wide | grep -E 'NAME|kibana' #查看保留的SVC

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

kibana-logging NodePort 10.105.239.129 <none> 5601:30008/TCP 2m59s k8s-app=kibana-logging

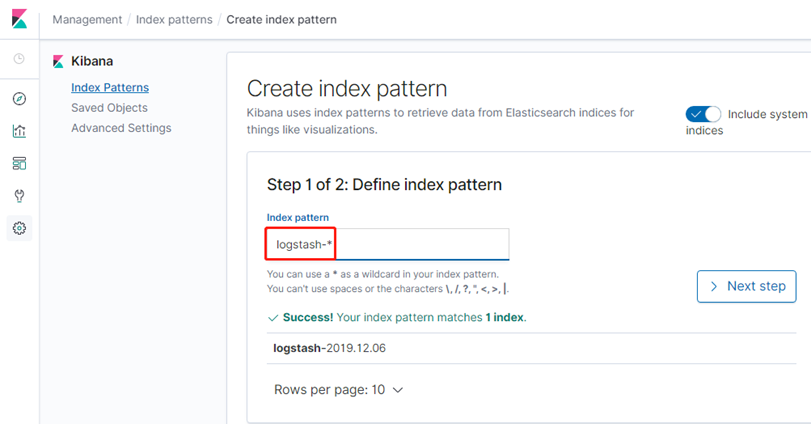

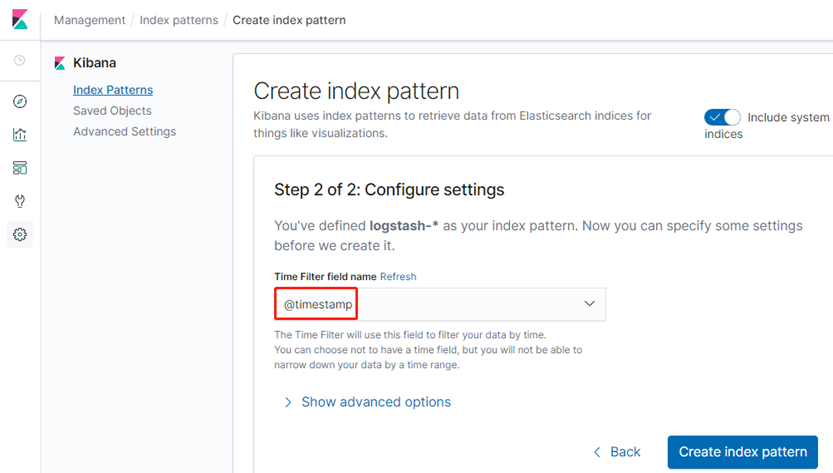

2.9 測試訪問

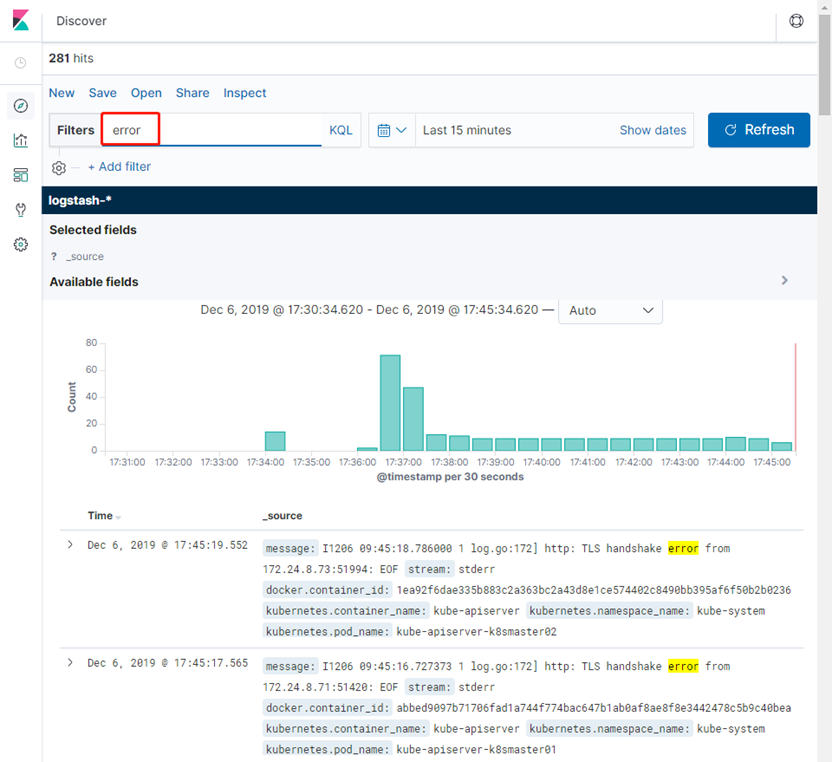

瀏覽器直接訪問:http://172.24.8.71:30008/

嘗試查找error關鍵字日誌。

嘗試查找error關鍵字日誌。