作者:李遵舉 一、問題 近期我們運維同事接到線上LB(負載均衡)服務記憶體報警,運維同事反饋說LB集群有部分機器的記憶體使用率超過80%,有的甚至超過90%,而且記憶體使用率還再不停的增長。接到記憶體報警的消息,讓整個團隊都比較緊張,我們團隊負責的LB服務是零售、物流、科技等業務服務的流量入口,承接上萬個服 ...

作者:李遵舉

一、問題

近期我們運維同事接到線上LB(負載均衡)服務記憶體報警,運維同事反饋說LB集群有部分機器的記憶體使用率超過80%,有的甚至超過90%,而且記憶體使用率還再不停的增長。接到記憶體報警的消息,讓整個團隊都比較緊張,我們團隊負責的LB服務是零售、物流、科技等業務服務的流量入口,承接上萬個服務的流量轉發,一旦有故障影響業務服務比較多,必須馬上著手解決記憶體暴漲的問題。目前只是記憶體報警,暫時不影響業務,先將記憶體使用率90%以上的LB服務下線,防止記憶體過高導致LB服務崩潰,影響業務,運維同事密切關註相關的記憶體報警的消息。

二、排查過程

經過開發同學通過cat /proc/meminfo查看Slab的內核記憶體可能有泄漏。

$ cat /proc/meminfo

MemTotal: 65922868 kB

MemFree: 9001452 kB

...

Slab: 39242216 kB

SReclaimable: 38506072 kB

SUnreclaim: 736144 kB

....通過slabtop命令分析slab發現內核中dentry對象占比高,考慮到dentry對象跟文件有關,Linux中一切皆可以為文件,這個可能跟socket文件有關,通過進一步排查發現LB服務上有個curl發送的HTTPS探測腳本,這個腳本存在dentry對象泄漏,並且在curl論壇上找到一篇文章確認了這個問題,這個文章說明瞭curl-7.19.7版本在發送HTTPS請求時,curl依賴的NSS庫存在dentry泄漏的bug,我查看一下我們curl版本就是7.19.7,問題終於真相大白了!!!

$ curl -V

curl 7.19.7 (x86_64-redhat-linux-gnu) libcurl/7.19.7 NSS/3.15.3 zlib/1.2.3 libidn/1.18 libssh2/1.4.2

Protocols: tftp ftp telnet dict ldap ldaps http file https ftps scp sftp

Features: GSS-Negotiate IDN IPv6 Largefile NTLM SSL libz

$ rpm -aq|grep nss-

nss-util-3.16.1-3.el6.x86_64

nss-sysinit-3.16.1-14.el6.x86_64

nss-softokn-freebl-3.14.3-17.el6.x86_64

nss-softokn-3.14.3-17.el6.x86_64

nss-3.16.1-14.el6.x86_64

nss-tools-3.16.1-14.el6.x86_64文章中介紹可以設置環境變數NSS_SDB_USE_CACHE修複這個bug,我們驗證通過了這個解決方案。

三、解決方案

1、目前先將探測腳本停止,在業務流量低峰時將記憶體使用率超過90%的服務先通過drop_caches清理一下緩存。

2、等大促過後,探測腳本中設置環境變數NSS_SDB_USE_CACHE,徹底修複這個問題。

四、復盤和總結

這次記憶體暴漲的問題根本原因是curl-7.19.7依賴的NSS庫存在dentry泄漏的bug導致的,探測腳本只是將這個問題暴露出來。這次問題由Linux記憶體泄漏引發的問題,因此以點帶面再次系統學習一下Linux記憶體管理的知識非常有必要,對我們以後排查記憶體暴漲的問題非常有幫助。

1)Linux記憶體定址

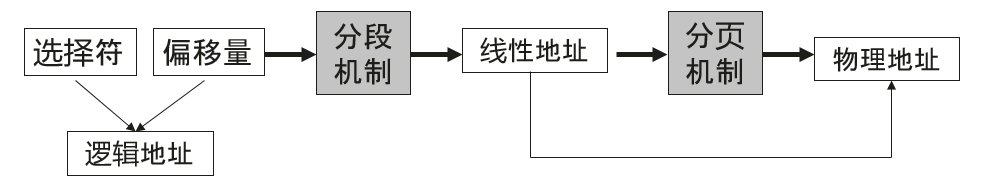

Linux內核主要通過虛擬記憶體管理進程的地址空間,內核進程和用戶進程都只會分配虛擬記憶體,不會分配物理記憶體,通過記憶體定址將虛擬記憶體與物理記憶體做映射。Linux內核中有三種地址,

a、邏輯地址,每個邏輯地址都由一段(segment)和偏移量(offset)組成,偏移量指明瞭從段開始的地方到實際地址之間的距離。

b、線性地址,又稱虛擬地址,是一個32個無符號整數,32位機器記憶體高達4GB,通常用十六進位數字表示,Linux進程的記憶體一般說的都是這個記憶體。

c、物理地址,用於記憶體晶元級記憶體單元定址。它們與從CPU的地址引腳發送到記憶體匯流排上的電信號對應。

Linux中的記憶體控制單元(MMU)通過一種稱為分段單元(segmentation unit)的硬體電路把一個邏輯地址轉換成線性地址,接著,第二個稱為分頁單元(paging unit)的硬體電路把線性地址轉換成一個物理地址。

2)Linux分頁機制

分頁單元把線性地址轉換成物理地址。線性地址被分成以固定長度為單位的組,稱為頁(page)。頁內部連續的線性地址被映射到連續的物理地址中。一般"頁"既指一組線性地址,又指包含這組地址中的數據。分頁單元把所有的RAM分成固定長度的頁框(page frame),也成物理頁。每一頁框包含一個頁(page),也就是說一個頁框的長度與一個頁的長度一致。頁框是主存的一部分,因此也是一個存儲區域。區分一頁和一個頁框是很重要的,前者只是一個數據塊,可以存放任何頁框或者磁碟中。把線性地址映射到物理地址的數據結構稱為頁表(page table)。頁表存放在主存中,併在啟用分頁單元之前必須有內核對頁表進行適當的初始化。

x86_64的Linux內核採用4級分頁模型,一般一頁4K,4種頁表:

a、頁全局目錄

b、頁上級目錄

c、頁中間目錄

d、頁表

頁全局目錄包含若幹頁上級目錄,頁上級目錄又依次包含若幹頁中間目錄的地址,而頁中間目錄又包含若幹頁表的地址。每個頁表項指向一個頁框。線性地址被分成5部分。

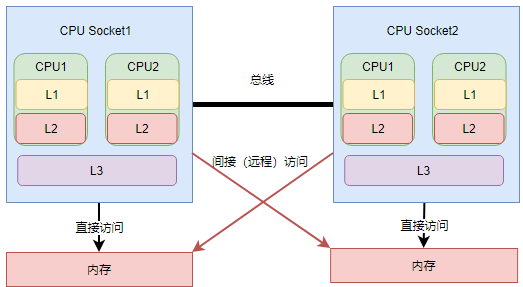

3)NUMA架構

隨著CPU進入多核時代,多核CPU通過一條數據匯流排訪問記憶體延遲很大,因此NUMA架構應運而生,NUMA架構全稱為非一致性記憶體架構 (Non Uniform Memory Architecture),系統的物理記憶體被劃分為幾個節點(node),每個node綁定不同的CPU核,本地CPU核直接訪問本地記憶體node節點延遲最小。

可以通過lscpu命令查看NUMA與CPU核的關係。

$ lscpu

Architecture: x86_64

CPU op-mode(s): 32-bit, 64-bit

Byte Order: Little Endian

CPU(s): 32

On-line CPU(s) list: 0-31

Thread(s) per core: 2

Core(s) per socket: 8

Socket(s): 2

NUMA node(s): 2

Vendor ID: GenuineIntel

CPU family: 6

Model: 62

Stepping: 4

CPU MHz: 2001.000

BogoMIPS: 3999.43

Virtualization: VT-x

L1d cache: 32K

L1i cache: 32K

L2 cache: 256K

L3 cache: 20480K

NUMA node0 CPU(s): 0-7,16-23 #這些核綁定在numa 0

NUMA node1 CPU(s): 8-15,24-31 #這些核綁定在numa 14)伙伴關係演算法

Linux內核通過著名伙伴關係演算法為分配一組連續的頁框而建立一種健壯、穩定的記憶體分配策略,是內核中一種記憶體分配器,並解決了記憶體管理外碎片的問題,外碎片是指頻繁地請求和釋放不同大小的一組連續頁框,必然導致在已分配的頁框的塊分散了許多小塊的空閑頁框。

5)Slab機制

slab機制的核心思想是以對象的觀點來管理記憶體,主要是為瞭解決內部碎片,內部碎片是由於採用固定大小的記憶體分區,即以固定的大小塊為單位來分配,採用這種方法,進程所分配的記憶體可能會比所需要的大,這多餘的部分便是內部碎片。slab也是內核中一種記憶體分配器,slab分配器基於對象進行管理的,所謂的對象就是內核中的數據結構(例如:task_struct,file_struct 等)。相同類型的對象歸為一類,每當要申請這樣一個對象時,slab分配器就從一個slab列表中分配一個這樣大小的單元出去,而當要釋放時,將其重新保存在該列表中,而不是直接返回給伙伴系統,從而避免內部碎片。上面中說到的dentry對象就是通過slab分配器分配的一種對象。

slab和伙伴系統是上下級的調用關係,伙伴關係按照頁管理記憶體,slab按照位元組管理,slab先從伙伴系統獲取數個頁的記憶體,然後切成分成固定的小塊(稱為object),然後再按照聲明的對象數據結構分配對象。

6)進程記憶體分佈

所有進程都必須占用一定數量的記憶體,這些記憶體用來存放從磁碟載入的程式代碼,或存放來自用戶輸入的數據等。記憶體可以提前靜態分配和統一回收,也可以按需動態分配和回收。對於普通進程對應的記憶體空間包含5種不同的數據區:

a、代碼段(text):程式代碼在記憶體中的映射,存放函數體的二進位代碼,通常用於存放程式執行代碼(即CPU執行的機器指令)。

b、數據段(data):存放程式中已初始化且初值不為0的全局變數和靜態局部變數。數據段屬於靜態記憶體分配(靜態存儲區),可讀可寫。

c、BSS段(bss):未初始化的全局變數和靜態局部變數。

d、堆(heap):動態分配的記憶體段,大小不固定,可動態擴張(malloc等函數分配記憶體),或動態縮減(free等函數釋放)。

e、棧(stack):存放臨時創建的局部變數。

Linux內核是操作系統中優先順序最高的,內核函數申請記憶體必須及時分配適當的記憶體,用戶態進程申請記憶體被認為是不緊迫的,內核儘量推遲給用戶態的進程動態分配記憶體。

a、請求調頁,推遲到進程要訪問的頁不在RAM中時為止,引發一個缺頁異常。

b、寫時複製(COW),父、子進程共用頁框而不是複製頁框,但是共用頁框不能被修改,只有當父/子進程試圖改寫共用頁框時,內核才將共用頁框複製一個新的頁框並標記為可寫。

7)Linux記憶體檢測工具

a、free命令可以監控系統記憶體

$ free -h

total used free shared buff/cache available

Mem: 31Gi 13Gi 8.0Gi 747Mi 10Gi 16Gi

Swap: 2.0Gi 321Mi 1.7Gib、top命令查看系統記憶體以及進程記憶體

•VIRT Virtual Memory Size (KiB):進程使用的所有虛擬記憶體,包括代碼(code)、數據(data)、共用庫(shared libraries),以及被換出(swap out)到交換區和映射了(map)但尚未使用(未載入實體記憶體)的部分。

•RES Resident Memory Size (KiB):進程所占用的所有實體記憶體(physical memory),不包括被換出到交換區的部分。

•SHR Shared Memory Size (KiB):進程可讀的全部共用記憶體,並非所有部分都包含在 RES 中。它反映了可能被其他進程共用的記憶體部分。

c、smaps文件

cat /proc/$pid/smaps查看某進程虛擬記憶體空間的分佈情況

0082f000-00852000 rw-p 0022f000 08:05 4326085 /usr/bin/nginx/sbin/nginx

Size: 140 kB

Rss: 140 kB

Pss: 78 kB

Shared_Clean: 56 kB

Shared_Dirty: 68 kB

Private_Clean: 4 kB

Private_Dirty: 12 kB

Referenced: 120 kB

Anonymous: 80 kB

AnonHugePages: 0 kB

Swap: 0 kB

KernelPageSize: 4 kB

MMUPageSize: 4 kBd、vmstat

vmstat是Virtual Meomory Statistics(虛擬記憶體統計)的縮寫,可實時動態監視操作系統的虛擬記憶體、進程、CPU活動。

## 每秒統計3次

$ vmstat 1 3

procs -----------memory---------------- ---swap-- -----io---- --system-- -----cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

0 0 0 233483840 758304 20795596 0 0 0 1 0 0 0 0 100 0 0

0 0 0 233483936 758304 20795596 0 0 0 0 1052 1569 0 0 100 0 0

0 0 0 233483920 758304 20795596 0 0 0 0 966 1558 0 0 100 0 0e、meminfo文件

Linux系統中/proc/meminfo這個文件用來記錄了系統記憶體使用的詳細情況。

$ cat /proc/meminfo

MemTotal: 8052444 kB

MemFree: 2754588 kB

MemAvailable: 3934252 kB

Buffers: 137128 kB

Cached: 1948128 kB

SwapCached: 0 kB

Active: 3650920 kB

Inactive: 1343420 kB

Active(anon): 2913304 kB

Inactive(anon): 727808 kB

Active(file): 737616 kB

Inactive(file): 615612 kB

Unevictable: 196 kB

Mlocked: 196 kB

SwapTotal: 8265724 kB

SwapFree: 8265724 kB

Dirty: 104 kB

Writeback: 0 kB

AnonPages: 2909332 kB

Mapped: 815524 kB

Shmem: 732032 kB

Slab: 153096 kB

SReclaimable: 99684 kB

SUnreclaim: 53412 kB

KernelStack: 14288 kB

PageTables: 62192 kB

NFS_Unstable: 0 kB

Bounce: 0 kB

WritebackTmp: 0 kB

CommitLimit: 12291944 kB

Committed_AS: 11398920 kB

VmallocTotal: 34359738367 kB

VmallocUsed: 0 kB

VmallocChunk: 0 kB

HardwareCorrupted: 0 kB

AnonHugePages: 1380352 kB

CmaTotal: 0 kB

CmaFree: 0 kB

HugePages_Total: 0

HugePages_Free: 0

HugePages_Rsvd: 0

HugePages_Surp: 0

Hugepagesize: 2048 kB

DirectMap4k: 201472 kB

DirectMap2M: 5967872 kB

DirectMap1G: 3145728 kB總結部分中一些內容來源於《深入理解Linux內核》,一些內容根據個人理解寫出的,有不對地方歡迎指正,部分圖片來源於網路