產生背景及定義 HDFS:分散式文件系統,用於存儲文件,主要特點在於其分散式,即有很多伺服器聯合起來實現其功能,集群中的伺服器各有各的角色 隨著數據量越來越大,一個操作系統存不下所有的數據,那麼就分配到更多的操作系統管理的磁碟中,但是管理和維護極不方便,於是迫切 需要一種系統來管理多台機器上的文件 ...

產生背景及定義

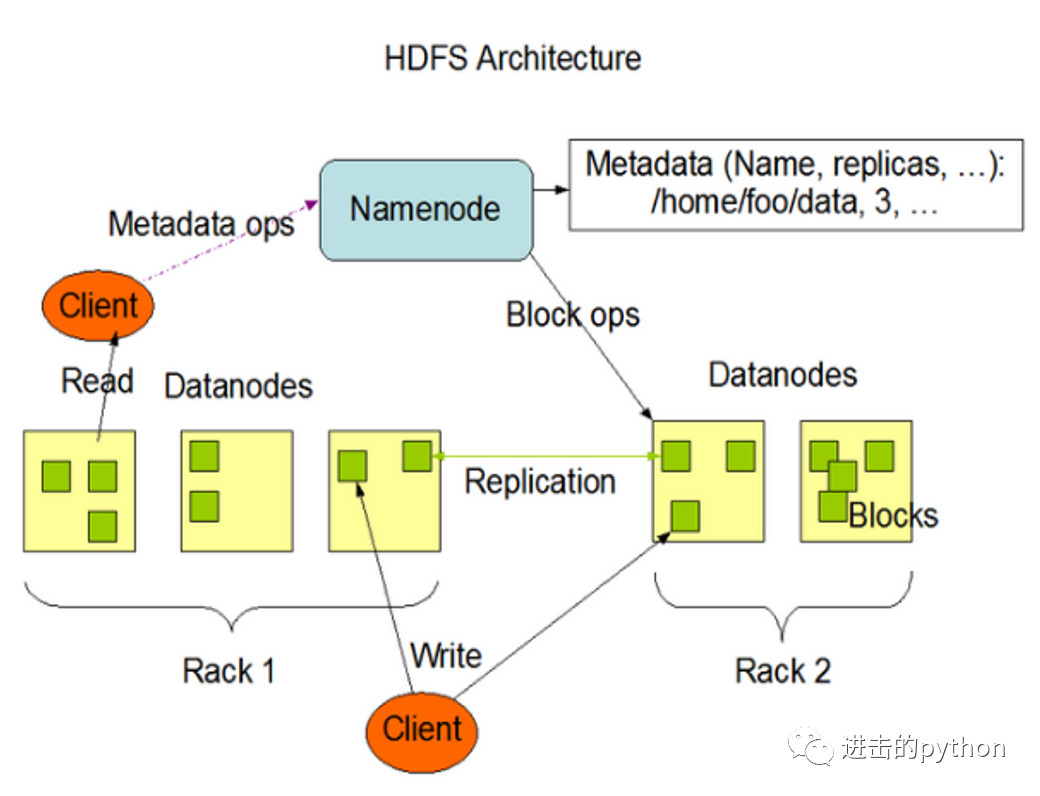

HDFS:分散式文件系統,用於存儲文件,主要特點在於其分散式,即有很多伺服器聯合起來實現其功能,集群中的伺服器各有各的角色

- 隨著數據量越來越大,一個操作系統存不下所有的數據,那麼就分配到更多的操作系統管理的磁碟中,但是管理和維護極不方便,於是迫切需要一種系統來管理多台機器上的文件,這就是分散式管理系統,HDFS是其中一種。

- HDFS的使用適合一次寫入,多次讀出的場景,且不支持對文件的直接修改,僅支持在文件末尾追加

- HDFS採用流式的數據訪問方式:特點就是像流水一樣,數據不是一次過來,而是一點一點“流”過來,處理數據也是一點一點處理。如果是數據全部過來之後才處理,那麼延遲就會很大,而且會消耗很大的記憶體。

優缺點

- 高容錯性

- 數據自動保存多個副本,通過增加副本的方式,提高容錯性

- 若某一個副本丟失後,它可以自動分配到其它節點作為新的副本

- 處理大數據

- 數據規模:能夠處理的數據規模可以達到GB,TB,甚至PB級別的數據

- 文件規模:能夠處理百萬規模以上的文件數量,數量相當之大

- 可構建在廉價的機器上,通過多副本機制,提高可靠性

組成架構

namenode(nn):就是Master,是一個管理者,存放元數據- 管理HDFS的名稱空間

- 配置副本策略

- 管理數據塊的映射信息

- 處理客戶端的讀寫請求

datanode(dn):就是slave,真正存儲文件的地方- 存儲實際的數據塊

- 執行數據塊的讀寫操作

secondarynamenode(2nn):並非namenode的熱備,當namenode掛掉的時候,並不能馬上替換namenode並提供服務- 作為namenode的輔助,分擔其工作量,比如定期合併Fsimage和Edits(文章後邊會講到這兩個東西),並推送給namenode

- 在緊急情況下,可輔助恢復namenode,但是只能恢復部分,而不能全部恢復

client:客戶端- 文件的切分,在上傳HDFS之前,client將文件切分為一個一個的Block,然後一個一個進行上傳

- 與namenode交互,獲取文件的datanode信息

- 與datanode交互,讀取或寫入數據

- client提供一些命令來管理HDFS,比如namenode的格式化

- client通過一些命令來訪問HDFS,比如對HDFS的增刪查改等

文件塊大小

為什麼要把文件抽象為Block塊存儲?

- block的拆分使得單個文件大小可以大於整個磁碟的容量,構成文件的Block可以分佈在整個集群, 理論上,單個文件可以占據集群中所有機器的磁碟。

- Block的抽象也簡化了存儲系統,對於Block,無需關註其許可權,所有者等內容(這些內容都在文件級別上進行控制)。

- Block作為容錯和高可用機制中的副本單元,即以Block為單位進行複製。

HDFS中的文件在物理記憶體中分塊存儲(Block),塊的大小在Hadoop2.x版本中預設為128M,在老版本中為64M,那麼為什麼為128M呢?

其實,HDFS的塊的大小的設置主要取決於磁碟傳輸速率,如下:

- 如果在HDFS中,定址時間為10ms,即查找到目標Block的時間為10ms

- 專家說操作的最佳狀態為:定址時間為傳輸時間的1%,因此傳輸時間為1s

- 而目前磁碟的傳輸速率普遍為100M/s

為什麼塊大小不能設置太小,也不能設置太大?

- HDFS的塊設置太小,會增加定址時間,使得程式可能一直在尋找塊的開始位置

- 如果設置的太大,從磁碟傳輸數據的時間會明顯大於定位這個塊所需的定址時間,導致程式處理這塊數據時會非常慢

HDFS的數據流

HDFS寫數據流程

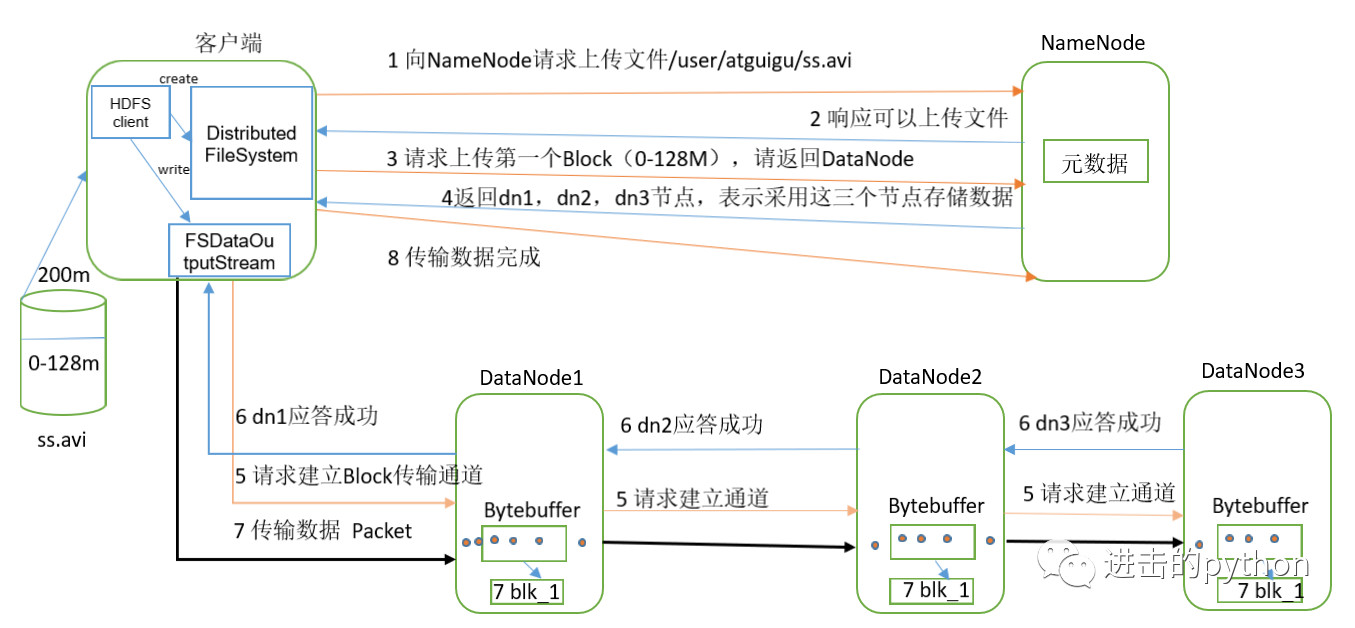

- 客戶端通過Distributed FileSystem模塊向NameNode請求上傳文件,NameNode檢查目標文件是否已存在,父目錄是否存在。

- NameNode返回是否可以上傳。

- 客戶端請求第一個 Block上傳到哪幾個DataNode伺服器上。

- NameNode返回3個DataNode節點,分別為dn1、dn2、dn3, 如果有多個節點,返回實際的副本數量,並根據距離及負載情況計算

- 客戶端通過FSDataOutputStream模塊請求dn1上傳數據,dn1收到請求會繼續調用dn2,然後dn2調用dn3,將這個通信管道建立完成。

- dn1、dn2、dn3逐級應答客戶端。

- 客戶端開始往dn1上傳第一個Block(先從磁碟讀取數據放到一個本地記憶體緩存),以Packet為單位,dn1收到一個Packet就會傳給dn2,dn2傳給dn3;dn1每傳一個packet會放入一個應答隊列等待應答。

- 當一個Block傳輸完成之後,客戶端再次請求NameNode上傳第二個Block的伺服器。(重覆執行3-7步)。

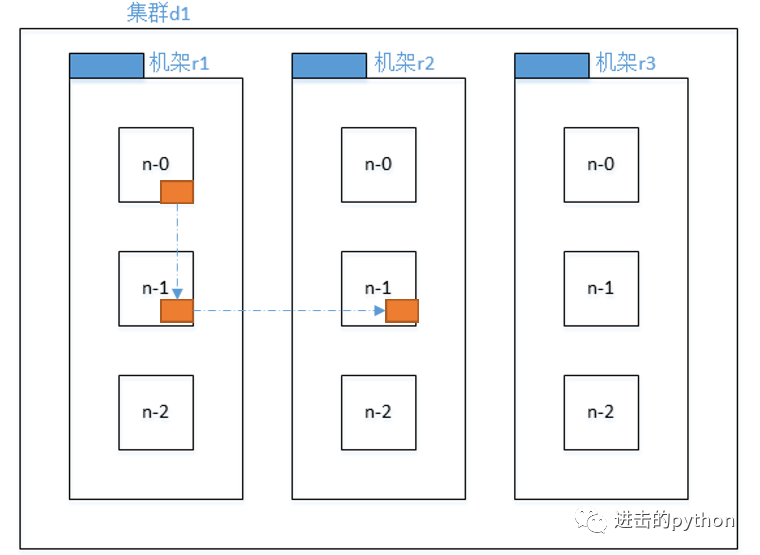

網路拓撲---節點距離計算

在HDFS寫數據的過程中,NameNode會選擇距離待上傳數據最近距離的DataNode接收數據,那麼這個最近距離是怎麼計算的呢?

結論:兩個節點到達最近的共同祖先的距離總和,即為節點距離。

如上圖所示:

- 同一節點上的進程節點距離為0

- 同一機架上不同節點的距離為兩個節點到共同機架r1的距離總和,為2

- 同一數據中心不同機架的節點距離為兩個節點到共同祖先集群d1的距離之和,為4

- 不同數據中心的節點距離為兩個節點到達共同祖先數據中心的距離之和,為6

機架感知(副本存儲的節點選擇)

副本的數量我們可以從配置文件中設置,那麼HDFS是怎麼選擇副本存儲的節點的呢?

如上圖所示,為了提高容錯性,有如下設置,加入現在有3個副本:

- 第一個副本在Client所在的節點上,如果客戶端在集群外,則隨機選一個

- 第二個副本和第一個副本位於相同機架,隨機節點

- 第三個副本位於不同機架,隨機節點

這樣做的目的就是為了提高容錯性。

HDFS讀數據流程

- 客戶端通過Distributed FileSystem向NameNode請求下載文件,NameNode通過查詢元數據,找到文件塊所在的DataNode地址。

- 挑選一臺DataNode(就近原則,然後隨機)伺服器,請求讀取數據。

- DataNode開始傳輸數據給客戶端(從磁碟裡面讀取數據輸入流,以Packet為單位來做校驗)。

- 客戶端以Packet為單位接收,先在本地緩存,然後寫入目標文件。