uniq命令: 常見參數: -c,--count ***** 在每行旁邊顯示改行重覆出現的次數 -d,--repeated 僅顯示重覆出現的行,2次或2次以上的行,預設的去重包含1次。 例子: a.只對相鄰的相同行內容去重。 [root@nfs-server test]# cat test.txt ...

uniq命令:

常見參數: -c,--count ***** 在每行旁邊顯示改行重覆出現的次數 -d,--repeated 僅顯示重覆出現的行,2次或2次以上的行,預設的去重包含1次。 例子:a.只對相鄰的相同行內容去重。

[root@nfs-server test]# cat test.txt10.0.0.910.0.0.810.0.0.710.0.0.710.0.0.810.0.0.810.0.0.9[root@nfs-server test]# uniq test.txt10.0.0.910.0.0.810.0.0.710.0.0.810.0.0.9

[root@nfs-server test]# sort test.txt10.0.0.710.0.0.710.0.0.810.0.0.810.0.0.810.0.0.910.0.0.9

[root@nfs-server test]# sort test.txt|uniq10.0.0.710.0.0.810.0.0.9[root@nfs-server test]#

[root@nfs-server test]# sort -u test.txt10.0.0.710.0.0.810.0.0.9

[root@nfs-server test]# sort test.txt|uniq -c210.0.0.7310.0.0.8210.0.0.9

http://post.judong.org/index.html http://mp3.judong.org/index.html

http://www.judong.org/3.html http://post.judong.org/2.html 解答: 法1:

[root@nfs-server test]# sort test.log|awk -F "[://]+"'{print $2}'|uniq -c1 mp3.judong.org2 post.judong.org3 www.judong.org

[root@nfs-server test]# awk -F /'{print $3}' test.log|sortmp3.judong.orgpost.judong.orgpost.judong.orgwww.judong.orgwww.judong.orgwww.judong.org[root@nfs-server test]# awk -F /'{print $3}' test.log|sort|uniq -c1 mp3.judong.org2 post.judong.org3 www.judong.org[root@nfs-server test]#

[root@nfs-server test]# awk -F /'{print $3}' test.log|sort|uniq -c|sort -r ##-r,表示倒序排列3 www.judong.org2 post.judong.org1 mp3.judong.org[root@nfs-server test]#

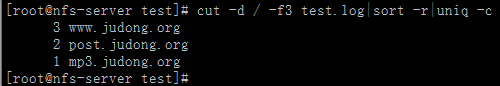

[root@nfs-server test]# cut -d /-f3 test.log|sort -r|uniq -c3 www.judong.org2 post.judong.org1 mp3.judong.org[root@nfs-server test]#