awk數組詳解及企業實戰案例 3.列印數組: [root@nfs-server test]# awk 'BEGIN{array[1]="zhurui";array[2]="zhuzhu";for(key in array) print key,array[key]}' 1 zhurui 2 zhuz ...

awk數組詳解及企業實戰案例

3.列印數組:[root@nfs-server test]# awk 'BEGIN{array[1]="zhurui";array[2]="zhuzhu";for(key in array) print key,array[key]}'1 zhurui2 zhuzhu[root@nfs-server test]#

[root@nfs-server test]# awk 'BEGIN{array[1]="zhurui";array[2]="zhuzhu";}END {for(key in array) print key,array[key]}'/etc/hosts1 zhurui2 zhuzhu

把文件內容第一列作為下標,第二列作為值,放入數組然後輸出。[root@nfs-server test]# cat t3.log1 zhurui2 zhuzhu[root@nfs-server test]# awk 'BENGIN{S[$1]=$2;}END{for(k in S) print k,S[k]}' t3.log[root@nfs-server test]# awk '{S[$1]=$2;}END{for(k in S) print k,S[k]}' t3.log1 zhurui2 zhuzhu

4、腳本:

4、腳本:

#!/bin/awkBEGIN{array[1]="zhurui"array[2]="zhuzhu"for(key in array)print key,array[key];}

[root@nfs-server test]# awk -f t2.awk1 zhurui2 zhuzhu[root@nfs-server test]#

[root@nfs-server test]# cat t3.log1 zhurui2 zhuzhu[root@nfs-server test]# awk 'BENGIN{S[$1]=$2;}END{for(k in S) print k,S[k]}' t3.log[root@nfs-server test]# awk '{S[$1]=$2;}END{for(k in S) print k,S[k]}' t3.log1 zhurui2 zhuzhu

http://post.judong.org/index.html http://mp3.judong.org/index.html

http://www.judong.org/3.html http://post.judong.org/2.html

[root@nfs-server test]# awk -F "/"'{S[$3]=S[$3]+1;}END{for(k in S) print k,S[k]}' test.logmp3.judong.org 1post.judong.org 2www.judong.org 3

[root@nfs-server test]# awk -F "/"'{S[$3]++}END{for(k in S) print k,S[k]}' test.log|sort -rn -k2|headwww.judong.org 3post.judong.org 2mp3.judong.org 1[root@nfs-server test]#

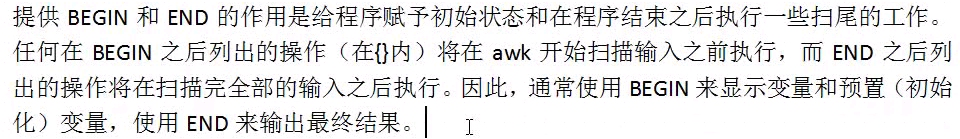

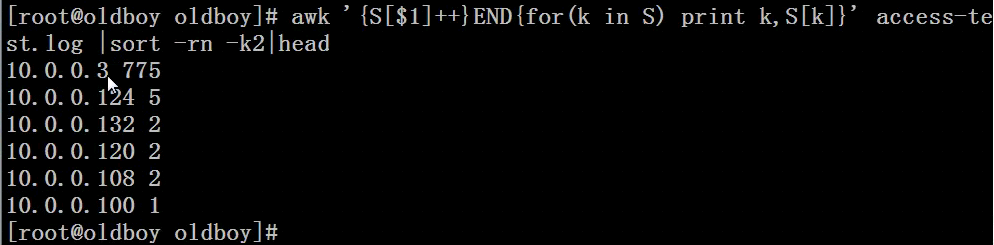

對於統計訪問連接IP個數的答案為:

[root@nfs-server test]# awk -F " "'{S[$1]=S[$1]+1;}END{for (k in S) print k,S[k]}' access-test.log|sort -rn|head ##此方法較複雜10.0.0.377510.0.0.132210.0.0.124510.0.0.120210.0.0.108210.0.0.1001[root@nfs-server test]# awk -F " "'{S[$1]++;}END{for (k in S) print k,S[k]}' access-test.log|sort -rn|head ##上一步的簡化版10.0.0.377510.0.0.132210.0.0.124510.0.0.120210.0.0.108210.0.0.1001[root@nfs-server test]# awk -F " "'{Z[$1]++;}END{for (k in Z) print k,Z[k]}' access-test.log|sort -rn|head10.0.0.377510.0.0.132210.0.0.124510.0.0.120210.0.0.108210.0.0.1001

方法2:

方法2:

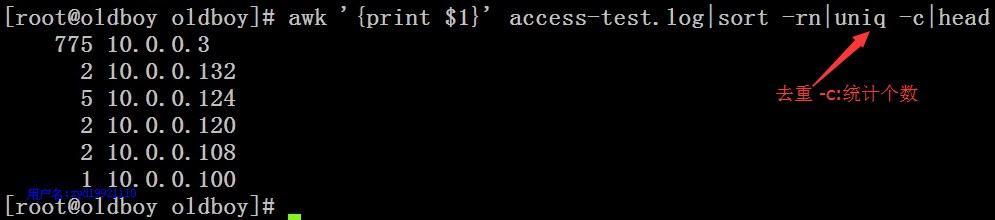

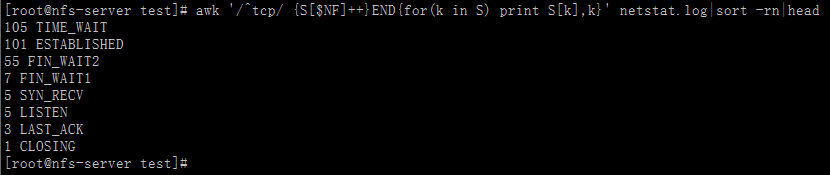

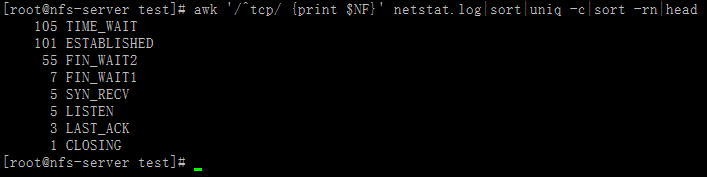

例4:統計企業工作中高併發linux伺服器不同網路連接狀態對應的數量

例4:統計企業工作中高併發linux伺服器不同網路連接狀態對應的數量

方法1:

[root@nfs-server test]# awk '/^tcp/ {S[$NF]++}END{for(k in S) print S[k],k}' netstat.log|sort -rn|head105 TIME_WAIT101 ESTABLISHED55 FIN_WAIT27 FIN_WAIT15 SYN_RECV5 LISTEN3 LAST_ACK1 CLOSING[root@nfs-server test]#

方法2:

方法2:

[root@nfs-server test]# awk '/^tcp/ {print $NF}' netstat.log|sort|uniq -c|sort -rn|head105 TIME_WAIT101 ESTABLISHED55 FIN_WAIT27 FIN_WAIT15 SYN_RECV5 LISTEN3 LAST_ACK1 CLOSING[root@nfs-server test]#

例5:

分析圖片服務日誌,把日誌(每個圖片訪問次數*圖片大小的總和)排行,取top10,也就是計算每個url的總訪問大小

例5:

分析圖片服務日誌,把日誌(每個圖片訪問次數*圖片大小的總和)排行,取top10,也就是計算每個url的總訪問大小