Scrapy Scrapy 是一個位了爬取網站數據,提取數據結構性數據而編寫的應用框架,少量代碼,就能快速爬取,使用了Twisted 非同步網路框架,加快我們下載速度! 工作流程 製作 Scrapy 爬蟲 一共需要4步: 新建項目 (scrapy startproject xxx):新建一個新的爬蟲項 ...

Scrapy

Scrapy 是一個位了爬取網站數據,提取數據結構性數據而編寫的應用框架,少量代碼,就能快速爬取,使用了Twisted 非同步網路框架,加快我們下載速度!

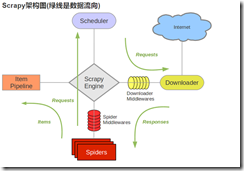

工作流程

製作 Scrapy 爬蟲 一共需要4步:

新建項目 (scrapy startproject xxx):新建一個新的爬蟲項目 明確目標 (編寫items.py):明確你想要抓取的目標 製作爬蟲 (spiders/xxspider.py):製作爬蟲開始爬取網頁 存儲內容 (pipelines.py):設計管道存儲爬取內容 Scrapy Engine(引擎): 負責Spider、ItemPipeline、Downloader、Scheduler中間的通訊,信號、數據傳遞等。 Scheduler(調度器): 它負責接受引擎發送過來的Request請求,並按照一定的方式進行整理排列,入隊,當引擎需要時,交還給引擎。 Downloader(下載器):負責下載Scrapy Engine(引擎)發送的所有Requests請求,並將其獲取到的Responses交還給Scrapy Engine(引擎),由引擎交給Spider來處理, Spider(爬蟲):它負責處理所有Responses,從中分析提取數據,獲取Item欄位需要的數據,並將需要跟進的URL提交給引擎,再次進入Scheduler(調度器). Item Pipeline(管道):它負責處理Spider中獲取到的Item,併進行進行後期處理(詳細分析、過濾、存儲等)的地方。 Downloader Middlewares(下載中間件):你可以當作是一個可以自定義擴展下載功能的組件。 Spider Middlewares(Spider中間件):你可以理解為是一個可以自定擴展和操作引擎和Spider中間通信的功能組件(比如進入Spider的Responses;和從Spider出去的Requests)Scrapy的運作流程

代碼寫好,程式開始運行... 1 引擎:Hi!Spider, 你要處理哪一個網站? 2 Spider:老大要我處理xxxx.com。 3 引擎:你把第一個需要處理的URL給我吧。 4 Spider:給你,第一個URL是xxxxxxx.com。 5 引擎:Hi!調度器,我這有request請求你幫我排序入隊一下。 6 調度器:好的,正在處理你等一下。 7 引擎:Hi!調度器,把你處理好的request請求給我。 8 調度器:給你,這是我處理好的request 9 引擎:Hi!下載器,你按照老大的下載中間件的設置幫我下載一下這個request請求 10 下載器:好的!給你,這是下載好的東西。(如果失敗:sorry,這個request下載失敗了。然後引擎告訴調度器,這個request下載失敗了,你 記錄一下,我們待會兒再下載) 11 引擎:Hi!Spider,這是下載好的東西,並且已經按照老大的下載中間件處理過了,你自己處理一下(註意!這兒responses預設是交給def parse()這個函數處理的) 12 Spider:(處理完畢數據之後對於需要跟進的URL),Hi!引擎,我這裡有兩個結果,這個是我需要跟進的URL,還有這個是我獲取到的Item數據。 13 引擎:Hi !管道 我這兒有個item你幫我處理一下!調度器!這是需要跟進URL你幫我處理下。然後從第四步開始迴圈,直到獲取完老大需要全部信息。 14 管道調度器:好的,現在就做! 註意!只有當調度器中不存在任何request了,整個程式才會停止,(也就是說,對於下載失敗的URL,Scrapy也會重新下載。)入門實例爬取(騰訊招聘)

準備環境:

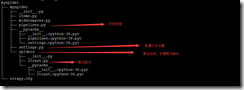

1)創建項目 pip install scrapy scrapy startproject myspider 2)創建儀個爬蟲 scrapy genspider itcast(爬蟲名字) "itcast.cn"(限制網站的範圍) 3)啟動爬蟲 scrapy crawl itcast代碼:

1 ###設置item 欄位### 2 import scrapy 3 4 class MyspiderItem(scrapy.Item): 5 title = scrapy.Field() 6 position = scrapy.Field() 7 time = scrapy.Field() 8 address = scrapy.Field() 9 10 ###設置spiders 目錄下的爬蟲腳本,可以設置多個## 11 vim spiders/itcast.py 12 # -*- coding: utf-8 - 13 import scrapy 14 import sys 15 #之前設置好的items 導入進來 16 from myspider.items import MyspiderItem 17 18 class ItcastSpider(scrapy.Spider): 19 #spider.name 可以用於判斷 20 name = 'itcast' 21 #限制範圍 22 allowed_domains = ['tencent.com'] 23 start_urls = ['https://hr.tencent.com/position.php?lid=2218&tid=87'] 24 #parse方法不能修改,必須有 25 def parse(self, response): 26 tb_list = response.xpath("//table[@class='tablelist']/tr")[1:-1] 27 for tr in tb_list: 28 #字典對象 29 item = MyspiderItem() 30 item['title'] = tr.xpath("./td[1]/a/text()").extract_first() 31 item['position'] = tr.xpath("./td[2]/text()").extract_first() 32 item['address'] = tr.xpath("./td[4]/text()").extract_first() 33 item['time'] = tr.xpath("./td[5]/text()").extract_first() 34 yield item 35 #翻頁 36 next_url = response.xpath("//a[@id='next']/@href").extract_first() 37 print(next_url) 38 if next_url != "javascript:;": 39 next_url = "https://hr.tencent.com/" +next_url 40 print(next_url) 41 #下一頁請求,scrapy封裝好的request請求 42 yield scrapy.Request( 43 next_url, 44 callback=self.parse 45 ) 46 print("="*30) 47 48 ##設置存儲pipeline## 49 vim pipelines.py 50 # -*- coding: utf-8 -*- 51 import json 52 class MyspiderPipeline(object): 53 def process_item(self,item,spider): 54 #有判斷,以後可以寫多個piiline,來存儲 55 if spider.name == "itcast": 56 with open('temp.txt','a') as f: 57 #item 是一個對象,要轉成字典! 58 json.dump(dict(item),f,ensure_ascii=False,indent=2) 59 60 61 ##設置setting 配置## 62 開啟pipelines,可以設置多個 63 64 ITEM_PIPELINES = { 65 'myspider.pipelines.MyspiderPipeline': 300, 66 'myspider.pipelines.XXXXPipeline': 300, 67 } 68 #不顯示日誌 69 LOG_LEVEL = "WARNING" 70 71 ##瀏覽器頭 72 USER_AGENT = 'Mozilla/5.0 (iPad; CPU OS 11_0 like Mac OS X) AppleWebKit/604.1.34 (KHTML, like Gecko) Version/11.0 Mobile/15A5341f Safari/604.1'