本文由雲+社區發表 TCP是一個複雜的協議,每個機制在帶來優勢的同時也會引入其他的問題。 Nagel演算法和delay ack機制是減少發送端和接收端包量的兩個機制, 可以有效減少網路包量,避免擁塞。但是,在特定場景下, Nagel演算法要求網路中只有一個未確認的包, 而delay ack機制需要等待更 ...

本文由雲+社區發表

TCP是一個複雜的協議,每個機制在帶來優勢的同時也會引入其他的問題。 Nagel演算法和delay ack機制是減少發送端和接收端包量的兩個機制, 可以有效減少網路包量,避免擁塞。但是,在特定場景下, Nagel演算法要求網路中只有一個未確認的包, 而delay ack機制需要等待更多的數據包, 再發送ACK回包, 導致發送和接收端等待對方發送數據, 造成死鎖, 只有當delay ack超時後才能解開死鎖,進而導致應用側對外的延時高。 其他文字已經介紹了相關的機制, 已經有一些文章介紹這種時延的場景。本文結合具體的tcpdump包,分析觸發delay ack的場景,相關的內核參數, 以及規避的方案。

背景

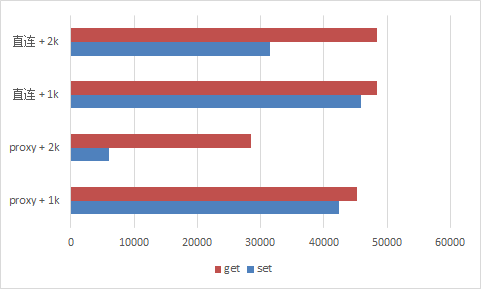

給redis加了一個proxy層, 壓測的時候發現, 對寫入命令,數據長度大於2k後, 性能下降非常明顯, 只有直連redis-server的1/10. 而get請求影響並不是那麼明顯。

分析

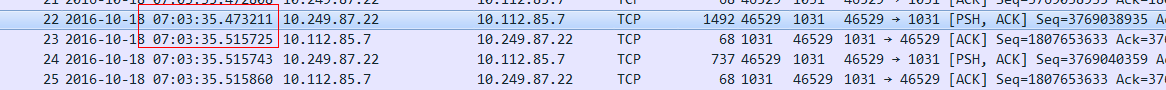

觀察系統的負載和網路包量情況, 都比較低, 網路包量也比較小, proxy內部的耗時也比較短。 無賴只能祭出tcpdump神奇, 果然有妖邪。

22號tcp請求包, 42ms後服務端才返回了ack。 初步懷疑是網路層的延時導致了耗時增加。Google和km上找資料, 大概的解釋是這樣: 由於客戶端打開了Nagel演算法, 服務端未關閉延遲ack, 會導致延遲ack超時後,再發送ack,引起超時。

原理

Nagel演算法,轉自維基百科

if there is new data to send

if the window size >= MSS and available data is >= MSS

send complete MSS segment now

else

if there is unconfirmed data still in the pipe

enqueue data in the buffer until an acknowledge is received

else

send data immediately

end if

end if

end if簡單講, Nagel演算法的規則是:

- 如果發送內容大於1個MSS, 立即發送;

- 如果之前沒有包未被確認, 立即發送;

- 如果之前有包未被確認, 緩存發送內容;

- 如果收到ack, 立即發送緩存的內容。

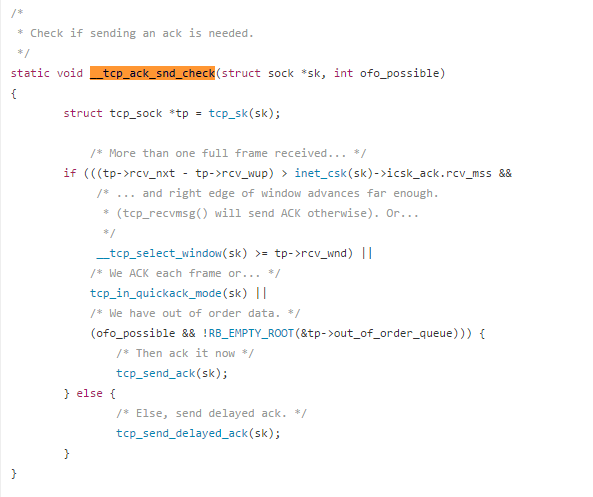

延遲ACK的源碼如下:net/ipv4/tcp_input.c

基本原理是:

- 如果收到的數據內容大於一個MSS, 發送ACK;

- 如果收到了接收視窗以為的數據, 發送ACK;

- 如果處於quick mode, 發送ACK;

- 如果收到亂序的數據, 發送ACK;

- 其他, 延遲發送ACK

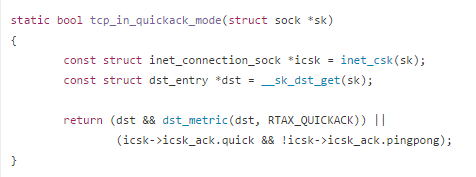

其他都比較明確, quick mode是怎麼判斷的呢? 繼續往下看代碼:

影響quick mode的一個因素是 ping pong的狀態。 Pingpong是一個狀態值, 用來標識當前tcp交互的狀態, 以預測是否是W-R-W-R-W-R這種互動式的通訊模式, 如果處於, 可以用延遲ack, 利用Read的回包, 將Write的回包, 捎帶給發送方。

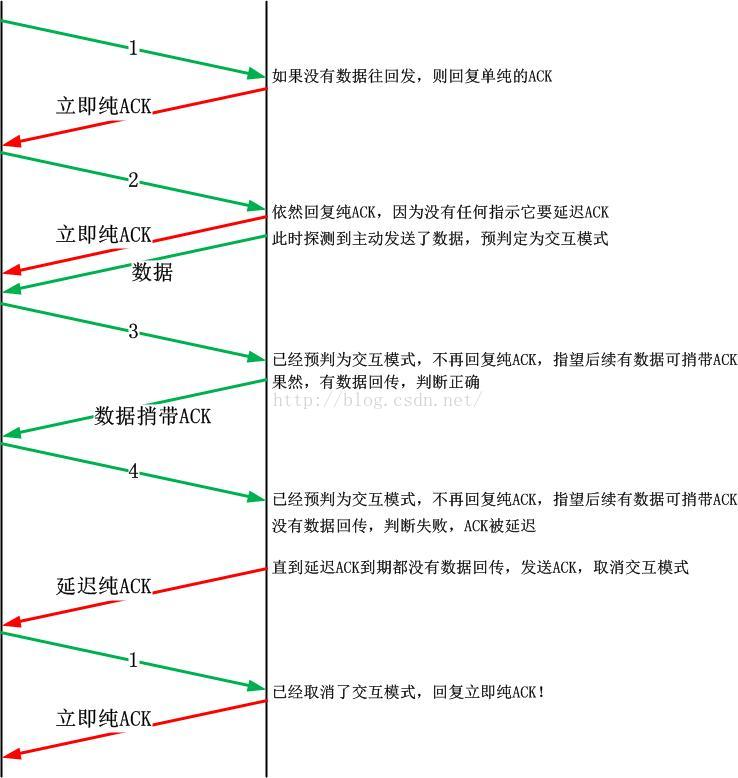

如上圖所示, 預設pingpong = 0, 表示非互動式的, 服務端收到數據後, 立即返回ACK, 當服務端有數據響應時,服務端將pingpong = 1, 以後的交互中, 服務端不會立即返回ack,而是等待有數據或者ACK超時後響應。

問題

按照前面的的原理分析,應該每次都有ACK延遲的,為什麼我們測試小於2K的數據時, 性能並沒有受到影響呢?

繼續分析tcpdump包:

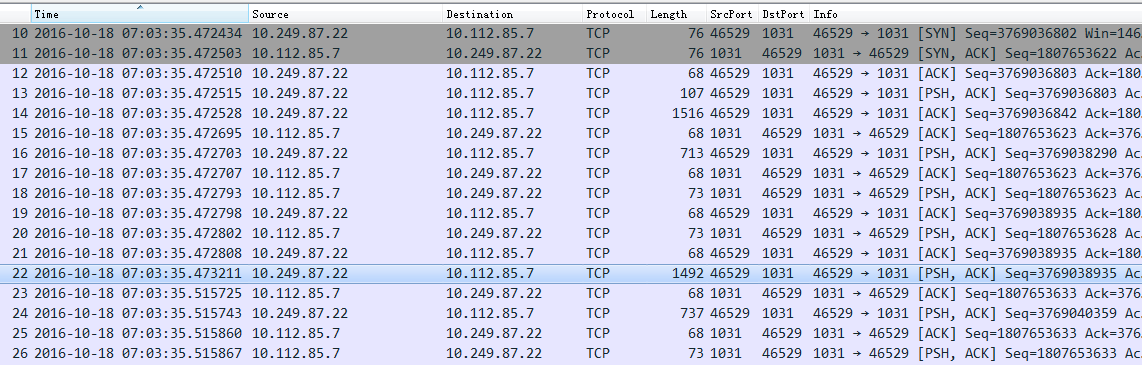

按照Nagel演算法和延遲ACK機制, 上面的交互如下圖所示, 由於每次發生的數據都包含了完整的請求, 服務端處理完成後, 向客戶端返回命令響應時, 將請求的ACK捎帶給客戶端,節約一次網路包。

再分析2K的場景:

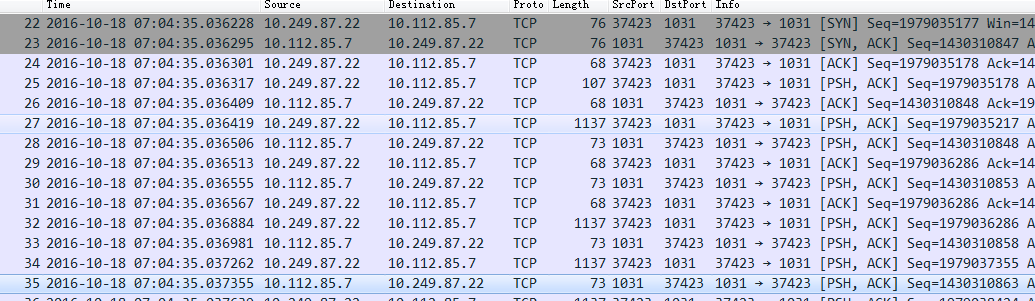

如下表所示, 第22個包發送的數據小於MSS, 同時,pingpong = 1, 被認為是交互模式, 期待通過捎帶ACK的方式來減少網路的包量。 但是, 服務端收到的數據,並不是一個完整的包,不能產生一次應答。服務端只能在等待40ms超時後,發送ACK響應包。

同時,從客戶端來看,如果在發送一個包, 也可以打破已收數據 > MSS的限制。 但是,客戶端受Nagel演算法的限制, 一次只能有一個包未被確認,其他的數據只能被緩存起來, 等待發送。

觸發場景

一次tcp請求的數據, 不能在服務端產生一次響應,或者小於一個MSS

規避方案

只有同時客戶端打開Nagel演算法, 服務端打開tcp_delay_ack才會導致前面的死鎖狀態。 解決方案可以從TCP的兩端來入手。

服務端:

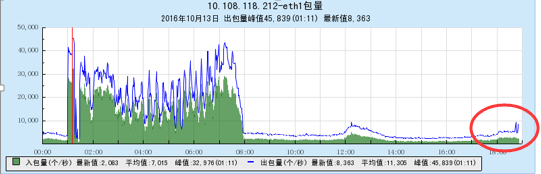

- 關閉tcp_delay_ack, 這樣, 每個tcp請求包都會有一個ack及時響應, 不會出現延遲的情況。 操作方式: echo 1 > /proc/sys/net/ipv4/tcp_no_delay_ack 但是, 每個tcp請求都返回一個ack包, 導致網路包量的增加,關閉tcp延遲確認後, 網路包量大概增加了80%,在高峰期影響還是比較明顯。

2.設置TCP_QUICKACK屬性。 但是需要每次recv後再設置一次。 對應我們的場景不太適合,需要修改服務端redis源碼。

客戶端:

- 關閉nagel演算法,即設置socket tcp_no_delay屬性。

staticvoid _set_tcp_nodelay(int fd) { int enable = 1; setsockopt(fd, IPPROTO_TCP, TCP_NODELAY, (void*)&enable, sizeof(enable)); } - 避免多次寫, 再讀取的場景, 合併成一個大包的寫;避免一次請求分成多個包發送, 最開始發送的包小於一個MSS,對我們的場景, 把第22號包的1424個位元組緩存起來, 大於一個MSS的時候,再發送出去, 服務端立即返迴響應, 客戶端繼續發送後續的數據, 完成交互,避免時延。

此文已由作者授權騰訊雲+社區發佈