通常,我們會對於一個文本文件數據導入到資料庫中,不多說,上代碼。 首先,表結構如下. 其次,在我當前D盤中有個文本文件名為2.txt的文件。 在資料庫中,可以這樣通過一句代碼插入。 1) bulk insert: 為Sql server 中一個批量插入的操作 2)T_Demo: 要插入的表 3)'D ...

通常,我們會對於一個文本文件數據導入到資料庫中,不多說,上代碼。

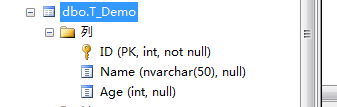

首先,表結構如下.

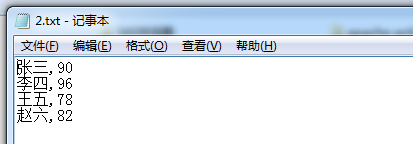

其次,在我當前D盤中有個文本文件名為2.txt的文件。

在資料庫中,可以這樣通過一句代碼插入。

Bulk insert T_Demo From 'D:\2.txt' With ( fieldterminator=',', rowterminator='\n' )

1) bulk insert: 為Sql server 中一個批量插入的操作

2)T_Demo: 要插入的表

3)'D:\2.txt': 數據源文件所在磁碟上的物理路徑

4)with 相當於一些插入的附屬條件,可以起這裡添加一些約束限制條件等

5) fieldterminator=’,’欄位的分割符為”,”一般的txt文本數據源的欄位分隔都為逗號,當然也可以為其他,比如”|”

6)rowterminator=’\n’各條信息間的分割符為’\n’,一般的txt文本數據源的信息間的分割都是換行符,即一條信息占一行,也可以用其他格式如:”|\n”

在微軟官方給的詳細如下:

BULK INSERT [ database_name . [ schema_name ] . | schema_name . ] [ table_name | view_name ] FROM 'data_file' [ WITH ( [ [ , ] BATCHSIZE = batch_size ] [ [ , ] CHECK_CONSTRAINTS ] [ [ , ] CODEPAGE = { 'ACP' | 'OEM' | 'RAW' | 'code_page' } ] [ [ , ] DATAFILETYPE = { 'char' | 'native'| 'widechar' | 'widenative' } ] [ [ , ] FIELDTERMINATOR = 'field_terminator' ] [ [ , ] FIRSTROW = first_row ] [ [ , ] FIRE_TRIGGERS ] [ [ , ] FORMATFILE = 'format_file_path' ] [ [ , ] KEEPIDENTITY ] [ [ , ] KEEPNULLS ] [ [ , ] KILOBYTES_PER_BATCH = kilobytes_per_batch ] [ [ , ] LASTROW = last_row ] [ [ , ] MAXERRORS = max_errors ] [ [ , ] ORDER ( { column [ ASC | DESC ] } [ ,...n ] ) ] [ [ , ] ROWS_PER_BATCH = rows_per_batch ] [ [ , ] ROWTERMINATOR = 'row_terminator' ] [ [ , ] TABLOCK ] [ [ , ] ERRORFILE = 'file_name' ] )]

這裡我們主要看with中的一些參數:(部分)

1) BATCHSIZE : 指定批處理中的行數

2) CHECK_CONSTRAINTS:啟用約束檢查,指定在大容量導入操作期間,必須檢查所有對目標表或視圖的約束。若沒有 CHECK_CONSTRAINTS 選項,則忽略所有 CHECK 和 FOREIGN KEY 約束,併在該操作後將表的約束標記為不可信。始終強制使用 UNIQUE、PRIMARY KEY 和 NOT NULL 約束。

3) FIRE_TRIGGERS

指定將在大容量導入操作期間執行目標表中定義的所有插入觸發器。如果為針對目標表的 INSERT 操作定義了觸發器,則每次完成批處理操作時均激發觸發器。

4) KEEPNULLS

指定空列在大容量導入操作期間應保留 Null 值,而不插入列的任何預設值

5) ORDER ( { column [ ASC | DESC ] } [ ,...n ] )

指定如何對數據文件中的數據排序。如果根據表中的聚集索引(如果有)對要導入的數據排序,則可提高大容量導入的性能

6) ERRORFILE ='file_name'

指定用於收集格式有誤且不能轉換為 OLE DB 行集的行的文件。這些行將按原樣從數據文件複製到此錯誤文件中。

--------------------------------------------------------------SqlBulkCopy分割線---------------------------------------------------------------------

在C#中,我們可以使用sqlBulkCopy去批量插入數據,其他批量插入方法不在討論。

上代碼......

/// <summary> /// SqlBulkCopy批量插入數據 /// </summary> /// <param name="connectionStr">鏈接字元串</param> /// <param name="dataTableName">表名</param> /// <param name="sourceDataTable">數據源</param> /// <param name="batchSize">一次事務插入的行數</param> public static void SqlBulkCopyByDataTable(string connectionStr, string dataTableName, DataTable sourceDataTable, int batchSize = 100000) { using (SqlConnection connection=new SqlConnection(connectionStr)) { using (SqlBulkCopy sqlBulkCopy=new SqlBulkCopy(connectionStr,SqlBulkCopyOptions.UseInternalTransaction)) { try { sqlBulkCopy.DestinationTableName = dataTableName; sqlBulkCopy.BatchSize = batchSize; for (int i = 0; i < sourceDataTable.Columns.Count; i++) { sqlBulkCopy.ColumnMappings.Add(sourceDataTable.Columns[i].ColumnName,sourceDataTable.Columns[i].ColumnName); } sqlBulkCopy.WriteToServer(sourceDataTable); } catch (Exception ex) { throw ex; } } } }

使用方式如下,這裡我將插入100萬條數據,

在SqlBulkCopyByDataTable方法中每次插入10萬條,

其插入方式SqlBulkCopyOptions.UseInternalTransaction (即事務插入,可用其他方式。)

DataTable dt = new DataTable("測試"); dt.Columns.Add("ID",typeof(int)); dt.Columns.Add("Name", typeof(string)); dt.Columns.Add("Age", typeof(int)); for (int i = 1; i <= 1000000; i++) { DataRow row = dt.NewRow(); row["ID"] = i; row["Name"] = "名字"+i; row["Age"] = i; dt.Rows.Add(row); } string connStr = System.Configuration.ConfigurationManager.ConnectionStrings["connStr"].ConnectionString; Stopwatch stopWatch = new Stopwatch(); stopWatch.Start(); SqlBulkCopyByDataTable(connStr, "T_Demo", dt); Console.WriteLine(stopWatch.Elapsed); Console.ReadKey();

用時為如下。

參考: http://blog.csdn.net/xuemoyao/article/details/8506338

本文到此結束。

純屬回顧與粗談,並沒有細說。

請各位見諒。