springboot繼承efk實現日誌收集 1.安裝es和kibana 我使用的雲伺服器centos7,2核+4G記憶體,跑起來記憶體使用率50%左右 建議使用最低配置和我一樣,1+2的配置kibana應該跑不起來,安裝過程使用了尚矽谷的springcloud的課程資料,也**!!!!!!!!可以不用, ...

springboot繼承efk實現日誌收集

1.安裝es和kibana

我使用的雲伺服器centos7,2核+4G記憶體,跑起來記憶體使用率50%左右

建議使用最低配置和我一樣,1+2的配置kibana應該跑不起來,安裝過程使用了尚矽谷的springcloud的課程資料,也!!!!!!!!可以不用,自己pull,我附了pull的方法

資料包:鏈接:https://pan.baidu.com/s/1GW1qUUwya6mUAacFokpZUw?pwd=eses

提取碼:eses

參考資料:https://blog.csdn.net/liurui_wuhan/article/details/115480511

1.1安裝es

-

使用的版本都是7.12.1

-

使用的安裝方式是docker

1.創建互聯網路

創建kibana和es可以在docker中互聯的網路

docker network create es-net

2.載入鏡像

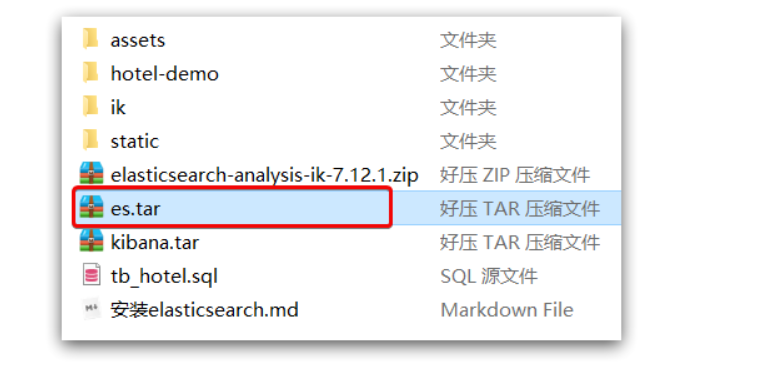

將資料包中的es.tar上傳到伺服器

# 導入數據2

docker load -i es.tar

ps:也可以自己pull ,只要最後的docker里有鏡像就好了

#pull的方法

docker pull docker.elastic.co/elasticsearch/elasticsearch:7.12.1

docker pull kibana:7.12.1

3.運行

docker run -d \

--name es \

-e "ES_JAVA_OPTS=-Xms512m -Xmx512m" \

-e "http.host=0.0.0.0"\

-e "discovery.type=single-node" \

-v es-data:/usr/share/elasticsearch/data \

-v es-plugins:/usr/share/elasticsearch/plugins \

--privileged \

--network es-net \

-p 9200:9200 \

-p 9300:9300 \

elasticsearch:7.12.1

命令解釋:

-

--name es:給啟動的容器別名,查看的時候可以直接使用es代替所有需要填寫容器名稱的地方,比如docker logs -f es -

-e "cluster.name=es-docker-cluster":設置集群名稱 -

-e "http.host=0.0.0.0":監聽的地址,可以外網訪問 -

-e "ES_JAVA_OPTS=-Xms512m -Xmx512m":記憶體大小 -

-e "discovery.type=single-node":非集群模式 -

-v es-data:/usr/share/elasticsearch/data:掛載邏輯捲,綁定es的數據目錄 -

-v es-logs:/usr/share/elasticsearch/logs:掛載邏輯捲,綁定es的日誌目錄 -

-v es-plugins:/usr/share/elasticsearch/plugins:掛載邏輯捲,綁定es的插件目錄 -

--privileged:授予邏輯捲訪問權 -

--network es-net:加入一個名為es-net的網路中 -

-p 9200:9200:埠映射配置

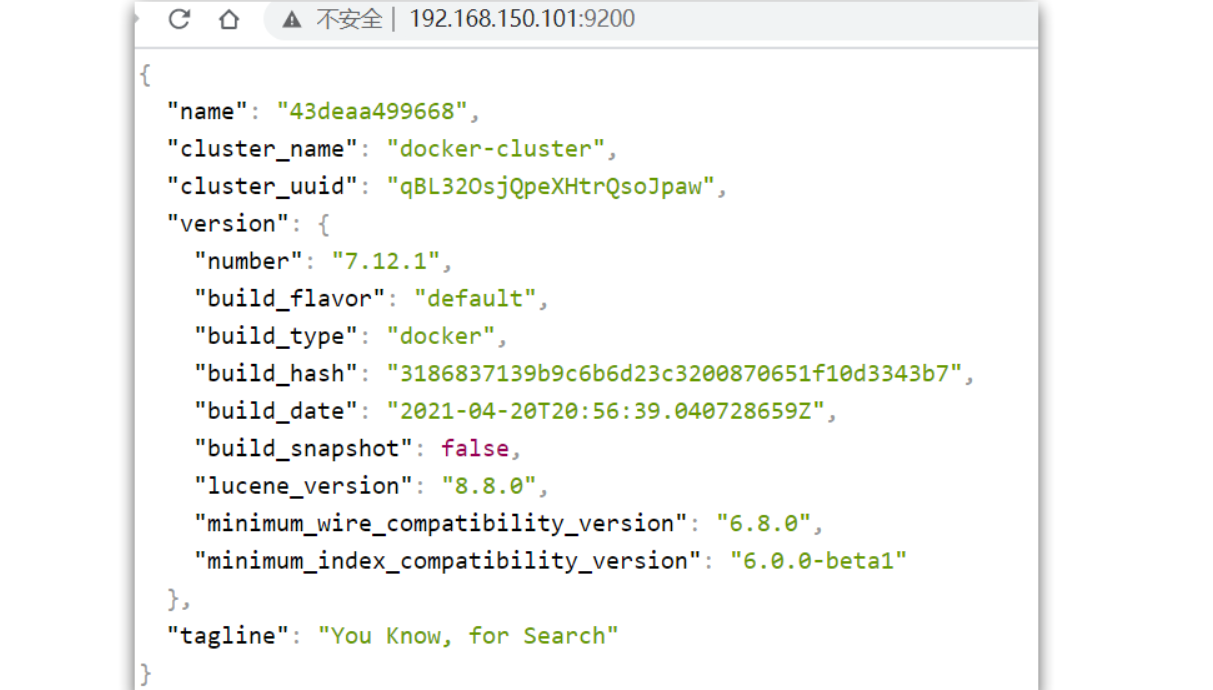

在瀏覽器中輸入:http://伺服器地址:9200 即可看到elasticsearch的響應結果:

1.2安裝kibana

kibana提供了可視化的界面

1.載入鏡像

跟es一樣,上傳到伺服器,再載入

2.運行

docker run -d \

--name kibana \

-e ELASTICSEARCH_HOSTS=http://es:9200 \

--network=es-net \

-p 5601:5601 \

kibana:7.12.1

--network es-net:加入一個名為es-net的網路中,與elasticsearch在同一個網路中-e ELASTICSEARCH_HOSTS=http://es:9200":設置elasticsearch的地址,因為kibana已經與elasticsearch在一個網路,因此可以用容器名直接訪問elasticsearch-p 5601:5601:埠映射配置

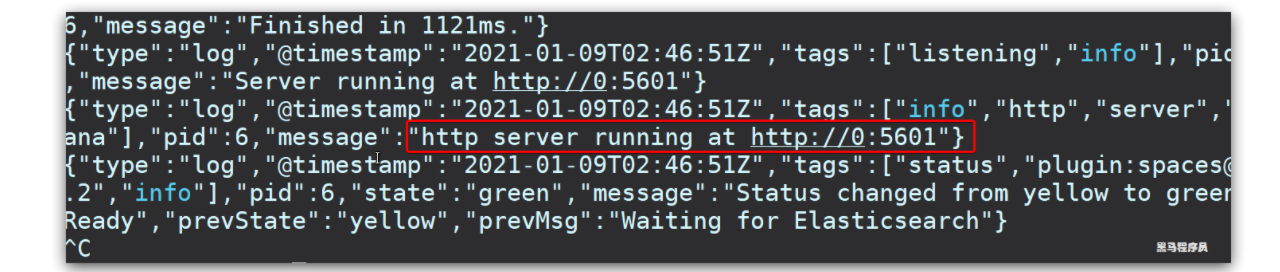

kibana啟動一般比較慢,需要多等待一會,可以通過命令:

docker logs -f kibana

查看運行日誌,當查看到下麵的日誌,說明成功:

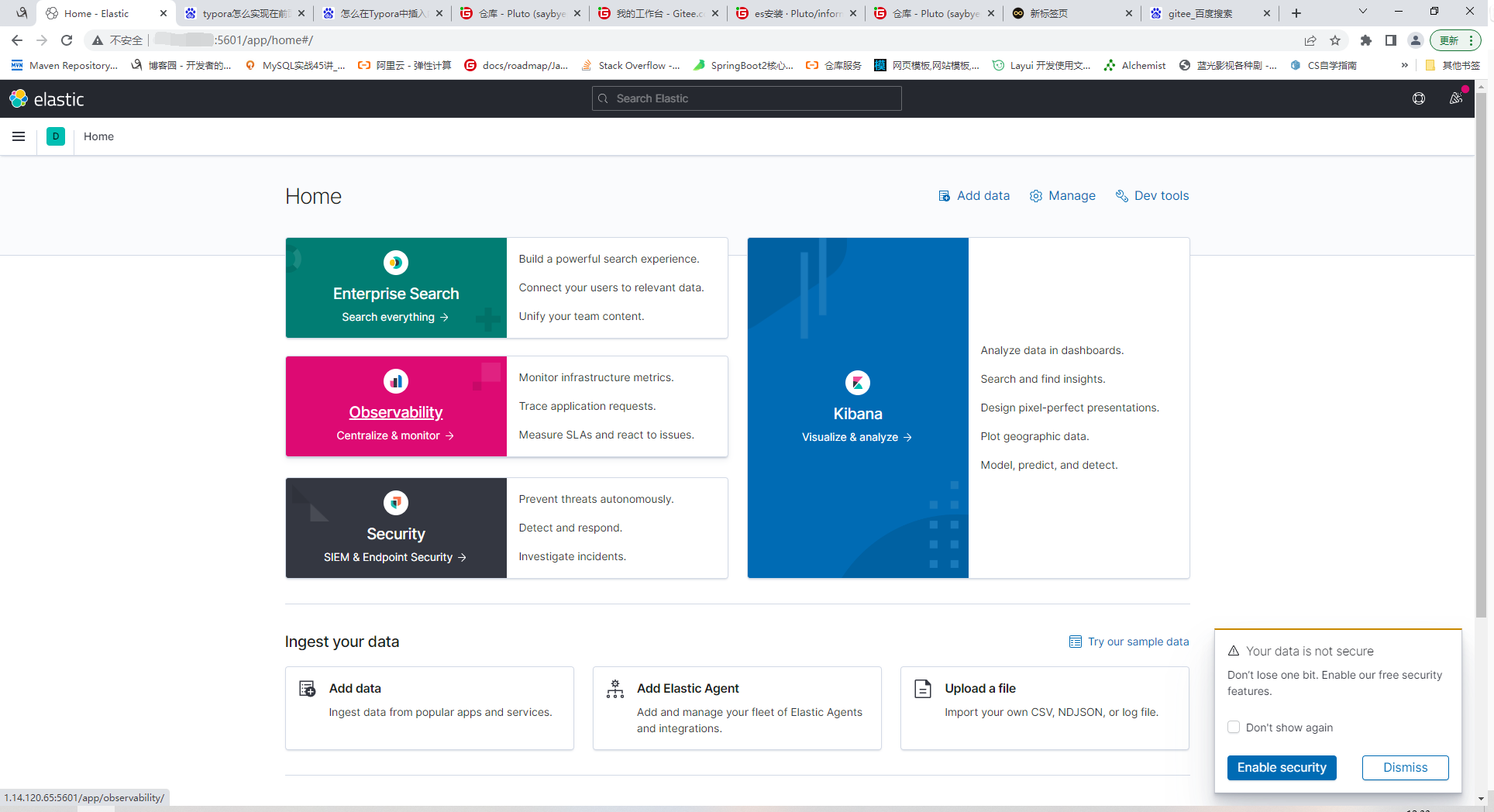

此時,在瀏覽器輸入地址訪問:http://伺服器地址:5601,即可看到結果

2.安裝filebeat

filebeat要安裝在你需要採集數據的電腦上,不一定要和es安裝在一臺機器上

比如我的項目是在本地跑,filebeat就要安在我的本機也就是windows下

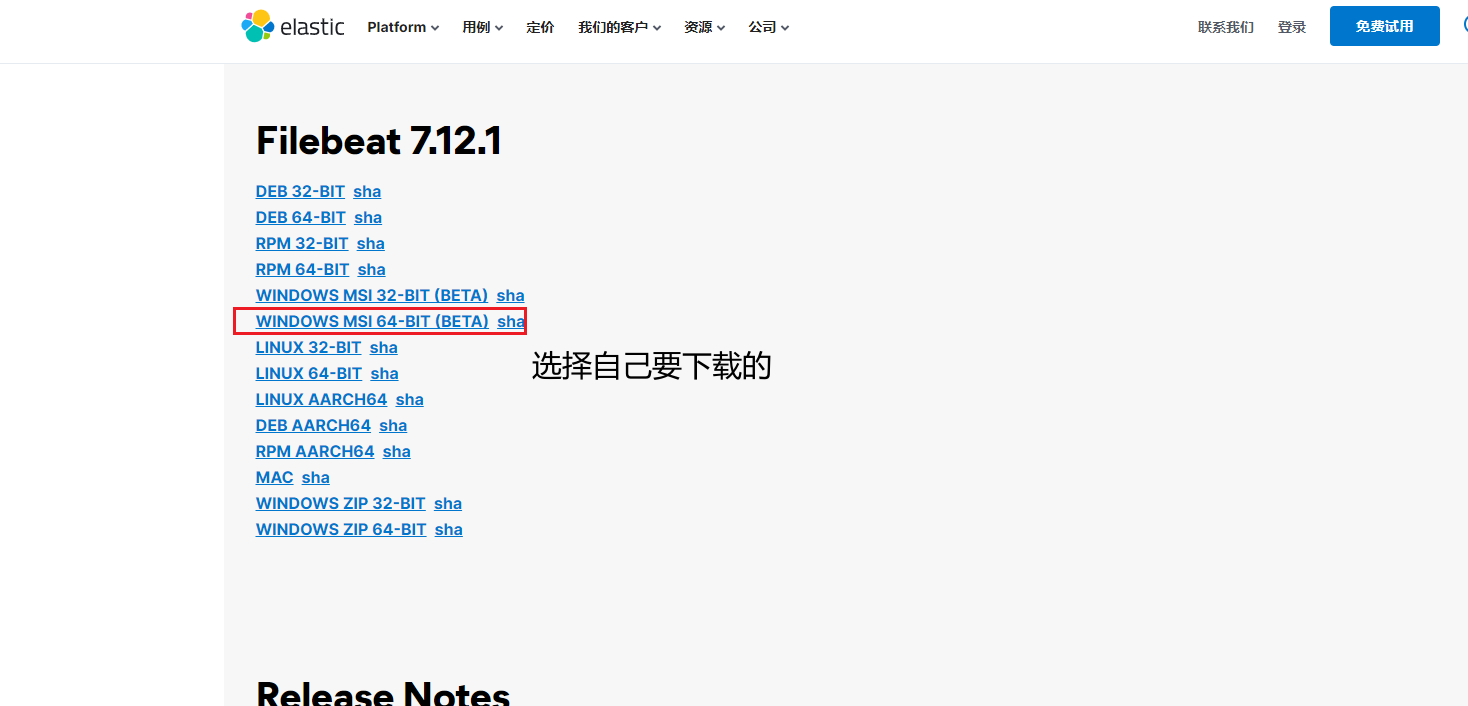

1.下載filebeat

https://www.elastic.co/cn/downloads/past-releases/filebeat-7-12-1

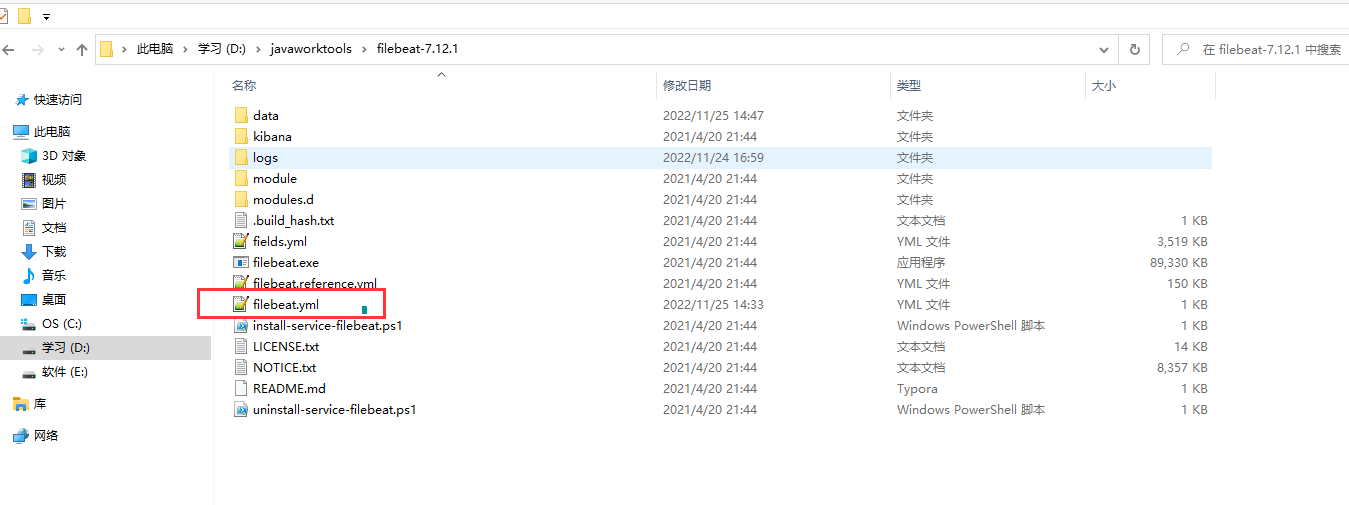

2.編寫filebeat.yml

# ============================== Filebeat inputs ===============================

filebeat.inputs:

- type: log

enabled: true

encoding: UTF-8

paths:

#你需要採集數據的地址,比如這個是我的項目生成log文件的地址

- D:\socialManeger\test1\logs\oper\*.log

# ---------------------------- Elasticsearch Output ----------------------------

output.elasticsearch:

# es 地址

hosts: ["1.14.120.65:9200"]

ps:這是最簡單的yml,如果要實現過濾或者其他的功能,可以去看看他的配置文件詳解

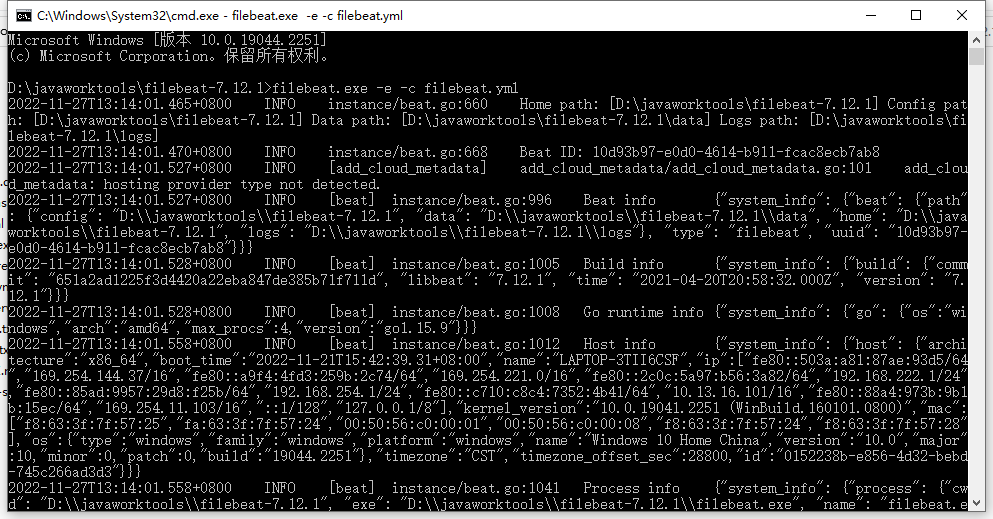

3.運行

進入filebeat的安裝目錄

filebeat.exe -e -c filebeat.yml

3.整合springboot

1.pom.xml 新增logstash-logback-encoder依賴,logstash-logback-encoder可以將日誌以json的方式輸出,也不用我們單獨處理多行記錄問題

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>5.3</version>

</dependency>

2.配置logback-spring.xml

<?xml version="1.0" encoding="UTF-8"?>

<configuration >

<include resource="org/springframework/boot/logging/logback/defaults.xml"/>

<contextName>logback</contextName>

<property name="log.path" value="logs/" />

<!--輸出到控制台-->

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<filter class="ch.qos.logback.classic.filter.ThresholdFilter">

<level>debug</level>

</filter>

<encoder>

<Pattern>${CONSOLE_LOG_PATTERN}</Pattern>

<!-- 設置字元集 -->

<charset>UTF-8</charset>

</encoder>

</appender>

<!--輸出到文件-->

<appender name="INFO_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${log.path}/oper/oper.log</file>

<encoder>

<pattern>%msg%n</pattern>

<charset>UTF-8</charset>

</encoder>

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>${log.path}/oper/oper -%d{yyyy-MM-dd}.%i.log</fileNamePattern>

<maxFileSize>100MB</maxFileSize>

<maxHistory>30</maxHistory>

<totalSizeCap>1GB</totalSizeCap>

</rollingPolicy>

<encoder class="net.logstash.logback.encoder.LogstashEncoder" >

<providers>

<timestamp>

<timeZone>Asia/Shanghai</timeZone>

</timestamp>

<pattern>

<pattern>{"message": "%message"}</pattern>

</pattern>

</providers>

</encoder>

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>info</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

</appender>

<!-- 時間滾動輸出 level為 ERROR 日誌 -->

<appender name="ERROR_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${log.path}/error/error.log</file>

<encoder>

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%thread] %-5level %logger{50} - %msg%n</pattern>

<charset>UTF-8</charset> <!-- 此處設置字元集 -->

</encoder>

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>${log.path}/error/error-%d{yyyy-MM-dd}.%i.log</fileNamePattern>

<maxFileSize>100MB</maxFileSize>

<maxHistory>30</maxHistory>

<totalSizeCap>1GB</totalSizeCap>

</rollingPolicy>

<filter class="ch.qos.logback.classic.filter.LevelFilter">

<level>ERROR</level>

<onMatch>ACCEPT</onMatch>

<onMismatch>DENY</onMismatch>

</filter>

</appender>

<root level="INFO">

<appender-ref ref="STDOUT" />

<appender-ref ref="INFO_FILE" />

<appender-ref ref="ERROR_FILE" />

</root>

<!--name:用來指定受此loger約束的某一個包或者具體的某一個類。-->

<!--addtivity:是否向上級loger傳遞列印信息。預設是true。-->

<logger name="com.netflix" level="ERROR" />

<logger name="net.sf.json" level="ERROR" />

<logger name="org.springframework" level="ERROR" />

<logger name="springfox" level="ERROR" />

</configuration>

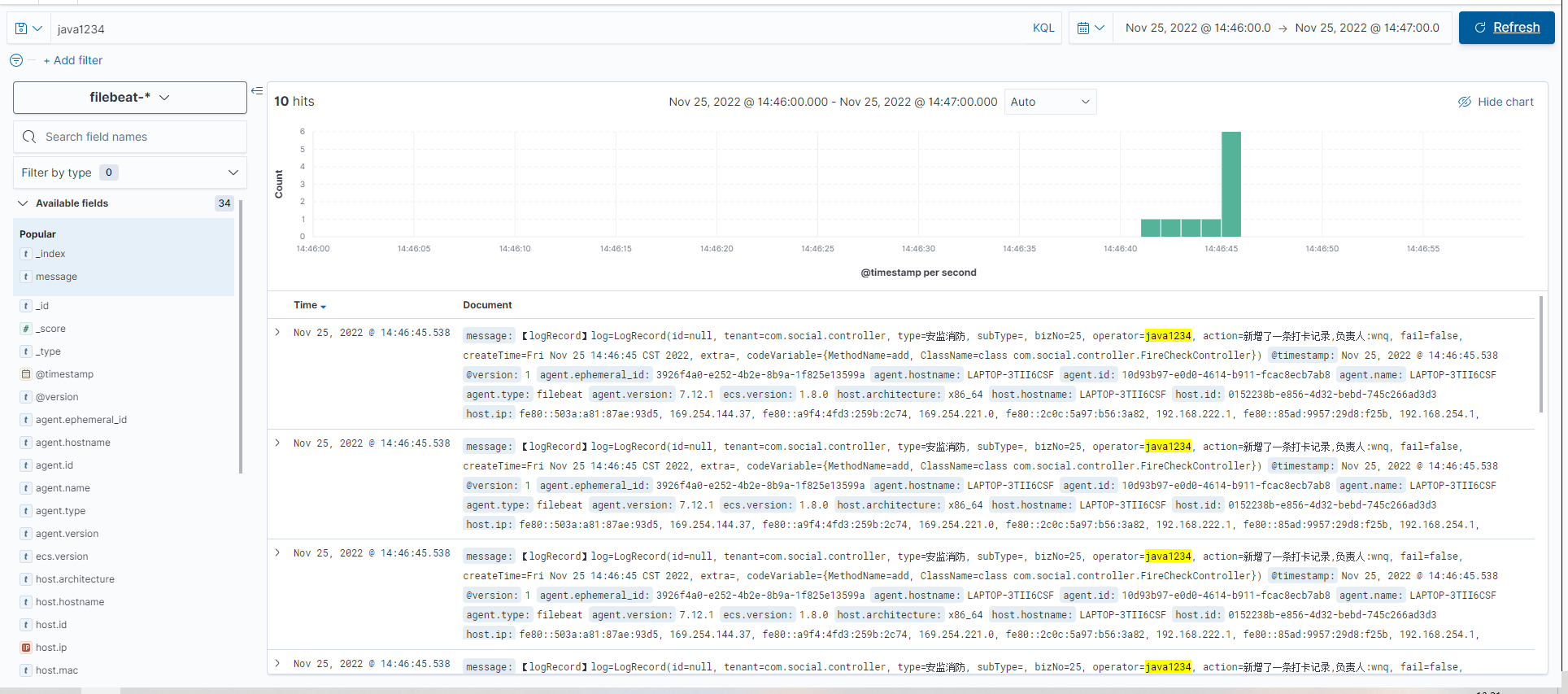

啟動springboot服務,生成的日誌會自動被filebeat採集並推送到es,可以查詢

如果想定製fielbeat.yml和logback.xml,可以去找參考資料

logback.xml詳解:

logback中文文檔:https://www.docs4dev.com/docs/zh/logback/1.3.0-alpha4/reference/architecture.html