###一、Scrapy 介紹 Scrapy是一個Python編寫的開源和協作的框架。起初是用於網路頁面抓取所設計的,使用它可以快速、簡單、可擴展的方式從網站中提取所需的數據。 Scrapy也是通用的網路爬蟲框架,爬蟲界的django(設計原則很像),可用於數據挖掘、監測和自動化測試、也可以應用在獲取 ...

一、Scrapy 介紹

Scrapy是一個Python編寫的開源和協作的框架。起初是用於網路頁面抓取所設計的,使用它可以快速、簡單、可擴展的方式從網站中提取所需的數據。

Scrapy也是通用的網路爬蟲框架,爬蟲界的django(設計原則很像),可用於數據挖掘、監測和自動化測試、也可以應用在獲取api所返回數據。

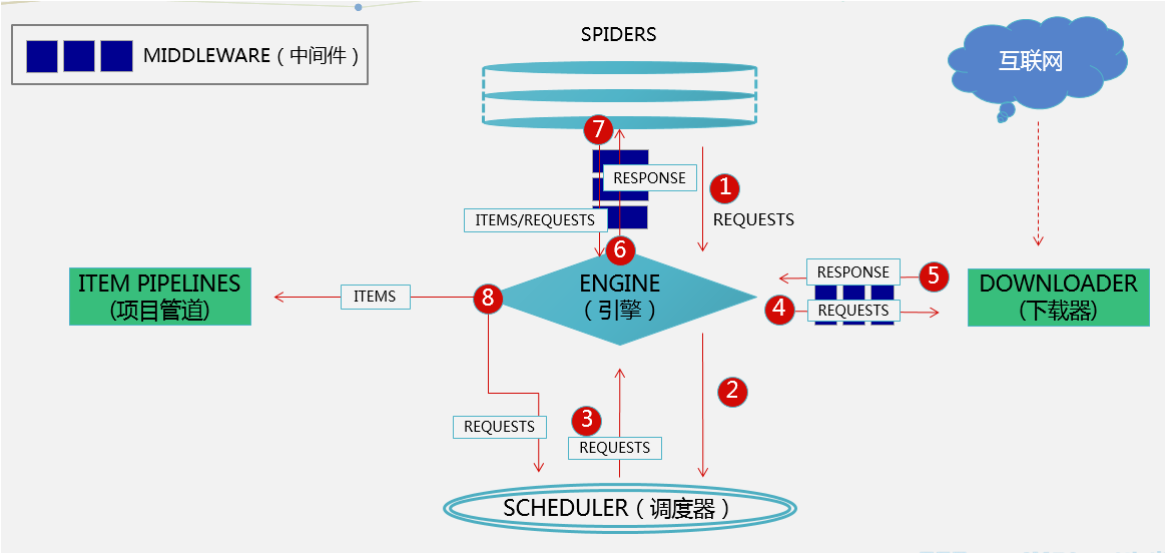

Scrapy是基於twisted框架開發而來,twisted是事件驅動python網路框架,因此scrapy使用的是非阻塞(非同步)的代碼來實現併發,可以發一堆請求出去(非同步,不用等待),誰先回來就處理誰(事件驅動,發生變化再處理)。整體架構如下圖

二、Scrapy 執行流程

五大組件

1、引擎(EGINE)

大總管,負責控制系統所有組件之間的數據流向,併在某些動作發生時觸發事件

2、調度器(SCHEDULER)

由它來決定下一個要抓取的網址是什麼,同時去除重覆的網址(scrapy框架用的集合)

# 通過配置來實現這一堆請求按深度優先(一條url爬到底),還是廣度優先(都先爬第一層,再往下爬)

# 先進先出(隊列)-->第一層請求從調度器出去,爬蟲解析後發出第二層請求,但要在隊列等先進的其他第一層請求出去,因此需要把第一層先爬完,這是廣度優先

# 後進先出(堆棧)-->出去的第一層經解析,發出第二層請求,進入調度器,它又先出去,一條線把它爬完,才能爬其他url請求,這是深度優先

3、下載器(DOWLOADER):用於下載網頁內容, 並將網頁內容返回給EGINE,下載器是建立在twisted這個高效的非同步模型上的

# 下載器前有一個下載中間件:用來攔截,這裡就是包裝requests對象的地方(加頭、加代理)

4、爬蟲(SPIDERS):開發人員自定義的類,用來解析responses,並且提取items對象(解析出來的內容),或者發送新的請求request(解析出要繼續爬取的url)

5、項目管道(ITEM PIPLINES):在items被提取後負責處理它們,主要包括清洗(剔除掉不需要的數據)、驗證、持久化(比如存到資料庫、文件、redis)等操作

兩大中間件

1、爬蟲中間件:位於EGINE和SPIDERS之間,主要處理SPIDERS的輸入(responses)和輸出(requests),還包括items對象,處理的東西過多就需要先判斷是哪個對象,用的很少

2、下載中間件:引擎和下載器之間,主要用來處理引擎傳到下載器的請求request, 從下載器傳到引擎的響應response;

可以處理加代理,加頭,集成selenium; 它用的不是requests模塊發請求,用的底層的urllib模塊,因此不能執行js;

框架的靈活就在於,你可以在下載中間件自己集成selenium,攔截後走你的下載方式,拿到數據再包裝成response對象返回;

# 開發者只需要在固定的位置寫固定的代碼即可(寫的最多的spider)

三、安裝

#1 pip3 install scrapy(mac,linux可以直接下載)

#2 windows上(主要是tweited裝不上)

解決方法

1、pip3 install wheel #安裝後,便支持通過wheel文件安裝軟體,wheel文件官網:https://www.lfd.uci.edu/~gohlke/pythonlibs

2、pip3 install lxml

3、pip3 install pyopenssl

4、下載並安裝pywin32:它是windows上的exe執行文件

https://sourceforge.net/projects/pywin32/files/pywin32/

5、下載twisted的wheel文件:http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted

6、執行pip3 install 下載目錄\Twisted-17.9.0-cp36-cp36m-win_amd64.whl

7、pip3 install scrapy

# 3 裝完後就有scrapy命令,命令視窗輸入

-D:\Python39\Scripts\scrapy.exe 此文件用於創建項目(相當於安裝完django有個django-admin.exe)

四、scrapy 創建項目,創建爬蟲,運行爬蟲

1 創建scrapy項目

# pycharm不支持創建scrapy,只能用命令來創建項目

scrapy startproject 項目名

eg: scrapy startproject firstscrapy (cmd先cd到項目創建的目錄上再執行命令)

-項目創建後會生成firstscray文件夾,用pycharm打開,類似django項目的目錄結構

2 創建爬蟲

# 先cd到創建的scrapy項目中, eg: 在firstscrapy項目路徑下執行命令

scrapy genspider 爬蟲名 爬取地址 # 相當於django創建app, python manage.py startapp app01

scrapy genspider chouti dig.chouti.com # 地址一開始寫錯了,後面可以修改

一執行就會在spider文件夾下創建出一個py文件,名字叫chouti,爬蟲就是一個個的py文件

執行命令-->生成py文件-->裡面包含了初始代碼,因此直接拷貝py文件改下裡面的代碼(爬蟲名、地址),就相當於創建一個新的爬蟲,新的py文件,django的app也可以這樣操作

3 運行爬蟲

方式一:通過命令啟動爬蟲

scrapy crawl chouti # 帶運行日誌

scrapy crawl chouti --nolog # 不帶日誌

方式二:支持右鍵執行爬蟲

# 在項目路徑下新建一個main.py,跟spiders文件夾同一級

from scrapy.cmdline import execute

execute(['scrapy','crawl','chouti','--nolog']) --->右鍵運行main.py文件

execute(['scrapy','crawl','baidu'])

# scrapy框架中,當一個爬蟲執行完畢後,會直接退出程式,而不是繼續執行後面代碼

# 用scrapy.cmdline.execute並不能同時運行多個爬蟲

註意:框架用了異常捕獲,如果不帶日誌,有異常不會拋到控制台

scrapy框架爬網頁會先去讀robots.txt協議,如果網站不讓爬,它就不爬了

可以在settings.py中,ROBOTSTXT_OBEY = True 改為False,不遵循它的協議

# 可以幾個爬蟲同時執行,它是非同步框架,裡面開的多線程

# 如果是同步,你放再多,也只能排隊一個個爬,前面的IO阻塞,後面也都等著

# 非同步的優勢在於,前面的IO阻塞了,後面的不會等,繼續執行起走,誰的請求回來就處理誰

五、scrapy項目目錄

firstscrapy # 項目名字

firstscrapy # 包,存放項目py文件

-spiders # 所有的爬蟲文件放在裡面

-baidu.py # 一個個的爬蟲(以後基本上都在這寫東西)

-chouti.py

-middlewares.py # 中間件(爬蟲,下載中間件都寫在這)

-pipelines.py # 持久化相關寫在這(處理items.py中類的對象)

-main.py # 自己建的py文件,執行爬蟲

-items.py # 一個一個的類(類似django中的models)

-settings.py # 配置文件

scrapy.cfg # 上線相關

六、settings介紹

1 預設情況,scrapy會去遵循爬蟲協議

2 修改配置文件參數,強行爬取,不遵循協議 ROBOTSTXT_OBEY = False

3 USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/84.0.4147.105 Safari/537.36'

4 LOG_LEVEL='ERROR' 日誌等級配置為error,info信息不列印,可以帶上日誌運行

5 存儲管道配置,數字越小,優先順序越高:pipelines是管道,可以同時丟到不同的位置取存儲

ITEM_PIPELINES = {

'firstscrapy.pipelines.ChoutiFilePipeline': 300,

'firstscrapy.pipelines.ChoutiMySqlPipeline': 305,

}

七、scrapy的數據解析(重點)

1 spiders爬蟲

爬蟲解析示例

class ChoutiSpider(scrapy.Spider):

name = 'chouti'

allowed_domains = ['dig.chouti.com']

start_urls = ['http://dig.chouti.com/']

def parse(self, response, *args, **kwargs):

print(response.text)

# 爬蟲類中定義了start_urls, 配了地址

# 一啟動會調用Spider類中start_requests方法--->從start_urls迴圈出url,包裝成requests對象返回

# 進入調度後,走到下載器--->下載回來的responses對象返回到爬蟲,調用parse方法進行解析

---------------------------------------

如果解析出一個網址,想繼續爬取這個網址,需要調用Requset類傳入url,生成requests對象並返回,它會繼續走scrapy框架的流程

from scrapy.http import Request

class ChoutiSpider(scrapy.Spider):

name = 'chouti'

allowed_domains = ['dig.chouti.com']

start_urls = ['http://dig.chouti.com/']

def parse(self, response, *args, **kwargs):

print(response.text)

return Request('http:www.chouti.com/article.html/')

# return Request('http:www.baidu.com/', dont_filter=True) 解析出來的百度的域不能爬,需要設置dont_filter

# 先爬dig.chouti.com,如果解析出http:www.chouti.com/article.html這個地址,要繼續爬

# 調用Request類,生成對象並返回-->調度器-->下載器-->返回response對象-->爬蟲,調用parse繼續解析

# allowed_domains設定了只能在某個域下爬,如果解析出來其他域就不能爬,dont_filter參數可以讓繼續爬其他域

2 解析方案一:自己用第三方解析,用bs4,lxml

bs4解析

from bs4 import BeautifulSoup

class ChoutiSpider(scrapy.Spider):

name = 'chouti'

allowed_domains = ['dig.chouti.com']

start_urls = ['http://dig.chouti.com/']

def parse(self, response, *args, **kwargs):

print(response.text)

soup=BeautifulSoup(response.text, 'lxml')

div_list=soup.find_all(class_='link-title')

for div in div_list:

print(div.text)

3 解析方案二:scrapy框架自帶的解析

css或xpath解析

xpath解析:

# 取到所有link-title類的標簽對象

response.xpath('//a[contains(@class,"link-title")]')

# 取到所有link-title類的標簽的html(doc)文檔

response.xpath('//a[contains(@class,"link-title")]').extract()

# 取到所有link-title類的標簽的文本

response.xpath('//a[contains(@class,"link-title")]/text()').extract()

# 取到所有link-title類的標簽的href屬性

response.xpath('//a[contains(@class,"link-title")]/@href').extract()

css解析:

# 取到所有link-title類的標簽對象

response.css('.link-title')

# 取到所有link-title類的標簽的html(doc)文檔

response.css('.link-title').extract()

# 取到所有link-title類的標簽的文本

response.css('.link-title::text').extract()

# 取到所有link-title類的標簽的href屬性

response.css('.link-title::attr(href)').extract()

# extract()取出的內容放在列表裡,即使取一個也放在列表,extract_first()取列表的第一個元素

八、scrapy的持久化存儲(重點)

數據存儲

方案一:parser函數必須返回列表套字典的形式(瞭解)

def parse(self, response, *args, **kwargs):

ll=[]

div_list = response.xpath('//div[contains(@class, "link-item")]')

for div in div_list:

title = div.css('.link-title::text').extract_first()

detail_url = div.css('.link-title::attr(href)').extract_first()

pic_url = div.css('.image-scale::attr(src)').extract_first()

ll.append('title':title, 'detail_url':detail_url, 'pic_url':pic_url)

return ll

執行下列命令,保存前肯定先執行爬蟲爬取 chouti.csv是保存的文件名,這個文件可以用excel打開;只能用csv\json\xml\pickle幾種格式保存

scrapy crawl chouti -o chouti.csv

方案二:高級,通過pipline item存儲(mysql,redis,文件)

1、在items.py中寫一個類,類似drf的序列化類

class ChoutiItem(scrapy.Item):

title = scrapy.Field() # 要返回的欄位對應上

detail_url = scrapy.Field()

pic_url = scrapy.Field()

2、在spinder中導入,實例化,把數據放進去

因為item字典沒有重寫點攔截方法,因此只能用字典方式賦值,不能對象.title賦值

from testscrapy.items import ChoutiItem

def parse(self, response, *args, **kwargs):

div_list = response.xpath('//div[contains(@class, "link-item")]')

for div in div_list:

item = ChoutiItem() # 迴圈一次生成一個item對象,添加屬性後返回

title = div.css('.link-title::text').extract_first()

detail_url = div.css('.link-title::attr(href)').extract_first()

pic_url = div.css('.image-scale::attr(src)').extract_first()

if not pic_url:

pic_url = ''

item['title'] = title

item['detail_url'] = detail_url

item['pic_url'] = pic_url

yield item

3、返回的是item對象,就會走到pipeline, 在pipelines.py中寫Pipeline存儲的類

# 以存文件為例,如果直接在process_item, with open打開寫,每次返回item走到ChoutiFilePipeline,就會存文件,進行IO操作,必須要a模式,w模式每次打開會覆蓋

# open_spider方法中open文件--->process_item方法中寫入文件--->close_spider方法中colse文件,整個構成上下文管理,不用反覆打開關閉,進行IO操作

class ChoutiFilePipeline(object):

def open_spider(self, spider): # 開始的時候

self.file=open('chouti.txt', 'w', encoding='utf-8')

def process_item(self, item, spider): # 在這個函數里持久化,存入數據,這裡要return item,不然排在後面的管道找不到item對象

self.file.write(item['title'] + \n)

self.file.write(item['detail_url'] + \n)

self.file.write(item['pic_url'] + \n)

return item

def close_spider(self, spider): # 結束的時候

self.file.close()

4、在setting中配置,把你自己寫的ChoutiFilePipeline配置進去;數字越小,優先順序越高:pipelines是管道,可以同時丟到不同的位置取存儲

如;FilePipeline、MySqlPipline,都可以配置在列表中,用數字表示優先順序

ITEM_PIPELINES = {

'firstscrapy.pipelines.ChoutiFilePipeline': 300,

'firstscrapy.pipelines.ChoutiMySqlPipeline': 305,

}